英伟达Blackwell架构设计完全解析

Nvidia Blackwell

英伟达Blackwell系列中技术最先进的芯片是 GB200,英伟达在系统层面的多个方面都做出了大胆的技术选择。尽管大多数数据中心部署的标准是每个机架功率密度约为 12 千瓦至 20 千瓦,但这个配备 72 个图形处理器(GPU)的机架功率密度达到了约 125 千瓦 / 机架。

这是此前从未达到过的计算和功率密度水平,鉴于所需的系统层面复杂性,产能提升已证明颇具挑战性。出现了众多问题,涉及电力输送、过热、水冷供应链产能提升、快速断连处的漏水以及各种各样的电路板复杂性难题。虽然这些问题让供应链上的一些供应商和设计师手忙脚乱,但大多数问题都比较小,并非英伟达削减产量或对主要路线图进行重大调整的原因。

影响出货量的核心问题与英伟达 “布莱克韦尔” 架构的设计直接相关。由于台积电以及英伟达自身设计方面的封装问题,最初的 “布莱克韦尔” 封装产品供应有限。“布莱克韦尔” 封装是首个采用台积电的晶圆级芯片封装(CoWoS-L)技术进行大规模量产的设计。

来源:台积电

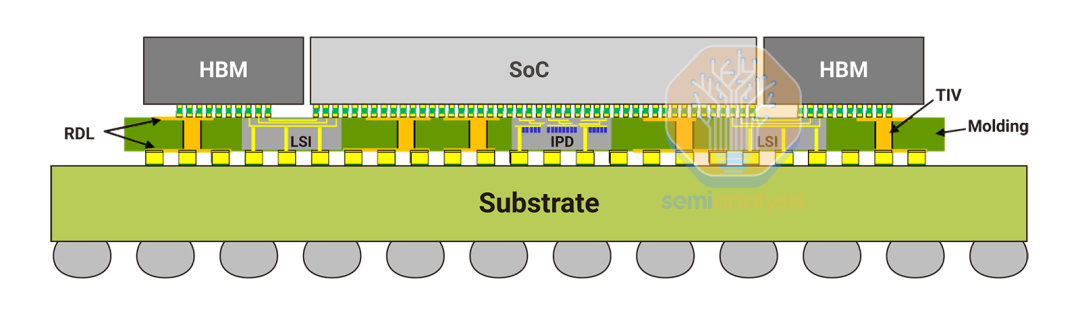

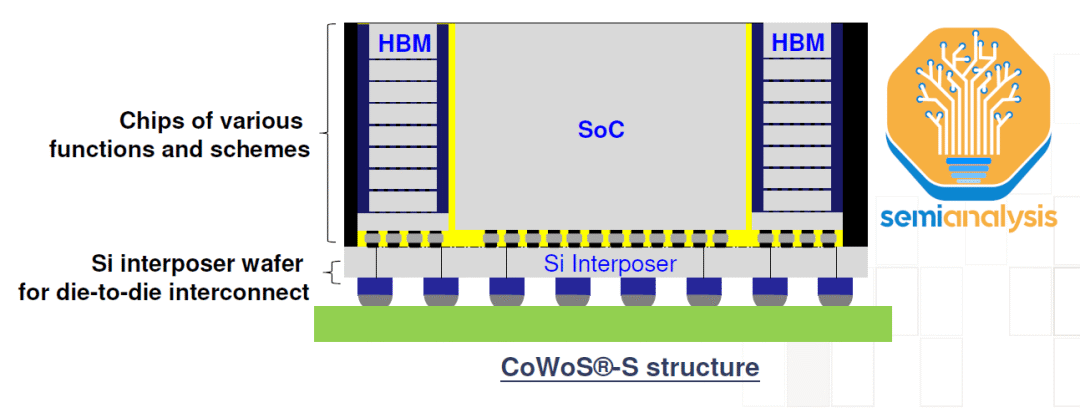

回顾一下,CoWoS-L(集成扇出晶圆级封装 - 局部硅互连技术)采用带有局部硅互连(LSI)的再分布层(RDL)中介层,并在该中介层中嵌入桥接芯片,以此来桥接封装内各类计算芯片和存储器之间的通信。将其与 CoWoS-S(集成扇出晶圆级封装 - 标准型技术)相比,后者从表面上看要简单得多,就是一大块硅片。

来源:台积电

由于未来人工智能加速器需要集成更多逻辑、内存和输入 / 输出(I/O)功能,CoWoS-S 封装尺寸不断增大且性能方面面临挑战,所以 CoWoS-L 成为了 CoWoS-S 的后续替代技术。台积电已通过 AMD 的 MI300 将 CoWoS-S 扩展到光罩尺寸约为原来 3.5 倍的中介层,但这已是实际极限。存在多个限制因素,关键的一点在于硅是易碎的,而且随着中介层尺寸变得更大,处理极薄的硅中介层难度也会增加。这些大型硅中介层随着光刻光罩拼接越来越多,成本也会变得更高。

有机中介层可以解决这一问题,因为它们不像硅那样易碎,但它们缺乏硅的电气性能,因此无法为性能更强的加速器提供足够的 I/O。届时可以使用硅桥(无源或有源)来补充信号密度以作弥补。此外,这些硅桥的性能 / 复杂度可以比大型硅中介层高。

CoWoS-L 是一项复杂得多的技术,但它代表着未来的发展方向。英伟达和台积电原本制定了非常激进的量产爬坡计划,目标是每季度生产超过 100 万颗芯片。结果出现了各种各样的问题。

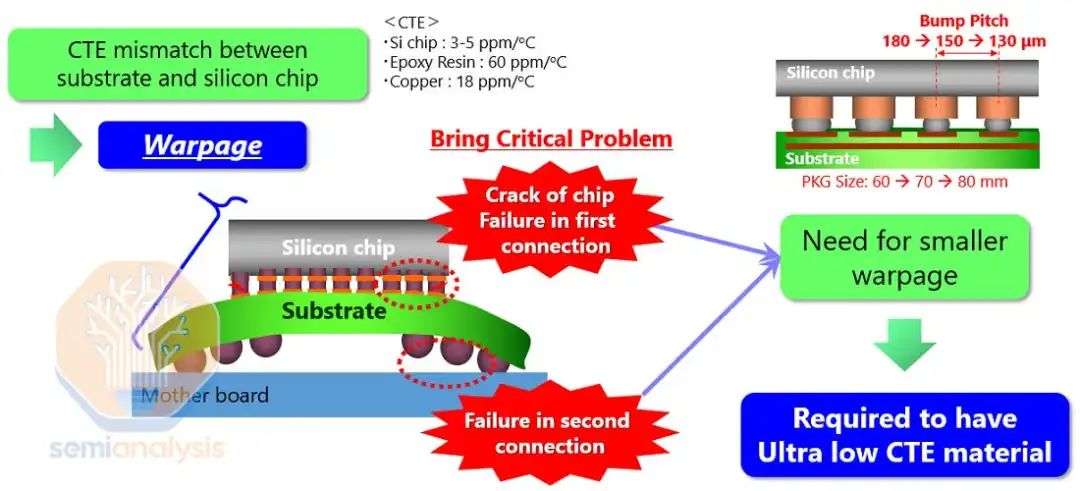

其中一个问题与在中介层以及有机中介层内嵌入多个精细凸点间距的硅桥有关,这可能会导致硅芯片、硅桥、有机中介层和基板之间的热膨胀系数(CTE)不匹配,从而引发翘曲。

添加图片注释,不超过 140 字(可选)

来源:Resonac

桥接芯片的放置需要极高的精度,尤其是涉及两个主要计算芯片之间的桥接部分时,因为这些桥接对于支持每秒 10 太字节的芯片间互连至关重要。据传,一个主要的设计问题与桥接芯片有关。这些桥接芯片需要重新设计。另外有传言称,顶部的几层全局布线金属层需要重新设计,而且布莱克韦尔(Blackwell)芯片要增加凸块。这是导致项目延期数月的主要原因。

还有一个问题是,台积电总体上没有足够的 CoWoS-L(整合型扇出晶圆级封装 —— 大尺寸版本)产能。过去几年里,台积电扩充了大量 CoWoS-S(整合型扇出晶圆级封装 —— 小尺寸版本)产能,英伟达占据了其中的大部分份额。如今,随着英伟达迅速将其需求转向 CoWoS-L,台积电一方面正在建造一座新的工厂 AP6 用于 CoWoS-L 生产,另一方面正在对 AP3 工厂现有的 CoWoS-S 产能进行转换。台积电需要对旧的 CoWoS-S 产能进行转换,否则这些产能将得不到充分利用,而 CoWoS-L 产能的提升速度会更慢。这种转换过程使得产能提升在本质上很不均衡。

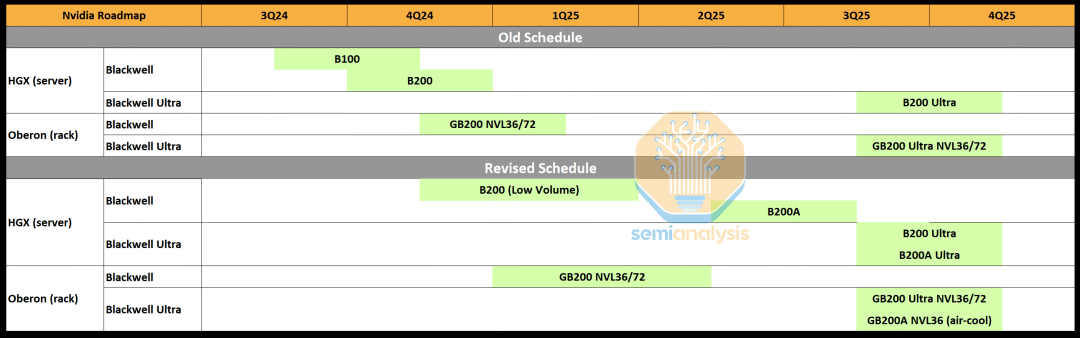

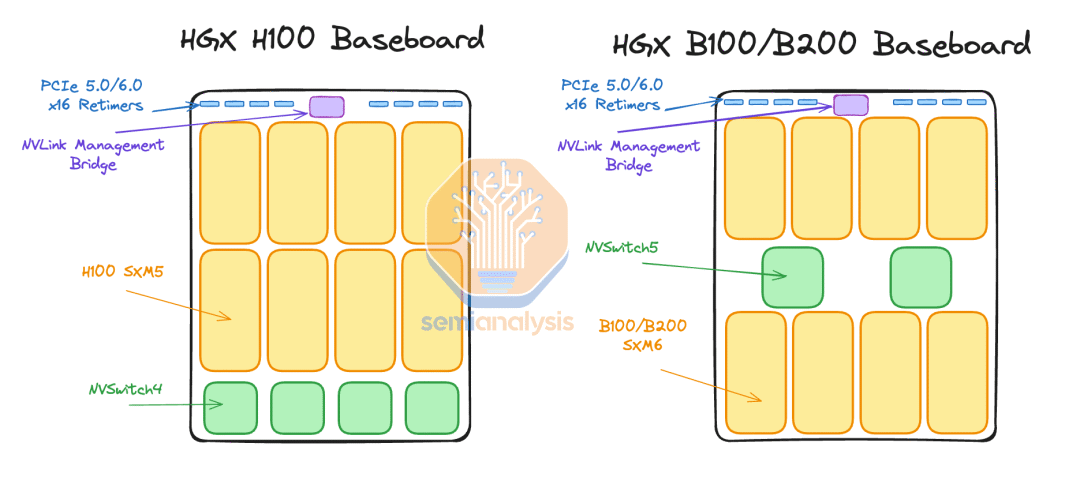

综合这两个问题来看,显然台积电将无法按照英伟达的期望供应足够的布莱克韦尔芯片。因此,英伟达几乎将其现有产能全部集中在 GB200 NVL 36×2 和 NVL72 机架规模系统上。除了最初的少量产量之外,采用 B100 和 B200 芯片的 HGX 规格产品实际上现在已被取消。

资料来源:SemiAnalysis Estimates、Nvidia

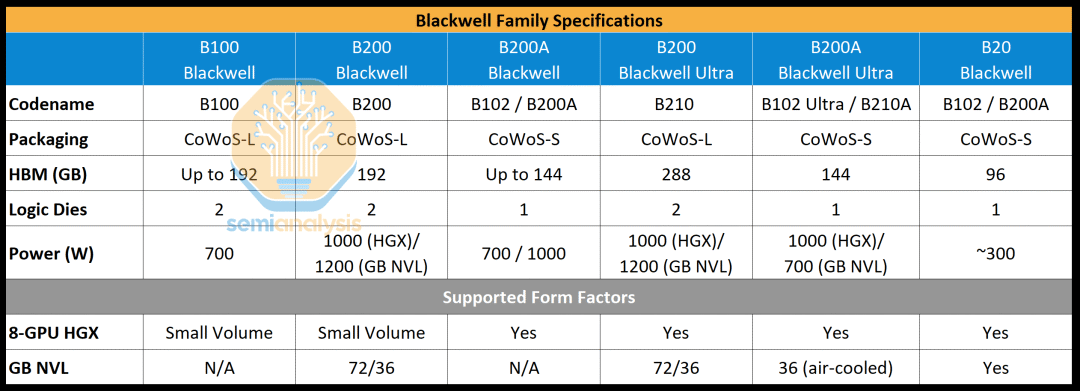

为满足需求,英伟达现将推出一款基于 B102 芯片的名为 B200A 的布莱克韦尔(Blackwell)图形处理器(GPU)。有意思的是,这款 B102 芯片也会用于布莱克韦尔的中国版产品,名为 B20。B102 是一款带有 4 层高带宽内存(HBM)的单片计算芯片。重要的是,这使得该芯片能够采用晶圆级芯片封装(CoWoS)的小尺寸版本(CoWoS-S)进行封装,而非大尺寸版本(CoWoS-L),甚至也不用英伟达的其他 2.5D 封装供应商(如安靠、日月光半导体、三星)提供的封装方式。最初的布莱克韦尔芯片有大量用于芯片到芯片(C2C)输入 / 输出的边界区域,而对于单片系统级芯片(SOC)来说这是不必要的。

B200A 将用于满足中低端人工智能系统的需求,并将取代用于 HGX 8-GPU 规格的 B100 和 B200 芯片。它会有 700 瓦和 1000 瓦的 HGX 规格,配备最高达 144GB 的 HBM3E,内存带宽最高可达 4TB / 秒。值得注意的是,其内存带宽低于 H200 的内存带宽。

再来说说布莱克韦尔 Ultra,它是布莱克韦尔的中期升级产品,采用标准 CoWoS-L 封装的布莱克韦尔 Ultra 将被称为 B210 或 B200 Ultra。布莱克韦尔 Ultra 既有内存升级,其 HBM3E 内存容量可达 288GB(12 层),同时在每秒浮点运算次数(FLOPS)方面性能也能提升高达 50%。

B200A 也会有 Ultra 版本。值得注意的是,该版本不会进行内存升级,不过芯片可能会重新设计以提升每秒浮点运算次数。B200A Ultra 还引入了一种全新的 MGX NVL 36 规格。B200A Ultra 也会像最初的 B200A 一样采用 HGX 配置。

资料来源:SemiAnalysis Estimates、Nvidia

对于超大规模云计算提供商(Hyperscaler)市场,我们认为 GB200 NVL72/36×2 将继续最具吸引力,因为在推理过程中,对于参数量超过 2 万亿的模型而言,它在性能 / 总体拥有成本(TCO)方面表现最优。话虽如此,如果超大规模云计算提供商无法获得期望数量的 GB200 NVL72/36×2 配置,它们可能仍需购买 MGX GB200A NVL36。此外,在功率密度较低或者缺乏许可 / 无法获取水冷改造用水的数据中心,MGX NVL36 看起来更具吸引力。

超大规模云计算提供商仍会采购 HGX Blackwell 服务器,因为它是可用于向外租给客户的最小计算单元,不过其采购量会比以往大幅减少。对于小型模型来说,HGX 在性能 / 总体拥有成本方面仍是最佳选择,因为这些模型不需要大量内存,能够适配在 NVL8 的单个内存一致性域内。

在使用不到 5000 个 GPU 进行训练任务时,HGX Blackwell 的性能 / 总体拥有成本优势也很明显。话虽如此,MGX NVL36 对于许多下一代模型来说是理想之选,总体而言基础设施更具灵活性,因此在很多情况下它是更优选择。

对于新云(Neocloud)市场,我们认为,由于很难找到支持液冷或高功率密度(带边车)的主机代管服务提供商,大多数客户不会购买 GB200 NVL72/36×2。而且,与超大规模云计算提供商相比,大多数新云在获取有限的 GB200 NVL72/36×2 数量方面通常处于更靠后的位置。

我们认为,像 Coreweave 这样既自行建设数据中心 / 进行改造又拥有大客户的大型新云服务提供商将会选择 GB200 NVL72/36×2。对于新云市场的其他参与者而言,大多数会选择 HGX Blackwell 服务器和 MGX NVL36,因为仅使用风冷和低功率密度机架就能部署这些设备。目前,大多数新云部署针对的是 Hopper(英伟达的一款产品),功率密度为每机架 20 千瓦。我们认为新云有可能部署 MGX GB200 NVL36,因为它仅需每机架 40 千瓦的风冷即可。

通过采用冷通道封闭技术并在数据中心内跳过一些排架,每机架 40 千瓦的部署难度并不大。在新云规模下,新云运营商和新云客户其实往往不会针对其特定工作负载去考虑每总体拥有成本的性能,相反,他们只是试图采购当下炒作最热的产品。例如,大多数(即便不是全部)新云客户不使用 FP8 训练,而是选择 bfloat16 训练。对于使用 bfloat16 进行训练的小型语言模型(LLM)来说,A100 80GB 在每总体拥有成本的性能方面表现要好得多。

由于 Meta 的 LLAMA 模型正影响着许多企业和新云的基础设施选择,最相关的部署单元是能否适配 Meta 的模型。LLAMA 3 405B 无法适配单个 H100 节点,但勉强能适配 H200(该模型可以进行量化,但质量损失巨大)。鉴于 405B 对于 H200 HGX 服务器来说已经接近极限,下一代基于混合专家(MoE)架构的 LLAMA 4 肯定无法适配 Blackwell HGX 的单个节点,这将极大地影响每总体拥有成本的性能。

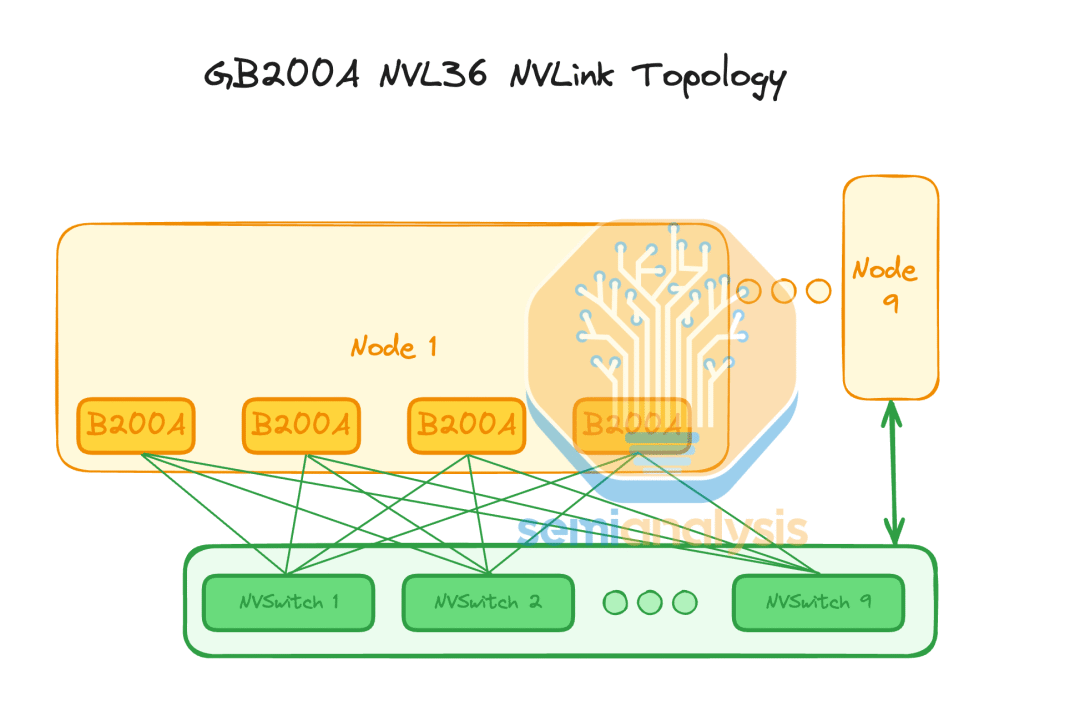

MGX GB200A Ultra NVL36 的架构

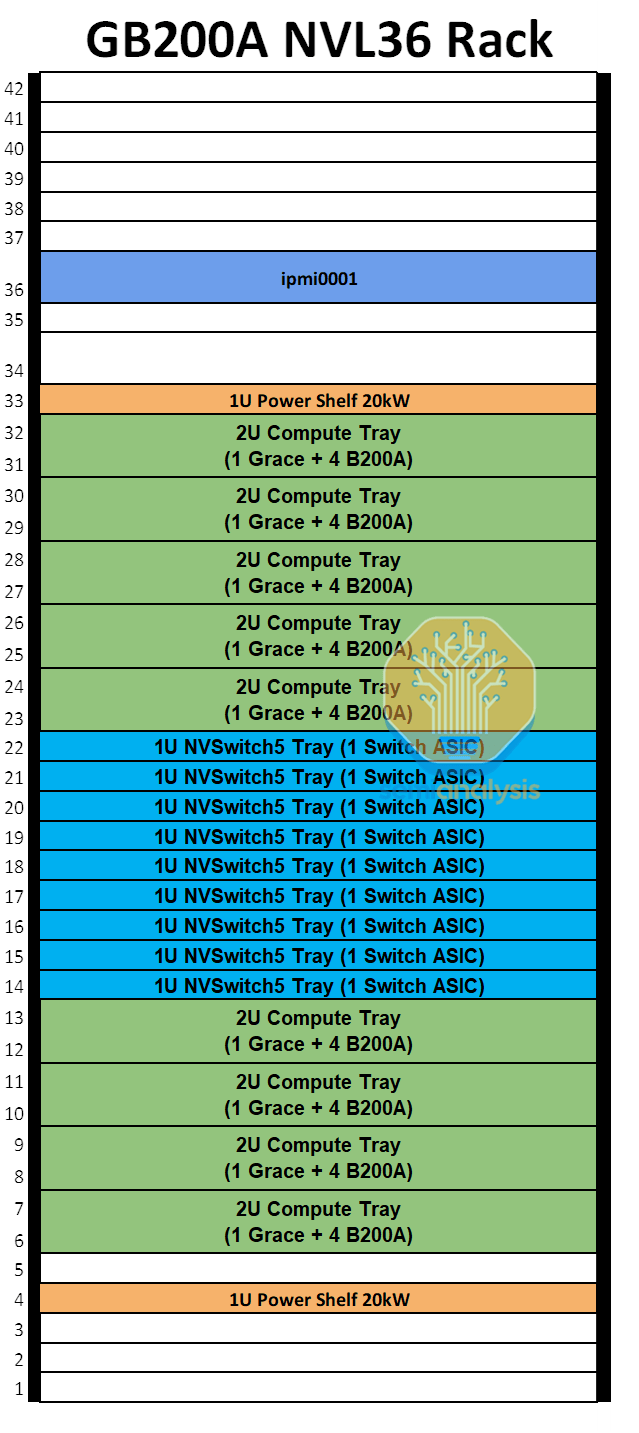

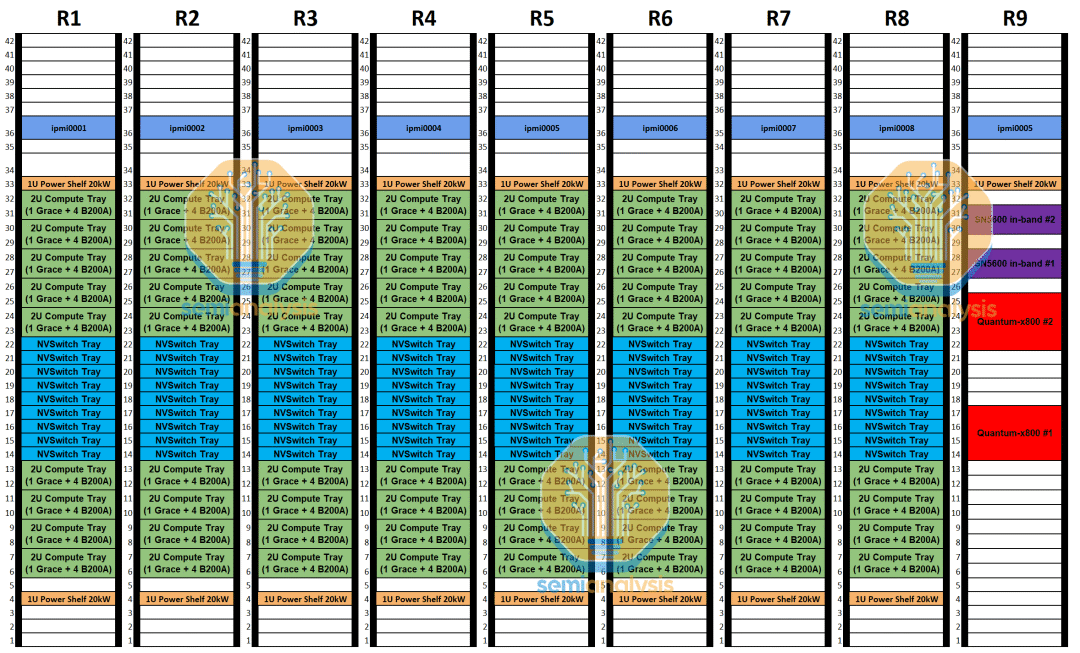

MGX GB200A NVL36 SKU 是一款全风冷 40kW/机架服务器,将有 36 个 GPU 与 NVLink 完全互连在一起。每个机架将有 9 个计算托盘和 9 个 NVSwitch 托盘。每个计算托盘为 2U,包含一个 Grace CPU 和四个 700W B200A Blackwell GPU,而 GB200 NVL72 / 36×2 则有两个 Grace CPU 和四个 1200W Blackwell GPU。

MGX NVL36 设计的 CPU 与 GPU 的比例仅为 1:4,而 GB200 NVL72 / 36×2 的比例为 2。此外,每个 1U NVSwitch Tray 只有一个交换机 ASIC,每个交换机 ASIC 的带宽为 28.8Tbit/s。

来源:SemiAnalysis GB200 和 GB200A 组件和供应链模型

由于每个机架仅为 40 千瓦,MGX NVL36 可以采用风冷方式。尽管大多数数据中心以及当前的 H100 部署每个机架仅为 20 千瓦,但每个机架 40 千瓦的 H100 部署情况也并不罕见。这是通过在数据中心内跳过一些排架,并利用冷热通道封闭技术实现的。在部署 40 千瓦的 MGX NVL36 机架时也可以采用同样的技术。这使得现有数据中心运营商在无需对其基础设施进行改造的情况下就能非常轻松地部署 MGX NVL36。

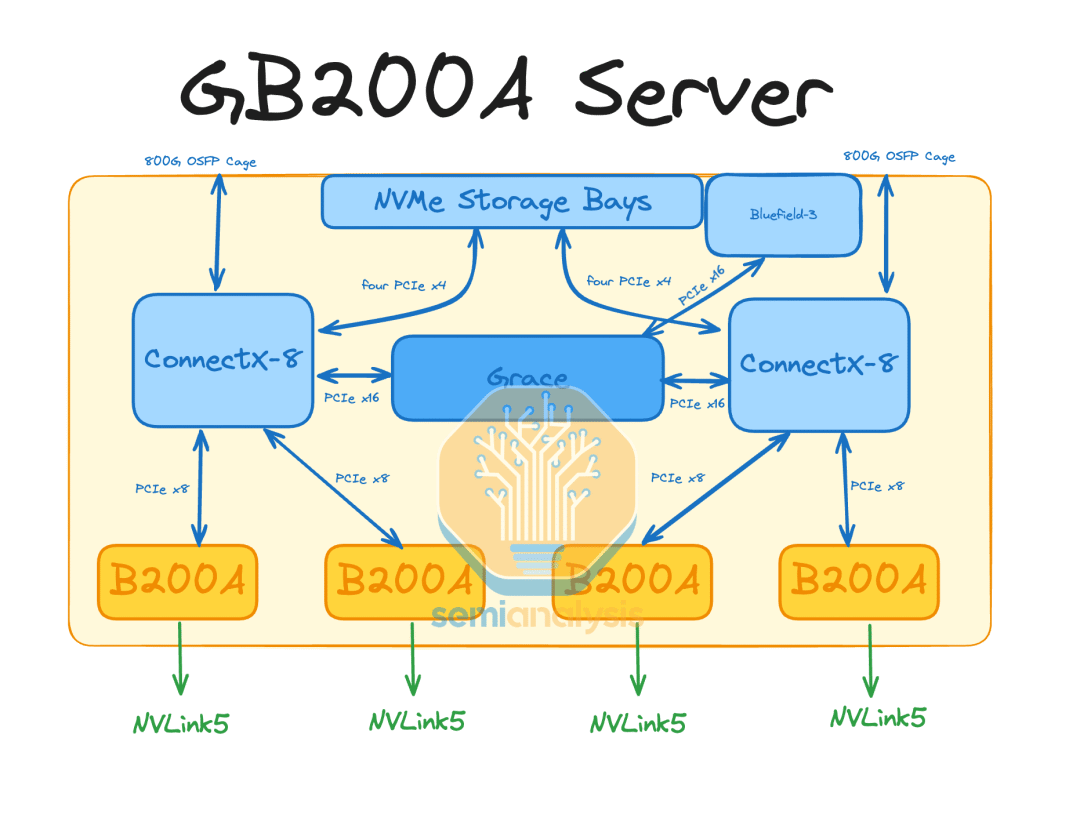

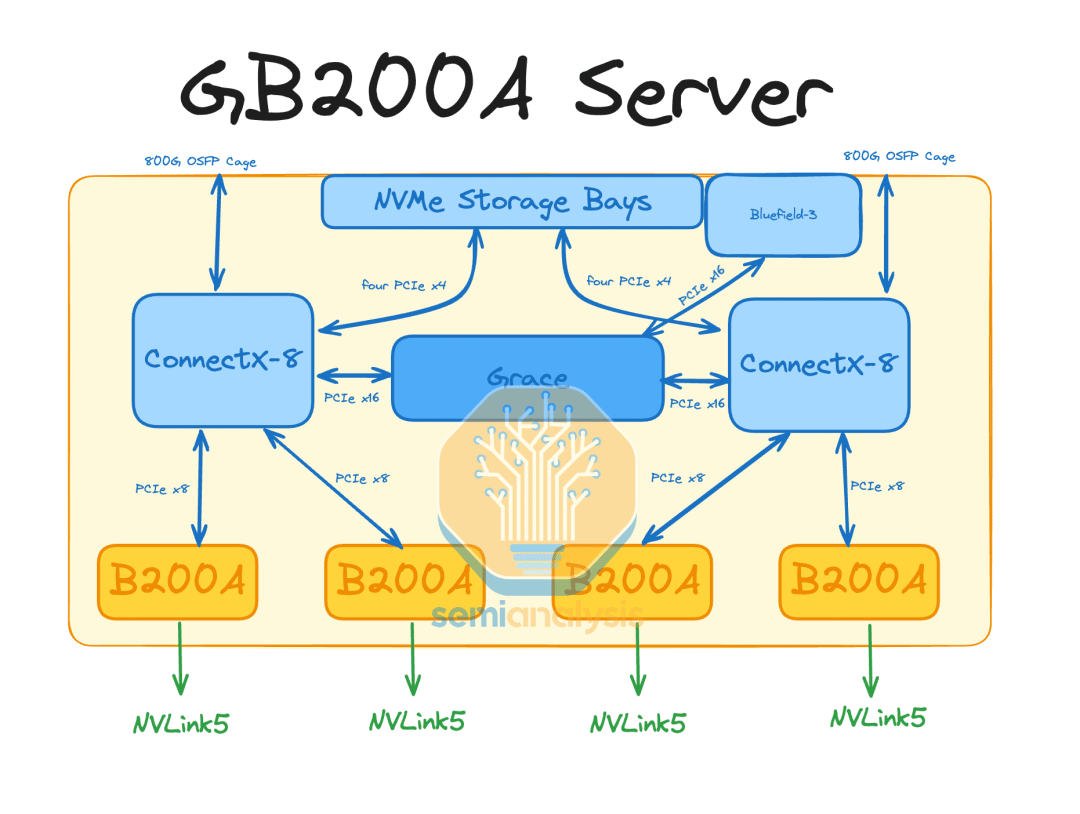

与 GB200 NVL72(36×2)不同,MGX NVL36 上四块 GPU 对应一块 CPU 的较高配比意味着它无法使用 C2C 互连,因为每个 GPU 所能获得的 C2C 带宽只有 GB200 NVL72(36×2)的一半。相反,将会利用集成的 ConnectX - 8 PCIe 交换机来让 GPU 与 CPU 进行通信。而且,与所有其他现有的人工智能服务器(HGX H100/B100/B200、GB200 NVL72(36×2)、MI300)不同的是,现在每个后端网络接口卡(NIC)将负责连接两块 GPU。这意味着,尽管 ConnectX - 8 网络接口卡的设计能够提供 800G 的后端网络带宽,但每个 GPU 只能使用 400G 的后端 InfiniBand(无限带宽)/RoCE(融合以太网远程直接内存访问)带宽。

来源:SemiAnalysis GB200 和 GB200A 组件和供应链模型

在 GB200 NVL72/36×2 上,搭配 ConnectX - 8 后端网卡时,每个图形处理器(GPU)可获得高达 800G 的带宽。

就参考设计而言,GB200A NVL36 将在每个计算托盘上使用一个 Bluefield - 3 前端网卡。与 GB200 NVL72/36×2 在每个计算托盘上使用两个 Bluefield - 3 网卡相比,这是一种更合理的设计。即便对于 MGX NVL36 来说,我们仍然觉得许多客户不会选择使用 Bluefield - 3,超大规模数据中心运营商可能会选择使用自己内部的网卡,或者使用诸如 ConnectX - 6/7 之类的通用前端网卡。

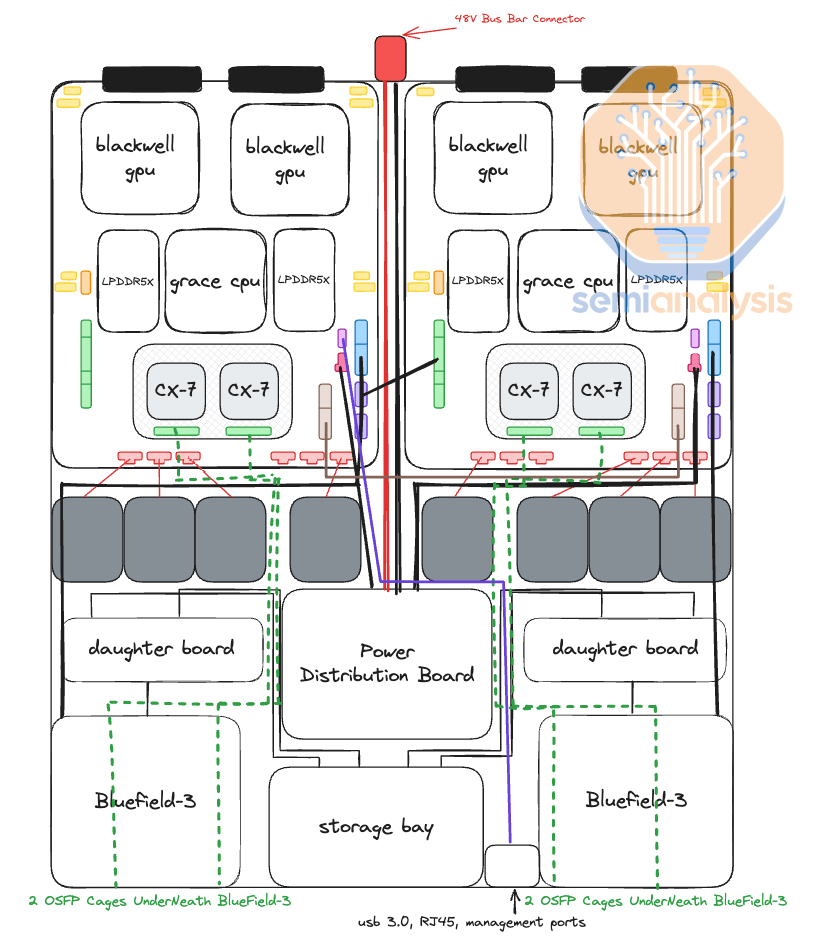

GB200 NVL72/NVL36×2 计算托盘的核心是比安卡(Bianca)板。比安卡板包含两个布莱克韦尔(Blackwell)B200 图形处理器和一个格蕾丝(Grace)中央处理器。每个计算托盘有两块比安卡板,这意味着每个计算托盘总共包含两个格蕾丝中央处理器和四个 1200W 的布莱克韦尔图形处理器。

来源:SemiAnalysis GB200 和 GB200A 组件和供应链模型

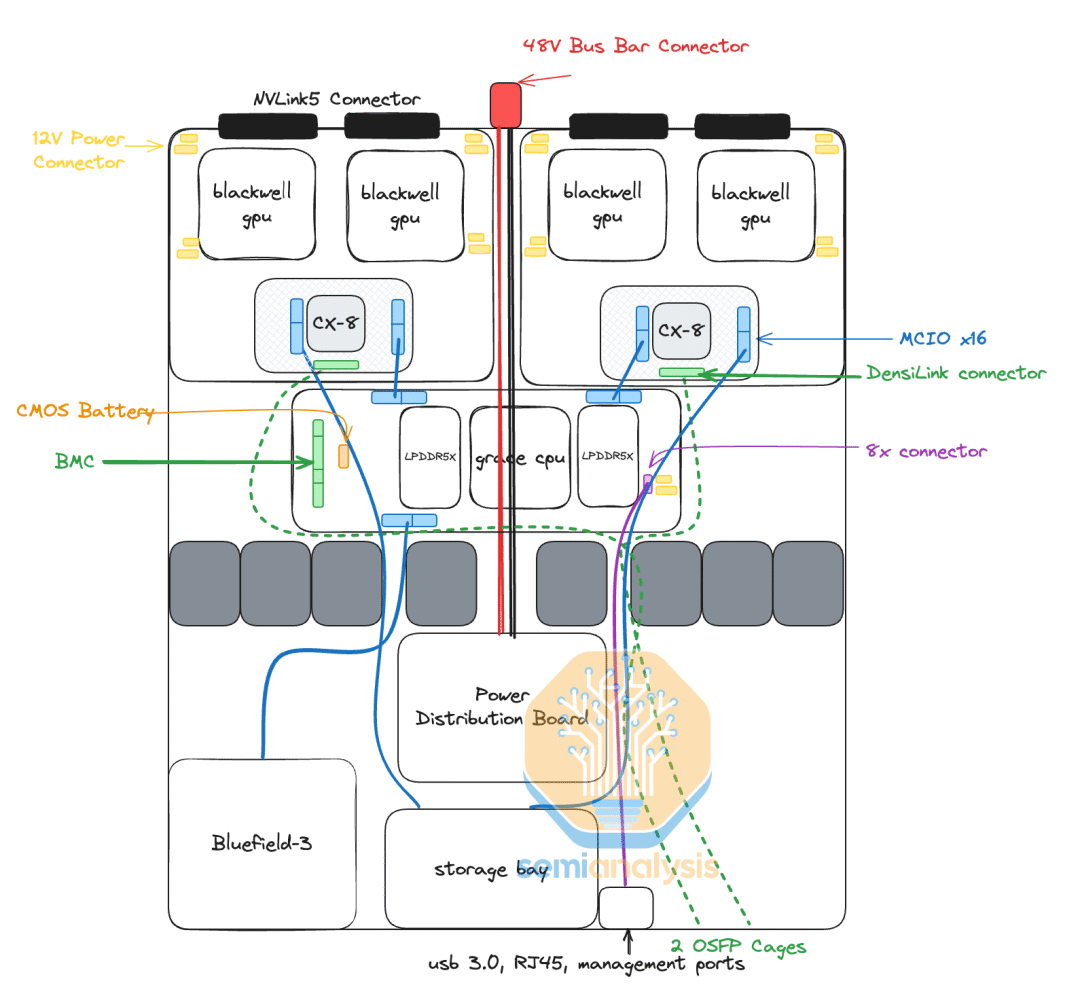

在 MGX GB200A NVL36 上,CPU(中央处理器)和 GPU(图形处理器)会位于不同的印制电路板(PCB)上,这与 HGX 服务器的设计类似。但与 HGX 服务器不同的是,我们认为每个计算托盘上的 4 个 GPU 会被细分成两块各含 2 个 GPU 的板卡。每块含 2 个 GPU 的板卡都将配备类似于比安卡(Bianca)板卡上的镜像夹层(Mirror Mezz)连接器。这些镜像夹层连接器将用于连接 ConnectX - 8 夹层板,ConnectX - 8 夹层板会将 ConnectX - 8 专用集成电路(ASIC)及其集成的 PCIe(高速串行计算机扩展总线标准)交换机与 GPU、本地 NVMe(非易失性内存主机控制器接口规范)存储以及格蕾丝(Grace)CPU 相连。

由于 ConnectX - 8 专用集成电路与 GPU 的距离非常近,这意味着 GPU 和 ConnectX - 8 网络接口卡(NIC)之间无需使用重定时器。这与 HGX H100/B100/B200 不同,HGX H100/B100/B200 需要使用重定时器才能从 HGX 主板连接到 PCIe 交换机。

由于格蕾丝 CPU 和布莱克韦尔(Blackwell)GPU 之间没有芯片到芯片(C2C)互连,格蕾丝 CPU 也位于一块完全独立的印制电路板上,这块电路板被称作 CPU 主板。该主板将包含基板管理控制器(BMC)连接器、CMOS 电池、MCIO 连接器等等。

来源:SemiAnalysis GB200 和 GB200A 组件和供应链模型

每个 GPU 的 NVLink 带宽在每个方向上都将达到 900GB / 秒,这与 GB200 NVL72/36×2 相同。从每浮点运算(FLOP)的角度来看,GPU 到 GPU 的带宽有了极大的提升,这使得 MGX NVL36 对于某些工作负载颇具优势。

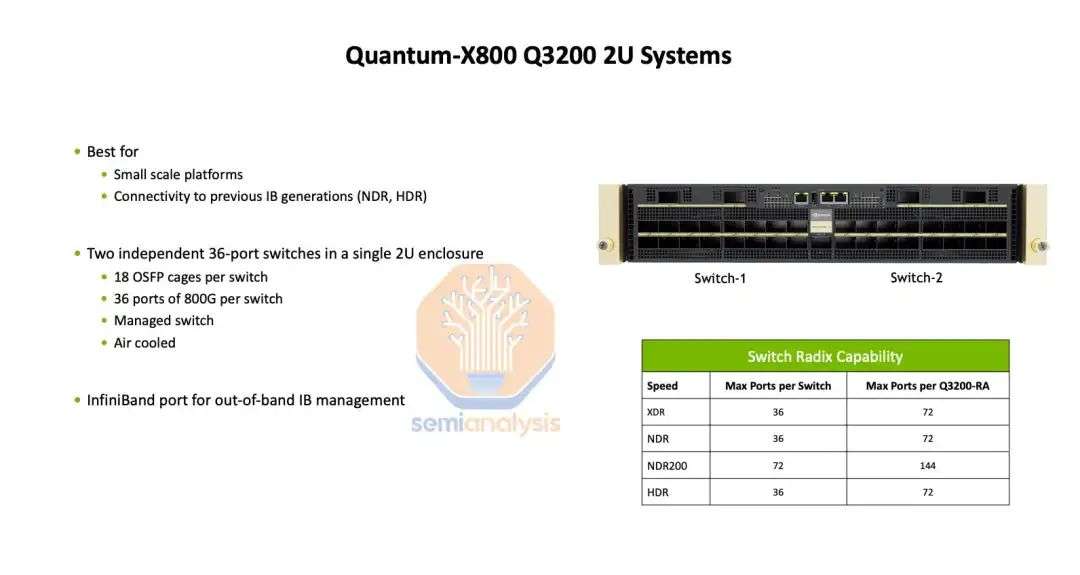

由于只需 1 层交换机来连接 36 个 GPU,仅需 9 个 NVSwitch 专用集成电路(ASIC)就能提供无阻塞网络。而且,由于每个 1U 交换机托盘只有 1 个 28.8Tbit / 秒的专用集成电路,风冷就变得相当容易。像 Quantum-2 QM9700 这样 25.6Tbit / 秒的 1U 交换机已经能够轻松实现风冷。虽然英伟达本可以通过让交换机托盘保留 2 个 NVSwitch 专用集成电路来启用 NVL36×2 的设计,但那样会增加成本,并且由于前面的 OSFP NVLink 笼会阻碍气流,可能就无法进行风冷了。

来源:SemiAnalysis GB200 & GB200A组件和供应链模型

在后端网络上,由于每个计算托盘只有两个 800G 端口,我们认为它将使用 2 轨优化的行端网络。每 8 个 GB200A NVl36 机架将配备 2 台 Quantum-X800 QM3400 交换机。

来源:SemiAnalysis GB200 & GB200A组件和供应链模型

我们估计,在每个 GPU 700W 的情况下,GB200A NVL36 很可能每个机架的功率约为 40kW。2U 计算托盘需要大约 4kW 的功率,但风冷每 2U 空间需要 4kW 的散热,需要专门设计的散热器和高速风扇。

来源:SemiAnalysis GB200 & GB200A组件和供应链模型

我们将在本文后面讨论这方面的冷却挑战,但对于 Nvidia 来说,在 MGX NVL36 设计上这是一个重大风险。

MGX GB200A NVL 36面临的挑战

对于 GB200 NVL72 / NVL36x2 而言,唯一没有使用 Connect-X 7/8 后端网卡的客户是亚马逊。正如我们在 GB200 架构分析中所讨论的那样,这已经带来了重大的工程难题,因为届时将不会有 Connect-X-7/8 或 Bluefield-3(这两者都集成了 PCIe 交换机),如此一来,就需要使用博通或阿斯特拉实验室(Astera Labs)的专用 PCIe 交换机来将后端网卡与 CPU、GPU 以及本地 NVMe 存储设备相连。这会消耗额外的电力,并增加物料清单(BoM)成本。

在 “半导体分析”(SemiAnalysis)的 GB200 组件及供应链模型中,我们对所有组件供应商的份额、销量以及平均销售价格(ASP)进行了细分,其中也包括 PCIe 交换机。由于 GB200A NVL36 是完全风冷的,所以在 2U 机箱前部除了有 PCIe 规格的网卡之外,再配备一个专用的 PCIe 交换机会极大地增加热工程方面的挑战。

来源:SemiAnalysis GB200 & GB200A组件和供应链模型

我们认为任何人要在 GB200A NVL36 上定制后端网卡基本是不可能的。

由于Grace CPU 和Blackwell GPU 位于不同的印制电路板上,我们认为可能也会有 x86 + B200A NVL36 版本。由于许多机器学习依赖项都是针对 x86 CPU 进行编译和优化的,这对于该产品型号(SKU)来说可能是一项额外优势。此外,与格蕾丝 CPU 相比,x86 CPU 平台能提供更高峰值性能的 CPU。遗憾的是,对于想要推出 x86 版本的原始设备制造商(OEM)来说,会面临散热方面的挑战,因为 CPU 耗电量要多出大约 100 瓦。我们认为,即便英伟达推出 x86 B200A NVL36 解决方案,他们也会引导大多数客户选择 GB200A NVL36 解决方案,因为这样可以销售格蕾丝 CPU。

GB200A NVL36 的关键卖点在于它是一个每机架 40 千瓦的风冷系统。对客户的主要吸引力在于,许多客户仍然无法支持每机架约 125 千瓦的 GB200 NVL72(或者两个机架总共超过 130 千瓦的 36×2 配置)所需的液冷及电力基础设施。

无需任何液冷意味着,与 GB200 NVL72 / 36×2 相比,散热解决方案将使整体散热方案大幅简化,基本上回归到散热器(三维蒸汽腔,3DVC)和一些风扇的配置。然而,鉴于 GB200A NVL36 的计算托盘采用 2U 机箱,3DVC 的设计将需要大幅调整。

热设计功耗(TDP)为 700 瓦的 H100 目前使用的是 4U 高的 3DVC,而 1000 瓦的 H200 使用的是 6U 高的 3DVC。相比之下,在 2U 机箱中热设计功耗为 700 瓦的 MGX B200A NVL36 就受到相当大的限制。我们认为,需要一种呈阳台状水平扩展的散热器,以增加散热器的表面积。

为什么 Nvidia 取消 GB200A NVL64

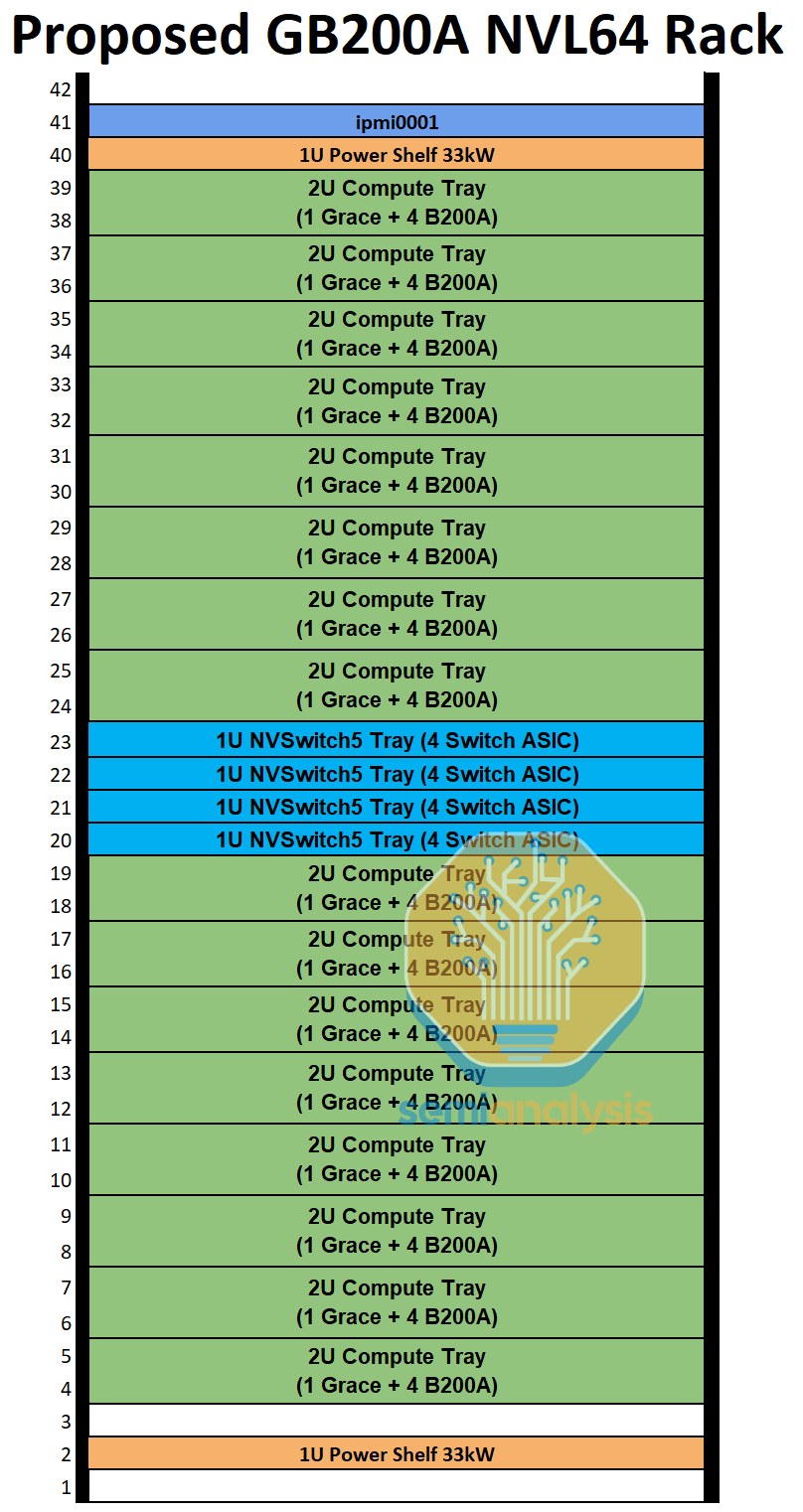

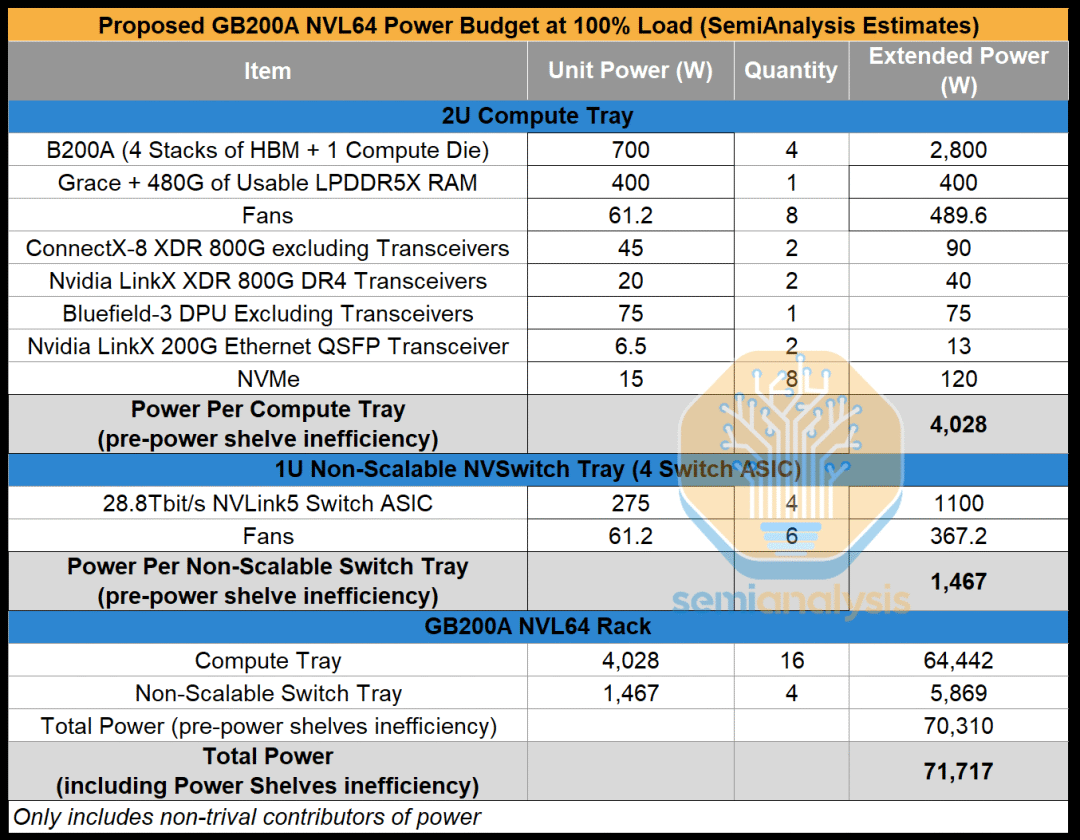

在英伟达着手研发 MGX GB200A NVL36 之前,他们也在试验一种风冷式 NVL64 机架设计。这种全风冷的 60 千瓦机架原本会配备 64 个通过 NVLink 完全互连在一起的图形处理器(GPU)。我们对这一拟推出的产品型号(SKU)进行了广泛的工程分析,鉴于下文所讨论的诸多问题,我们认为该产品不可行,不会上市发售。

在拟定的 NVL64 产品型号中,有 16 个计算托盘和 4 个 NVSwitch 托盘。每个计算托盘为 2U 规格,包含一个格蕾丝(Grace)CPU 以及四个 700 瓦的布莱克韦尔(Blackwell)GPU,这与 MGX GB200A NVL36 的配置相同。而 NVSwitch 托盘则进行了重大改动。英伟达没有将 GB200 中每个托盘配备两个 NVSwitch 的配置减少为每个托盘一个 NVSwitch,而是尝试将其增加到四个交换专用集成电路(ASIC)。

来源:SemiAnalysis GB200 & GB200A组件和供应链模型

尽管英伟达提出的设计称 NVL64 将是一个 60 千瓦的机架,但我们已经估算了功率预算,并且认为下限更接近每机架 70 千瓦。不管怎样,仅靠空气来冷却每机架 60 千瓦或 70 千瓦的热量是很疯狂的做法,这通常需要使用后门热交换器,不过这样就破坏了风冷机架架构的意义,因为仍然依赖液冷供应链,而且对于大多数数据中心来说,要将设施用水输送到后门热交换器,仍需要对设施层面进行改造。

来源:SemiAnalysis GB200 & GB200A组件和供应链模型

另一个存在很大问题的散热问题是,NVSwitch 托盘在单个 1U 机箱内会配备四个 28.8Tbit/s 的交换专用集成电路(ASIC),这需要近 1500 瓦的散热功率。对于一个 1U 机箱来说,1500 瓦的散热功率本身并非离谱,但一旦考虑到由于从交换 ASIC 到背板连接器的超通道跨接电缆会阻塞大量气流,从而带来散热方面的挑战,情况就不同了。

鉴于风冷式 MGX NVL 机架正以极快的速度推向市场,英伟达试图在设计开始后的短短 6 个月内就交付产品,对于一个本就工程资源紧张的行业来说,设计一款新的交换托盘并建立相应供应链是相当困难的。

拟议中的 GB200A NVL64 的另一个主要问题在于,每个机架有 64 个 800G 后端端口,而每个 XDR Quantum - X800 Q3400 交换机却有 72 个 800G 下游端口,这会导致端口不匹配。这意味着采用优化导轨的后端拓扑结构会浪费端口,每个交换机都会有额外的 16 个 800G 端口闲置。在昂贵的后端交换机上存在闲置端口会极大地影响网络性能 / 总体拥有成本(TCO),因为交换机价格不菲,特别是像 Quantum - X800 这样的高基数模块化交换机。

资料来源:英伟达

此外,同一 NVLink 域内配置 64 个 GPU 并非理想之举。从表面上看,这可能听起来很不错,因为 64 是 2 的理想倍数,非常适合不同的并行化配置,比如(张量并行度 TP=8,专家并行度 EP=8),或者(TP=4,全分片数据并行 FSDP=16)。但遗憾的是,由于硬件的不可靠性,英伟达建议每个 NVL 机架至少预留一个计算托盘,以便能将 GPU 离线进行维护,从而可当作热备用件使用。

如果每个机架没有至少一个处于热备用状态的计算托盘,那么机架上哪怕只有一个 GPU 出现故障,其影响范围也会导致整个机架在相当长的时间内被迫停止服务。这就类似于在配备 8 个 GPU 的 HGX H100 服务器上,服务器上只要有一个 GPU 出现故障,就会迫使全部 8 个 H100 GPU 停止服务,无法继续为工作负载贡献算力。

来源:SemiAnalysis GB200 & GB200A组件和供应链模型

预留至少一个计算托盘作为热备用件,会使得每个机架只有 60 个图形处理器(GPU)可用于工作负载。虽然 64 作为一个更便于使用的数字,因为它有 2、4、8、16 和 32 这些公因数,便于实现更理想的并行组合,但 60 并非如此。

这就是为什么在 GB200 上采用 NVL36×2 或 NVL72 配置时,总共设置 72 个 GPU 是经过深思熟虑的 —— 这样可以预留两个计算托盘作为热备用,让用户的每个机架有 64 个 GPU 可用于工作负载。

GB200A NVL36 可以预留一个计算托盘作为热备用,并且对于并行方案有 2、4、8、16 这些公因数,因此能在实际工作负载中实现更高的可靠性。

参考文献链接

人工智能芯片与自动驾驶

浙公网安备 33010602011771号

浙公网安备 33010602011771号