第四周:卷积神经网络 part3

循环神经网络

- 应用:语音问答、机器翻译、股票预测、作词作诗机、模仿写论文和代码(格式)、图像理解、视觉问答。

- 特点:一个序列当前的输出与前面的输出也有关。具体的表现形式为网络会对前面的信息进行记忆并应用于当前输出的计算中。可以更好地处有时序关系的任务

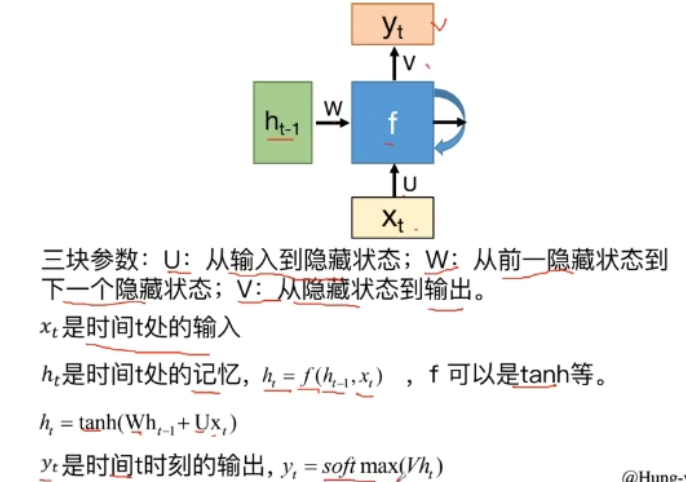

- 基本结构

隐层的数据被存入到一个“记忆”单元中;

存在“记忆”中的数据会被作为另外一个输入与原始输入一起输入到神经网络中。

![]()

![]()

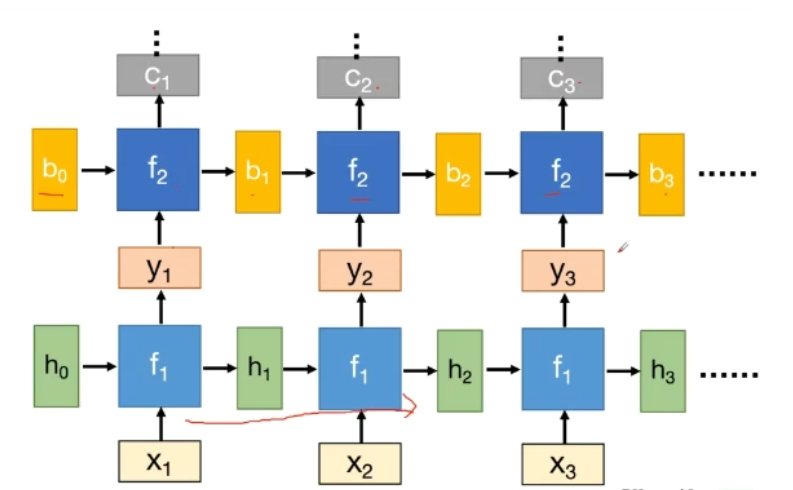

深度rnn

![]()

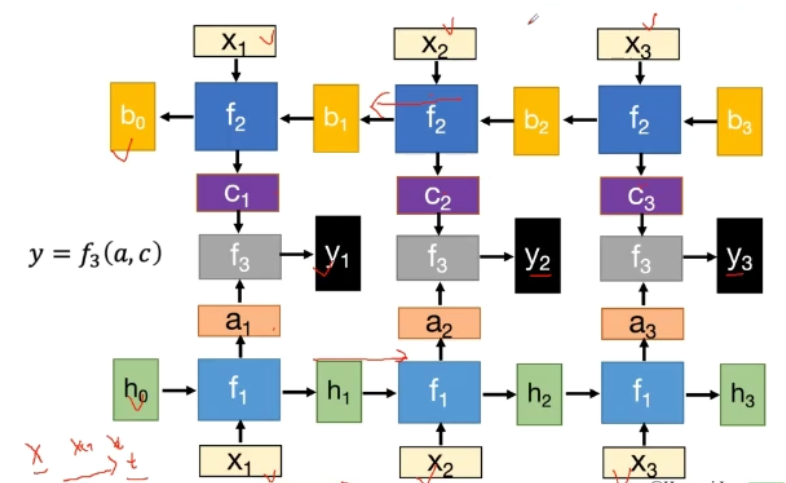

双向rnn

![]()

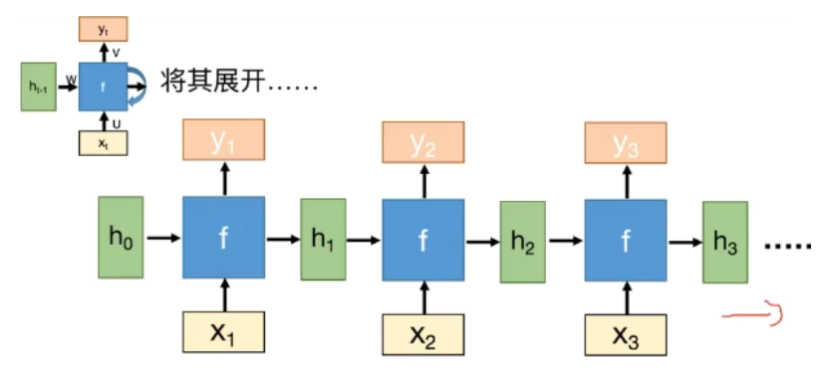

小结

- f是不断重复利用的

- 模型所需要学习的参数是固定的

- 无论输入的长度是多少,只需要一个函数f

- 隐层状态h可以被看作是“记忆”,它包含了之前时间点上的相关信息

- 输出y不仅由当前的输入所决定,还会考虑到之前的“记忆”

- RNN在不同时刻共享同一组参数(U,W,V),加大的减少了需要训练和预估的参数量

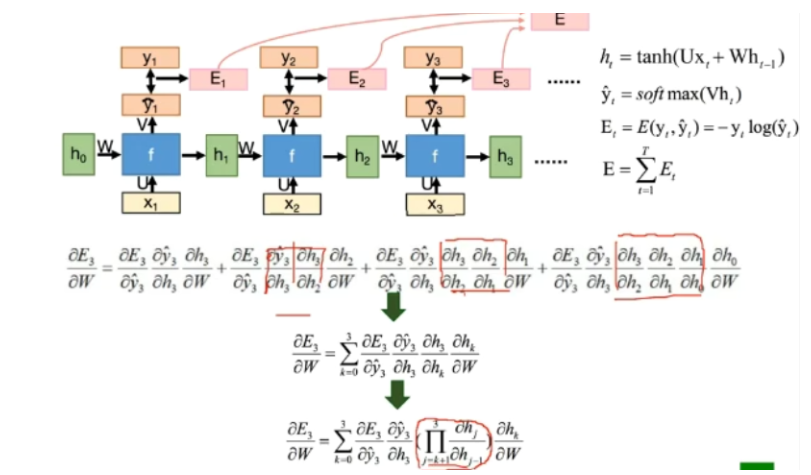

- BRTT算法

![]()

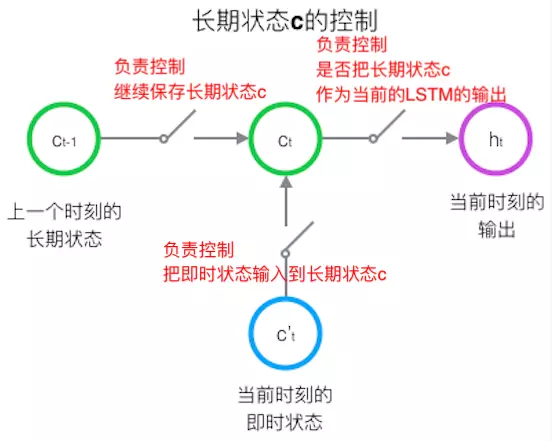

- LSTM

LSTM 有三个门(遗忘门,输入门,输出门),来保护和控制细胞状态

![]()

遗忘门(forget gate)

它决定了上一时刻的单元状态 c_t-1 有多少保留到当前时刻 c_t

输入门(input gate)

它决定了当前时刻网络的输入 x_t 有多少保存到单元状态 c_t

输出门(output gate)

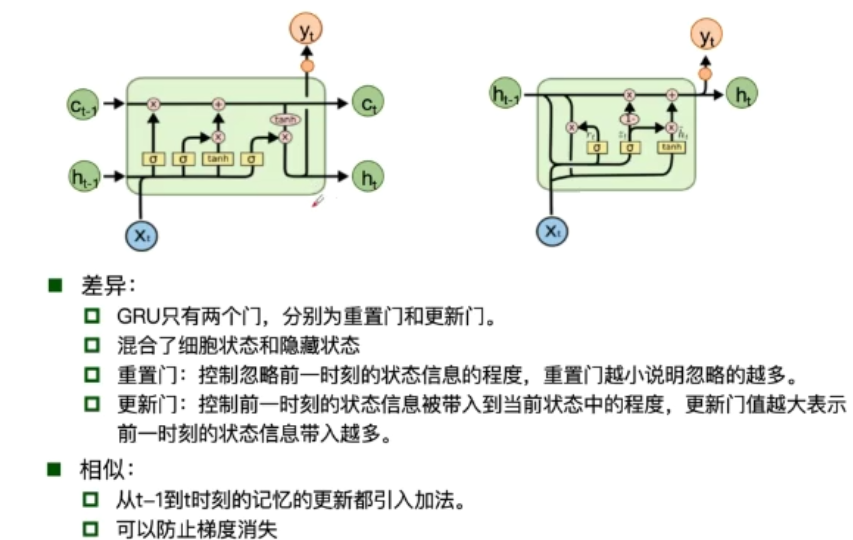

控制单元状态 c_t 有多少输出到 LSTM 的当前输出值 h_t - GRU

![]()

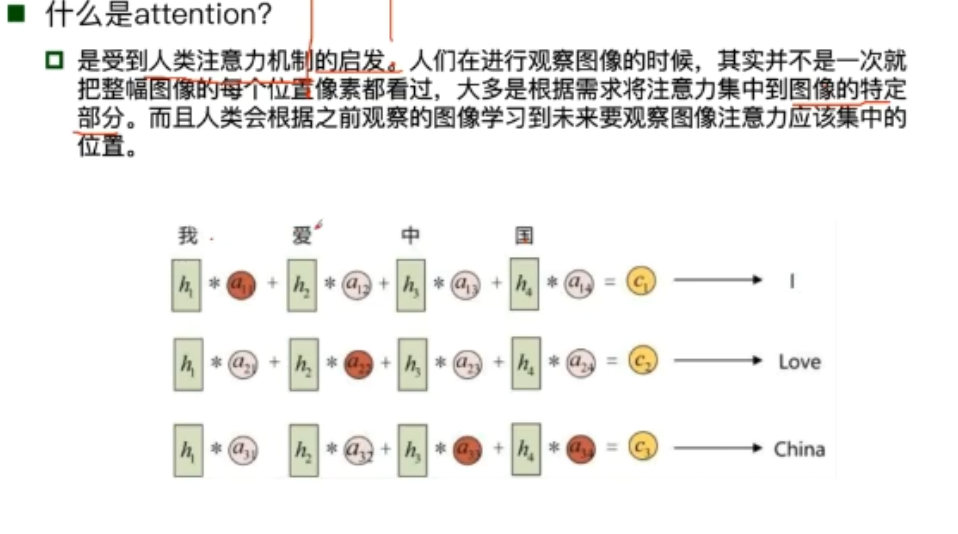

- 注意力机制

![]()

浙公网安备 33010602011771号

浙公网安备 33010602011771号