Spark-shell的使用

使用spark-shell操作hive数据仓库的前提是需要把hive 配置文件hive-site.xml复制到sparkconf目录下

进入到spark bin目录下使用命令开启一个spark-shell:

./spark-shell --master local[2] --jars /home/iie4bu/software/mysql-connector-java-5.1.35.jar

因为我们要操作hive,因此需要添加mysql的driver类。

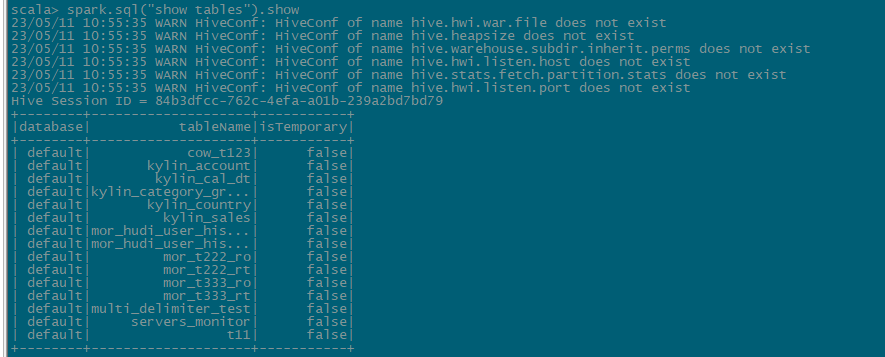

查看表

spark.sql("show tables").show

查看数据库

spark.sql("show databases").show

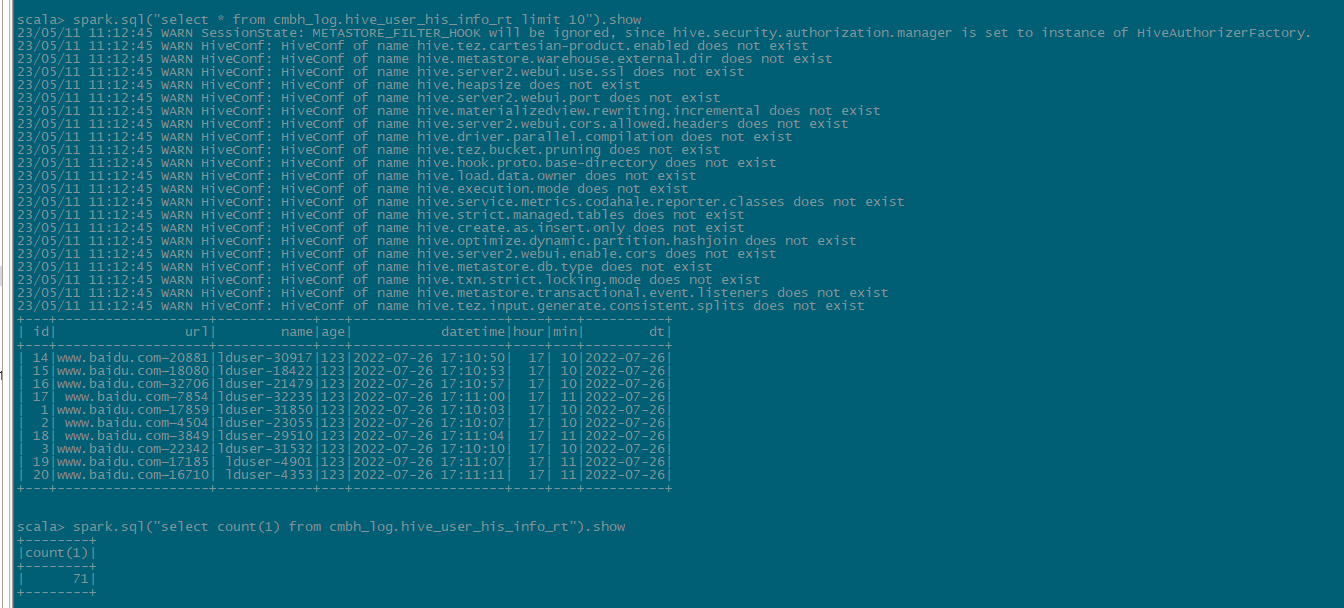

查表数据

spark.sql("select * from table_name").show

本文来自博客园,作者:whiteY,转载请注明原文链接:https://www.cnblogs.com/whiteY/p/17390611.html

浙公网安备 33010602011771号

浙公网安备 33010602011771号