scala实验3 (2)

一、在 spark-shell 中读取 Linux 系统本地文件“/home/hadoop/test1.txt”,然后统计出文件的行数:

1、首先启动spark-shell进入Spark-shell模式:(进入spark目录下后 输入命令 bin/spark-shell 启动spark-shell模式)

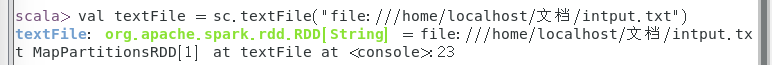

2、加载text文件(spark创建sc,可以加载本地文件和HDFS文件创建RDD)

注意:加载HDFS文件和本地文件都是使用textFile,区别是添加前缀(hdfs://和file://)进行标识。

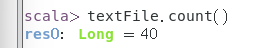

3、获取RDD文件textFile所有项

二、在 spark-shell 中读取 HDFS 系统文件“/home/hadoop/test.csv(也可以是txt文件)”(如果该文件不存在, 请先创建),然后,统计出文件的行数:

浙公网安备 33010602011771号

浙公网安备 33010602011771号