另辟新径:用数学极限推导神经网络中的激活函数

一、数学先验知识:

二、激活函数推导

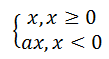

a)、Relu

b)、Leaky Relu

Leaky ReLU只是对ReLU的x负半轴部分添加一个很小的斜率,规避神经元死完这个问题

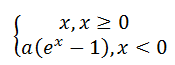

c)、ELU

用公式(1-1)中e^x-1代替Leaky Relu 中x<0时的x,则有

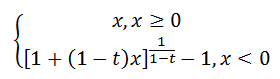

d)、其他激活函数[1]

对![]() 这个式子进行化简,看看其等价于什么?当然,前提默认是在当𝑥→0的条件下:

这个式子进行化简,看看其等价于什么?当然,前提默认是在当𝑥→0的条件下:

e)、扩展:

其他相关等价无穷小:(当x→0时)

sinx~x

ln(1+x)~x

tanx~x

[(1+x)]^a-1~ax

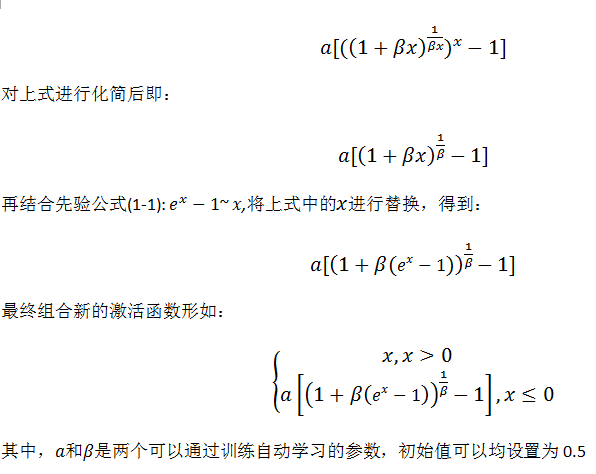

三、创建激活函数

首先我们看ELU的激活函数公式:

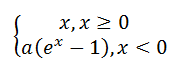

再结合先验公式(1-2):![]() ,故将上述a(e^x-1)中的e进行替换,得到等价公式如:

,故将上述a(e^x-1)中的e进行替换,得到等价公式如:

四、实验结果

基于ImageNet数据集使用VGG19,使用上面新创建的激活函数代替VGG19中的ReLU函数后,训练500个epcoh,准确率97.7%,竟然的Relu的97%还要高点

难道这就是创建激活函数的规律。。。。

[1]李宏亮, 程起上. 一种可形变激活函数的改进方法,系统及存储设备:, 2018.

作为一枚技术小白,写这篇笔记的时候参考了很多博客论文,在这里表示感谢,同时,未经同意,请勿转载....

浙公网安备 33010602011771号

浙公网安备 33010602011771号