2025-01-14 - 通用人工智能技术 - RAG - 离线安装 Anaconda 并导入依赖源 - 流雨声

问卷不采集个人信息,仅用于科研学习的统计,多谢各位

调查问卷: https://www.wjx.cn/vm/exIBFDM.aspx#

摘要

2025-01-14 周二 杭州 晴光潋滟

小记: 有一种痛苦的是没有网,比这个更痛苦的是没有电。

应用实践

1. Anaconda 离线部署

官网最新: https://www.anaconda.com/download/success

版本列表: https://repo.anaconda.com/archive/

国内代餐: https://mirrors.tuna.tsinghua.edu.cn/anaconda/archive/

# 服务器部署

chmod +x Anaconda3-2024.06-1-Linux-x86_64.sh

bash Anaconda3-2024.06-1-Linux-x86_64.sh

# 一路回车,直到安装成功

/root/anaconda3

2. Anaconda 环境变量

2.A 系统配置

vim ~/.bashrc

# 默认安装好的 conda 路径为 /root/anaconda3,个人根据自己的环境路径修改

export PATH="/root/anaconda3/bin:$PATH"

# 使环境变量立即生效

source ~/.bashrc

# 查看安装版本

conda --version

2.B 初始化

# conda 初始化

conda init

# 设置启动conda,是否激活默认base环境,默认为True

conda config --set auto_activate_base false

# conda添加清华源(离线情况下换为内部源)

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/conda-forge/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/pytorch/

conda config --set show_channel_urls yes

# 虚拟环境

conda create -n 虚拟环境名称 python=3.12

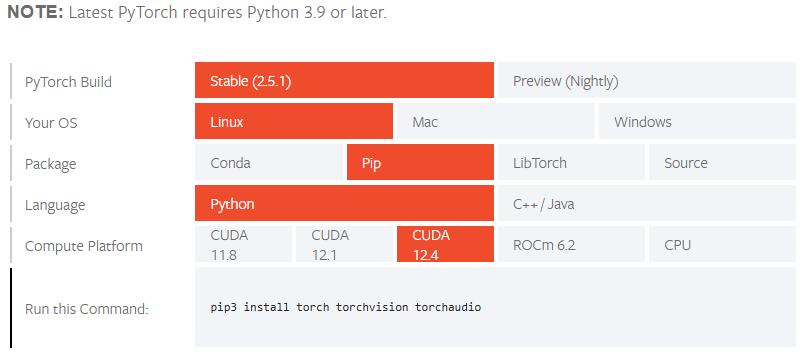

3. Pytorch配置(网络,你懂的)

3.A CUDA 版本检测

nvidia-smi

备注: 用于深度学习的 CUDA 版本至少为11,目前较为主流的版本为 11 或 12.

3.B 安装Pytorch

官网配置页: https://pytorch.org/

# 虚拟环境

source activate xxxx

# 安装对应的版本

pip3 install torch torchvision torchaudio

3.C Pytorch 验证

# python3 代码验证

import torch

torch.__version__

# 依赖检查

conda list | grep torch

3.D JupyterNotebook

pip install jupyter

4. Cupy 离线部署

Pytorch 与 Tensorflow 以及 Cupy 都是使用 GPU 资源进行运算的,Pytorch 与 Tensorflow 的安装和部署较强依赖网络环境资源,数据中心等内网环境部署需要费一番功夫的。Cupy 作为一种数据处理的工具包,可以方便的进行 GPU 算力资源的调用,因此整理离线安装部署过程以作参考。

Cpuy 发行版(操作系统):https://github.com/cupy/cupy/releases

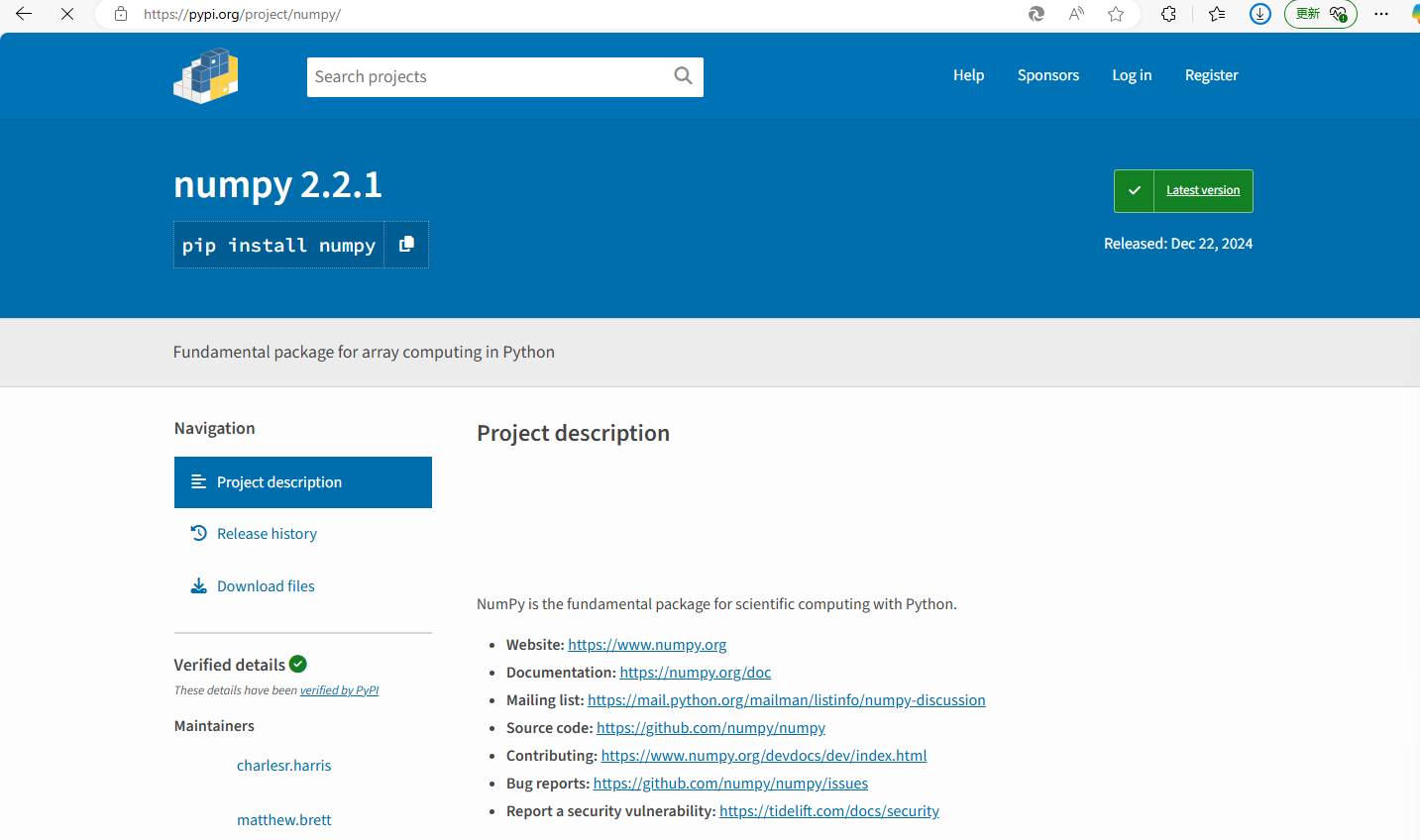

依赖包 Numpy: https://pypi.org/project/numpy/

依赖包 Fastrlock: https://pypi.org/project/fastrlock/0.8.2/#files

pip install fastrlock-0.8.2-cpxx-cpxx-manylinux_2_5_x86_64.manylinux1_x86_64.whl

pip install numpy-xxx.whl

pip install cupy-xxx.whl

Cupy 的 GPU 算力调用代码通过和大模型对话获取,这里不再赘述。

总结

看来大家都想当风口上的猪猪侠,暂且不说在研发领域能够触碰到人工智能和大模型的可能性也不是很大,但是各位都是挺喜欢包装自己的,各路妖魔鬼怪都要对大模型或者深度学习发表一下自己的看法和意见。这个过程少不了各种对人工智能发展的意淫,说白了大多数人只是眼红人工智能带来的经济收益和回报。如果只是听到一些概念就胡乱发散真的不如去睡觉来的轻松自在,物欲横流的世界难得的是闲云野鹤,冷眼旁观。

浙公网安备 33010602011771号

浙公网安备 33010602011771号