Docker 跨主机网络

Docker提供两种原生的跨主机网络: Overlay 和 Macvlan

libnetwork & CNM

libnetwork 是 docker 容器网络库,最核心的内容是其定义的 Container Network Model (CNM),这个模型对容器网络进行了抽象,由以下三类组件组成:

Sandbox

Sandbox 是容器的网络栈,包含容器的 interface、路由表和 DNS 设置。 Linux Network Namespace 是 Sandbox 的标准实现。Sandbox 可以包含来自不同 Network 的 Endpoint。

Endpoint

Endpoint 的作用是将 Sandbox 接入 Network。Endpoint 的典型实现是 veth pair,后面我们会举例。一个 Endpoint 只能属于一个网络,也只能属于一个 Sandbox。

Network

Network 包含一组 Endpoint,同一 Network 的 Endpoint 可以直接通信。Network 的实现可以是 Linux Bridge、VLAN 等。

下面是 CNM 的示例:

创建Overlay网络

环境host1(172.16.65.151)、host2(172.16.65.152)、host3(172.16.65.153)

Docerk overlay 网络需要一个 key-value 数据库用于保存网络状态信息,包括 Network、Endpoint、IP 等。Consul、Etcd 和 ZooKeeper 都是 Docker 支持的 key-vlaue 软件,我们这里使用 Consul。

最简单的方式是以容器方式运行 Consul:

在host3上面运行 #docker run -d -p 8500:8500 -h consul --name consul progrium/consul -server -bootstrap

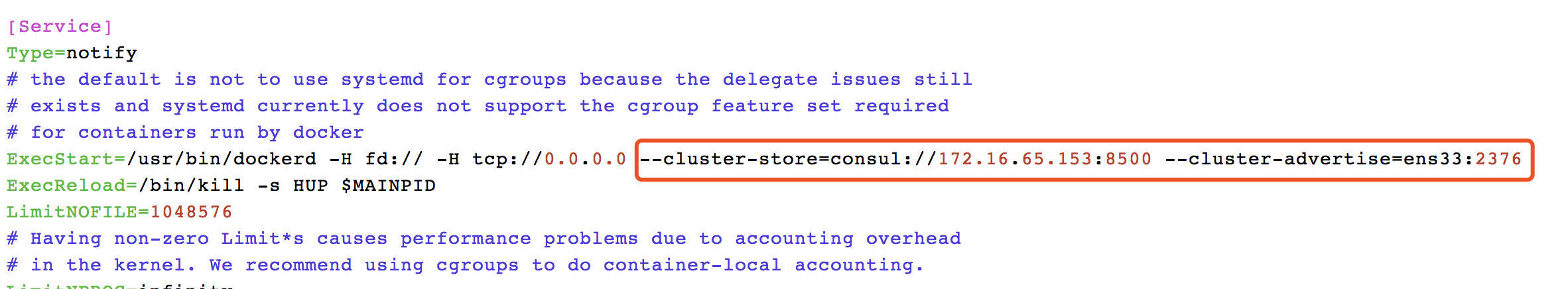

接下来修改 host1 和 host2 的 docker daemon 的配置文件 /lib/systemd/system/docker.service (不同的版本可能位置不一样)

--cluster-store 指定 consul 的地址。--cluster-advertise 告知 consul 自己的连接地址。

重启 docker daemon。

systemctl daemon-reload

systemctl restart docker.service

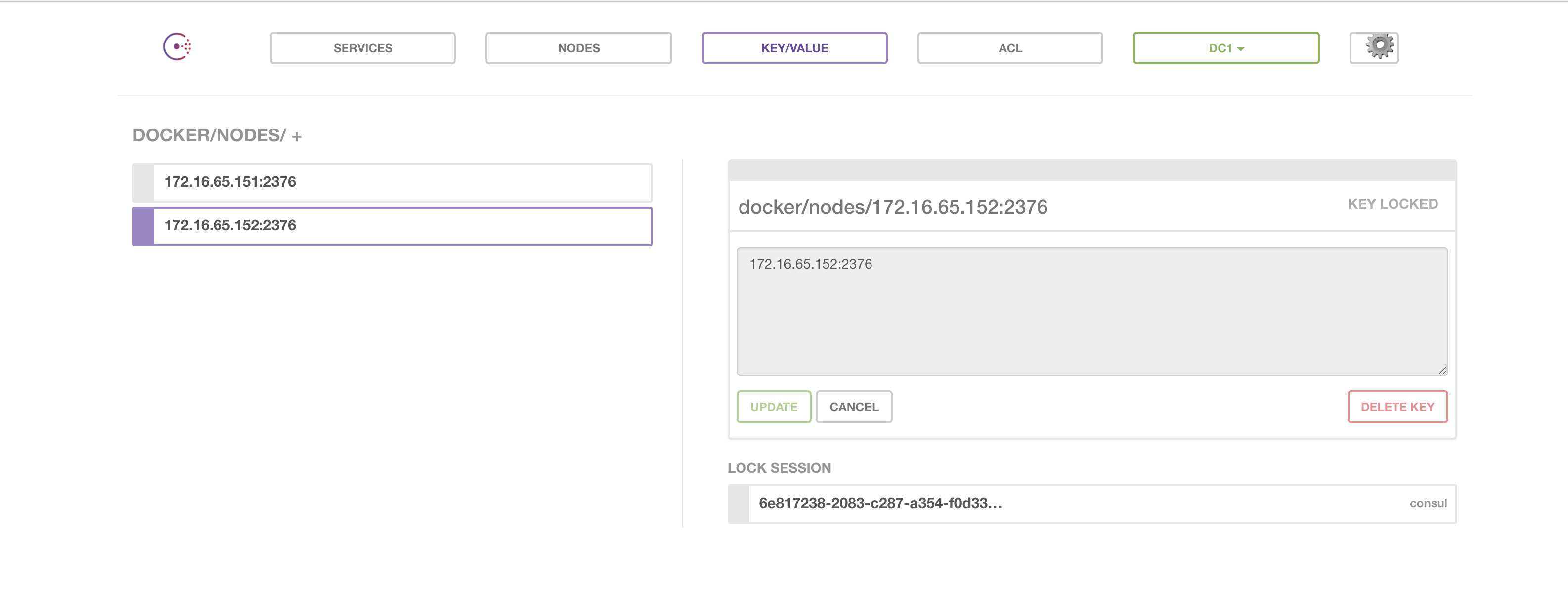

Docker主机将自动注册到Consul数据库中

在 host1 中创建 overlay 网络 ov_net1:

-d overlay 指定 driver 为 overaly。

docker network ls 查看当前网络:

注意到 ov_net1 的 SCOPE 为 global,而其他网络为 local。在 host2 上查看存在的网络:

host2 上也能看到 ov_net1。这是因为创建 ov_net1 时 host1 将 overlay 网络信息存入了 consul,host2 从 consul 读取到了新网络的数据。之后 ov_net 的任何变化都会同步到 host1 和 host2。

运行一个 busybox 容器并连接到 ov_net1:

查看容器的网络配置:

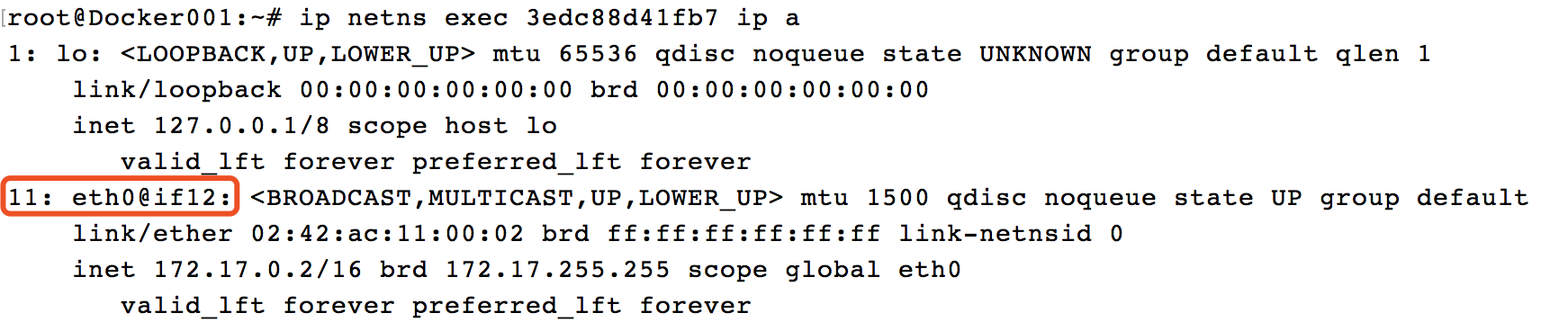

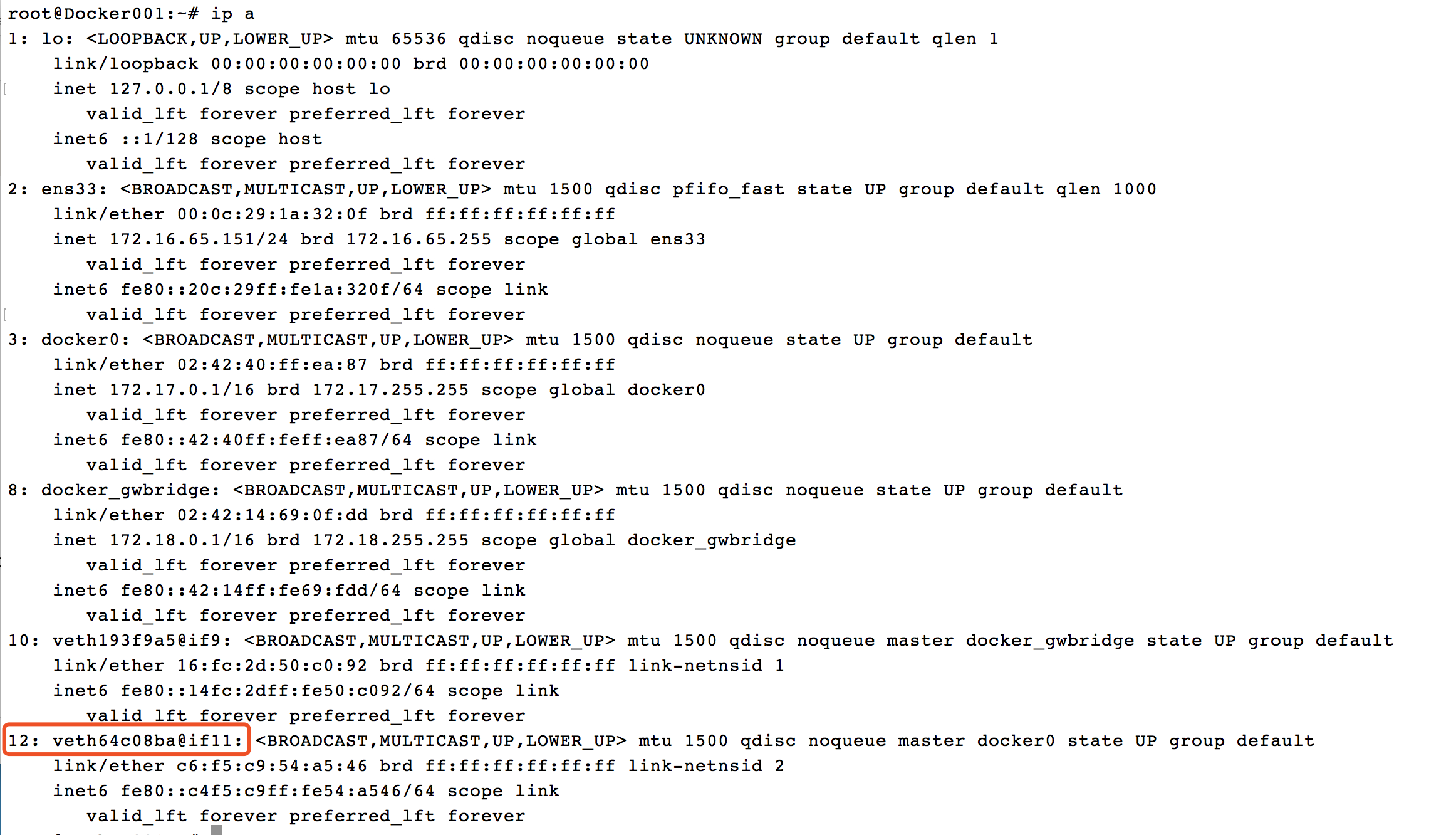

bbox1 有两个网络接口 eth0 和 eth1。eth0 IP 为 10.0.0.2,连接的是 overlay 网络 ov_net1。eth1 IP 172.17.0.2,容器的默认路由是走 eth1,eth1 是哪儿来的呢?

其实,docker 会创建一个 bridge 网络 “docker_gwbridge”,为所有连接到 overlay 网络的容器提供访问外网的能力。

从 docker network inspect docker_gwbridge 输出可确认 docker_gwbridge 的 IP 地址范围是 172.17.0.0/16,当前连接的容器就是 bbox1(172.17.0.2)。

而且此网络的网关就是网桥 docker_gwbridge 的 IP 172.17.0.1。

这样容器 bbox1 就可以通过 docker_gwbridge 访问外网。

如果外网要访问容器,可通过主机端口映射,比如:

docker run -p 80:80 -d --net ov_net1 --name web1 httpd

在 host2 中运行容器 bbox2:

bbox2 IP 为 10.0.0.3,可以直接 ping bbox1:

可见 overlay 网络中的容器可以直接通信,同时 docker 也实现了 DNS 服务。

下面我们讨论一下 overlay 网络的具体实现:

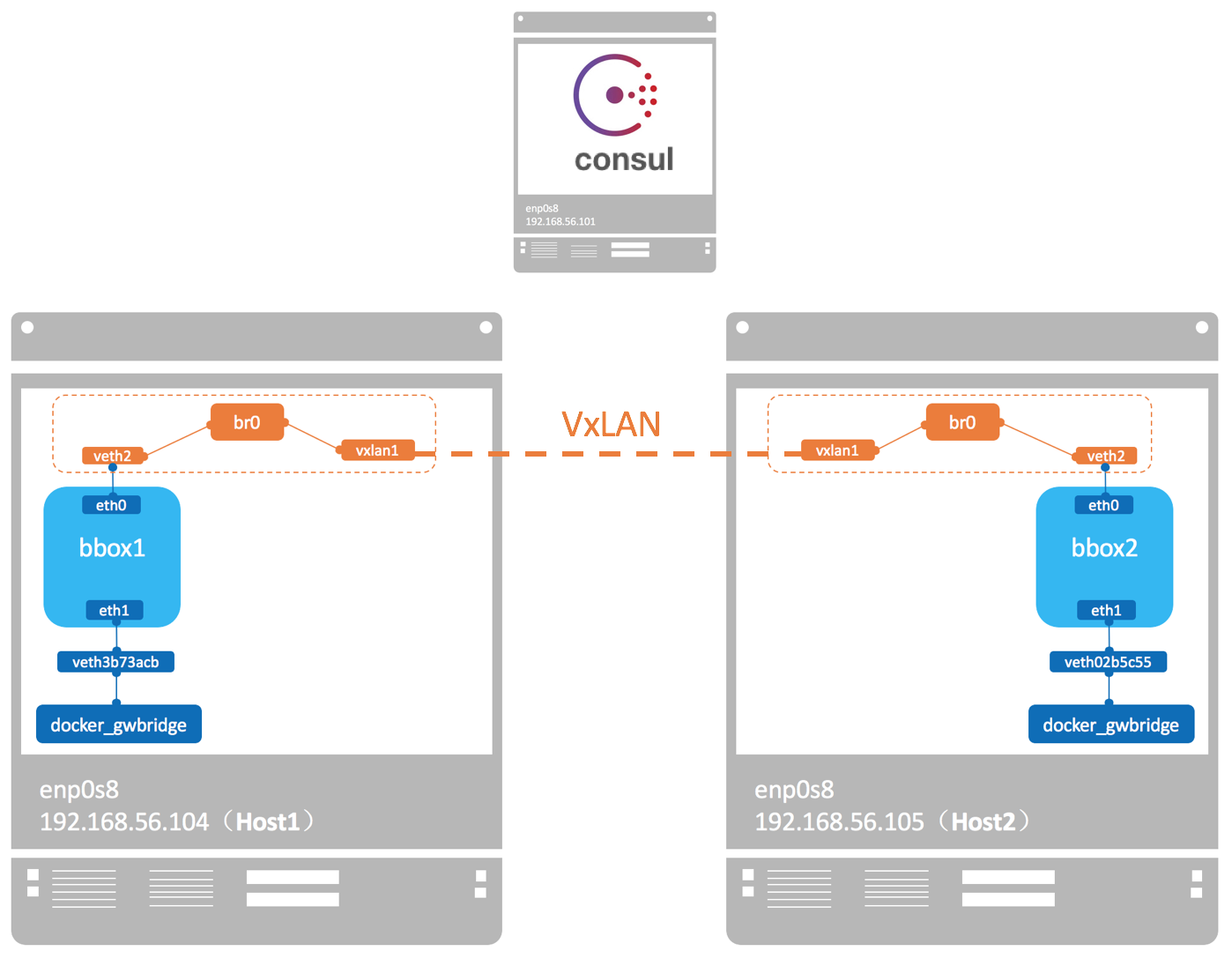

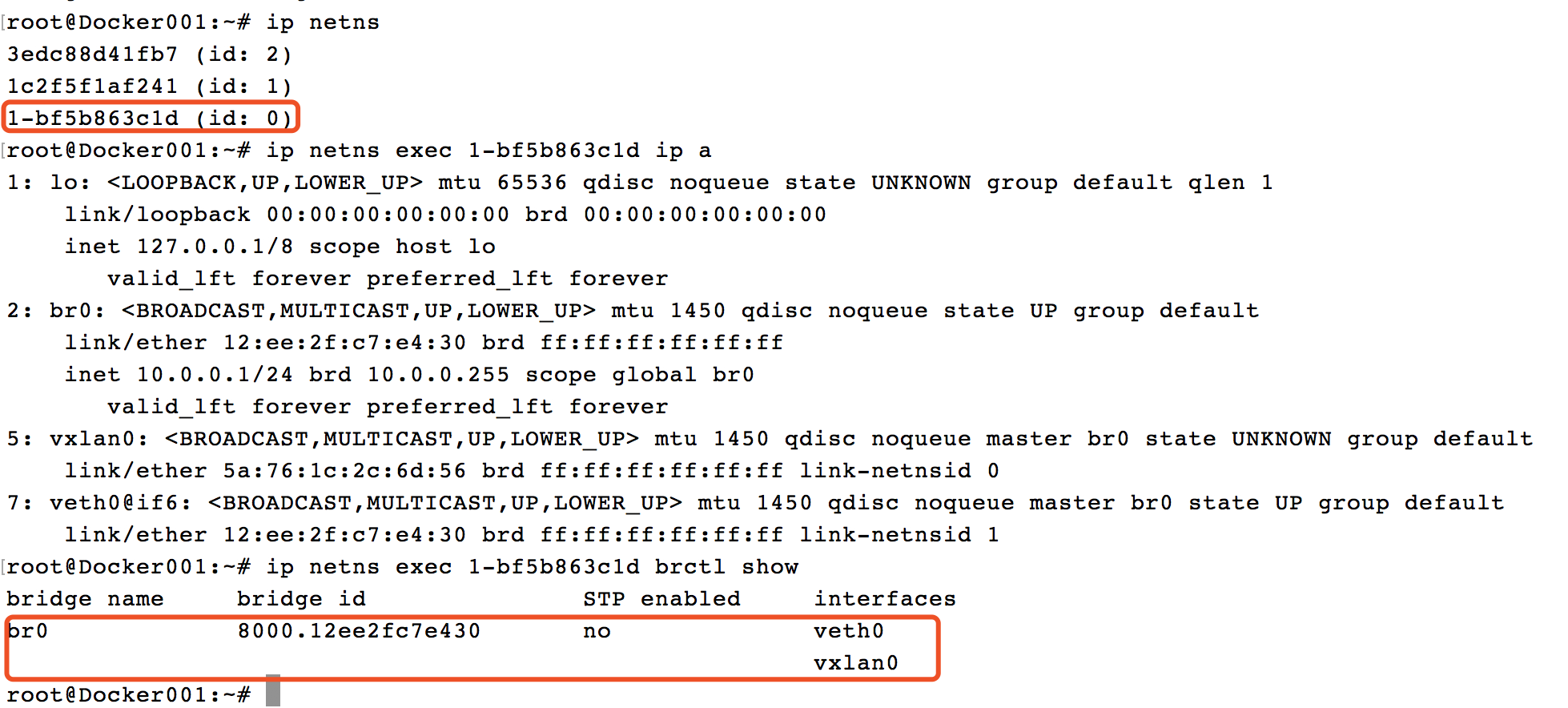

docker 会为每个 overlay 网络创建一个独立的 network namespace,其中会有一个 linux bridge br0,endpoint 还是由 veth pair 实现,一端连接到容器中(即 eth0),另一端连接到 namespace 的 br0 上。

br0 除了连接所有的 endpoint,还会连接一个 vxlan 设备,用于与其他 host 建立 vxlan tunnel。容器之间的数据就是通过这个 tunnel 通信的。逻辑网络拓扑结构如图所示:

要查看 overlay 网络的 namespace 可以在 host1 和 host2 上执行 ip netns(请确保在此之前执行过 ln -s /var/run/docker/netns /var/run/netns),可以看到两个 host 上有一个相同的 namespace

这就是 ov_net1 的 namespace,查看 namespace 中的 br0 上的设备。

查看 vxlan1 设备的具体配置信息可知此 overlay 使用的 VNI(VxLAN ID)为 256。

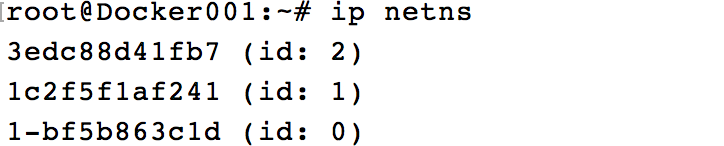

每个Container启动后,都会创建一个Network NameSpace, 可以通过ip netns进行查看

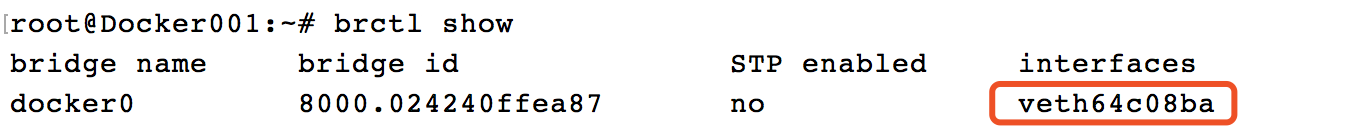

可以看到Container的网卡eth0@if12和宿主机的网卡veth64c08ba@if11是一对veth pair,然后桥接到docker0这个Bridge上的

Docker Overlay 创建的Network NameSpace中有自己的Bridge网络,将vxlan网络和Container的网卡进行连接

浙公网安备 33010602011771号

浙公网安备 33010602011771号