OpenCode 一个神奇的CLI (可以融合Claude Code, iFLow, Copilot, Google, 阿里,智谱等)

https://opencode.ai/

https://opencode.ai/docs

- OpenCode 是一个开源代理,可帮助您直接从终端编写和运行代码。

- 原生 TUI响应式、原生、可主题化的终端 UI

- 启用 LSP自动为 LLM 加载正确的 LSP

- 多会话在同一项目上并行启动多个代理

- 分享链接共享指向任何会话的链接以供参考或调试

- Claude Pro 使用 Anthropic 登录以使用您的 Claude Pro 或 Max 帐户

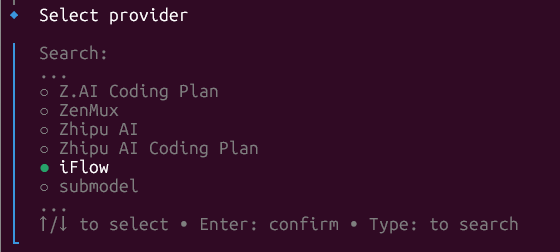

- 通过 Models.dev 的任何模型 75+ LLM 提供商,包括本地模型

- 任何编辑器OpenCode 在您的终端中运行,将其与任何 IDE 配对

安装命令

curl -fsSL https://opencode.ai/install | bash

或

npm i -g opencode-ai

运行方式:

opencode #正常运行

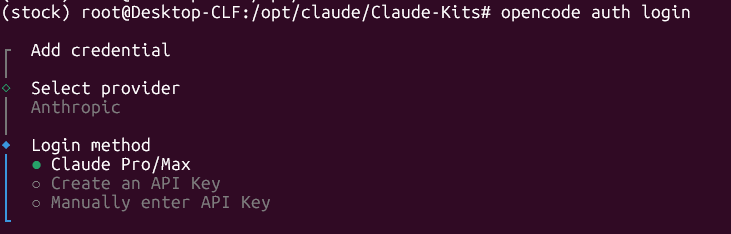

opencode auth login #使用其它方式运行,这里可以选 Anthropic, 连接到Claude Code, 或者 iFlow,太强了

我刚研究出一个方法,先用opencode auth login, 调起iflow, 把key配置好,再[安装openspec](npm install -g @fission-ai/openspec@latest), 然后进入项目目录,openspec init, 然后启动opencode, 就可以用/openspec命令了,比speckit好像更强一些。

https://github.com/Fission-AI/OpenSpec

https://opencode.ai/docs

设置文件

~/.local/share/opencode/auth.json

Credentials

When you add a provider’s API keys with opencode auth login, they are stored in ~/.local/share/opencode/auth.json.

Config

You can customize the providers through the provider section in your OpenCode config.

~/.config/opencode/package.json

设置不同的AI入口,参考:https://opencode.ai/docs/providers/

Ollama

{

"$schema": "https://opencode.ai/config.json",

"provider": {

"ollama": {

"npm": "@ai-sdk/openai-compatible",

"name": "Ollama (local)",

"options": {

"baseURL": "http://localhost:11434/v1"

},

"models": {

"llama2": {

"name": "Llama 2"

}

}

}

}

}

在此示例中:

ollama是自定义提供程序 ID。这可以是您想要的任何字符串。

npm指定要用于此提供程序的包。这里,用于任何与 OpenAI 兼容的 API。@ai-sdk/openai-compatible

name是 UI 中提供程序的显示名称。

options.baseURL是本地服务器的端点。

models是模型 ID 到其配置的映射。模型名称将显示在模型选择列表中。

其他提供商

在项目目录中创建或更新文件:opencode.json

{

"$schema": "https://opencode.ai/config.json",

"provider": {

"myprovider": {

"npm": "@ai-sdk/openai-compatible",

"name": "My AI ProviderDisplay Name",

"options": {

"baseURL": "https://api.myprovider.com/v1"

},

"models": {

"my-model-name": {

"name": "My Model Display Name"

}

}

}

}

}

以下是配置选项:

npm:要使用的 AI SDK 包,适用于 OpenAI 兼容提供商@ai-sdk/openai-compatible

name:UI 中的显示名称。

型号:可用型号。

options.baseURL:API 端点 URL。

options.apiKey:如果不使用身份验证,则可选择设置 API 密钥。

options.headers:(可选)设置自定义标头。

在下面的示例中详细介绍高级选项。

运行该命令,您的自定义提供程序和模型将显示在选择列表中。/models

一个示例:

下面是设置 、 和 model 选项的示例。apiKeyheaderslimit

{

"$schema": "https://opencode.ai/config.json",

"provider": {

"myprovider": {

"npm": "@ai-sdk/openai-compatible",

"name": "My AI ProviderDisplay Name",

"options": {

"baseURL": "https://api.myprovider.com/v1",

"apiKey": "{env:ANTHROPIC_API_KEY}",

"headers": {

"Authorization": "Bearer custom-token"

}

},

"models": {

"my-model-name": {

"name": "My Model Display Name",

"limit": {

"context": 200000,

"output": 65536

}

}

}

}

}

}

配置详细信息:

apiKey:使用变量语法设置,了解更多:.env

headers:随每个请求发送的自定义标头。

limit.context:模型接受的最大输入令牌数。

limit.output:模型可以生成的最大令牌数。

这些字段允许 OpenCode 了解您还剩下多少上下文。标准提供商会自动从 models.dev 中提取这些内容。limit

浙公网安备 33010602011771号

浙公网安备 33010602011771号