Spark:win10下Idea配置spark环境

Windows10环境配置

先在spark和hadoop官网上下载对应的版本(spark官网会推荐对应的hadoop版本)。

将下载下来的包解压到对应的文件夹,hadoop解压时需以管理员身份运行winRAR,否则会出错。

D:\Spark\spark-3.0.1-bin-hadoop2.7

D:\Hadoop\hadoop-2.7.7

在github上搜索winUtils,选择前两个库中的一个,下载对应版本的hadoop2.7.7/bin。

用下载下来的bin替换原hadoop2.7.7/bin

配置环境变量

Path新建:![]()

新建HADOOP_HOME

![]()

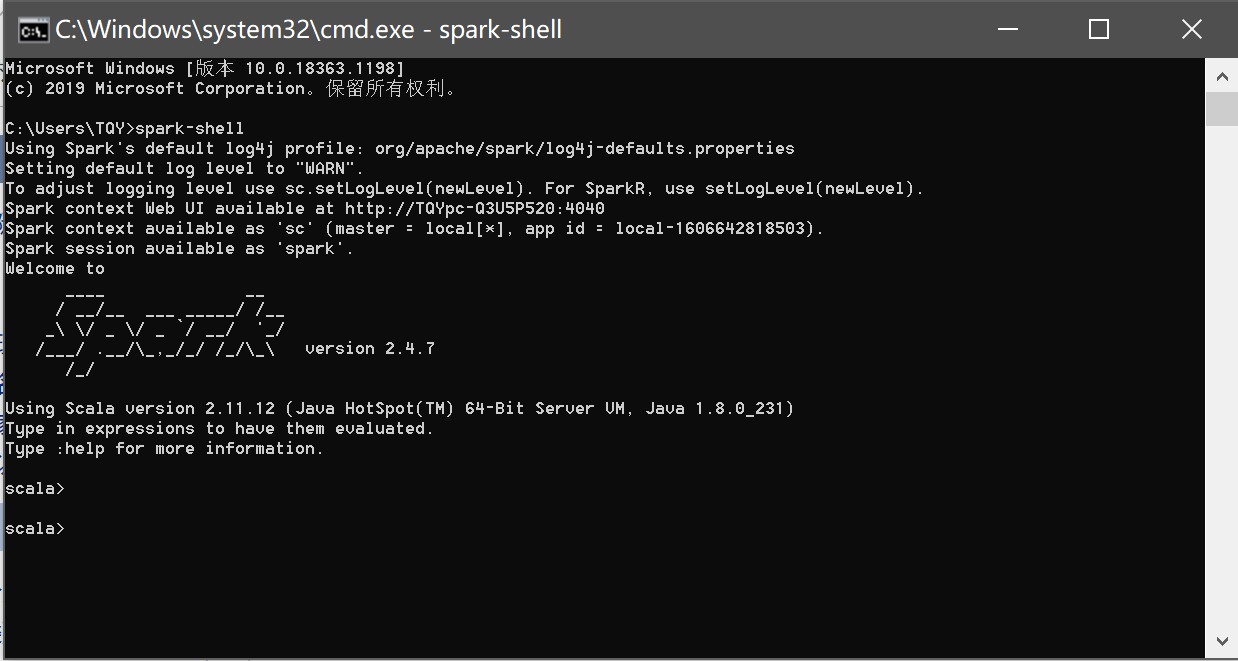

在cmd里运行spark-shell

成功!

IDEA下环境配置

浙公网安备 33010602011771号

浙公网安备 33010602011771号