神经网络:学习率衰减

比较简单的道理:

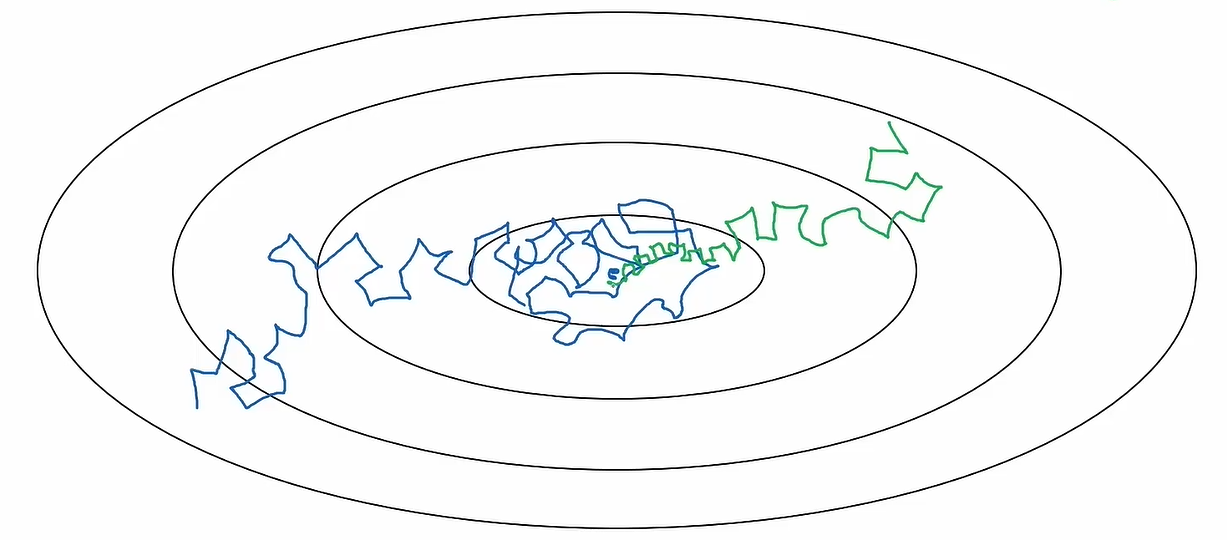

当刚开始进行训练/进行梯度下降时,距离0梯度还有很长一段过程,所以此时可以大胆地提高训练步长,即保持高学习率

而当梯度下降到一定程度,差不多在0梯度或目标梯度附近变动时,此时若保持高学习率,会造成无法收敛(如图蓝色曲线),所以需要降低学习率,以小步长进行梯度下降

常见的学习率衰减方式有许多,下面给出在pytorch框架下的一些衰减函数

https://zhuanlan.zhihu.com/p/380795956

比较简单的道理:

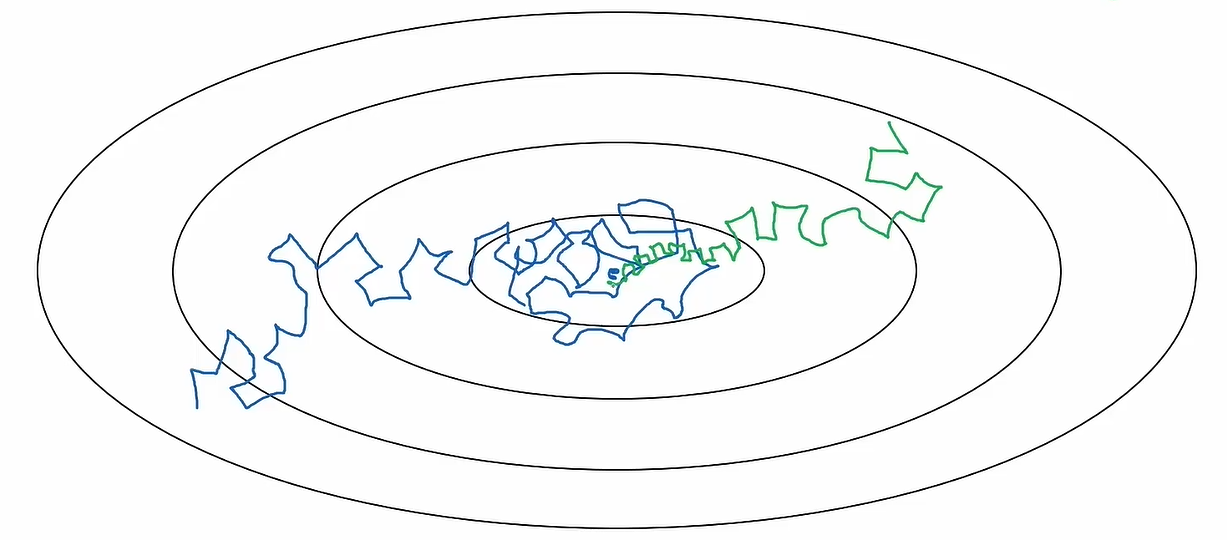

当刚开始进行训练/进行梯度下降时,距离0梯度还有很长一段过程,所以此时可以大胆地提高训练步长,即保持高学习率

而当梯度下降到一定程度,差不多在0梯度或目标梯度附近变动时,此时若保持高学习率,会造成无法收敛(如图蓝色曲线),所以需要降低学习率,以小步长进行梯度下降

常见的学习率衰减方式有许多,下面给出在pytorch框架下的一些衰减函数

https://zhuanlan.zhihu.com/p/380795956