Flume日志数据采集优秀的工具简介

2026-01-16 09:47 tlnshuju 阅读(0) 评论(0) 收藏 举报目录

引入Flume

在现代大数据系统中,应用程序、服务器和网络设备每时每刻都在产生海量的日志数据(如点击流、交易记录、系统日志等)。这些数据通常分散在不同的机器上,需要被可靠、高效、实时地收集起来,并传输到像HDFS、HBase、Kafka这样的集中存储或处理系统中进行分析。

传统方法(如使用scp、脚本拷贝)在数据量剧增时面临诸多挑战:

- 可靠性差:网络或目标系统故障易导致数据丢失。

- 效率低下:无法满足实时或准实时收集需求。

- 扩展性差:难以应对数据源和数据量的动态增长。

- 缺乏统一管理:配置分散,运维复杂。

Flume应运而生,它正是为了解决海量日志数据的采集、聚合和传输问题而设计的分布式系统。

Flume定义

Apache Flume 是一个高可用、高可靠、分布式的海量日志采集、聚合和传输系统。

其设计理念基于流式数据流,具有以下特性:

- 可靠性:提供端到端的可靠性保障(通过事务机制)。

- 可扩展性:水平扩展架构,支持添加更多的代理(Agent)。

- 可管理性:配置驱动,易于管理和监控。

- 高性能:能够处理来自多个数据源的海量数据。

- 声明式配置:无需编写复杂代码,通过配置文件即可定义数据流。

Flume架构及组件

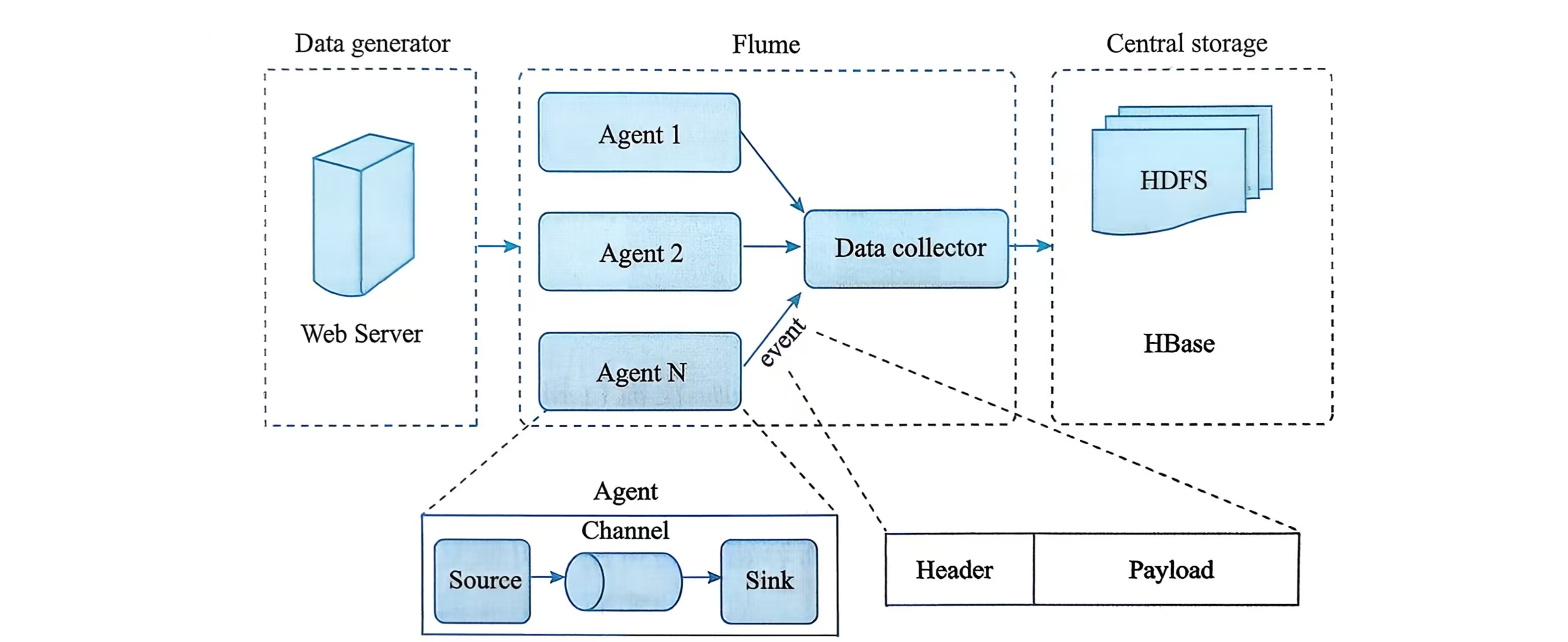

Flume的核心是Agent。一个Agent是一个JVM进程,它是Flume数据流的基本工作单元。复杂的流可以通过多个Agent级联形成。

Agent内部三大组件

①Source (源)

职责:从数据发生器(如Web Server、日志文件)接收或抓取数据。

工作机制:主动轮询数据源或被动等待数据推送。

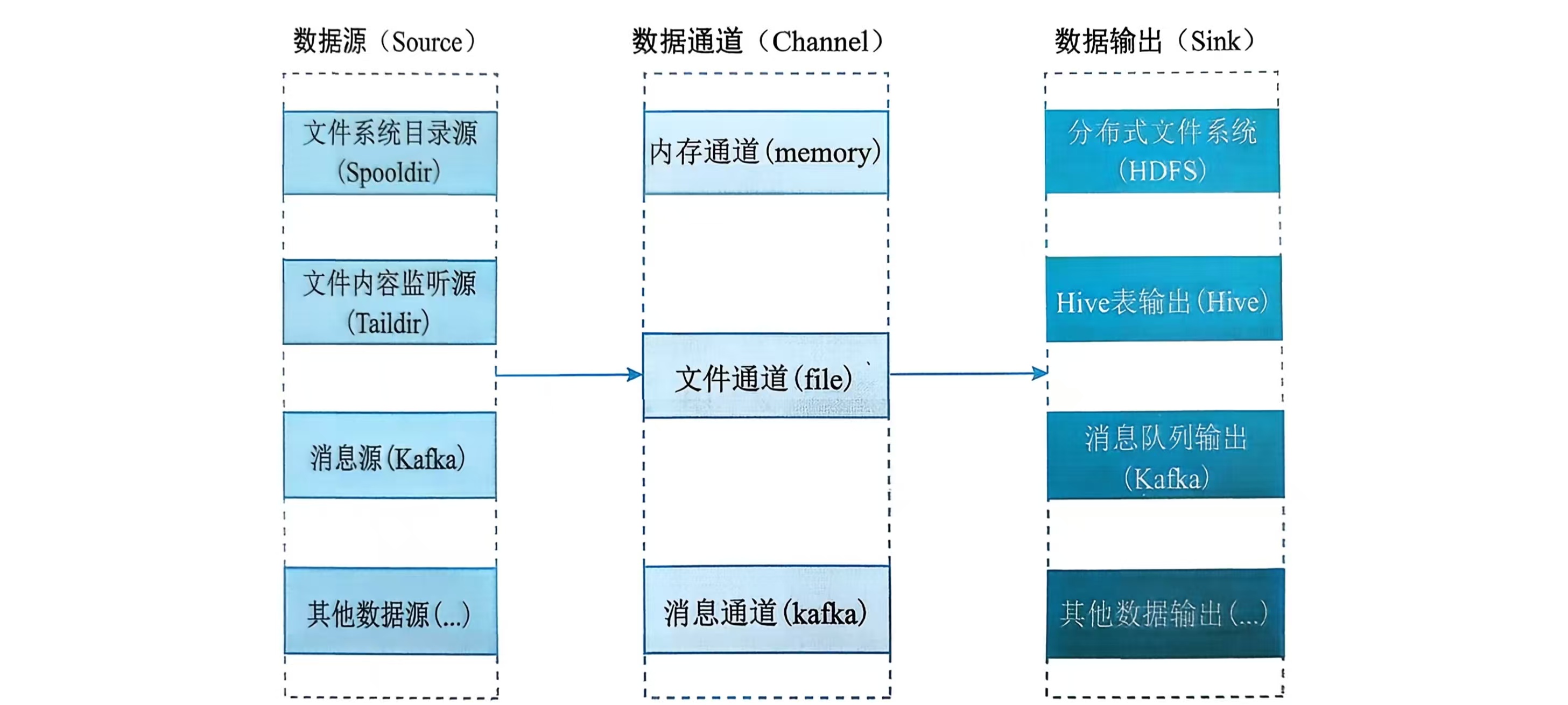

常见类型:

- exec:执行一个命令(如tail -F),采集命令输出。

- netcat:监听指定端口,接收TCP/UDP数据。

- avro:监听Avro端口,接收来自其他Flume Agent的数据,用于构建多级流。

- spooldir:监控一个目录,采集其中新增的文件。

- kafka:从Kafka主题中消费消息作为数据源。

②Channel (通道)

职责:是Source和Sink之间的缓冲区。临时存储Event,直到被Sink消费。

作用:解耦Source和Sink的速率差异,提供可靠性。

常见类型:

- Memory Channel:将事件存储在内存队列中。吞吐量高,但故障时可能丢失数据。

- File Channel:将事件持久化到本地磁盘。可靠性高,但速度较慢。

- JDBC Channel:使用嵌入式数据库存储事件,实验性功能。

- Kafka Channel:使用Kafka作为缓冲,兼具高吞吐和持久性。

Sink (汇)

职责:从Channel中取出事件,并将其传输到下一个目的地或最终存储系统。

工作机制:定期轮询Channel,批量取出事件进行传输。

常见类型:

- logger:将事件作为日志信息输出到控制台(主要用于调试)。

- hdfs:将事件写入Hadoop HDFS,支持文本、序列文件等多种格式。

- avro:将事件发送到指定的Avro端口,通常用于传递给下一个Flume Agent。

- hbase:将事件写入HBase数据库。

- kafka:将事件发布到Kafka主题。

数据模型Event

Event是Flume传输的基本数据单元。

一个Event由Header(头信息)和Body(负载)组成。

- Header:一个Map<String, String>结构,用于存放元数据(如来源、类型、优先级等),可用于路由和过滤。

- Body:一个字节数组,承载实际的数据负载(如一行日志内容)。

多Agent流与复用

多级串联:多个Agent可以连接起来,形成复杂的数据流管道(例如:Agent1(收集) -> Agent2(聚合) -> HDFS)。

- 扇入:多个第一层Agent可以将数据汇聚到一个第二层Agent,实现日志聚合。

- 扇出 :一个Agent的Sink可以将数据同时发往多个目的地(如同时写入HDFS和Kafka)。通过Sink组和选择器(复制或多路复用选择器)实现。

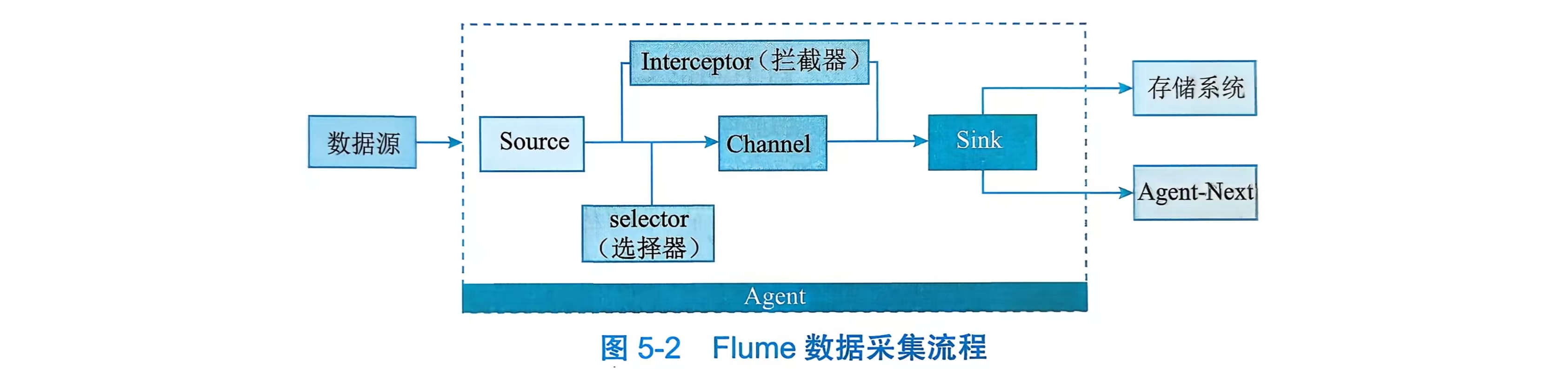

Flume采集流程

1. 数据输入:数据源→Source

- 数据源(比如日志文件、消息队列等)产生的数据,首先会被 Flume 的Source组件接收。

2. Agent 内部流转:Source→Interceptor→Selector→Channel

- 数据进入 Source 后,会在 Agent 内部经过以下组件处理:

- Interceptor(拦截器):对数据做预处理(比如过滤、格式转换、添加标记),可以有多个拦截器按顺序执行。

- Selector(选择器):决定数据要发送到哪个Channel(如果有多个 Channel 的话);默认是 “复制所有数据到所有 Channel”,也可以自定义规则(比如按数据内容分流)。

- Channel(通道):是 Agent 内部的 “临时存储缓冲”,负责缓存数据(避免 Source 和 Sink 速度不匹配导致数据丢失),常见的有内存 Channel、文件 Channel 等。

3. 数据输出:Channel→Sink→目标系统

- Channel 中的数据会被Sink组件消费,最终发送到目标系统:

- Sink 从 Channel 中读取数据,然后将数据输出到存储系统(比如 HDFS、HBase)或下一个 Agent(Agent-Next),实现跨 Agent 的分布式数据传输。

简单总结就是:数据源 → Source → (Interceptor预处理)→ (Selector选Channel)→ Channel缓存 → Sink输出 → 存储系统/下一个Agent

使用Flume

Flume的使用精髓在于编写*.conf配置文件。

运行

# 1.创建配置文件

vi job.conf

# 2.启动Agent(最常用命令)

bin/flume-ng agent \

--conf conf \ # 配置文件目录

--conf-file job.conf \ # 你的配置文件

--name a1 \ # Agent名称(必须和配置文件里一致)

-Dflume.root.logger=INFO,console # 控制台输出日志

# 3.后台运行(生产环境)

nohup bin/flume-ng agent --conf conf --conf-file job.conf --name a1 &Source

①执行命令

# 实时监控日志文件(最常用)

agent.sources.src.type = exec

agent.sources.src.command = tail -F /var/log/application.log

# 执行任意shell命令

agent.sources.src.command = /bin/bash -c "cat /tmp/data.txt"②监控目录

# 监控目录,有新文件就采集

agent.sources.src.type = spooldir

agent.sources.src.spoolDir = /data/logs # 监控目录

agent.sources.src.fileSuffix = .COMPLETED # 处理完的文件加后缀

agent.sources.src.deletePolicy = never # 不删除原文件③网络端口

# 监听端口,接收网络数据(测试用)

agent.sources.src.type = netcat

agent.sources.src.bind = localhost

agent.sources.src.port = 44444④接收其他Flume数据

# 接收其他Agent发来的数据

agent.sources.src.type = avro

agent.sources.src.bind = 0.0.0.0

agent.sources.src.port = 41414Channel

① Memory Channel(内存,性能好)

agent.channels.ch.type = memory

agent.channels.ch.capacity = 10000 # 最大存10000个事件

agent.channels.ch.transactionCapacity = 1000 # 每次事务处理1000个② File Channel(文件,更可靠)

agent.channels.ch.type = file

agent.channels.ch.checkpointDir = /data/checkpoint # 检查点目录

agent.channels.ch.dataDirs = /data/channel # 数据存储目录③ Kafka Channel(用Kafka当缓冲)

agent.channels.ch.type = org.apache.flume.channel.kafka.KafkaChannel

agent.channels.ch.kafka.bootstrap.servers = kafka1:9092

agent.channels.ch.kafka.topic = flume-channelSink

① Logger Sink(输出到控制台,调试用)

agent.sinks.sk.type = logger② HDFS Sink(写入HDFS,最常用)

agent.sinks.sk.type = hdfs

agent.sinks.sk.hdfs.path = hdfs://namenode:8020/flume/events/%Y-%m-%d/%H

agent.sinks.sk.hdfs.filePrefix = data-

agent.sinks.sk.hdfs.rollInterval = 3600 # 1小时切一个新文件

agent.sinks.sk.hdfs.rollSize = 134217728 # 128MB切一个新文件

agent.sinks.sk.hdfs.rollCount = 0 # 不按事件数切文件③ Kafka Sink(写入Kafka)

agent.sinks.sk.type = org.apache.flume.sink.kafka.KafkaSink

agent.sinks.sk.kafka.bootstrap.servers = kafka1:9092,kafka2:9092

agent.sinks.sk.kafka.topic = mytopic④ Avro Sink(发给其他Flume)

agent.sinks.sk.type = avro

agent.sinks.sk.hostname = 192.168.1.100 # 目标机器IP

agent.sinks.sk.port = 41414 # 目标端口Interceptor

用作做数据处理

# 添加时间戳

agent.sources.src.interceptors = i1

agent.sources.src.interceptors.i1.type = timestamp

# 添加主机名

agent.sources.src.interceptors = i2

agent.sources.src.interceptors.i2.type = host

agent.sources.src.interceptors.i2.hostHeader = hostname

# 还可以用户自定义拦截器:构建maven项目并添加flume依赖包

# 多个拦截器按顺序执行

agent.sources.src.interceptors = i1 i2

agent.sources.src.interceptors.i1.type = timestamp

agent.sources.src.interceptors.i2.type = host常用命令与操作

①启动命令

# 基础启动

bin/flume-ng agent -n a1 -c conf -f job.conf

# 带日志输出

bin/flume-ng agent -n a1 -c conf -f job.conf -Dflume.root.logger=INFO,console

# 后台启动

nohup bin/flume-ng agent -n a1 -c conf -f job.conf > flume.log 2>&1 &②监控查看

# 查看运行状态(如果开启了监控)

curl http://localhost:41414/metrics

# 查看进程

ps aux | grep flume

# 查看日志

tail -f logs/flume.log③停止Agent

# 找到进程ID并停止

ps -ef | grep flume

kill [PID]

# 或者用pkill

pkill -f flume配置文件结构和示例

基本结构

# 1. 定义组件

[agent名].sources = [source名]

[agent名].channels = [channel名]

[agent名].sinks = [sink名]

# 2. 配置Source

[agent名].sources.[source名].type = [类型]

[agent名].sources.[source名].[其他属性] = [值]

# 3. 配置Channel

[agent名].channels.[channel名].type = [类型]

[agent名].channels.[channel名].[其他属性] = [值]

# 4. 配置Sink

[agent名].sinks.[sink名].type = [类型]

[agent名].sinks.[sink名].[其他属性] = [值]

# 5. 绑定

[agent名].sources.[source名].channels = [channel名]

[agent名].sinks.[sink名].channel = [channel名]Flume传输日志到Kafka示例

①创建一个包含测试内容的日志文件:

# 1. 创建日志文件并写入测试内容

mkdir -p /var/log

cat > /var/log/app.log << EOF

2025-12-19 10:00:00 [INFO] user_id:1001, action:login

2025-12-19 10:00:01 [INFO] user_id:1002, action:order_pay

2025-12-19 10:00:02 [ERROR] db_connect_fail, retry:1

EOF

# 2. 验证日志内容(确认有3行测试数据)

cat /var/log/app.log②配置Flume采集任务

# 1.新建Flumens配置文件

# 进入 Flume 配置目录

cd /opt/apache-flume-1.9.0/conf

# 新建配置文件:flume-kafka.conf

vim flume-kafka.conf

# 2.配置文件内容

# 定义 Agent 名称为 logagent(可自定义)

logagent.sources = exec-source

logagent.channels = memory-channel

logagent.sinks = kafka-sink

# ========== Source 配置(采集日志文件) ==========

# 类型:exec,通过 tail -F 实时监控日志

logagent.sources.exec-source.type = exec

# 执行的命令:读取 app.log

logagent.sources.exec-source.command = cat /var/log/app.log

# 字符编码

logagent.sources.exec-source.charset = UTF-8

# 绑定 Channel

logagent.sources.exec-source.channels = memory-channel

# ========== Channel 配置(内存通道) ==========

logagent.channels.memory-channel.type = memory

# 通道最大容量(事件数)

logagent.channels.memory-channel.capacity = 10000

# 每次从通道取的最大事件数

logagent.channels.memory-channel.transactionCapacity = 1000

# ========== Sink 配置(输出到 Kafka) ==========

logagent.sinks.kafka-sink.type = org.apache.flume.sink.kafka.KafkaSink

# Kafka 集群地址(单节点:IP:9092;集群:ip1:9092,ip2:9092)

logagent.sinks.kafka-sink.kafka.bootstrap.servers = 192.168.1.100:9092

# 输出到的 Kafka 主题(需提前创建)

logagent.sinks.kafka-sink.kafka.topic = app-log-topic

# Kafka 生产者批次大小(可选,优化性能)

logagent.sinks.kafka-sink.kafka.producer.acks = 1

logagent.sinks.kafka-sink.kafka.compression.type = snappy

# 绑定 Channel

logagent.sinks.kafka-sink.channel = memory-channel

# 批量发送大小(可选)

logagent.sinks.kafka-sink.kafka.producer.batch.size = 16384③启动组件

# 1. 启动ZooKeeper(后台)

nohup /opt/kafka/bin/zookeeper-server-start.sh /opt/kafka/config/zookeeper.properties > /dev/null 2>&1 &

# 2. 启动Kafka(后台)

nohup /opt/kafka/bin/kafka-server-start.sh /opt/kafka/config/server.properties > /dev/null 2>&1 &

# 3. 等待5秒(确保Kafka启动完成)

sleep 5

# 4. 创建Kafka主题(首次测试需执行)

/opt/kafka/bin/kafka-topics.sh --create --zookeeper 192.168.1.100:2181 --replication-factor 1 --partitions 3 --topic app-log-topic

# 5. 启动Flume(一次性采集静态日志)

cd /opt/apache-flume-1.9.0

nohup bin/flume-ng agent --name logagent --conf conf --conf-file conf/flume-kafka.conf > logs/flume-kafka.log 2>&1 &④验证采集结果

# 启动Kafka消费者,查看是否能读到静态日志

/opt/kafka/bin/kafka-console-consumer.sh --bootstrap-server 192.168.1.100:9092 --topic app-log-topic --from-beginning

# 能看到3行测试日志即成功

浙公网安备 33010602011771号

浙公网安备 33010602011771号