网络分析模型一

以下是美化后的 Linux 网络缓冲区优化指南,采用更清晰的排版和结构,便于阅读和操作:

Linux 网络缓冲区优化指南

合理设置网络缓冲区(Socket Buffer)能显著提升网络吞吐量和响应速度,尤其在 高延迟、高带宽 的网络环境(如数据中心、视频流传输等)中。以下是详细的操作方法:

1. 查看当前缓冲区设置

使用 sysctl命令查看关键内核参数的当前值:

# TCP 接收缓冲区范围(最小/默认/最大)

sysctl net.ipv4.tcp_rmem

# TCP 发送缓冲区范围(最小/默认/最大)

sysctl net.ipv4.tcp_wmem

# 全局接收/发送缓冲区最大值

sysctl net.core.rmem_max

sysctl net.core.wmem_max2. 临时修改缓冲区大小

通过 sysctl -w临时生效(重启后失效),适用于快速测试:

# 设置 TCP 接收缓冲区:最小 4KB,默认 86KB,最大 16MB

sysctl -w net.ipv4.tcp_rmem='4096 87380 16777216'

# 设置 TCP 发送缓冲区:最小 4KB,默认 64KB,最大 16MB

sysctl -w net.ipv4.tcp_wmem='4096 65536 16777216'

# 设置全局接收/发送缓冲区上限(需 ≥ tcp_rmem/tcp_wmem 的最大值)

sysctl -w net.core.rmem_max=16777216

sysctl -w net.core.wmem_max=167772163. 永久修改缓冲区大小

编辑 /etc/sysctl.conf文件,添加以下配置并执行 sysctl -p永久生效:

# 编辑配置文件(推荐使用 vim/nano)

vim /etc/sysctl.conf

# 添加以下内容(根据实际需求调整数值):

net.ipv4.tcp_rmem = 4096 87380 16777216

net.ipv4.tcp_wmem = 4096 65536 16777216

net.core.rmem_max = 16777216

net.core.wmem_max = 16777216

# 使配置立即生效

sysctl -p4. 其他关键优化参数

(1) 启用 TCP 高级特性

# 启用 TCP 窗口缩放(提升高延迟网络吞吐量)

net.ipv4.tcp_window_scaling = 1

# 启用 TCP 时间戳(辅助计算 RTT,提升拥塞控制精度)

net.ipv4.tcp_timestamps = 1(2) 优化 TIME-WAIT 状态

# 允许复用 TIME-WAIT 连接(节省端口资源)

net.ipv4.tcp_tw_reuse = 1

# 快速回收 TIME-WAIT 连接(注意:在 NAT 环境慎用)

net.ipv4.tcp_tw_recycle = 1 # (Linux 4.12+ 已移除,建议改用 tw_reuse)(3) 拥塞控制算法

# 使用 BBR 算法(适合高带宽、高延迟网络,如 10Gbps+)

net.ipv4.tcp_congestion_control = bbr

# 其他可选算法:cubic(默认)、reno、htcp 等⚠️ 注意:

tcp_tw_recycle在 Linux 4.12 及以上版本已移除,且在 NAT 环境可能导致连接问题,建议优先用tcp_tw_reuse。BBR 算法需内核 ≥ 4.9,并确保未与其他优化冲突。

5. 注意事项

-

合理配置数值

-

缓冲区大小需匹配 服务器内存 和 网络带宽(例如:1Gbps 网络建议

rmem_max/wmem_max至少 16MB~64MB)。 -

过大可能浪费内存,过小会导致吞吐量受限。

-

-

测试验证

-

生产环境修改前,先在 测试环境验证 效果。

-

使用工具(如

iperf3、netperf)评估网络性能变化。

-

-

监控与调优

-

通过

ss -tem或cat /proc/net/sockstat观察缓冲区使用情况。 -

结合

sar -n DEV 1或nload监控实际流量表现。

-

总结

|

优化目标 |

关键参数 |

推荐值(示例) |

|---|---|---|

|

提升吞吐量 |

|

16MB~64MB(按需调整) |

|

高延迟网络优化 |

|

|

|

减少 TIME-WAIT 影响 |

|

|

|

高带宽优化 |

|

|

BDP 和 cwnd 详解(含查看方法)

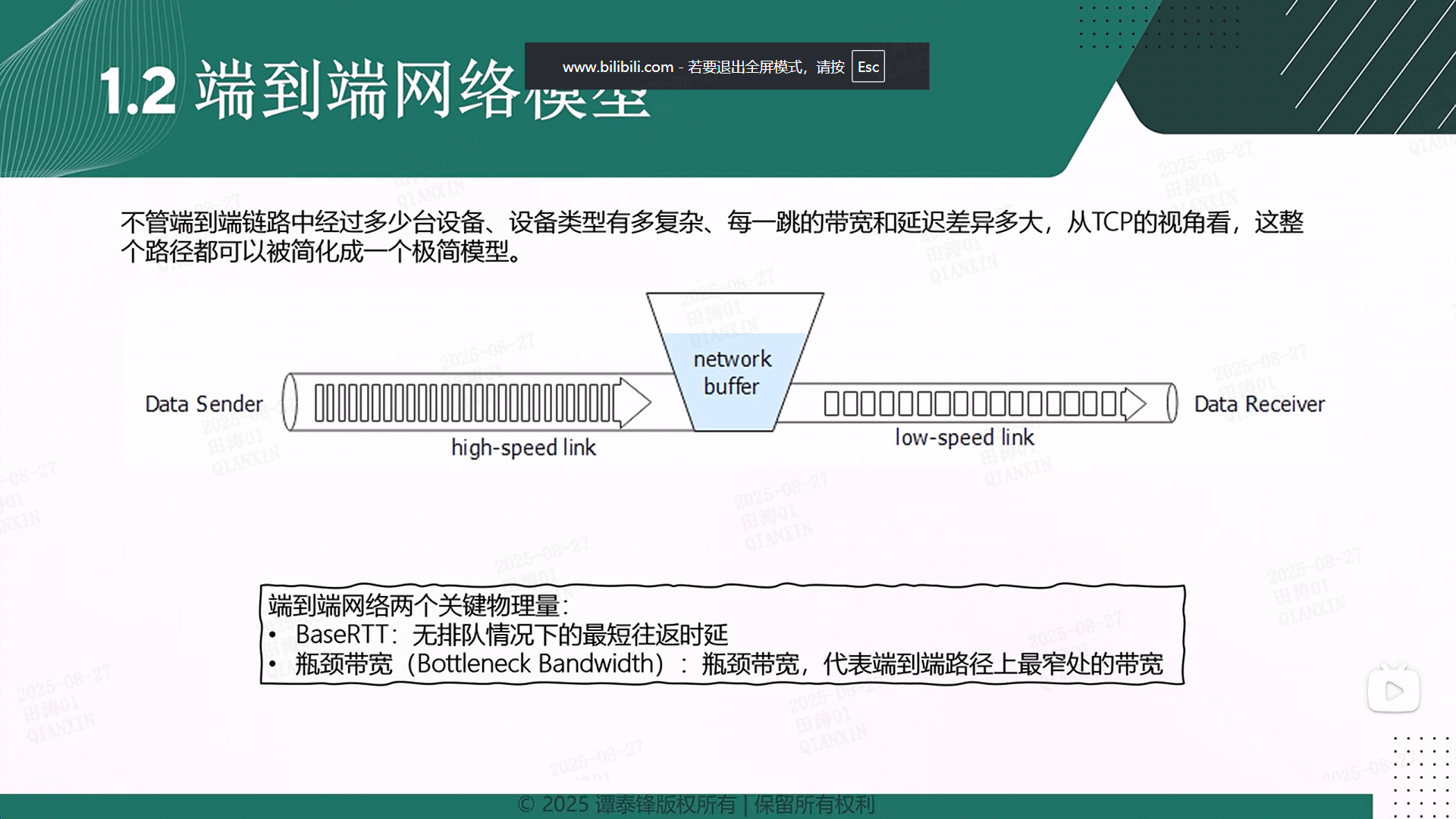

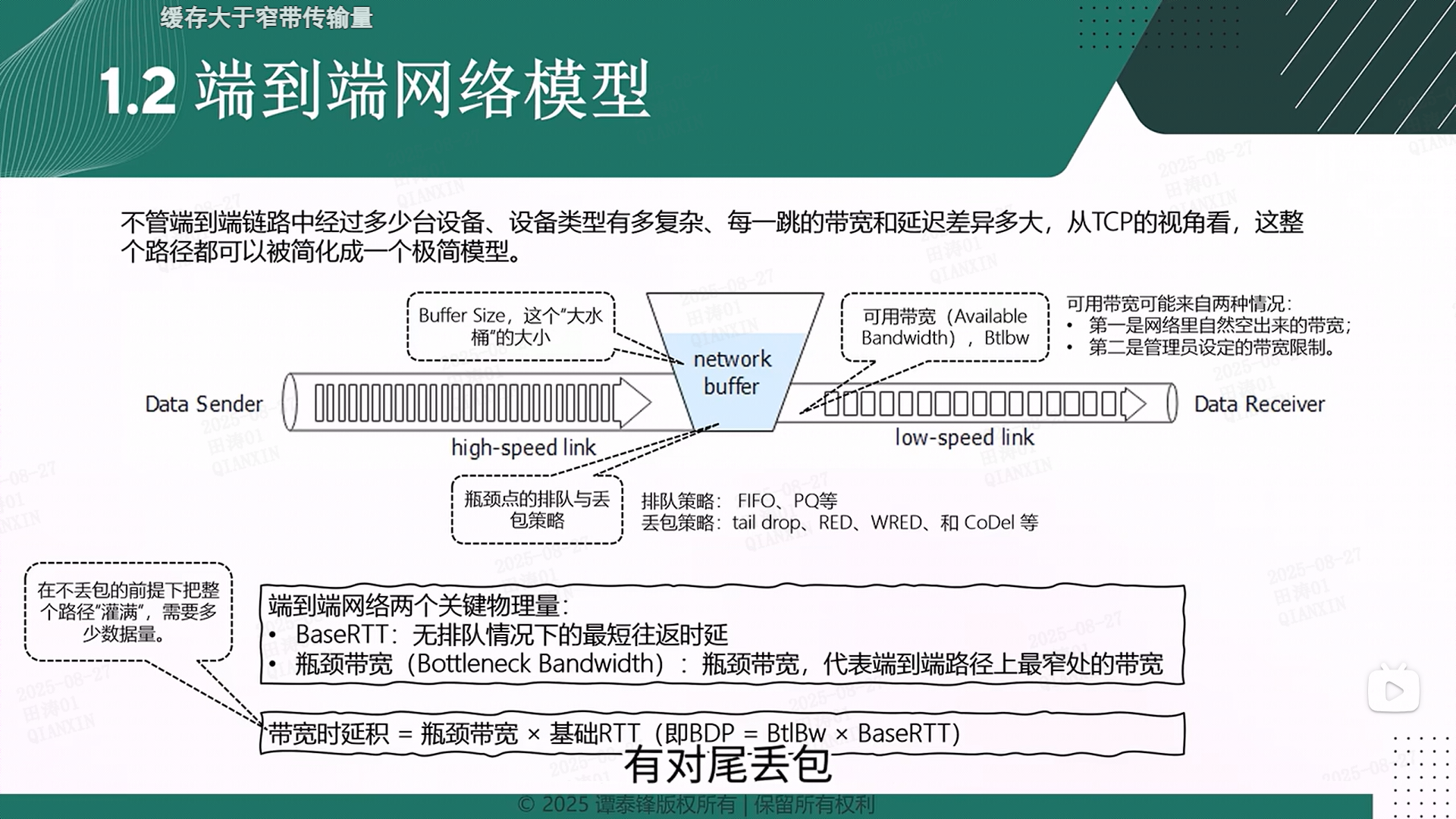

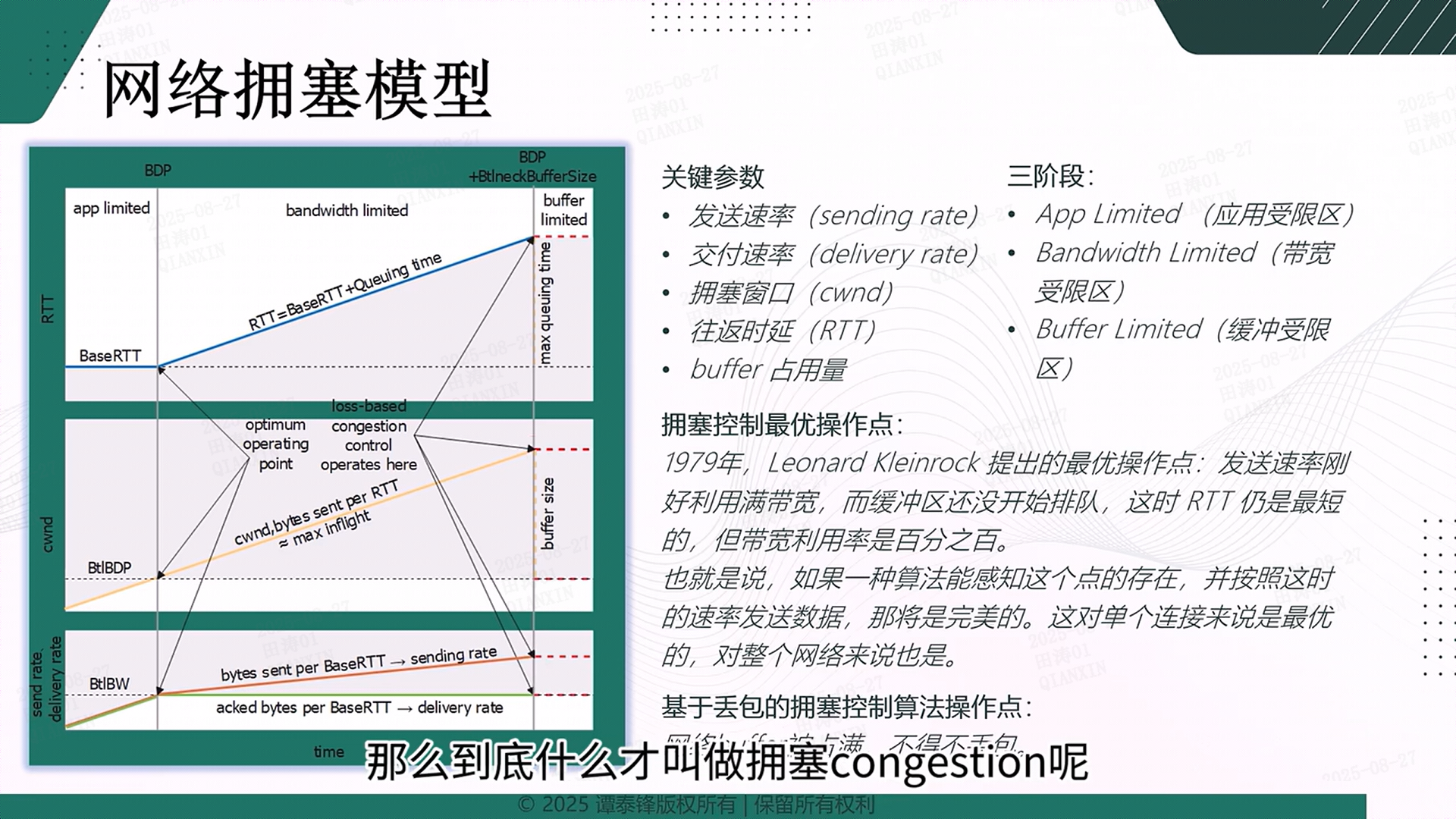

1. BDP(Bandwidth-Delay Product,带宽时延积)

📌 定义

BDP 表示 网络链路在 1 个 RTT(往返时间)内能够传输的最大数据量,即 网络管道的容量。

它是 带宽(Bandwidth) 和 延迟(Delay/RTT) 的乘积,单位通常是 字节(Bytes)。

📐 计算公式

BDP=带宽(Bits/sec)×RTT(秒)

由于 TCP 以 字节(Bytes) 为单位传输数据,通常需要 除以 8:

BDP(Bytes)=8带宽(Bits/sec)×RTT(秒)

🔢 示例计算

假设:

-

带宽 = 100 Mbps(100,000,000 bits/sec)

-

RTT = 50 ms(0.05 秒)

计算:

BDP=8100,000,000×0.05=85,000,000=625,000Bytes≈610KB

这意味着 网络管道在 1 个 RTT 内最多能传输约 610KB 数据。

🌐 实际意义

-

BDP 决定了 TCP 拥塞窗口(cwnd)的理想大小:

为了充分利用带宽,cwnd 应该 ≥ BDP,否则网络无法跑满带宽。

-

如果 cwnd < BDP → 网络利用率低(带宽未充分利用)。

-

如果 cwnd ≈ BDP → 网络传输效率最佳。

-

如果 cwnd > BDP → 可能导致丢包(缓冲区溢出)。

2. cwnd(Congestion Window,拥塞窗口)

📌 定义

cwnd 是 TCP 发送方动态调整的窗口,表示 在未收到 ACK 的情况下,最多可以发送多少数据,用于 防止网络拥塞。

🔄 工作原理

-

慢启动(Slow Start):cwnd 指数增长(1 MSS → 2 MSS → 4 MSS...)。

-

拥塞避免(Congestion Avoidance):cwnd 线性增长(每 RTT +1 MSS)。

-

丢包时:cwnd 减半(乘法减小),并调整慢启动阈值(ssthresh)。

📏 单位

-

MSS(Maximum Segment Size):通常 1460 Bytes(以太网 MTU 1500 - IP/TCP 头 40B)。

-

cwnd 值:如

cwnd=10表示 10 MSS ≈ 14.6KB。

🔍 查看方法

(1) 使用 ss -i命令

ss -i输出示例:

ESTAB 0 0 192.168.1.100:22 192.168.1.200:54321

cubic wscale:7,7 rto:204 rtt:12.500/0.250 ato:40 mss:1448 cwnd:10 send 1.2Mbps rcv_space:29200-

cwnd:10 → 当前拥塞窗口 = 10 MSS(如 10 × 1448 ≈ 14.48KB)。

(2) 使用 tcpdump+ Wireshark 抓包分析

-

观察 TCP ACK 和窗口变化,间接推断 cwnd 调整。

3. BDP 和 cwnd 的关系

|

指标 |

含义 |

理想情况 |

如何查看 |

|---|---|---|---|

|

BDP |

网络管道容量(带宽 × RTT) |

决定 cwnd 的最小理想值 |

手动计算或工具估算 |

|

cwnd |

TCP 发送窗口(防拥塞) |

应 ≥ BDP 以跑满带宽 |

|

✅ 最佳实践

-

如果 cwnd < BDP → TCP 无法充分利用带宽(需优化拥塞控制算法,如 BBR)。

-

如果 cwnd ≈ BDP → 网络传输效率最佳。

-

如果 cwnd > BDP → 可能导致丢包(缓冲区溢出)。

4. 如何计算 BDP 并优化 cwnd?

(1) 计算 BDP

方法 1:手动计算

-

测带宽(如

iperf3):iperf3 -c <server_ip> # 测试带宽(如 100 Mbps) -

测 RTT(如

ping):ping <server_ip> # 查看平均延迟(如 50ms) -

计算 BDP:

BDP=8带宽(Mbps)×1,000,000×RTT(ms)示例(100 Mbps,50ms RTT):

BDP=8100×1,000,000×0.05=625,000Bytes≈610KB

方法 2:使用 tcptrace或 bwping工具

-

这些工具可以自动估算 BDP。

(2) 优化 cwnd(让 cwnd ≥ BDP)

方法 1:使用 BBR 拥塞控制算法(推荐)

# 查看当前算法

sysctl net.ipv4.tcp_congestion_control

# 设置为 BBR(适用于高带宽、高延迟网络)

sysctl -w net.ipv4.tcp_congestion_control=bbr-

BBR 会自动调整 cwnd ≈ BDP,比传统 CUBIC 更高效。

方法 2:调整 TCP 初始窗口(initcwnd)

# 查看当前 initcwnd

ip route show

# 修改某个路由的初始 cwnd(如 10 MSS)

ip route change default via 192.168.1.1 dev eth0 initcwnd 10-

默认 initcwnd 通常是 10 MSS(Linux 4.0+),但可以手动调整以优化短连接。

5. 总结

|

概念 |

定义 |

查看方式 |

优化目标 |

|---|---|---|---|

|

BDP |

带宽 × RTT(网络管道容量) |

手动计算或工具估算 |

cwnd 应 ≥ BDP 以跑满带宽 |

|

cwnd |

TCP 拥塞窗口(防丢包) |

|

动态调整,避免拥塞 |

|

关系 |

cwnd 决定 TCP 吞吐量,BDP 是理论最大值 |

|

让 cwnd ≈ BDP 最佳 |

📌 关键结论

-

BDP 是网络能跑满的极限,cwnd 是 TCP 实际能发的窗口。

-

如果 cwnd < BDP → 带宽未充分利用(需优化 TCP 算法,如 BBR)。

-

如果 cwnd ≈ BDP → 网络传输效率最佳。

-

推荐使用 BBR 算法,它能自动让 cwnd 接近 BDP,提升高延迟网络的吞吐量。

浙公网安备 33010602011771号

浙公网安备 33010602011771号