AMD Instinct MI50 32G显卡在Ubuntu22.04下搭建大模型试玩体验

之前搞了一个二奶机5600G+MI50(32G)平台跑大语言模型,一直在win平台上使用,主要是通过LM Studio+Vulkan使用(傻瓜式),近期尝试了下在linux下搭建和使用,主要是想试下rocm下输出。

以下水下搭建方案和体验。

搭建环境:

1.系统:Ubuntu22.04

Ubuntu22.04网上比较推荐这个版本,主要是驱动问题好解决,另外就是安装显卡驱动和rocm支持。gpu驱动这边用的amdgpu-install_6.3.60303-1_all.deb,供参考。

2.硬件:

CPU:5600G

主板:华硕TUF B450-PRO GAMING

内存:ddr4 2400 32G(垃圾内存混搭,能跑就行)

显卡:MI50 32G(风扇插在主板一个pwm控制口上)

3.模型平台:Ollama (v0.12.3)

参考网上教程安装,主要是下载比较费劲,使用curl很难下载完整,需要些技巧,不耐心琢磨可能就停这一步了。

直接Github上下载“ollama-linux-amd64.tgz”、“ollama-linux-amd64-rocm.tgz”,但是下载会很慢,容易中断,这边是使用了魔法上网 + “Free Download Manager”才完成下载,过程中会反复中断拉起,而且可能下载链接会中途失效,这时需要重新从GitHub中获取新的下载链接地址来更新下载器中下载链接,实现接续下载。

建议使用v0.12.3,网上教程大多用更旧的版本。新的Ollamav0.12.4开始将不再支持MI50GPU了,后续新版本可能会通过Vulkan接口来支持。

ollama安装不水,教程比较多,这里说下ollama更新,主要是版本更新确实快,建议直接删掉\usr\lib\ollama,然后重新解压到这里。

sudo tar -C /usr -xzf ollama-linux-amd64.tgz

sudo tar -C /usr -xzf ollama-linux-amd64-rocm.tgz

4.对外访问人机交互:Open WebUI

找教程需要注意,有些文章提供的docker很难访问到,提供一个我用到的,供参考。

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.nju.edu.cn/open-webui/open-webui:main

5.模型使用

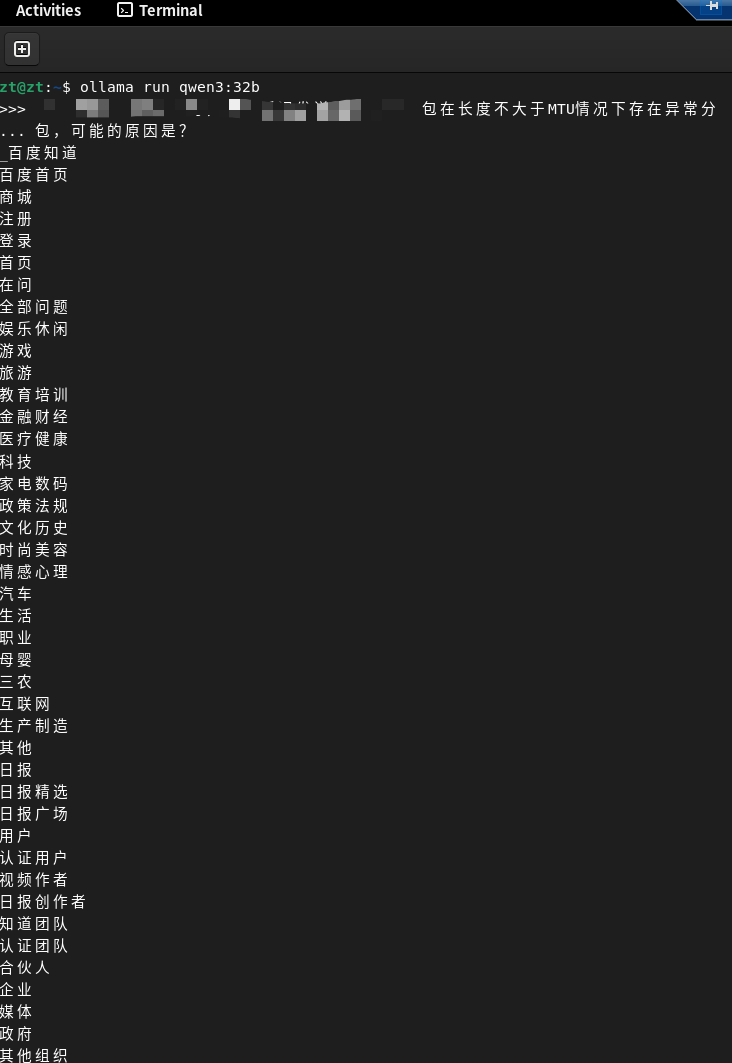

qwen3:32b

qwen3:30b 8bit量化

gpt-oss:20b

deepseek-r1:32b

比较推荐qwen3:30b 8bit量化,刚好利用上了32G显存,且输出速度也足够快。

尽量直接命令拉取,用guff格式导入时部分模型会出现胡乱输出的情况, 这边就遇到回答直接吐出训练资料的情况,很奇葩。

MI50的一些问题:

另外LM Studio在ubuntu下也可以使用,也做了尝试,但是好像32G显存只能用到一半,32B模型没法把模型都加载到显存,输出会很慢,不知道其他人有没有遇到过,或有解决方法。

-----------------------------------------

更新20251029:

驱动升级到了6.4.60404,可以正常工作,去AMD官网下载即可。

网上有人升级到Rocm7.0.2,号称输出有较大提升,有空试试。

------------------------------------------

更新20251103:

“外LM Studio在ubuntu下也可以使用,也做了尝试,但是好像32G显存只能用到一半”

关于该问题根据在Redidt上一个文章内容解决,主要通过更新显卡bios可以解决。

linux下使用amdvbflash对MI50刷入“274474.rom”,重启后显存使用就正常了,rom可以在github上找,有人上传了。

---------------------------------------------

更新20251114:

关于驱动升级到6.4.6,Rocm会升级到6.4.4版,网上传这个驱动性能提升比较大,但是实际直接使用官方Ollama包没有影响,因为它是将驱动做了包含,还是默认用的6.3.3,不会使用外部的rocm。

要支持qwen3 Vl 32B大模型,需要升级Ollama版本到0.12.7及以上,但是MI50已经被官方放弃了,今天看了下最新的0.12.11有了Vulkan支持,也就是ollama之前生成通过这个支持MI50,但是试了之后还是没法调用MI50显卡,会默认cpu执行。

这边研究了下目录结构和文件,好像ollama新版中amd的驱动接口库和0.12.4区别不大,所以想是不是可以把MI50相关的gfx906驱动补全到最新版本就能调用,实际测试这个方案行不通,补全后启动ollama能找到显卡,但是不能启动模型(有报错)。

如果用新的rocm就需要自行去用源码做配置修改,以及自行实现编译,外网找了好久没有找到教程,但论坛传有人做了新版Ollama的docker方案,有时间了自己研究的试试,看能不能自己编译一个支持的版本。

浙公网安备 33010602011771号

浙公网安备 33010602011771号