Raid与LVM应用

项目要求

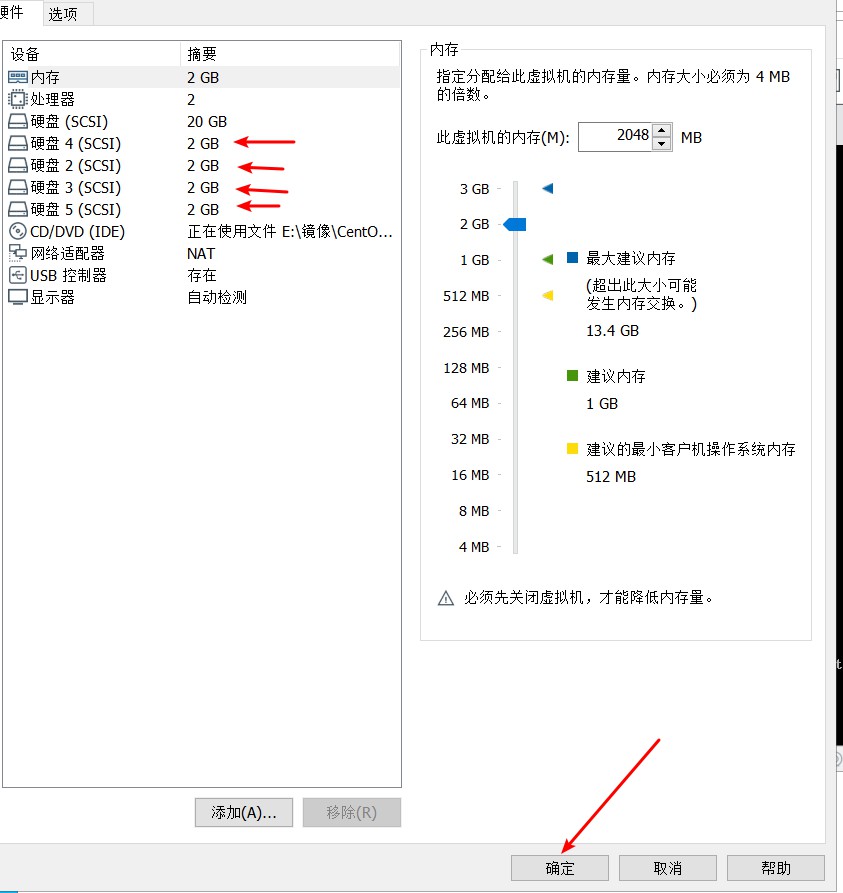

给服务添加4块2G硬盘,使用2块硬盘生成raid0的磁盘md0,使用2块硬盘生成raid1的磁盘md1,使用md0和md1生成vg1,包含pe100M使用vg1生成lv1,包含25个pe,以xfs格式挂载到/RaidLVM1使用vg1生成lv2,包含2.5GB,以xfs格式挂载到/RaidLVM2,永久生效.

项目分析

检查环境

配置yum源

格式化硬盘

生成md0和md1

生成pv

生成vg

生成lv

格式化并挂载

项目步骤

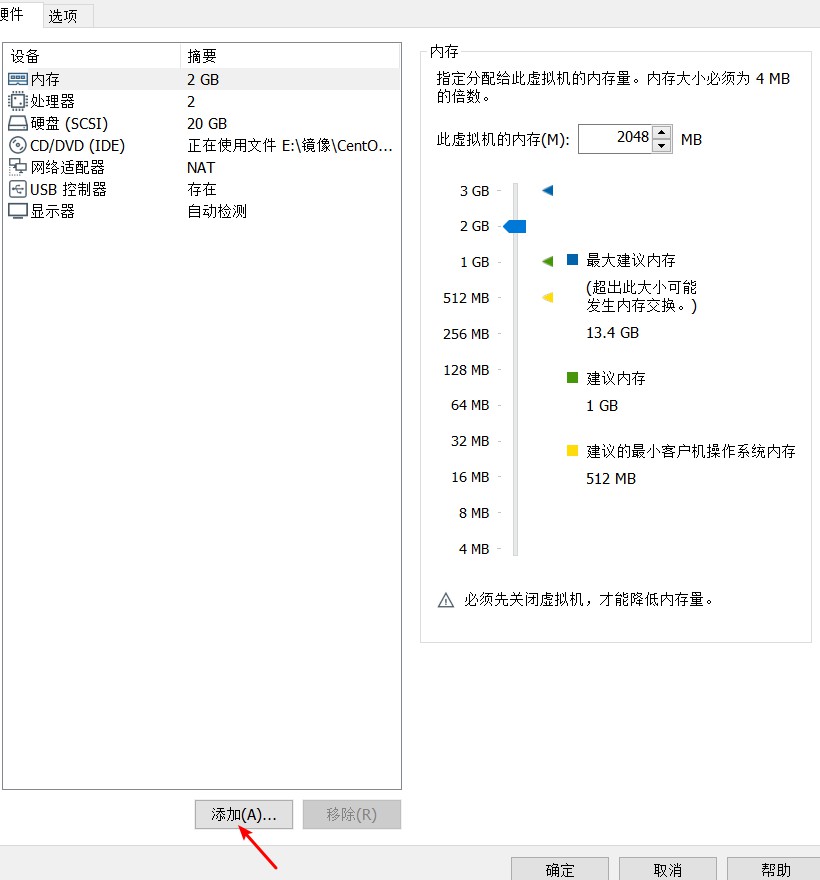

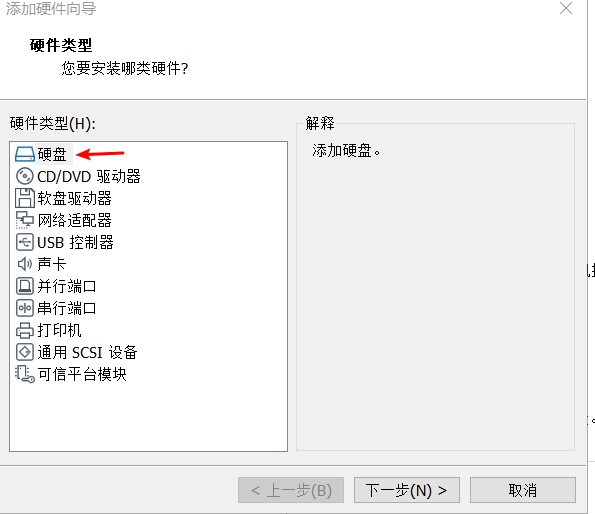

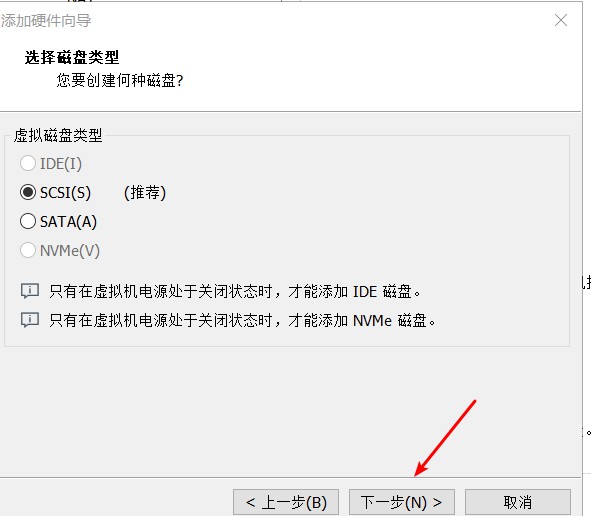

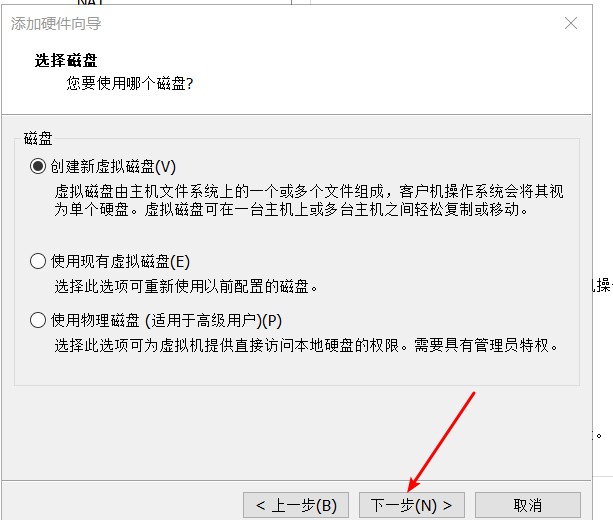

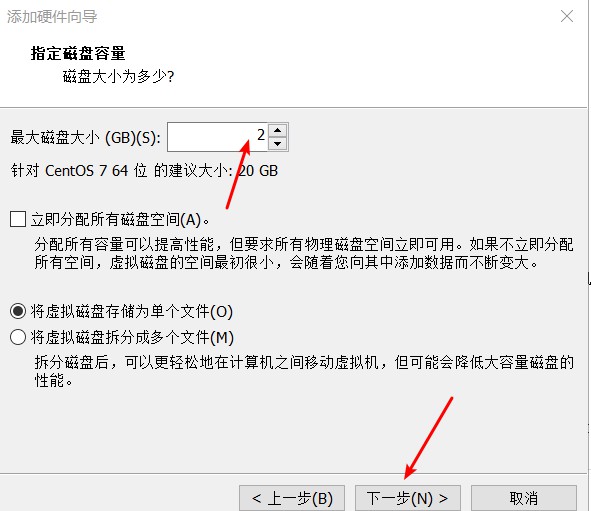

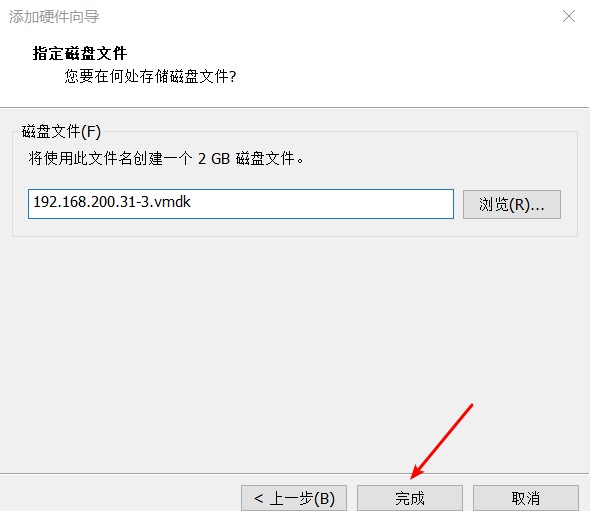

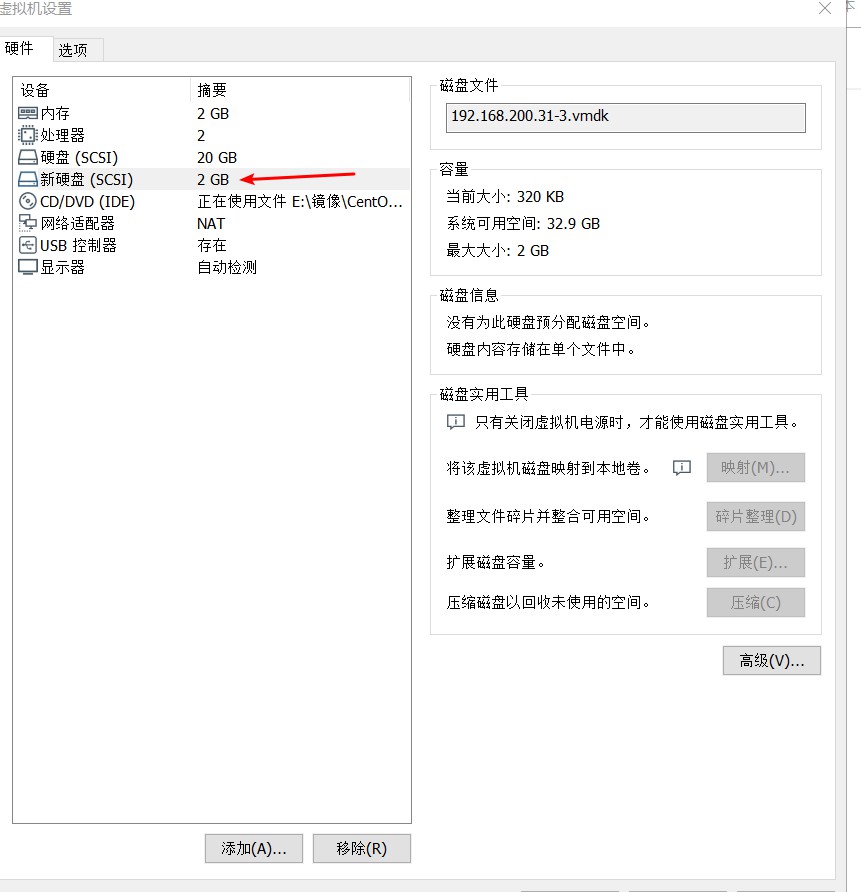

(1)环境搭建

(2)项目操作

- 环境检查

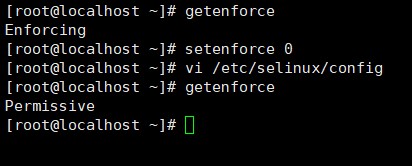

getenforce #检查selinux状态

setenforce 0 #临时关闭selinux

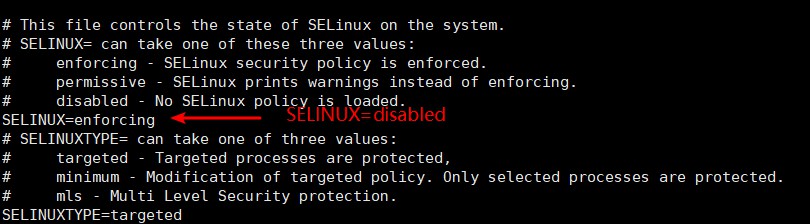

vim /etc/selinux/config

SELINUX=enforcing 改为: SELINUX=disabled #永久关闭

- 配置yum源

mkdir /dvd

mount /dev/cdrom /dvd

cd /etc/yum.repos.d

rm -fr *.repo

vi dvd.repo

[dvd]

name=dvd

baseurl=file:///dvd

enabled=1

gpgcheck=0

yum clean all

yum makecache

- 添加硬盘

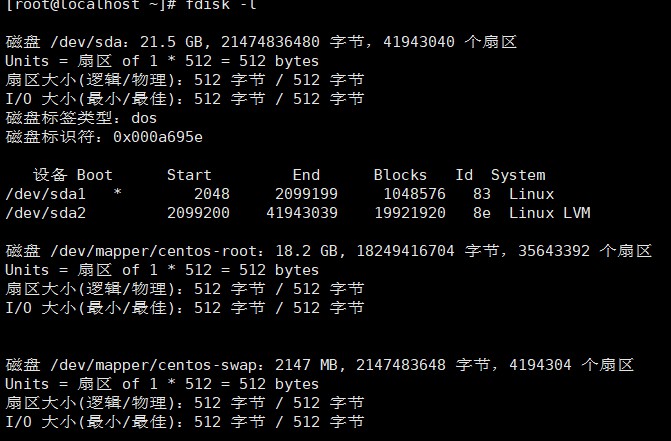

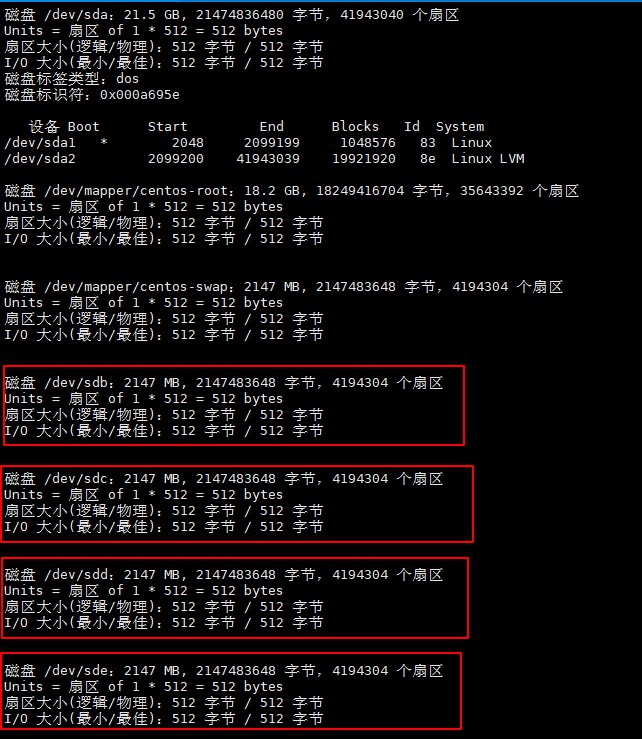

fdisk -l #查看磁盘状态

注意:添加硬盘是在服务器运行状态添加的,未显示出来,需要使用动态添加硬盘方法来实现

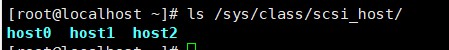

ls /sys/class/scsi_host/ #查看硬盘数

添加硬盘命令

echo "- - -" > /sys/class/scsi_host/host0/scan

echo "- - -" > /sys/class/scsi_host/host0/scan

echo "- - -" > /sys/class/scsi_host/host0/scan

fdisk -l #查看添加状态

- 分区

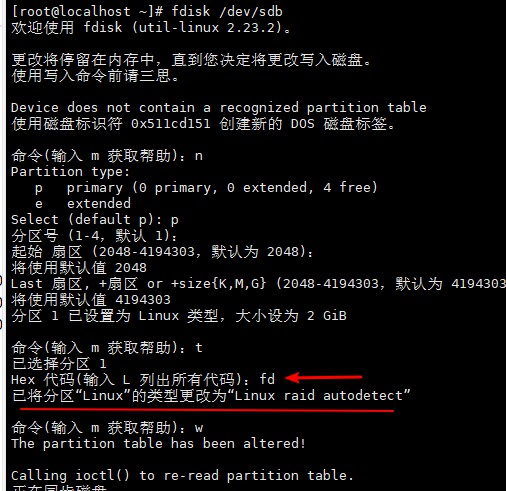

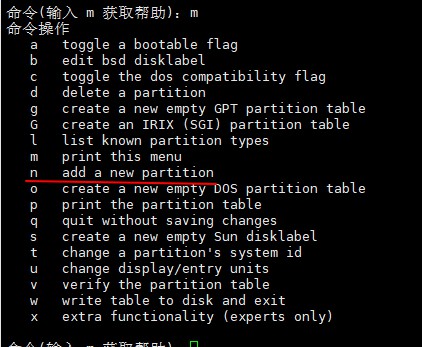

fdisk /dev/sdb

同操作:

fdisk /dev/sdc

fdisk /dev/sdd

fdisk /dev/sde

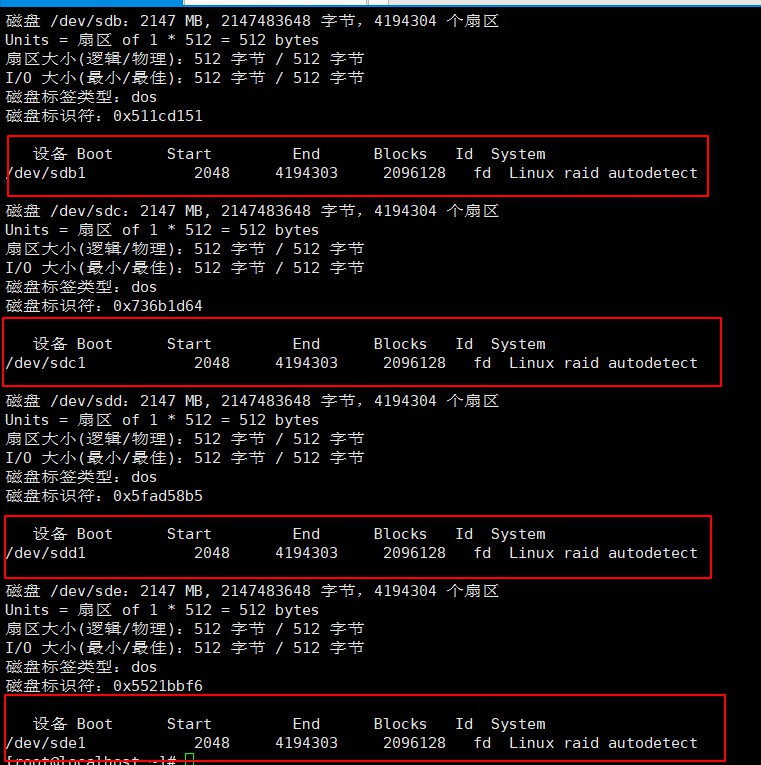

fdisk -l

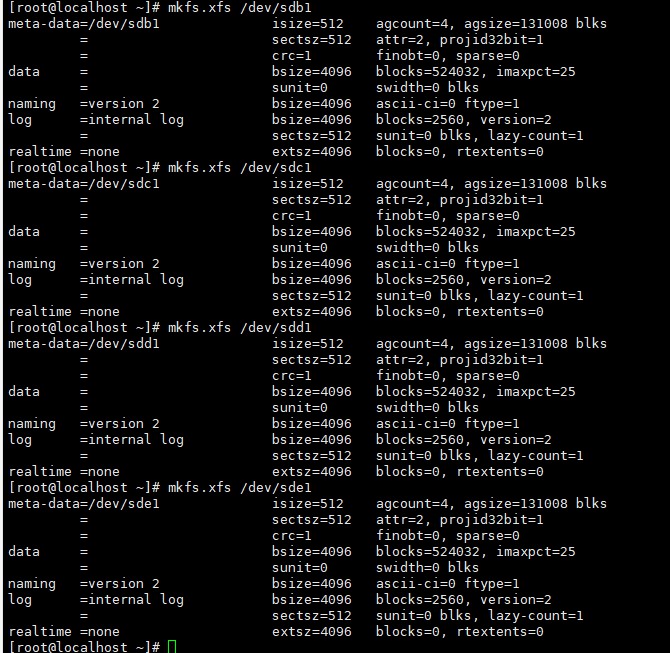

- 格式化分区

mkfs.xfs /dev/sdb1

mkfs.xfs /dev/sdc1

mkfs.xfs /dev/sdd1

mkfs.xfs /dev/sde1

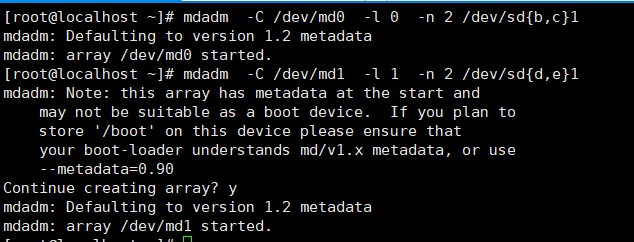

- 生成md0和md1

yum -y install mdadm #下载mdadm

mdadm -C /dev/md0 -l 0 -n 2 /dev/sd{b,c}1 #-C 创建一个阵列 -l 设定raid模式(0) -n 指定阵列的设备数目(2)

mdadm -C /dev/md1 -l 1 -n 2 /dev/sd{d,e}1 #-C 创建一个阵列 -l 设定raid模式(1) -n 指定阵列的设备数目(2)

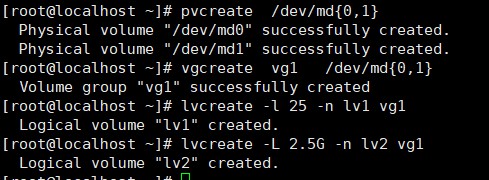

- 生成PV,VG,LV

pvcrewate /dev/md{0,1} #生成PV

vgcreate vg1 -s 100 /dev/md{0,1} #生成PE块大小为100的vg1

lvcreate -l 25 -n lv1 vg1 #生成有25块pe的lv1

lvcreate -L 2.5G -n lv2 vg1 #生成2.5G的lv2

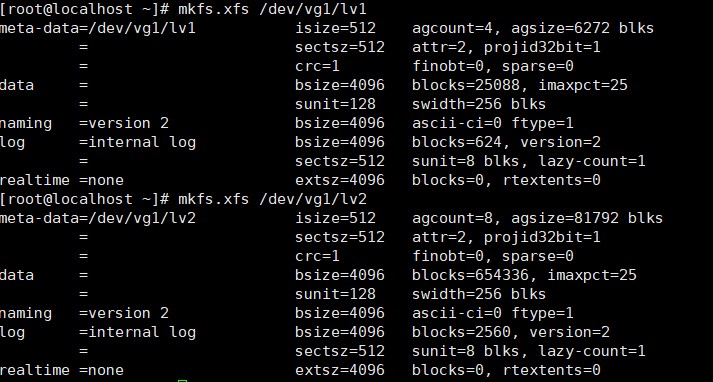

- 格式化lv1和lv2

mkfs.xfs /dev/vg1/lv1

mkfs.xfs /dev/vg1/lv2

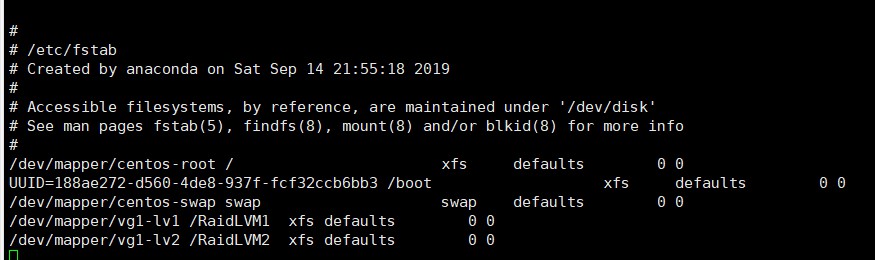

- 永久挂载

mkdir /RaidLVM1 #创建挂载点

mkdir /RaidLVM2

mount /dev/vg1/lv1 /RaidLVM1 #挂载

mount /dev/vg1/lv2 /RaidLVM2

vi /etc/fstab

/dev/mapper/vg1-lv1 /RaidLVM1 xfs defaults 0 0

/dev/mapper/vg1-lv1 /RaidLVM1 xfs defaults 0 0

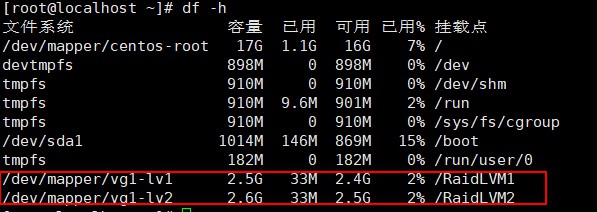

- 验证

df -h #查看硬盘大小

浙公网安备 33010602011771号

浙公网安备 33010602011771号