Deepseek R1 论文解析

Deepseek v3和Deepseek R1的推出引爆了国内AI圈子,我也来分享一下对Deepseek R1论文的解析,不过因为我本身没看过很多inference scaling的文章,因此如果有错误请大家指正。

摘要:

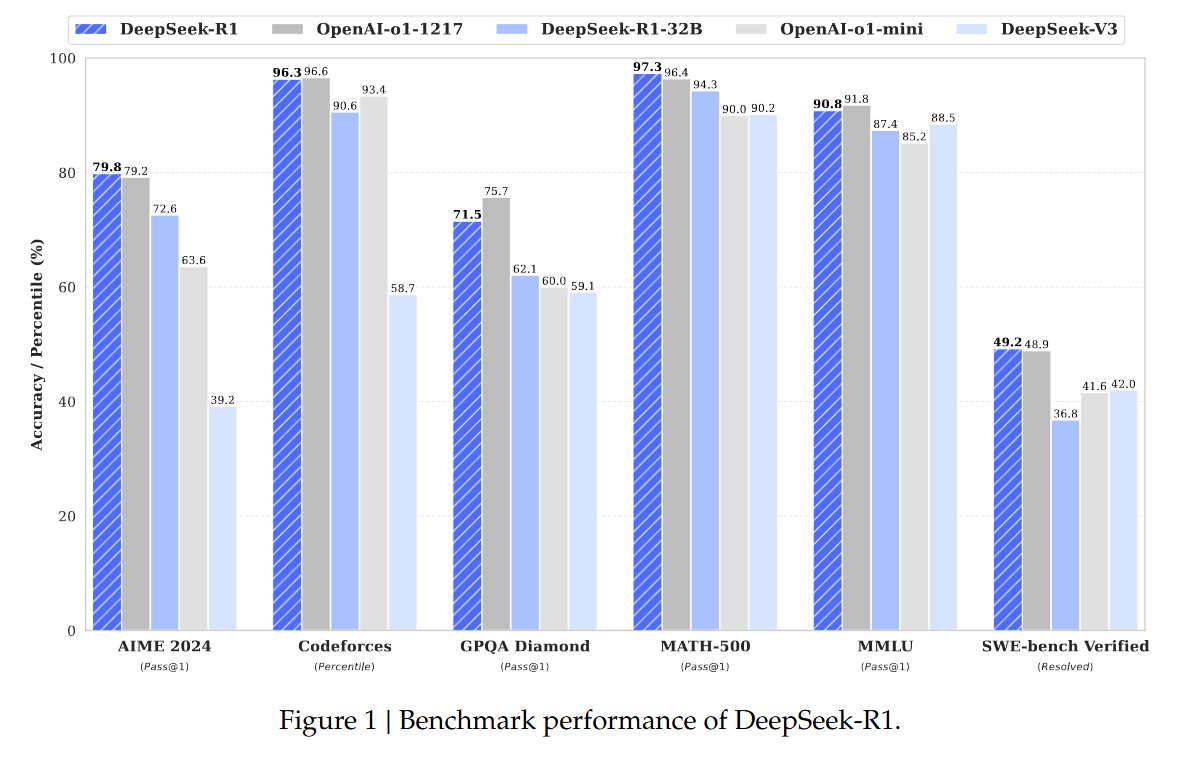

DeepSeek-R1-Zero在进行强化学习前没有经历SFT,同时表现出了强大的推理能力以及一些缺陷。为了解决这些缺陷deepseek R1在RL前引入了多阶段的训练以及冷启动数据。在性能上deepseek R1达到了接近于O1的性能。

introduction:

post training对提升推理性能、提升模型符合人类偏好的能力以及符合社会价值观等有非常大的帮助。OpenAi是第一个使用inference scaling来增强模型推理性能的,取得了非常好的效果,但是之前的开源的探索工作,如过程奖励模型、强化学习、搜索方法如蒙特卡洛树搜索等都远达不到O1的效果。

Deepseek团队探索了仅使用强化学习来增强模型推理性能的方法,使用deepseek-v3-base作为基座模型,使用GRPO作为强化学习方法来微调模型,最终得到了DeepSeek-R1-Zero,其可以达到一个非常接近于O1的水平,但也遇到了语言混乱,可读性差等等问题。

为改进这些问题并进一步提升推理性能,Deepseek团队提出了 DeepSeek-R1,主要通过少量的冷启动数据与多阶段训练流程来实现。具体包括:1)收集数千条冷启动数据来微调 DeepSeek-V3-Base;2)执行与 DeepSeek-R1-Zero 类似的强化学习过程;3)在 RL 收敛后,结合通过拒绝采样(reward model分数高的)获取的 SFT 数据和来自 DeepSeek-V3 的有监督数据(涵盖写作、事实问答、自我认知等领域)继续训练模型;4)最后进行额外的 RL 步骤,整合各种场景的提示数据,得到 DeepSeek-R1,其性能可与 OpenAI-o1-1217 相当。

同时在模型蒸馏方面,研究团队将 DeepSeek-R1 的能力迁移到更小的密集模型上。在 Qwen2.5-32B 模型上直接蒸馏可胜过在此模型上执行 RL,说明大型模型中学习到的推理模式对于提升小模型的推理能力至关重要。Deepseek团队开源了蒸馏后的 Qwen 和 Llama 系列模型,其中 14B 模型在实际测试中大幅超越了同类的开源 QwQ。

Approach:

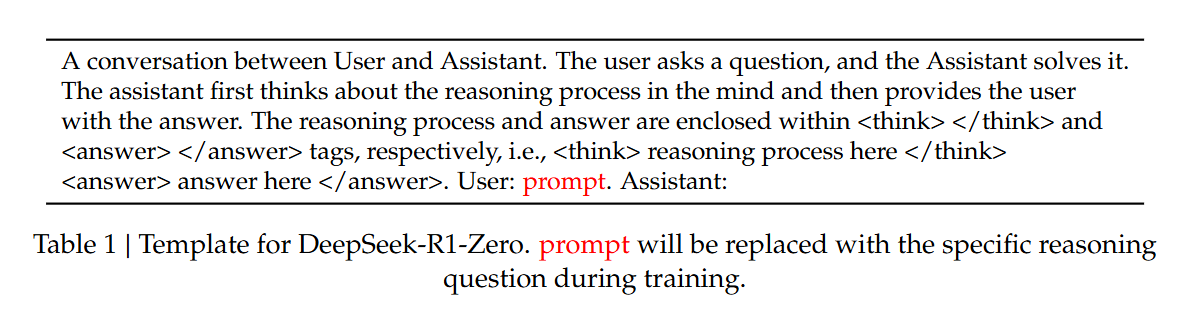

DeepSeek-R1-Zero:在base模型上直接进行RL,没有经过任何SFT,RL方法使用同样是deepseek出品的GRPO。

RL的奖励模型很简单,由两部分组成:1)正确性奖励:即模型的输出是否正确;2)格式奖励:输出需要符合模板格式,think和answer都要符合格式。

DeepSeek-R1-Zero仅通过RL就实现了非常大的推理性能的提升,再加上多数投票后,DeepSeek-R1-Zero可以实现类似于O1的性能,更为可贵的是,DeepSeek-R1-Zero的训练过程不需要监督,奖励也并非来自一个神经网络模型,而是基于规则的奖励,这极大简化了训练的难度和成本。

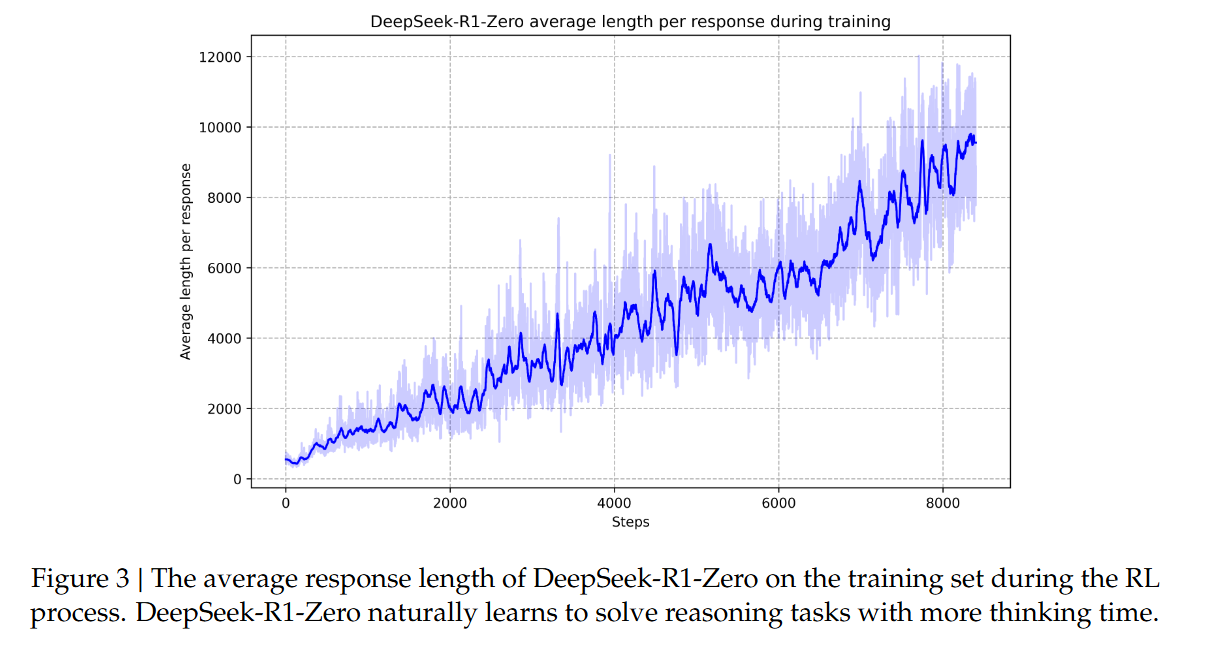

在这一训练过程中,随着模型训练步数的增加,推理长度呈现明显的上升趋势,这一现象清晰地展示了模型在强化学习过程中推理能力的渐进提升。此外,在DeepSeek-R1-Zero的训练过程中,作者团队观察到了一个特别引人深思的现象——模型的"顿悟时刻"。这一现象出现在模型的中间版本。在这个阶段,DeepSeek-R1-Zero学会了通过重新评估初始方案来为问题分配更多的思考时间。这种行为不仅证明了模型推理能力的成长,也生动展示了强化学习如何带来意想不到且富有深度的结果。这个顿悟时刻不仅对模型本身具有重要意义,也让研究人员备受启发。它凸显了强化学习的力量和优雅之处:我们无需明确教导模型如何解决问题,只需提供恰当的激励机制,模型就能自主发展出高级的问题解决策略。这一顿悟时刻有力地提醒我们,强化学习有潜力激发人工系统新层次的智能,为未来更自主、更具适应性的模型开辟道路。但是DeepSeek-R1-Zero也面临一些可读性以及混合语言等问题,这严重影响了模型的可用性和用户体验。

DeepSeek-R1:

DeepSeek-R1在DeepSeek-R1-Zero的基础上设计了一个四阶段训练方法以进一步提升模型的推理能力以及可用性。

Cold Start:

作者团队为DeepSeek-R1收集和构建了少量长思维链数据,用于微调模型作为RL的base模型。为收集这些数据,探索了多种方法:1)使用长思维链数据进行fewshot,2)直接提示模型生成包含反思和验证的详细答案,3)收集可读的DeepSeek-R1-Zero的输出,4)通过人工标注者后处理过的输出。

Reasoning-oriented Reinforcement Learning:

这一阶段的重点是通过RL增强模型的推理能力,特别是在编码、数学、科学和逻辑推理等推理密集型任务中。同时为了缓解模型输出多语言的问题,训练的过程中增加了语言一致性loss,尽管略微损失性能,但增强了可读性。

Rejection Sampling and Supervised Fine-Tuning:

不同于前一阶段主要侧重于推理任务,这个阶段引入了其他领域的数据,以增强模型在写作、角色扮演和其他通用任务上的能力。

推理数据:

作者团队精心设计推理提示,通过对上述RL训练得到的checkpoint进行拒绝采样来生成推理路径,前一阶段仅包含可通过规则型奖励评估的数据;本阶段扩展了数据集,引入额外数据,部分使用生成式奖励模型(将标准答案和模型预测输入DeepSeek-V3进行判断),为提高可读性,作者团队过滤掉了混合语言、冗长段落和代码块的思维链。对每个提示采样多个回答,仅保留正确答案,总计收集约60万条推理相关训练样本。

非推理数据:

对于写作、事实问答、自我认知和翻译等非推理数据,作者团队采用DeepSeek-V3生成一部分数据,并复用部分DeepSeek-V3的部分SFT数据集,某些非推理任务中,作者团队通过提示让DeepSeek-V3在回答问题前生成潜在的思维链,对简单查询(如"hello"),回复中不提供思维链。总计收集约20万条非推理训练样本

Reinforcement Learning for all Scenarios:

为了增强模型与人类偏好的一致性,作者团队开展了第二阶段的强化学习训练,同时兼顾提升模型的helpful、无害性和推理能力。在这一阶段,他们采用了多元化的训练策略:对推理数据沿用DeepSeek-R1-Zero的规则型奖励机制,对通用数据则运用奖励模型来把握复杂场景中的人类偏好。在优化过程中,作者团队将helpful评估聚焦于最终总结的实用价值,同时通过对完整响应的审查来确保无害性。这种多维度的训练方法最终帮助他们打造出一个在保持卓越推理能力的同时,更注重实用性和安全性的模型。

实验:

实验不必多说,主要就是效果很好。

讨论:

蒸馏vsRL

在qwen2-32b-base上的实验证明,从大模型蒸馏需要更少的计算资源并达到更好的性能。

失败的方法:

过程奖励模型:判断过程的好坏困难,导致模型训练非常复杂。

蒙塔卡罗搜索:搜索空间过大。

浙公网安备 33010602011771号

浙公网安备 33010602011771号