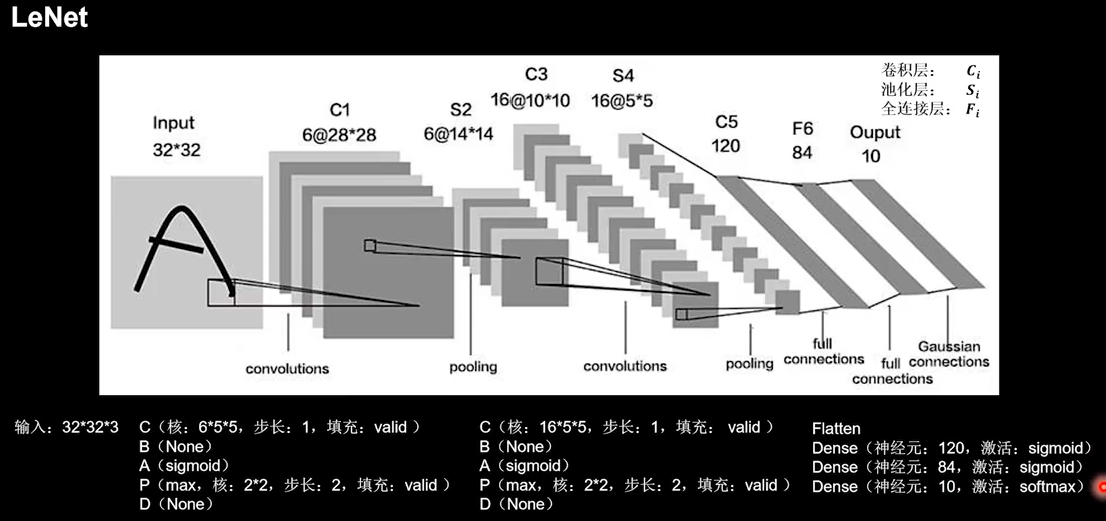

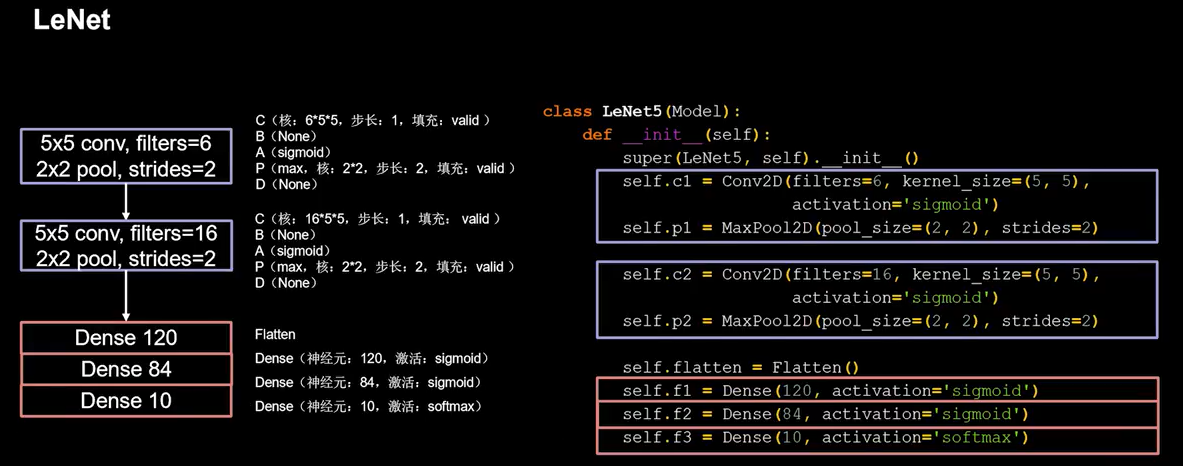

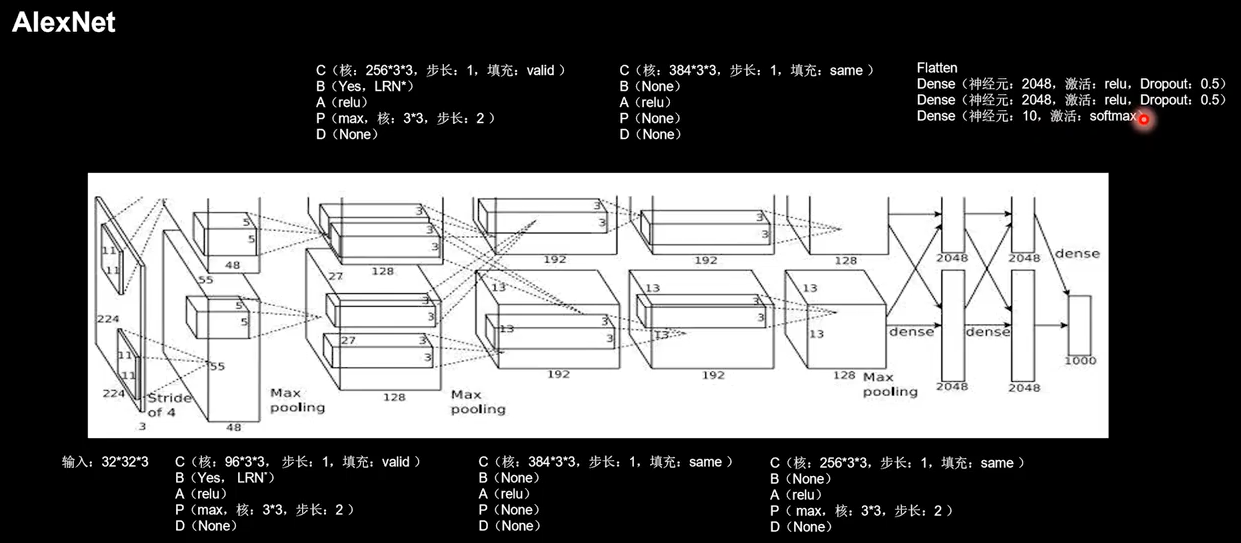

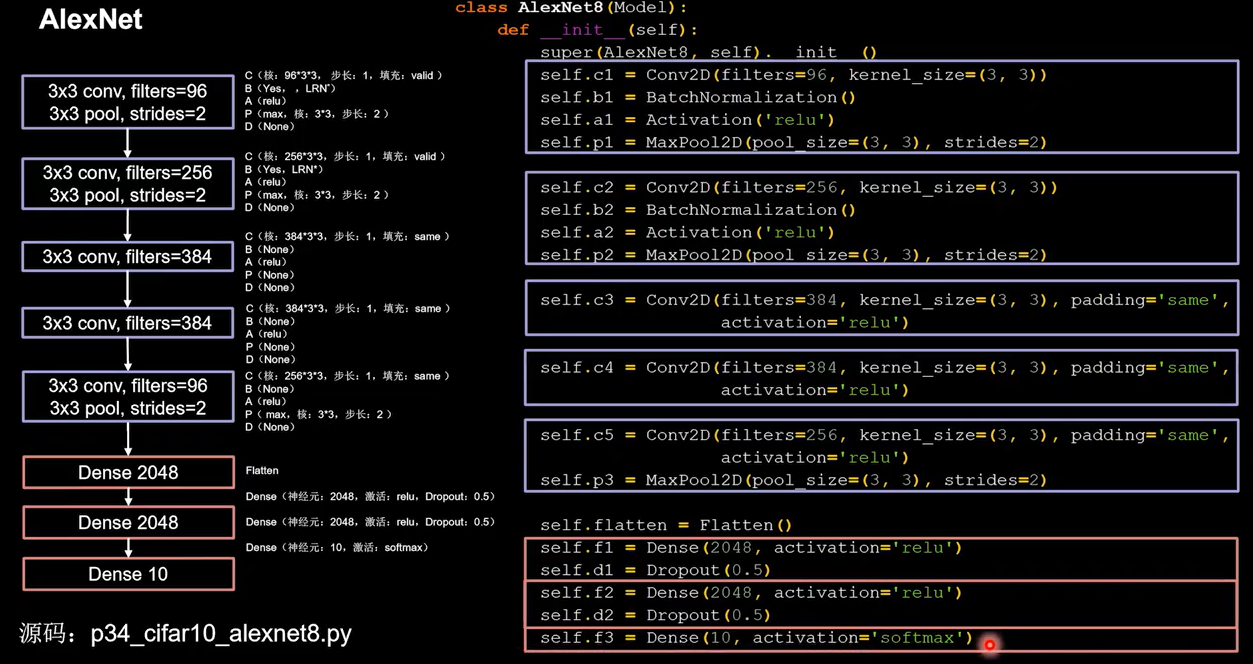

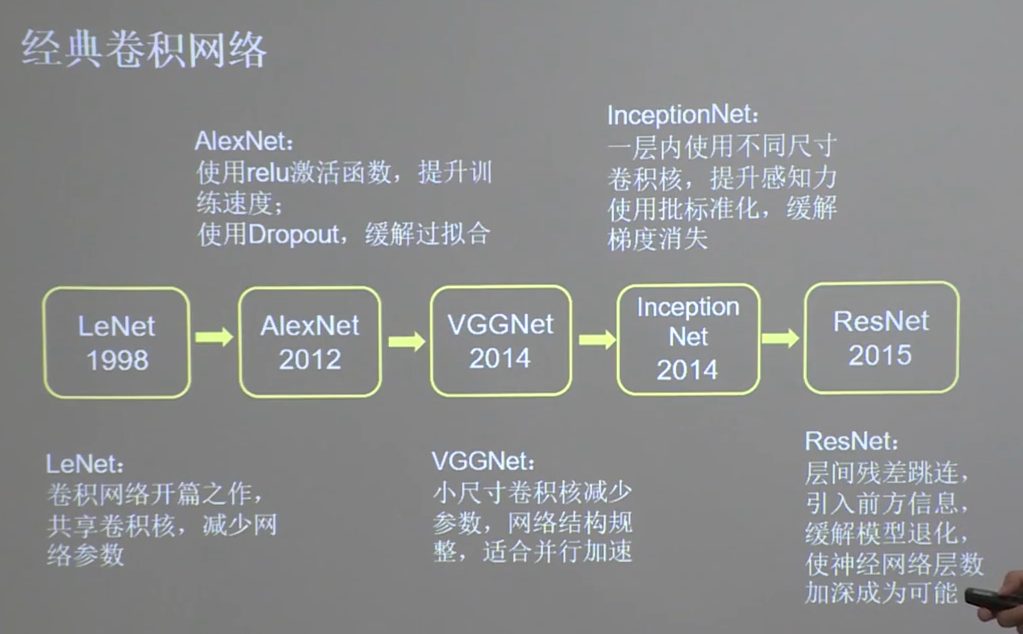

LeNet神经网络1998-AlexNet神经网络2012-VGGNet2014-InceptionNet2014

两层卷积,三层全链接,最后一层使用softmax激活函数使输出符合概率分布

AlexNet使用relu激活函数提升了训练速度,使用Dropout缓解了过拟合

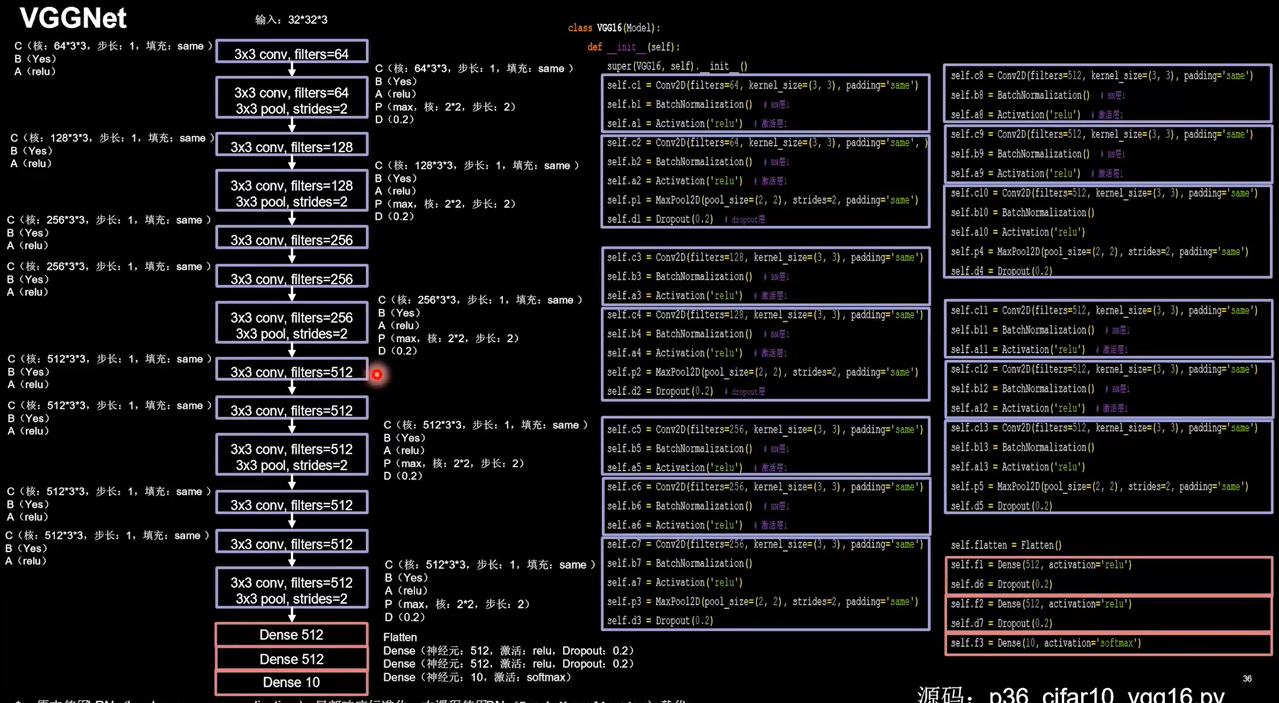

VGGNet诞生于2014年,使ImageNet竞赛的亚军,Top5错误率减小到7.3%。。使用小尺寸卷积核,在减小参数的同时,提高了识别准确率。VGGNet的网络结构规整,非常适合硬件加速,

以16层VGG网络为例。

卷积核的个数分别是64-64-128-128-256-256-256-512-512-512-512-512-512-512-512-10,卷积核越来越大,因为越靠后特征图尺寸越小,通过增加卷积核的个数,增加了特征图深度,保持了信息的承载能力

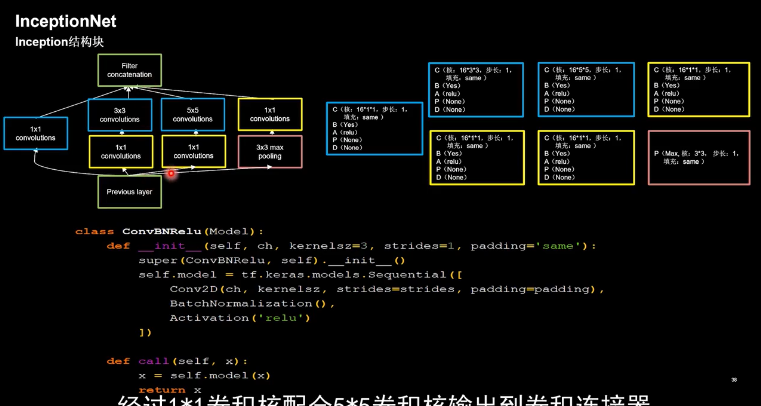

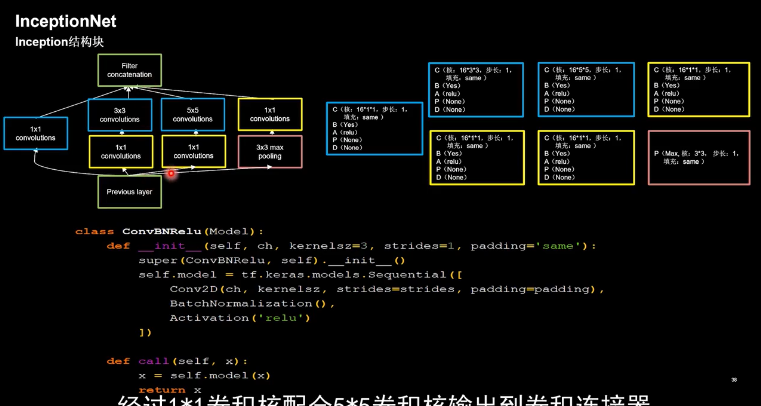

InceptionNet诞生于2014,当年ImageNet竞赛冠军,Top5错误率为6.67%,引入了Inception结构块,在同一层网络内使用不同尺寸的卷积核,提升了模型感知力,使用了批标准化,缓解了梯度消失。

InceptionNet的核心是他的基本单元Inception结构块,Inception结构块,在同一层网络内使用了多个尺寸的卷积核,可以提取不同尺寸的特征,通过11卷积核,作用到输入特征图的每个像素点,通过设定少于输入特征图深度的11卷积核个数,减少了输出特征图深度,起到了降维的作用,减少了参数量和计算量。

图中给出了Inception的结构块,Inception结构块包含四个分支,第一个分支是经过11卷积核输出到卷积连接器,第二个分支是经过11卷积核配合33卷积核输出到卷积连接器,第三个分支是经过11卷积核配合55卷积核输出到卷积连接器,第四个分支是经过33最大池化核配合1*1卷积核输出到卷积连接器,送到卷积连接器的特征数据尺寸相同。卷积连接器会把收到的这四路特征数据按深度方向拼接,形成Inception结构块的输出。

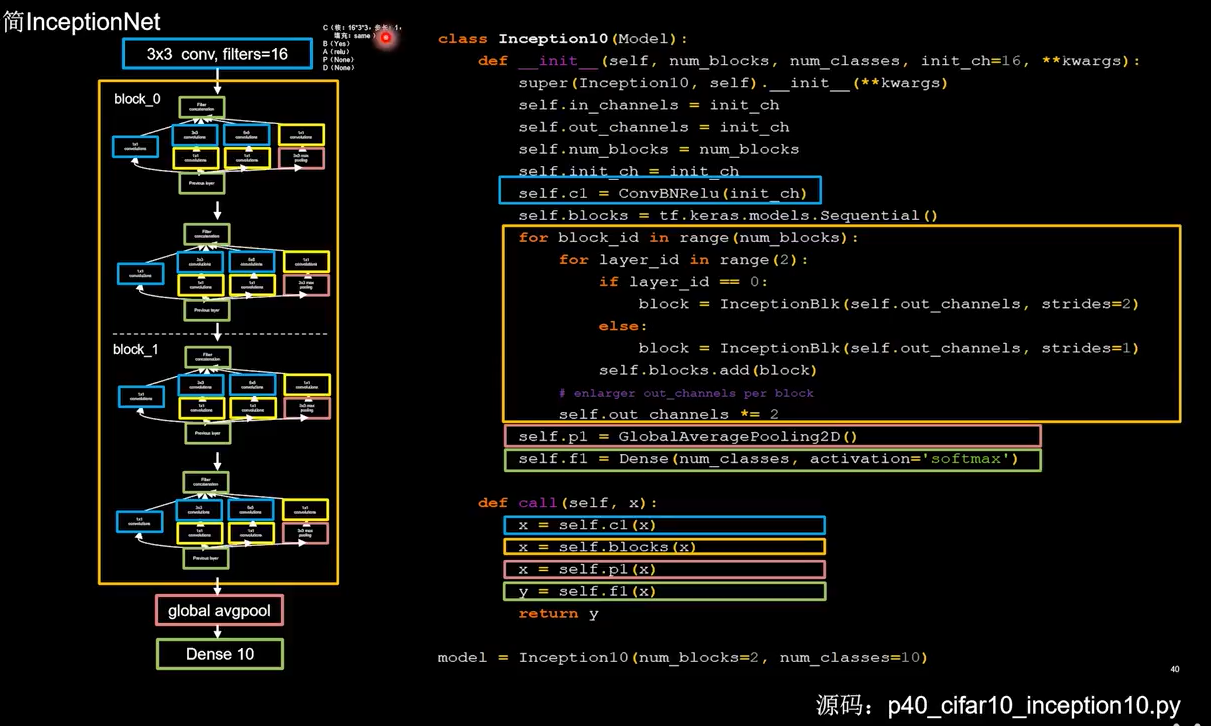

搭建精简版本的IncaptionNet,网络共有10层。

如图所示,共4个Inception结构块。

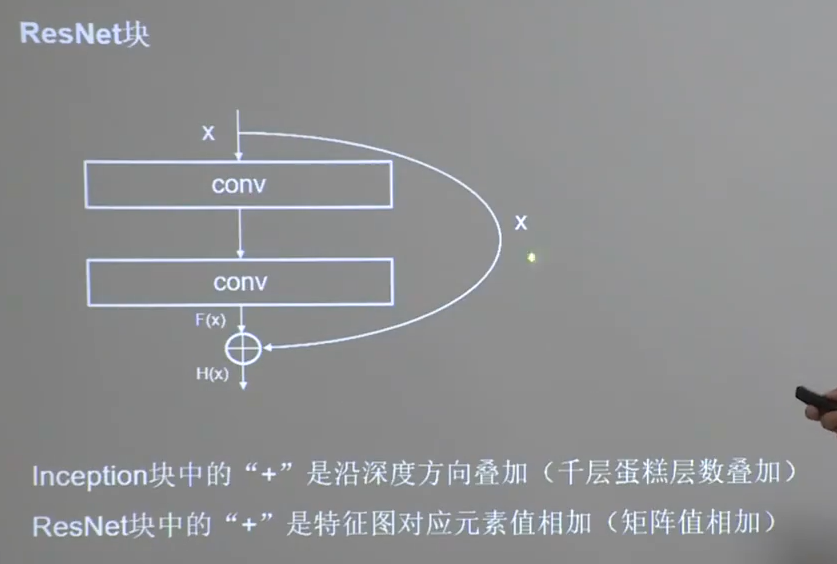

ResNet2015是当年ImageNet竞赛的冠军,ResNet提出了层间残差跳连,引入了前方信息,缓解梯度消失,使神经网络层数增加成为可能。通过实验证明单纯堆叠神经网络层数,会使神经网络模型退化,以至于后边的特征丢失了前边特征的原本模样,于是他应用了一根跳连线,将前边的特征直接接到了后边,使这里的输出结果H(x),包含了堆叠卷积的非线性输出F(x)和跳过这两层堆叠卷积,直接连接过来的恒等映射x,让他们对应元素相加,这一操作有效缓解了神经网络模型堆叠导致的退化,使得神经网络可以向着更深层级发展

浙公网安备 33010602011771号

浙公网安备 33010602011771号