Pychaim和Idea 集成远程服务器部署的ollama+qwen-coder32b

服务器配置为:2个11264MiB NvidiaGPU + 16核 3.8GHz CPU + 72G 内存;部署Ollama平台,使用Qwen-coder2.5:32B模型。

一、在linxu服务器上执行下面操作:

1. 下载、安装并运行ollama;

ollama的安装网上介绍的比较多,此处不再多讲,可以参考 Ollama全面指南:安装、使用与高级定制

若在服务器上部署ollama,确保ollama的对外接口在编辑器所在的主机上可以访问;

2. 下载并安装qwen-coder32b;

在ollama官网上查找模型qwen2.5-coder

在服务器上运行:

ollama run qwen2.5-coder

二、在Pychaim上执行下面操作:

1. 下载Pychaim插件Proxy-AI

在pychaim的plugin的MarketPlace中搜索Proxy-AI并安装。

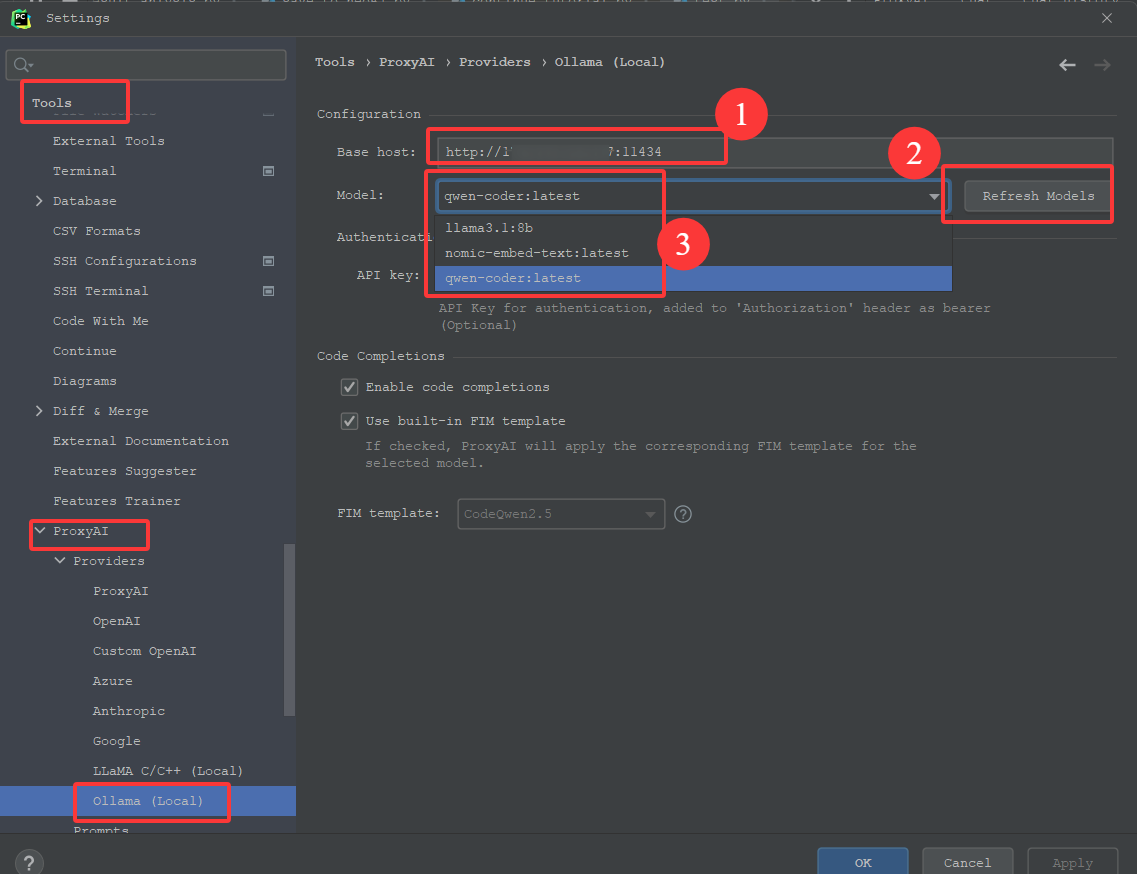

2. 配置Proxy-AI

配置好1 Base Host后,点击2 Refresh Model, 3处可以自动显示环境上部署的所有模型,选择自己需要的那个。

注意事项:

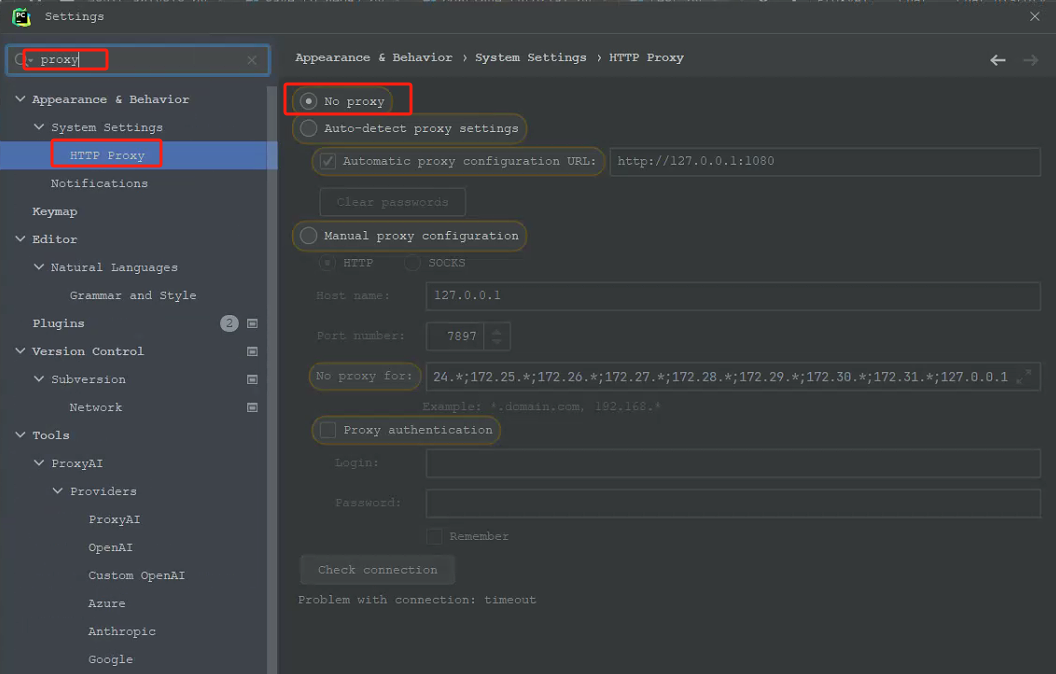

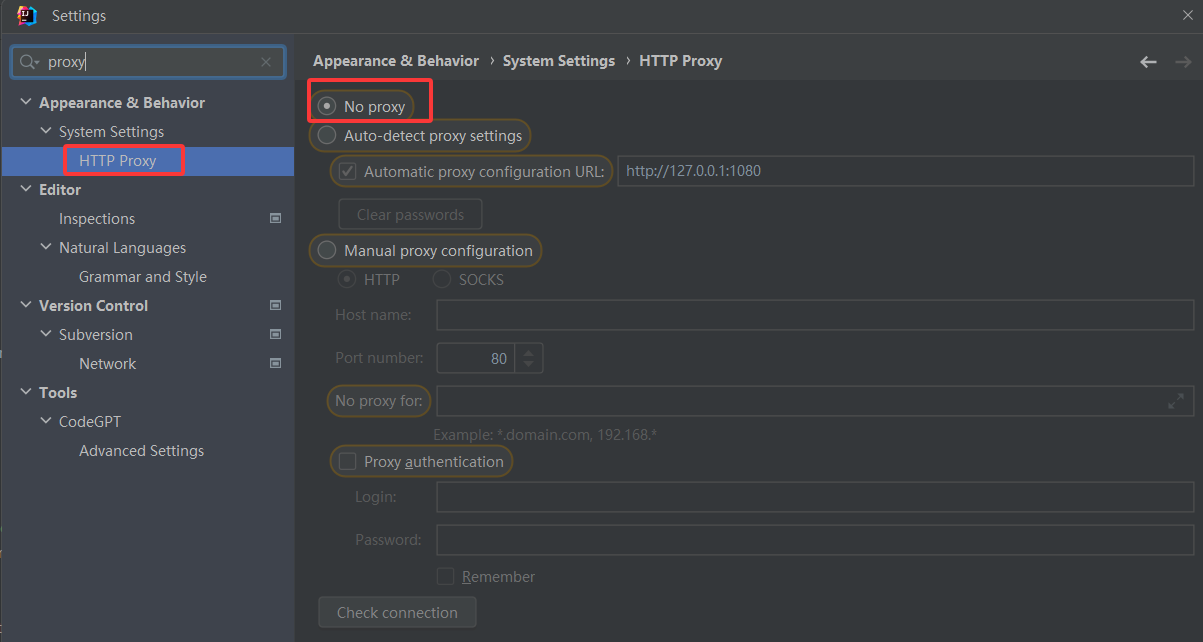

一定要注意Pychaim中的Proxy是否选中了代理,需要选择No Proxy;之前我为了下载插件选择了代理,导致配置好ollama的url中,刷新model一直显示不粗来,为止浪费了2天的时间。

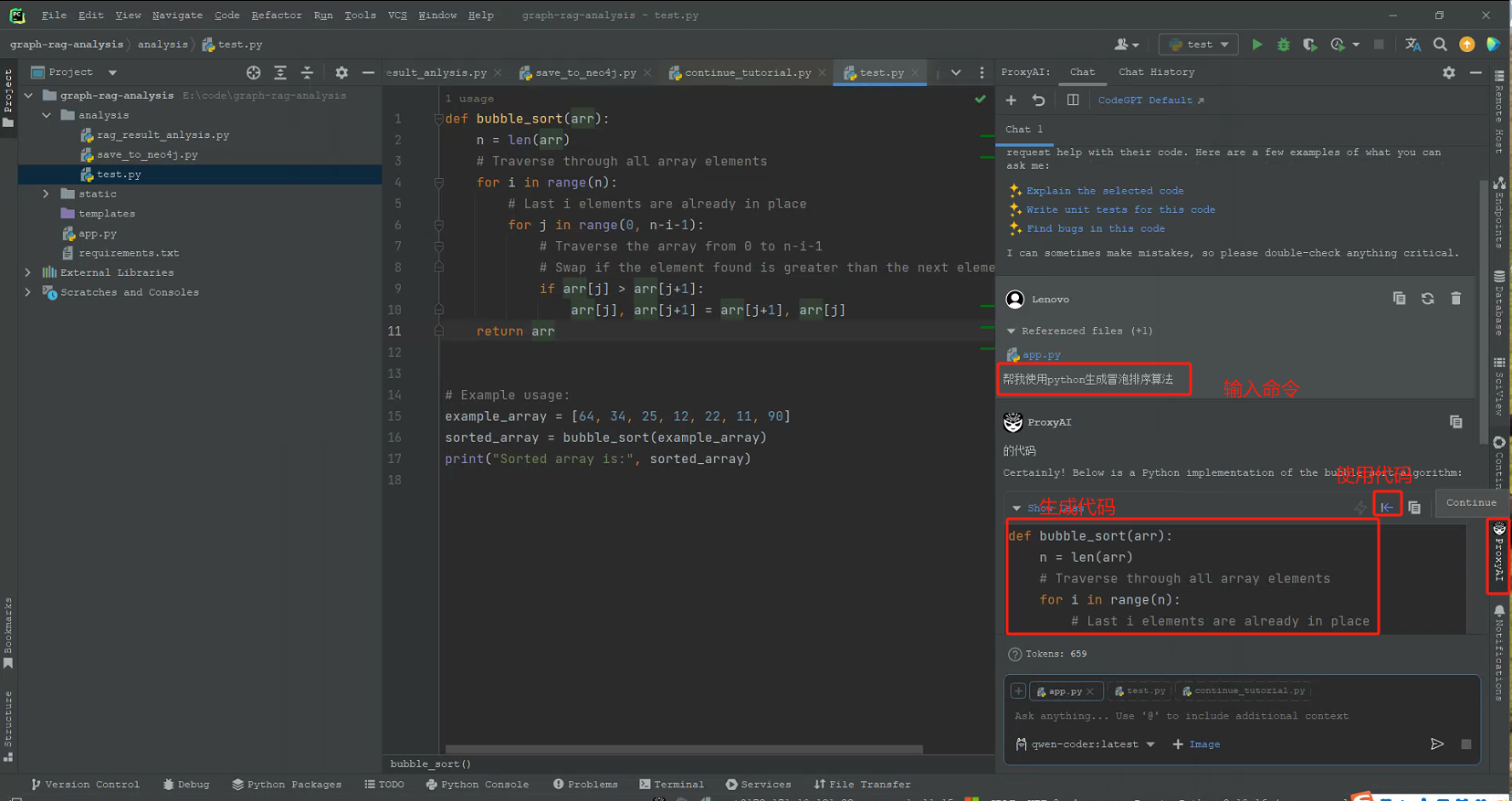

3. 使用Proxy-AI

三、在Idea上执行下面操作:

1. 下载Pychaim插件Proxy-AI

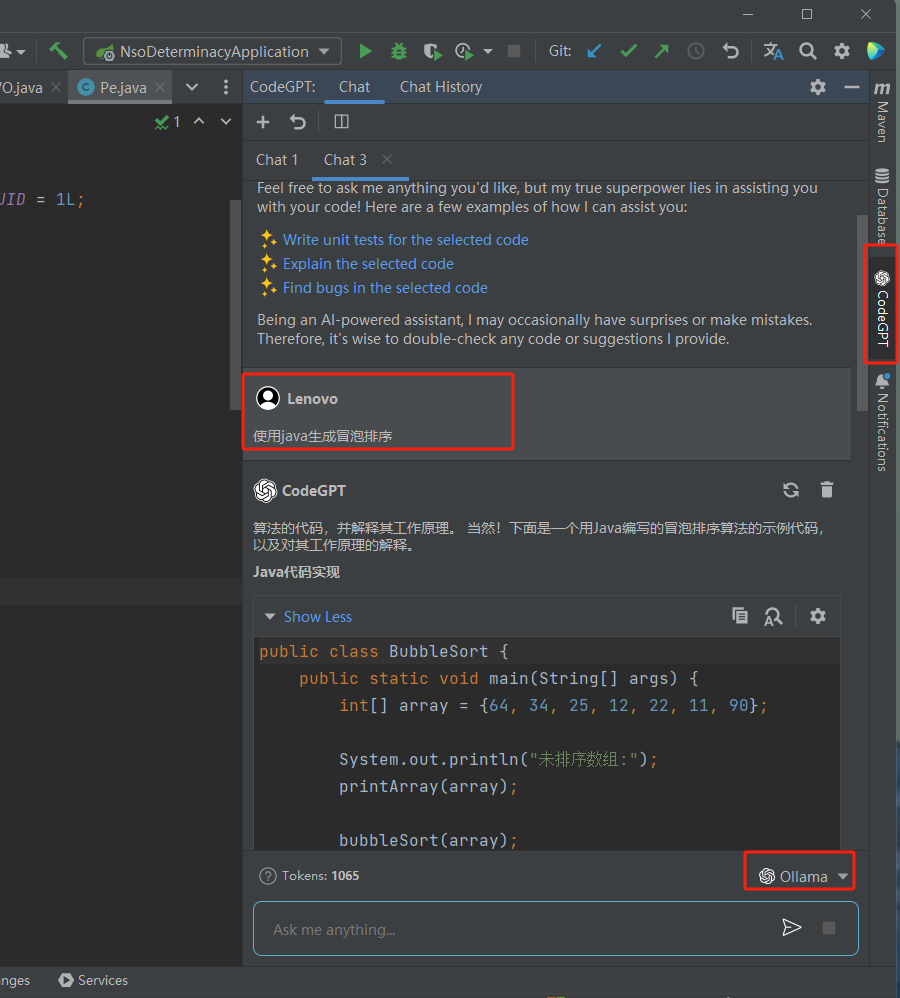

在idea的plugin的MarketPlace中搜索Proxy-AI并安装,可能由于我的idea比较老旧,版本是2022.2.3的,安装完成后显示CodeGpt

2. 配置Proxy-AI

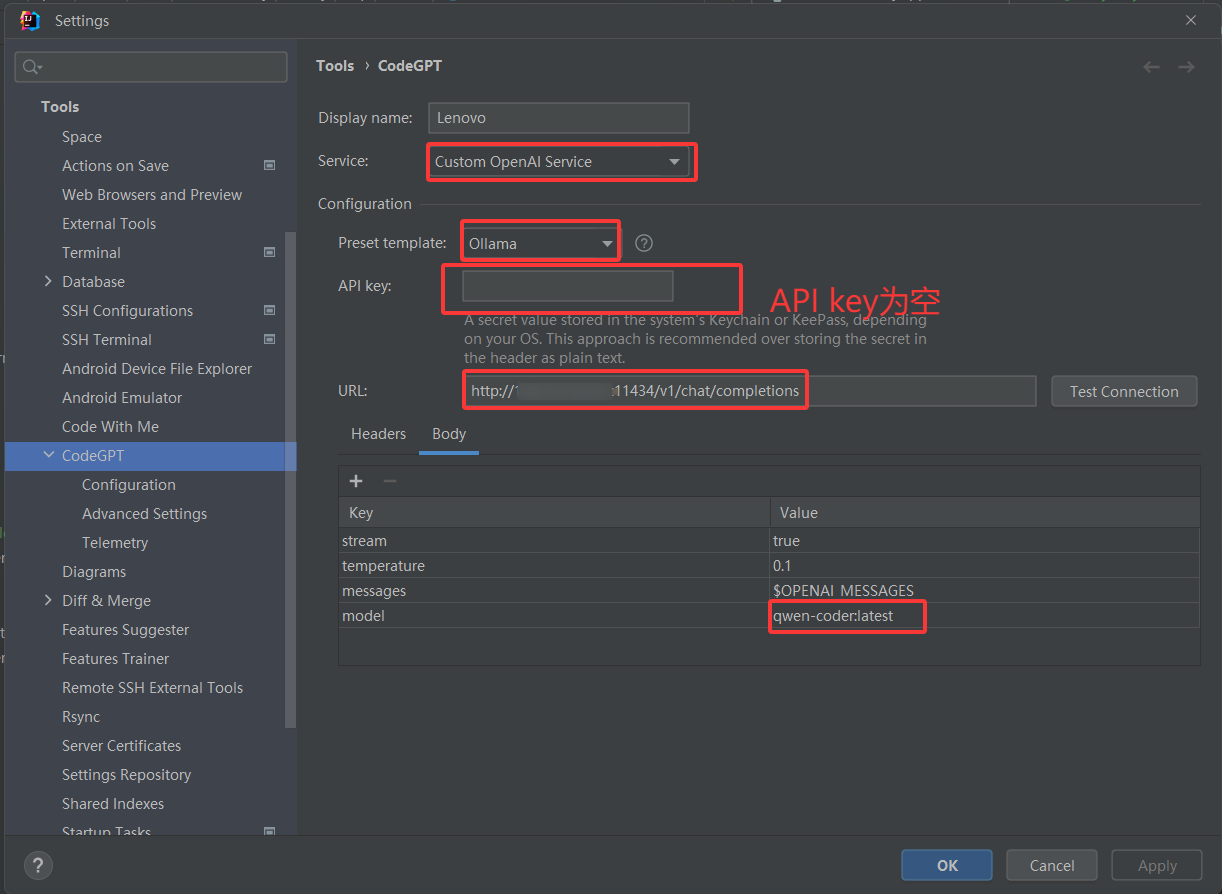

需要注意两点:

注意事项:

- URL与Pychaim中填写的并不相同,Pychaim中只需要填写 http://[ip]:11434,而idea中URL需要填写http://[ip]:11434/v1/chat/completions;

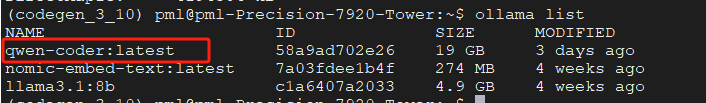

- body中的model名称,需要跟环境上部署的一致,可能是因为版本的问题,此处不能够直接刷新出来,需要在linux服务器上执行 ollama list,找到需要的model名称

![]()

- 一定要注意Idea中的Proxy是否选中了代理,需要选择No Proxy;

![]()

3. 使用Proxy-AI

浙公网安备 33010602011771号

浙公网安备 33010602011771号