ubuntu部署ollama+llama+graphrag

一、部署ollama

1. 找到ollama安装的文档,使用手动安装方式;

2. 根据系统的cpu和gpu选择对应的般本下载:

x86_64 CPU选择下载ollama-linux-amd64

x86_64 GPU选择下载ollama-linux-amd64-rocm

aarch64|arm64 CPU选择下载ollama-linux-arm64

我们的系统为带x86_64 GPU

curl -L https://ollama.com/download/ollama-linux-amd64-rocm.tgz -o ollama-linux-amd64-rocm.tgz

解压缩:

sudo tar -C /usr -xzf ollama-linux-amd64-rocm.tgz

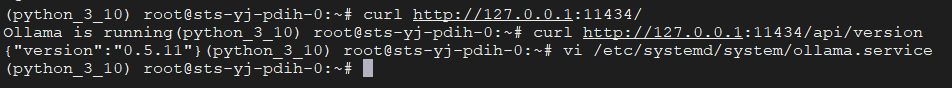

3. 修改配置文件,允许其他客户端调用,默认情况下ollama只能在本机上调用

vi /etc/systemd/system/ollama.service

点击查看配置

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

#ExecStart=/usr/bin/ollama serve

ExecStart=/usr/local/bin/ollama serve --host 0.0.0.0

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="OLLAMA_HOST=0.0.0.0:11434"

[Install]

WantedBy=default.target

4. 运行ollama

ollama serve&

二、部署ollama

5. 下载llama3.3 70b模型

ollama pull llama3.3:70b

6. 查看模型文件存放路径:

ollama show --modelfile llama3.3:70b

点击查看代码

(python_3_10) root@sts-yj-pdih-0:~/data/sjk/ollama# ollama show --modelfile llama3.3:70b

[GIN] 2025/02/25 - 02:44:23 | 200 | 30.057µs | 127.0.0.1 | HEAD "/"

[GIN] 2025/02/25 - 02:44:23 | 200 | 22.313843ms | 127.0.0.1 | POST "/api/show"

# Modelfile generated by "ollama show"

# To build a new Modelfile based on this, replace FROM with:

# FROM llama3.3:70b

FROM /root/.ollama/models/blobs/sha256-4824460d29f2058aaf6e1118a63a7a197a09bed509f0e7d4e2efb1ee273b447d

TEMPLATE "{{- range .Messages }}<|start_header_id|>{{ .Role }}<|end_header_id|>

{{ .Content }}<|eot_id|>

{{- end }}<|start_header_id|>assistant<|end_header_id|>

"

PARAMETER stop <|start_header_id|>

PARAMETER stop <|end_header_id|>

PARAMETER stop <|eot_id|>

将上述模型存放到指定路径 /root/data/sjk,

cp /root/.ollama/models/blobs/sha256-4824460d29f2058aaf6e1118a63a7a197a09bed509f0e7d4e2efb1ee273b447d /root/data/sjk/llama3.3:70b.gguf

并在/root/data/sjk目录下创建model.txt,写入以下内容:

from ./llama3.3:70b.gguf

7. 创建模型

ollama create llama3.3:70b -f model.txt

8. 查看模型

ollama list

点击查看

(python_3_10) root@sts-yj-pdih-0:~/data/sjk# ollama list

NAME ID SIZE MODIFIED

llama3.3:70b 5520fd28a084 42 GB 23 seconds ago

三 部署graphrag

1. 下载graphrag (指定版本v0.4.1),建议下载tag为v0.4.1的版本,不同版本配置不同

git clone -b v0.4.1 https://github.com/microsoft/graphrag.git

2. 进入graphrag目录,下载依赖包:

pip install -e .

3. 创建所需的目录

将数据文本文件放在这个路径下, 文件格式为txt, 注意:txt文件必须是utf-8编码的,可以多个文件。

mkdir -p ./ragtest/input

4. 初始化 ./ragtest 文件夹以创建所需的文件:

graphrag init --root ./ragtest

此时会在 ragtest 目录下生成 output,logs,setting.yaml,prompts,.env (默认隐藏)等目录及文件。setting.yaml 是配置文件,后面需要修改,output 是每次跑模型的结果,logs是运行日志。

5. 修改.env文件为如下内容:

GRAPHRAG_API_KEY=ollama

GRAPHRAG_CLAIM_EXTRACTION_ENABLED=True

6. 修改setting.yaml文件,修改的代码为:

点击查看代码

api_key: ollama

model: llama3.1-32k

api_base: http://localhost:11434/v1

api_key: ollama

model: nomic-embed-text

api_base: http://localhost:11434/api

chunks:

size: 300

snapshots:

graphml: true

7. 参考博客修改源码

8. Running the Indexing pipeline

graphrag index --root ./ragtest

浙公网安备 33010602011771号

浙公网安备 33010602011771号