Hadoop集群节点启动异常处理

㈠、我们首先来看报错信息(文件路径因人而异,务必注意)

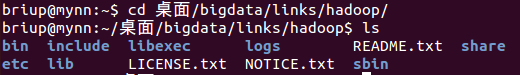

1、进入创建的软连接下的Hadoop中查找日志

①cd 桌面/bigdata/links/hadoop/

②ls

截图如下:

③cd logs

④ls

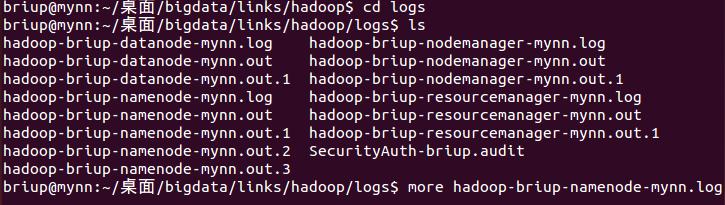

根据自己所挂掉的节点去选择所要查找的日志(以NameNode为例)

⑤more hadoop-briup-namenode-mynn.log

截图如下:

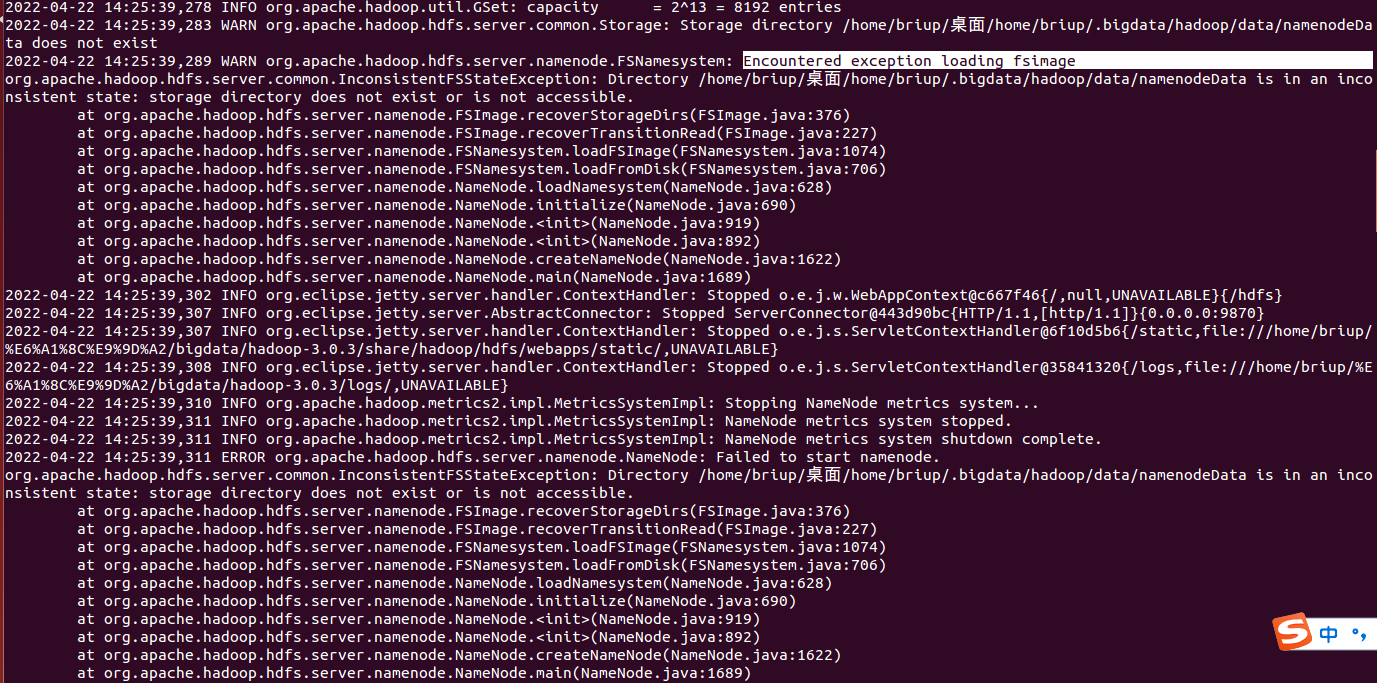

查找到的信息会很多,报错信息在偏下的位置,要耐心的看完哦(回车用来查看信息,若要跳出可使用Ctrl+c),由于内容偏多,此处着重来看报错信息,报错信息有以下俩种报错。

报错一:

报错二:

㈡、解决问题

1、我们使用格式化的方法来解决报错一

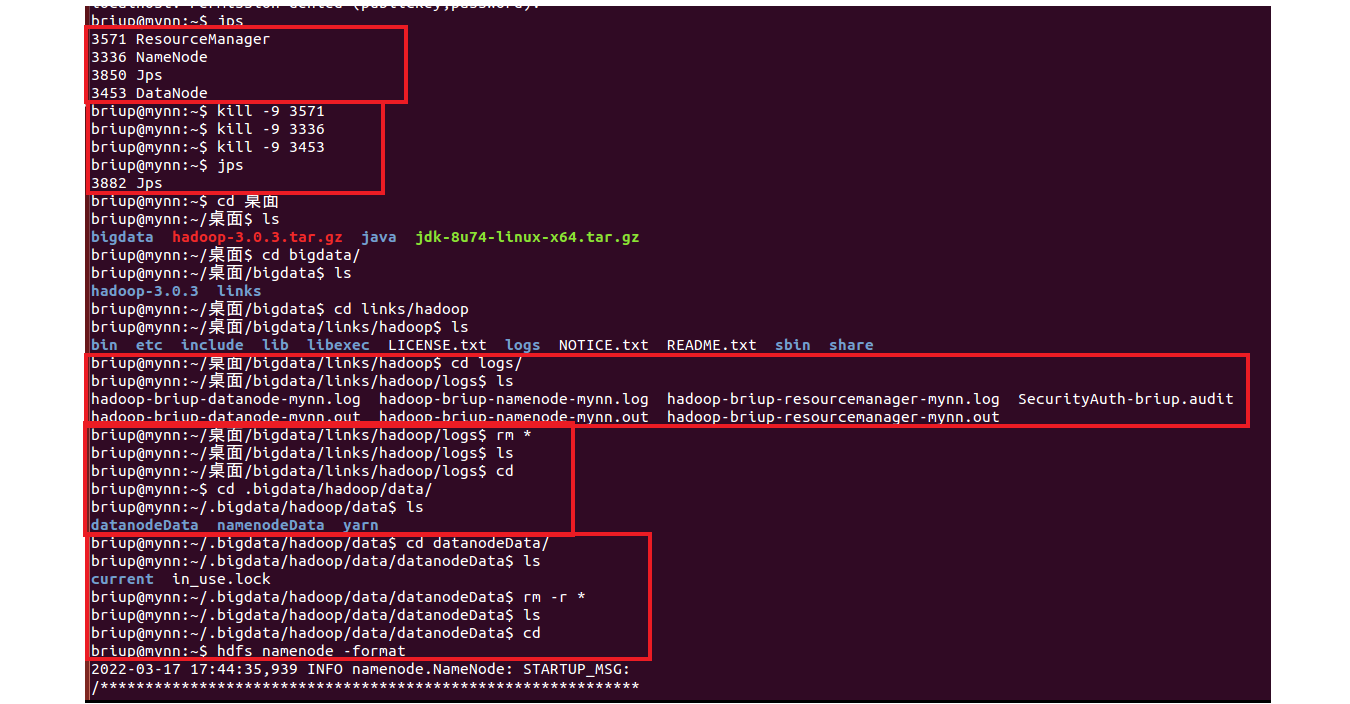

①首先我们将可以启动的几个集群关闭

kill -9 3571(集群编号)

或

hadoop-daemon.sh stop datanode

②然后删除所有日志信息

⑴cd 桌面/bigdata/links/hadoop/logs

⑵rm *

⑶ls

⑷cd

③然后进入根目录下删除datanodeData下的数据

⑴cd .bigdata/hadoop/data

⑵ls

⑶cd datanodeData

⑷ls

⑸rm -r *

⑹ls

⑺cd

④重新初始化hdfs文件系统

hdfs namenode -format

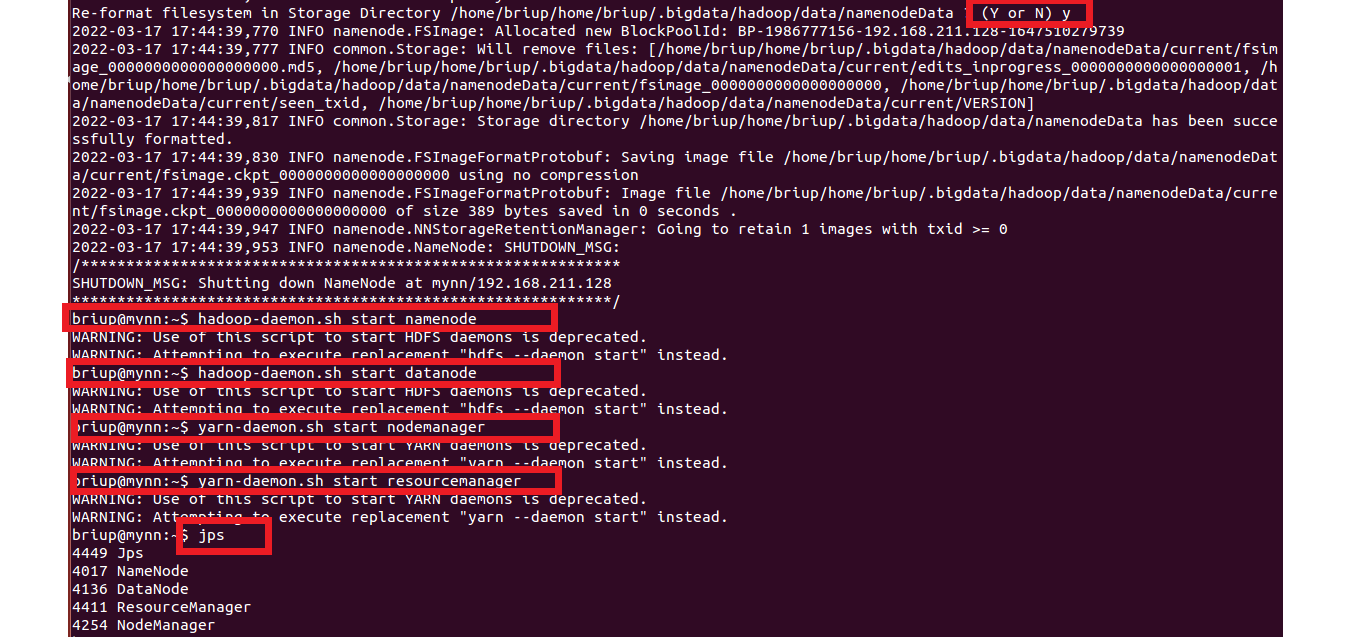

注:一定要出现输入Y才算是正常了.不然一直初始化

⑤启动集群(启动方式不一样的以自己的为准)

hadoop-daemon.sh start namenode

hadoop-daemon.sh start datanode

yarn-daemon.sh start nodemanager

yarn-daemon.sh start resourcemanager

到这里,集群节点应该是可以启动的,下面俩张图操作过程,可结合图片去操作

2、报错二解决方法

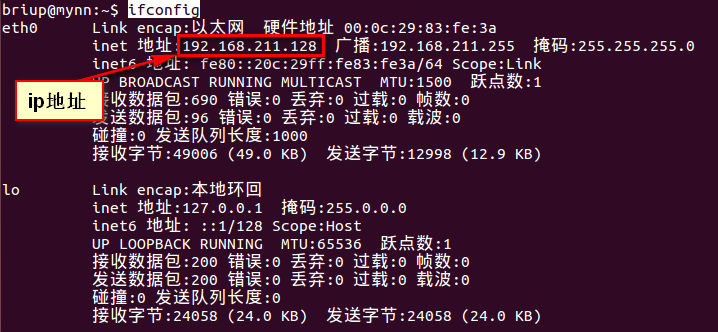

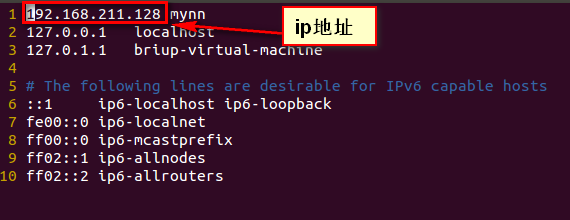

①查看俩个地方的ip地址是否一致

⑴ ifconfig 查询结果如下:

⑵vi /etc/hosts

⑶若不一致,以第一张图中的ip地址为主

②改完ip地址后,重复解决报错一的操作

浙公网安备 33010602011771号

浙公网安备 33010602011771号