论文阅读:1、针对深度学习的对抗攻击综述-密码学报-2021年8月

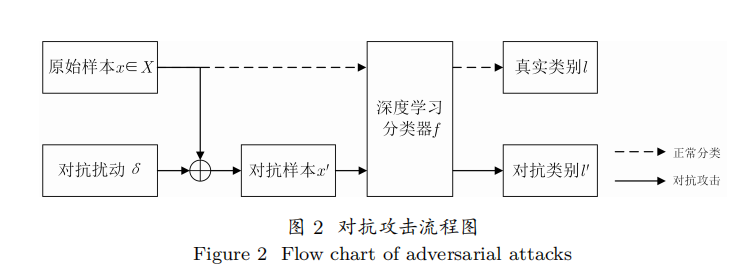

①通过对原始样本加入微小扰动所生成的对抗样本能够有效欺骗深度学习模型,并将生成对抗样本的方式称为对抗攻击。

②对抗攻击能够使深度学习以高置信度的方式给出错误的输出,实现针对深度学习检测服务的逃逸攻击。

③深度学习缺乏可解释性由其自身结构和运行机理决定,具体表现在以下3个方面:

(1)深度神经网络的神经元数量大、参数多;

(2)神经网络采用分层结构,层次之间连接方式多样;

(3)神经网络自主学习样本特征,而许多特征人类无法理解。

④在计算机视觉领域,对抗样本现象是指对输入图像加入人眼视觉难以感知的轻微扰动,导致基于深度学习的图像分类器以高置信度的方式输出错误的结果。

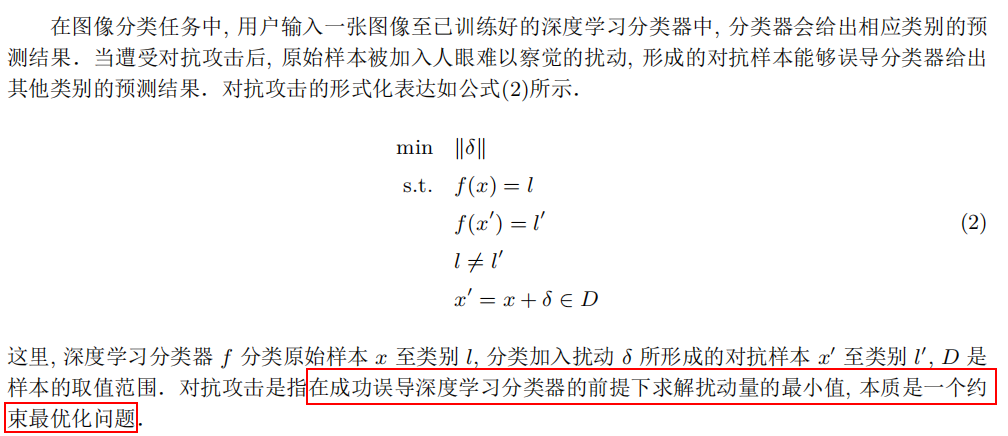

⑤

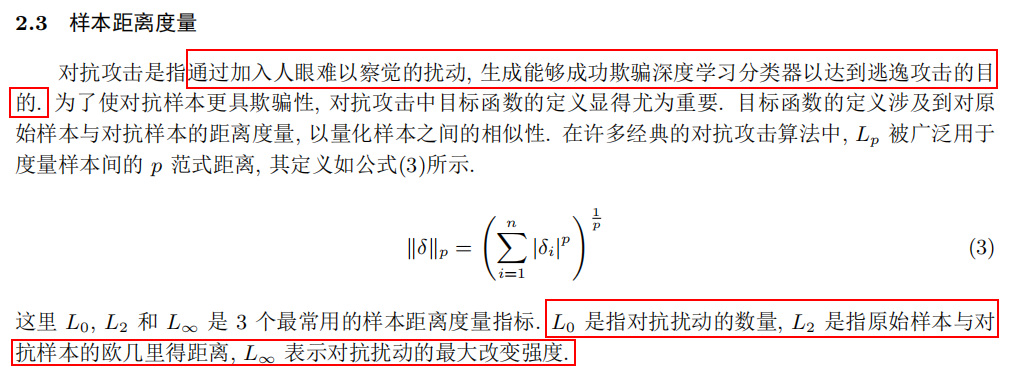

⑥

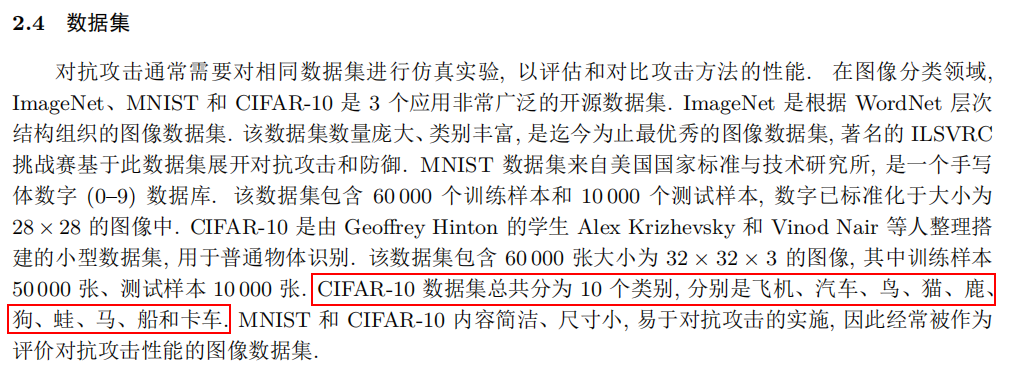

⑦

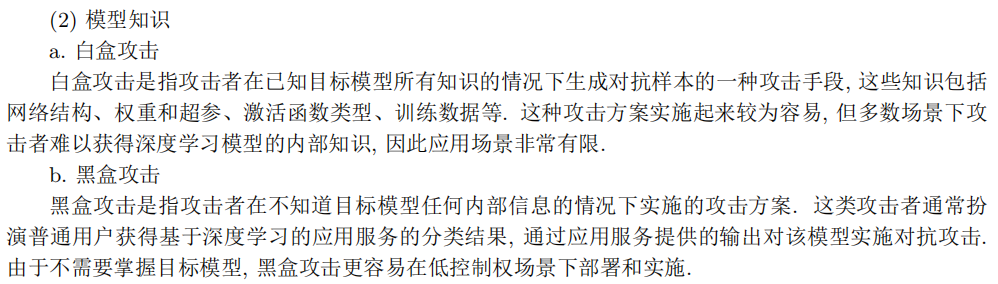

⑧

⑨

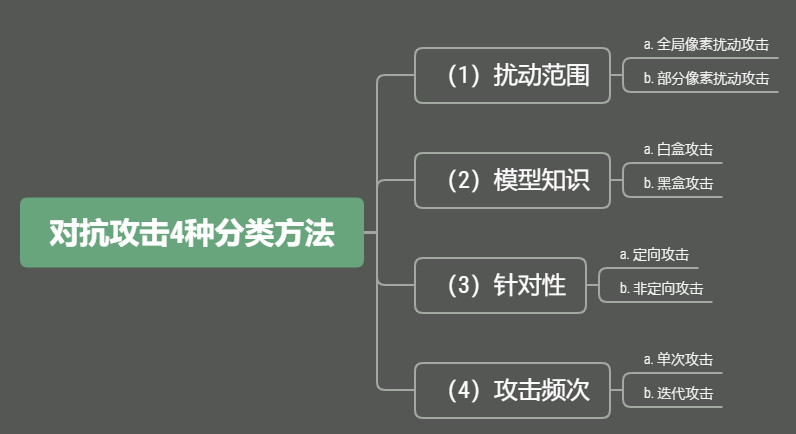

分类的思维导图

⑩

浙公网安备 33010602011771号

浙公网安备 33010602011771号