[斯坦福大学2014机器学习教程笔记]第四章-多元梯度下降法

在这节中,我们将介绍如何设定该假设的参数,我们还会讲如何使用梯度下降法来处理多元线性回归。

首先,我们回顾一下上节的知识点。

- 假设形式:hθ(x)=θTX=θ0x0+θ1x1+θ2x2+θ3x3+……+θnxn。(x0=1)

- 参数:θ0,θ1,θ2,……,θn。我们也可以把它想象成一个n+1维向量。

- 代价函数:J(θ0,θ1,……,θn)=(1/2m)Σ(hθ(xi)-yi)2。(通过误差项的平方和来给定)但是,我们可以不把J看作是这n+1个数的函数,我们可以把它看作是参数θ这个向量的函数。所以J(θ0,θ1,……,θn)也可以写作J(θ)。

- 那么,我们就可以得出梯度下降的式子,如下所示。

我们要不断通过θj减去α乘以导数项来更新每个θj参数。

我们要不断通过θj减去α乘以导数项来更新每个θj参数。

接下来,让我们看一下执行梯度下降时是怎么样的。

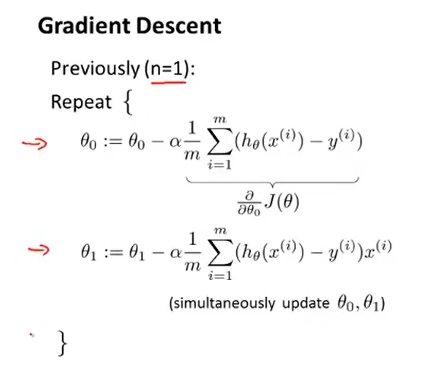

我们先来回顾一下之前讨论过的内容(即当n=1时的情况)。

在n=1的情况下,我们有两个独立的更新规则,分别对应参数θ0和θ1。

那么当n≥1时,我们有

所以,我们就能得到可行的用于多元线性回归的梯度下降法。当我们有多个特征量时,我们会有多个更新规则来更新参数θ0,θ1,θ2,……。

当我们观察θ0的更新规则,和之前n=1的时候的式子其实是一样的。它们一样的原因是,我们约定了x0(i)=1。当我们观察θ1的更新规则,和之前n=1的时候的式子其实是等效的。但是,我们要注意,我们使用了x1(i)来表示第一个特征量。现在我们有多个特征量,所以我们也有多个相似的更新规则。

去更远的地方 见更亮的光

浙公网安备 33010602011771号

浙公网安备 33010602011771号