吴恩达-梯度爆炸和消失

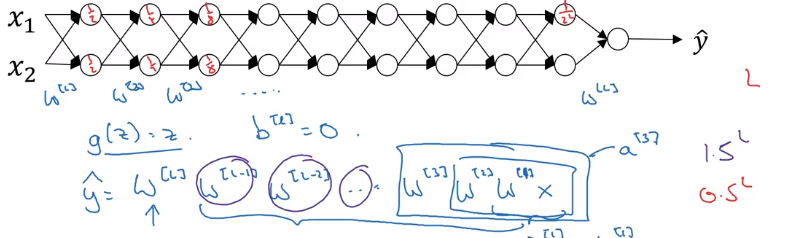

如果神经网络层数过多,假设每一次的W权重都是一样的且都>1,那么经过L层,则在反向传播中,往后的梯度会是指数级增长, w^L,反正如果w<1,最后梯度会一直接近于0造成梯度小时的现象

那么如何解决这个问题呢

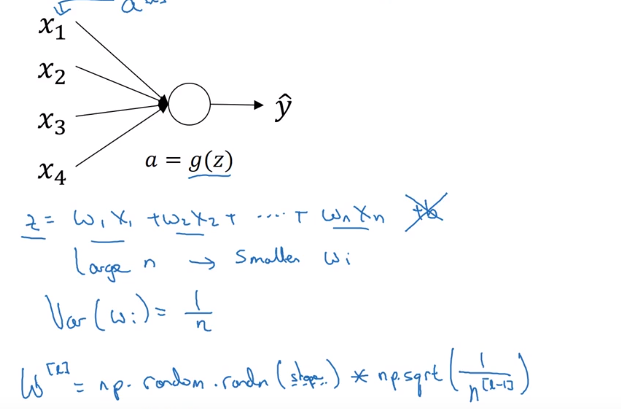

最直接的方式就是从根源入手,如果是如图的线性激活函数g(z)=z,则尽量减少W值,此处线性关系的解决:

但是此方式不能根本解决问题,只能延缓发生的时间,换一种思路

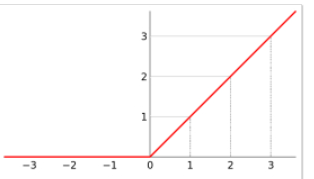

或者是改变g(Z),如果使用relu函数,当z>=0的时候,此时梯度永远为1,那么1^L还是为1,问题解决:

要注意的是当z<0的时候,梯度始终为0,这样可能导致某些神经元死亡的现象发生

浙公网安备 33010602011771号

浙公网安备 33010602011771号