各大公司AI栈分析

| 华为 | 海光 | amd | intel | nv | |

| GPU/NPU | Ascend910 | 深算二号 |

Instinct MI100-300 RX 桌面系列( RX5000,RX6000 RX7000,RX9000) |

Gaudi 3 桌面:ARC A770

|

P100、V100、A100、H100、B200 桌面:RTX 4090 |

| 计算架构 | CANN | ROCm | ROCm | OneAPI | CUDA |

| AI推理部署框架 | MindSpore Serving | SGlang | OPEA、OpenVino | TensorRT-LLM/NIM | |

| AI推理训练框架 | MindSpore | PyTorch | PyTorch | PyTorch |

开源AI推理部署框架:Ollama、VLLM、LLaMA.cpp、

各个公司都在PyTorch发力。 似乎TensorFlow已不再是主流。

英伟达服务器GPU对比

| GPU | 架构 | 工艺 | CUDA 核心数 | 显存类型 | 显存容量 | 内存带宽 | FP16 峰值性能 | 应用场景 |

|---|---|---|---|---|---|---|---|---|

| P100 | NVIDIA Pascal | 16nm | 无具体数据 | HBM2 | 16GB/32GB | 732GB/s 或 549GB/s | 18.7 teraFLOPS | 具备强扩展能力的 HPC、混合型工作负载 HPC 的数据中心 |

| V100 | Volta | 12nm | 5120 个 | HBM2 | 16GB/32GB | 900GB/s | 125TFLOPS | 深度学习训练和推理、高性能计算、数据分析 |

| A100 | Ampere | 7nm | 6912 个 | HBM2E | 40GB/80GB | 1.6TB/s | 312TFLOPS | 深度学习训练、推理、高性能计算和数据分析 |

| H100 | Hopper | 台积电 4N | 16384 个 | HBM3 | 80GB | 3TB/s | 840TFLOPS | 大规模 AI 训练和推理、高性能计算 |

| B200 | Blackwell | 无具体数据 | 无具体数据 | HBM3e | 192GB(每个 Die 4 个 24GB 的 HBM3e stack) | 8TB/s | 无具体数据 | 超大规模数据中心、人工智能和机器学习、高性能计算(HPC) |

DeepSeep 大模型服务

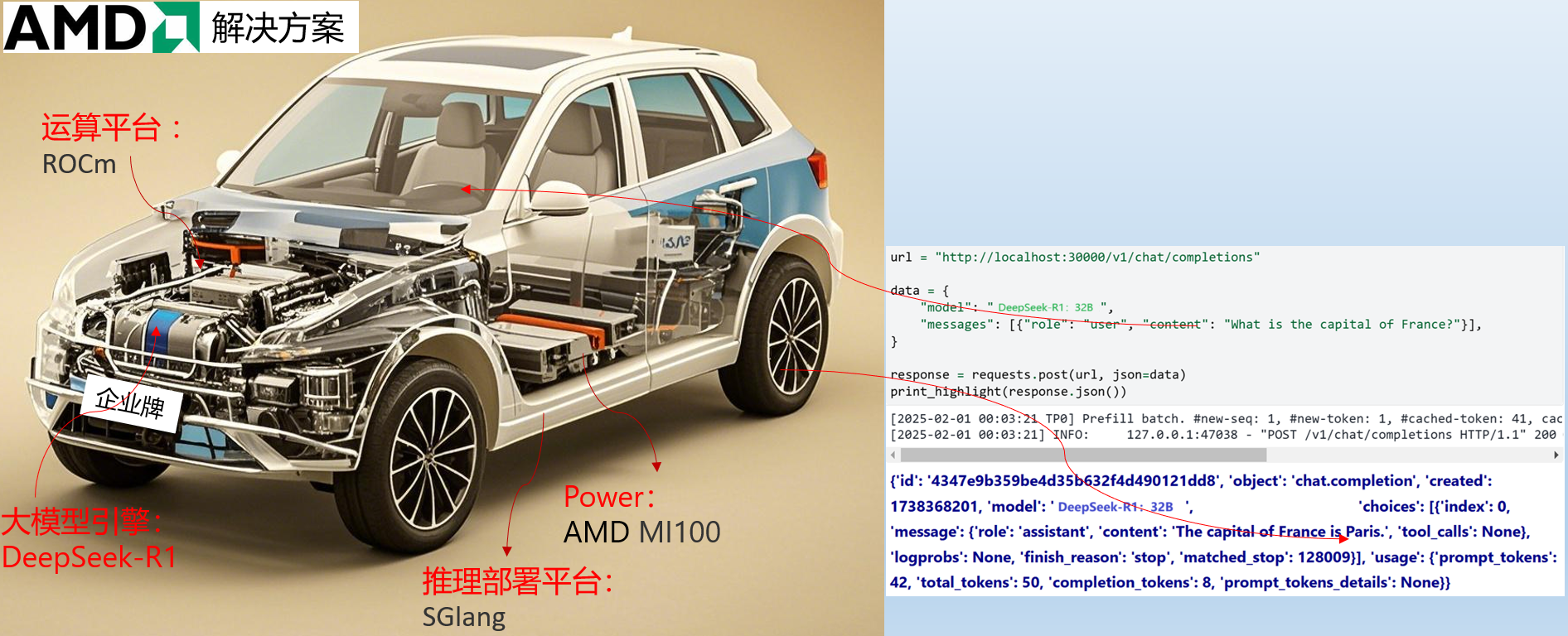

AMD:提供解决方案

腾讯云:提供大模型即服务

REF:

AI相关的一些软件库:cuDNN, cuBLAS,tensorrt-llm, TensorRT SDK

浙公网安备 33010602011771号

浙公网安备 33010602011771号