一些很棒的文章资料

目标检测中的数据不平衡问题综述

https://zhuanlan.zhihu.com/p/141147948

不错的文章.总结了各种数据不平衡问题和相应解决方法.

优化算法如何选择?

一个框架看懂优化算法之异同 SGD/AdaGrad/Adam

Adam的两宗罪

优化算法的选择与使用策略

adam和学习率衰减

不同优化算法的核心差异:下降方向

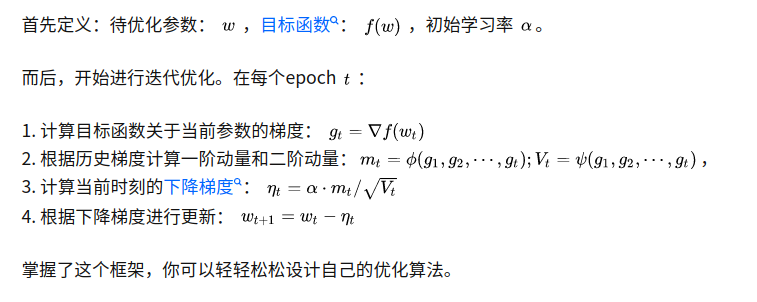

SGD算法的下降方向就是该位置的梯度方向的反方向,带一阶动量的SGD的下降方向则是该位置的一阶动量方向。自适应学习率类优化算法为每个参数设定了不同的学习率,在不同维度上设定不同步长,因此其下降方向是缩放过(scaled)的一阶动量方向。

SGD:完全不参考之前的梯度

SGD有两个缺点:1. 收敛慢 2.陷入局部最优

SGDM:t时刻的梯度方向参考t-1时刻的梯度. 由于引入了梯度动量,下降更快.

SGD with Nesterov Acceleration:步骤1中计算相对于当前参数的梯度的时候假设当前参数按照之前的梯度方向做变化,再求梯度. 为了解决局部最优解的问题.

Adam: 通过引入二阶动量,改变学习率,即adaptive + Momentum

卷及网络中的平移不变性

https://cloud.tencent.com/developer/article/1661000

cuda core和tensor core的区别

https://www.zhihu.com/question/451127498

高赞第二kaiyuan的回答.

作者:sdu20112013

如果您觉得阅读本文对您有帮助,请点一下“推荐”按钮,您的“推荐”将是我最大的写作动力!欢迎转载,转载请注明出处.

浙公网安备 33010602011771号

浙公网安备 33010602011771号