深度学习第四节——卷积神经网络

提纲

·绪论

1. 卷积神经网络的应用 2. 传统神经网络vs卷积神经网络

·基本组成结构

1. 卷积 2.池化 3.全连接

·卷积神经网络典型结构

1. AlexNet 2. ZFNet 3. VGG 4. GoogleNet 5. ResNet

·代码实战

TensorFlow-CNN

·总结

1.参考作业2.代码3.文献

一、绪论

1.卷积神经网络的应用:

(1)基本应用:分类,检测,检索,分割 (计算机视觉里常用)

(2)其他应用:人脸识别、人脸表情识别、图像生成、图像风格转化、图像风格转化、自动驾驶

2.传统神经网络vs卷积神经网络

深度学习三部曲

1. 搭建神经网络结构:给定一些图片,提取特征,就像是图片的一个表示

2. 找到一个合适的损失函数:来评估我的表示和真实的一些差异

比如说:交叉熵损失(cross entropy loss), 均方误差(MSE),……

3. 找到一个合适的优化函数,更新网络中的参数,让它朝着正确的方向去走

比如反向传播(BP算法),用随机梯度下降(SGD)去更新网络的参数

本节课主要讲第一部分,如何搭建神经网络的结构

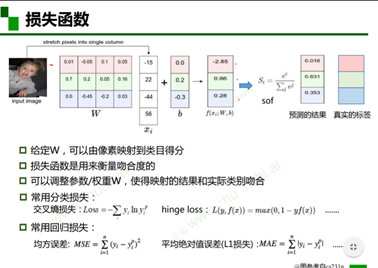

之前先看损失函数

假设有一个非常简单的神经网络,这个神经元的参数是W和b,给图像一个简单的表示xi,通过提特征的过程表示成f(xi, W, b),f=W*x+b,S分母…..结果呢,就是每一个都是这样概率的形式,并且他们的和是唯一的。真实的标签:真实位置是1,其他位置是0。接下来用损失函数衡量吻合度,调整参数、权重,使得映射的结果和实际类别相吻合。

在分类的任务中,常用的损失有:交叉熵损失yi指真实类别,yi’指预测类别,y是真是类别,f(x)预测类别。

在回归的任务中,比如说物体检测的例子。

传统神经网络能用到计算机视觉上吗?为什么还需要卷积神经网络呢?

全连接网络处理图像的问题

参数太多:权重矩阵的参数太多 –> 过拟合

卷积神经网络的解决方式

局部关联,参数共享(一次滑动过程中参数是不改变的)

传统神经网络vs卷积神经网络

相同之处:都是层级网络:

CONV layer: 卷积层

RELU layer: RELU 激活层

POOL layer: 池化层

FC layer:全连接层

二、基本组成结构

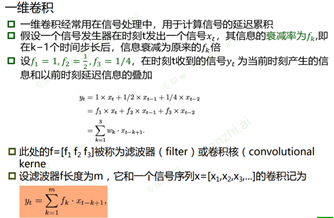

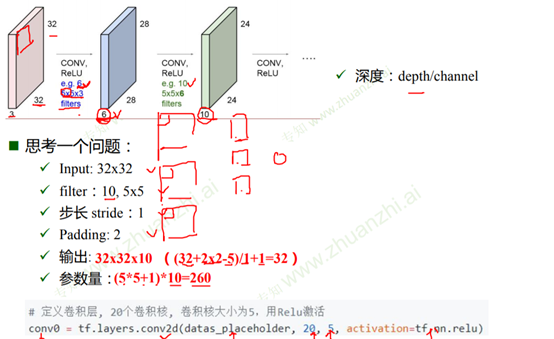

1.卷积— Convolutional Layer

·卷积是对两个实变函数的一种数学操作。

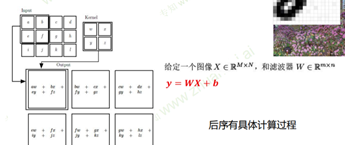

·在图像处理中,图像是以二维矩阵的形式输入到神经网络的, 因此我们需要二维卷积。

b偏秩向

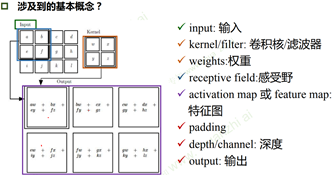

卷积核/滤波器

Input:输入二维矩阵,可能是对图像的一个表示

Kernel:红色框框

Weights:kernel里的每一个值

Receptive field:感受野:卷积核的感受野是对应的输入那块

Activation map特征图:经过一次卷积之后输出出来的

Padding:比如7*7,步长为3时最后不够,就在周围补0

Deep/channel深度:map厚度

卷积的可视化理解:机器学习有很强的数学理论支撑

在深层次上,不同的卷积核关注不同的信息;人眼可能识别不了

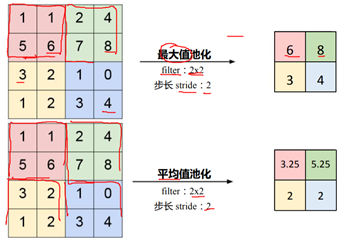

2.池化— Poo ling Layer

池化的过程更像是在做缩放的一个过程

·保留了主要特征的同时减少参数和计算量,防止过拟合,提高模型泛化能力。

·它一般处于卷积层与卷积层之间,全连接层与全连接层之间

Pooling的类型: Max pooling: 最大值池化 Average pooling: 平均池化

更像是数学的问题,最大值更常见

3.全连接 — Fully Connected Layer

全连接层 / FC layer:两层之间所有神经元都有权重链接

通常全连接层在卷积神经网络尾部

全连接层参数量通常最大

卷积神经网络小结:

一个典型的卷积网络是由卷积层、池化层、全连接层交叉堆叠而成

卷积是对两个实变函数的一种数学操作,求内积的一个过程

局部关联,参数共享

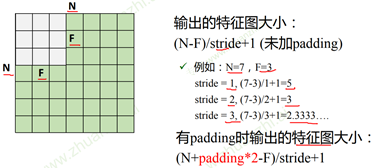

未加padding时输出的特征图大小:(N-F)/stride+1

有padding时输出的特征图大小:(N+padding*2- F)/stride+1

Pooling的类型:Max pooling: 最大值池化,Average pooling: 平均池化

全连接:通常全连接层在卷积神经网络尾部

浙公网安备 33010602011771号

浙公网安备 33010602011771号