【深度学习】xformers库介绍

背景

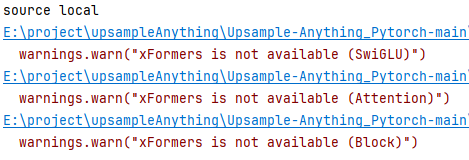

跑代码的时候看见这样的报错

虽然代码运行起来了,但是xformers库没有起作用,这样模型效果会有折扣

于是用命令装了一下xformers库(这个库也要和对应的cuda版本匹配)

pip3 install -U xformers --index-url https://download.pytorch.org/whl/cu118

后面了解了一下这个xformers库的作用

xFormers 库详解

xFormers 是由 Meta(原 Facebook)AI 团队开发的开源深度学习库,核心聚焦于 Transformer 架构的高效实现与优化,旨在解决 Transformer 自注意力机制(Self-Attention)带来的显存占用高、计算效率低的痛点,同时保持灵活性和易用性。

它与 PyTorch 深度集成,已成为大语言模型(LLM)、扩散模型(如 Stable Diffusion)、视觉 Transformer(ViT)等场景的核心优化工具。

一、核心背景:为什么需要 xFormers?

Transformer 的自注意力机制计算复杂度为 $O(n^2)$($n$ 为序列长度),长序列(如万级 token)场景下:

- 显存占用呈平方级增长,容易触发 OOM(显存溢出);

- 计算效率低下,训练/推理吞吐量低。

xFormers 正是为解决这两个问题而生,通过整合多种优化的注意力变体、硬件级算子优化,大幅提升 Transformer 的性能。

二、核心特点

1. 多类高效注意力变体的统一接口

xFormers 封装了目前主流的高性能注意力实现,用户可无缝切换,无需修改核心逻辑:

| 注意力变体 | 核心优势 | 适用场景 |

|---|---|---|

| FlashAttention | 显存节省 50%+、计算速度提升 2-4 倍 | 长序列 LLM 训练/推理 |

| Memory-Efficient Attention | 避免中间张量冗余存储,显存友好 | 通用 Transformer 场景 |

| 稀疏注意力(Sparse Attention) | 仅计算关键区域注意力,复杂度降至 O(n) | 超长序列(10万+ token) |

| 线性注意力(如 Linformer) | 用线性投影替代矩阵乘法,复杂度 O(n) | 极致长序列(百万级 token) |

| Multi-Head Attention (优化版) | 硬件适配的标准注意力实现 | 通用短序列场景 |

2. 硬件级算子优化

针对 NVIDIA GPU(CUDA/Tensor Core)做了深度定制:

- 重排内存访问模式,减少显存读写延迟;

- 利用 CUDA 核函数、Tensor Core 加速矩阵运算;

- 避免 PyTorch 原生算子的冗余中间张量生成。

3. 模块化、可插拔设计

- 组件与 PyTorch 原生 API 兼容,可直接替换

torch.nn.MultiheadAttention; - 易集成到 Hugging Face Transformers、Diffusers、Stable Diffusion 等主流生态。

4. 显存与速度双重优化

长序列(如 1024/4096 token)场景下:

- 显存占用:FlashAttention 相比原生实现可减少 50%-70%;

- 速度:训练/推理吞吐量提升 2-4 倍(NVIDIA A100/A10 等 GPU 下更明显)。

三、核心功能模块

xFormers 的代码结构清晰,核心模块如下:

| 模块 | 功能描述 |

|---|---|

xformers.ops |

底层优化算子(核心):如注意力计算、矩阵乘、Softmax 等 |

xformers.components.attention |

注意力组件封装:统一接口调用不同注意力变体 |

xformers.models |

预定义的高效 Transformer 骨架:快速构建模型 |

xformers.utils |

辅助工具:显存监控、性能评估、兼容性检查等 |

四、适用场景

- 大语言模型(LLM):优化 GPT、LLaMA、BERT 等模型的长序列训练/推理,降低显存占用、提升吞吐量;

- 扩散模型:优化 Stable Diffusion 等图像生成模型的 Cross Attention 层,加速图像生成、减少显存使用(是 SD 优化版的标配);

- 视觉 Transformer:优化 ViT、Swin Transformer 等模型的注意力计算,提升视觉任务训练效率;

- 多模态模型:CLIP、BLIP 等模型的跨模态注意力优化。

五、安装与简单使用

1. 安装(推荐匹配 CUDA/PyTorch 版本)

# 方式1:pip 安装(适配 CUDA 11.8 为例)

pip install xformers --index-url https://download.pytorch.org/whl/cu118

# 方式2:源码编译(需最新特性/自定义优化)

git clone https://github.com/facebookresearch/xformers.git

cd xformers

pip install -e .

2. 极简使用示例(替换原生注意力)

import torch

import xformers.ops as xops

# 模拟输入:batch_size=2,序列长度=1024,维度=512,头数=8

batch_size, seq_len, dim, num_heads = 2, 1024, 512, 8

q = torch.randn(batch_size, seq_len, dim).cuda() # Query

k = torch.randn(batch_size, seq_len, dim).cuda() # Key

v = torch.randn(batch_size, seq_len, dim).cuda() # Value

# 使用 xFormers 优化的 Memory-Efficient Attention

output = xops.memory_efficient_attention(q, k, v)

# 或使用 FlashAttention(自动适配硬件)

output = xops.flash_attention(q, k, v)

3. 集成到 Hugging Face 模型

以 LLaMA 为例,仅需替换注意力层:

from transformers import LlamaModel

from xformers.components.attention import build_attention

# 构建 xFormers 注意力组件

attn = build_attention(

{"name": "flash_attention", "dropout": 0.1},

dim_model=4096,

num_heads=32

)

# 替换模型的原生注意力

model = LlamaModel.from_pretrained("llama-7b")

for layer in model.layers:

layer.self_attn = attn

六、关键优势总结

- 显存节省:长序列下显存占用降低 50%+,解决 OOM 问题;

- 速度提升:硬件优化算子让注意力计算提速 2-4 倍,提升训练/推理吞吐量;

- 生态兼容:与 PyTorch、Hugging Face、Stable Diffusion 等深度整合;

- 灵活性:支持多种注意力变体,适配不同序列长度和任务场景。

七、注意事项

- 硬件依赖:主要优化针对 NVIDIA GPU(CUDA),CPU/AMD GPU 支持有限;

- 版本匹配:需严格匹配 PyTorch、CUDA 版本(如 PyTorch 2.0+ + CUDA 11.7/11.8),否则易安装失败;

- 接口兼容性:部分稀疏注意力变体需特定的序列处理方式,使用前需查阅官方文档。

生态整合

- Stable Diffusion:官方推荐启用 xFormers 加速图像生成,显存占用减少 30%+;

- Hugging Face:Transformers 库支持通过

accelerate集成 xFormers 优化; - Meta 自研模型:LLaMA、OPT 等模型的官方优化版本均基于 xFormers。

浙公网安备 33010602011771号

浙公网安备 33010602011771号