AI 语音随访患者,AI 医疗初创 Tucuvi 融资 2000 万美元;Gmail 升级 AI 版,转型主动式智能体助手丨日报

开发者朋友们大家好:

这里是**「RTE 开发者日报」,每天和大家一起看新闻、聊八卦。我们的社区编辑团队会整理分享 RTE(Real-Time Engagement) 领域内「有话题的技术**」、「有亮点的产品」、「有思考的文章」、「有态度的观点」、「有看点的活动」,但内容仅代表编辑的个人观点,欢迎大家留言、跟帖、讨论。

本期编辑:@瓒an、@鲍勃

01 有话题的技术

1、SiMa.ai 联合 Cerence 发布车载对话式 AI 方案:基于 Modalix SoC 实现全本地化推理,功耗低于 10W

SiMa.ai 与 Cerence 在 CES 2026 期间展示了新一代车载生成式 AI 对话系统。该方案通过 Modalix SoC 实现了完全的端侧运行,在确保高性能边缘推理的同时,将整机功耗控制在 10W 以下。

-

Modalix SoC 专有加速: 采用针对 GenAI 优化的专用 SoC 架构,支持在不依赖云端连接的情况下,于边缘侧完成复杂自然语言处理任务。

-

10W 低功耗运行: 相比通用 GPU 或高性能计算平台,该方案在提供高密度 AI 算力的同时,将运行功耗压低至 10W 以内,优化了车载环境的散热要求。

-

高自然度人机交互: 相比 IAA 2025 发布的早期版本,本次迭代提升了端侧模型的响应速度与逻辑理解能力,支持更接近真人的对话体验。

-

全本地化部署: 所有语音处理与大模型推理均在本地完成,确保了数据隐私并消除了云端请求带来的延迟风险。

( @SiMa_lnc@X)

2、Tucuvi 获 2000 万美元 A 轮融资:推出语音智能体「LOLA」,支持 50+ 自动化临床工作流

西班牙医疗 AI 初创公司 Tucuvi 完成 2000 万美元 A 轮融资,由 Cathay Innovation 和 Kfund 领投。其核心产品 AI 护理管理平台利用语音智能体「LOLA」自动化处理患者电话沟通与临床决策支持,旨在解决医疗系统行政效率低下及人手短缺问题。

-

语音智能体「LOLA」实现复杂临床交互: 智能体通过语音交互执行患者随访,支持包括术后跟踪、慢病管理、术前评估、分诊筛选及药物管理在内的 50 多种临床工作流。

-

端到端工作流编排与人工升级机制: 平台支持全流程自动化,并在识别到异常临床指标或复杂情况时,自动将任务升级至人工医疗团队处理。

-

深度集成与自动文档化: 该平台不局限于语音通话,还涵盖了临床文档的自动生成,并实现了与现有医疗机构运营系统的后端集成。

-

大规模医疗合规性验证: 系统已在欧洲 60 多个医疗系统中部署,累计处理超过 30 万次真实患者通话,强调在临床环境下的可审计性与安全性。

目前已在欧洲 60 多个医疗系统中上线应用;本轮融资将用于向全欧洲及美国市场扩张。

( @Tech.eu)

02有亮点的产品

1、可以科技完成超亿元股权融资,将关注人机情感交互

消费级机器人公司可以科技完成超亿元股权融资,本轮由吴中金控集团、元禾控股领投,基石资本、蓝驰创投、黎万强跟投。

天眼查信息显示,可以科技此前已完成 7 轮融资,2022 年完成 C 轮融资,投资方涵盖蓝驰创投、源码资本、小米、顺为资本、安克创新、松禾远望等知名机构。

可以科技成立于 2014 年,旗下拥有细胞机器人(Cell Robot)和可立宝(ClicBot)两款旗舰产品。据官方信息,本轮融资将用于加速家庭服务机器人与教育机器人产品的研发及市场拓展。

本周的 CES2026 活动上,可以科技推出全新产品,桌面助理机器人 Loona Deskmate。

区别于同类型桌面产品,Loona Deskmate 不自带屏幕、摄像头或麦克风,用户需要将手机吸附到无线充电位,同步启动 AI 陪伴应用。

DeskMate 通过多模态 AI 感知与实时情感计算,实现了「无需下令,主动理解」的自然交互方式。

另据外部信息,可以科技 B+轮融资路演或将于 2026 年 2 月底正式启动。

( @多知)

2、开源插件 CallMe 发布:通过 「Telnyx」/「Twilio」 实现 Claude Code 语音外呼与多轮交互

开发者 zefram.eth 发布了名为 CallMe 的 MIT 开源插件,使 Claude Code 能够通过电话外呼方式与开发者进行异步交互。当 AI 任务完成、运行卡顿或需要人工决策时,系统将自动拨打用户电话并支持多轮语音对话。

-

混合 API 技术栈:语音通信链路基于 「Telnyx」 和 「Twilio」 接口,TTS 与 STT 由 OpenAI API 提供支持。

-

并发工具调用能力:支持在通话过程中执行 Tool Use ,例如 Claude 可在保持通话的同时进行网页搜索并将结果同步至语音流。

-

全终端覆盖:由于基于传统电信网络,该功能兼容智能手机、智能手表及固定电话,无需安装特定移动端 App。

-

权限校验约束:由于 Claude Code 的权限授予(如 ls 读取目录)必须通过终端输入完成,插件当前无法通过语音远程授权,建议在全自动模式下配置跳过权限确认。

-

极低运行成本:插件本体免费且开源,底层 API 通话成本仅为每分钟数美分。

现已在 GitHub 开放源码,采用 MIT 开源协议。用户需自行配置相关 API 密钥。

( @boredGenius@X)

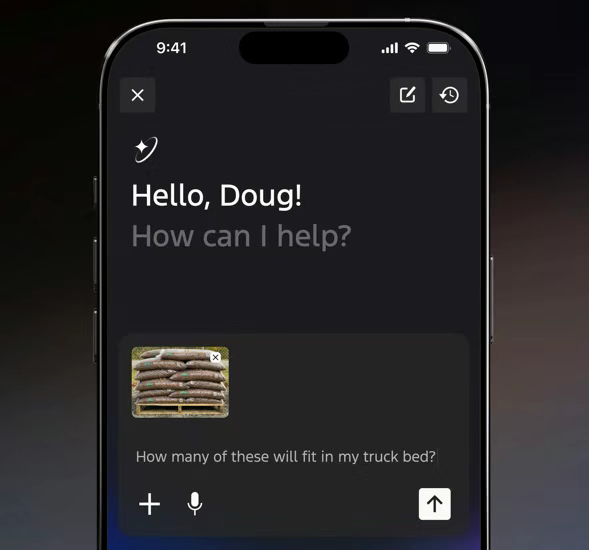

3、福特发布基于 LLM 的车载 AI 助手,下一代「BlueCruise」成本降低 30% 并瞄准 2028 年「Eyes-off」能力

Ford 在 CES 2026 宣布推出由 Google Cloud 托管的 LLM 智能体,并披露下一代「BlueCruise」智驾系统路线图。该更新旨在通过降低硬件成本和深化车端数据集成,实现从点对点辅助驾驶向高阶自动驾驶的演进。

-

深度数据集成智能体: 助手基于 Google Cloud 托管的现成 LLM 构建,拥有车辆底层数据访问权限。除了常规交互,可处理针对性技术咨询(如皮卡货箱载重限制、实时机油寿命分析),计划于 2027 年实现原生车载集成。

-

「BlueCruise」硬件成本削减: 下一代智驾系统制造支出较现行版本降低 30%。该系统将首发于「Universal Electric Vehicle」平台,首款搭载车型预计为 2027 年发布的中型皮卡。

-

点对点自主驾驶: 新版系统将提供类似于「Tesla」FSD 的端到端辅助能力,支持从起点到终点的连续导航辅助,初期仍需驾驶员全程监督。

-

「Eyes-off」技术节点: 明确 2028 年为实现「Eyes-off」驾驶的目标年份。届时系统将允许驾驶员在特定条件下视线离开路面,标志着从 L2+ 向 L3 级及以上自动驾驶的转变。

AI 助手计划 2026 年初上线手机 App,2027 年开启车载原生支持;下一代「BlueCruise」预计 2027 年随 UEV 平台新车发布。

( @TechCrunch)

4、Google 发布 Gemini 3 驱动的 Gmail 升级:原生集成 AI Overviews 与上下文感知 AI Inbox

Google 宣布 Gmail 正式接入 Gemini 3 大模型,推出具备语义搜索能力的 AI Overviews、自动化优先级排序的 AI Inbox 以及跨应用上下文的创作工具。此举旨在利用 LLM 的推理能力,将邮件客户端从单一通讯工具转型为主动式「智能体」助手。

-

基于 Gemini 3 的自然语言检索:AI Overviews 支持通过自然语言查询跨年份、跨邮件的具体细节(如去年的装修报价),直接生成精准回答而非返回邮件列表;对话摘要功能已面向全体用户免费开放,Q&A 检索功能限 Pro/Ultra 订阅者使用。

-

语义识别驱动的 AI Inbox:该功能通过分析用户往来频率、联系人关系强度及邮件正文语义,自动识别 VIP 并提取关键待办事项进行内置置顶,实现非固定规则的动态优先级排序。

-

跨应用上下文辅助写作:Help Me Write 模块新增个性化功能,下月起将支持调用其他 Google 应用(如日历、文档)中的上下文信息进行邮件草拟;同时集成 Proofread 接口,提供进阶语法与语调校对。

-

多模态与性能优化:底层由 Gemini 3 系列模型驱动,在保持低延迟的前提下提升了长文本的合成摘要能力,目前首发支持英文,后续将扩展多语言支持。

即日起在美国市场上线(仅限英文),AI Overviews 摘要功能全员免费,Q&A 与 Proofread 需订阅 Google AI Pro/Ultra;AI Inbox 目前处于 Trusted Testers 测试阶段,预计未来数月内规模化部署。

( @Google Blog)

03有态度的观点

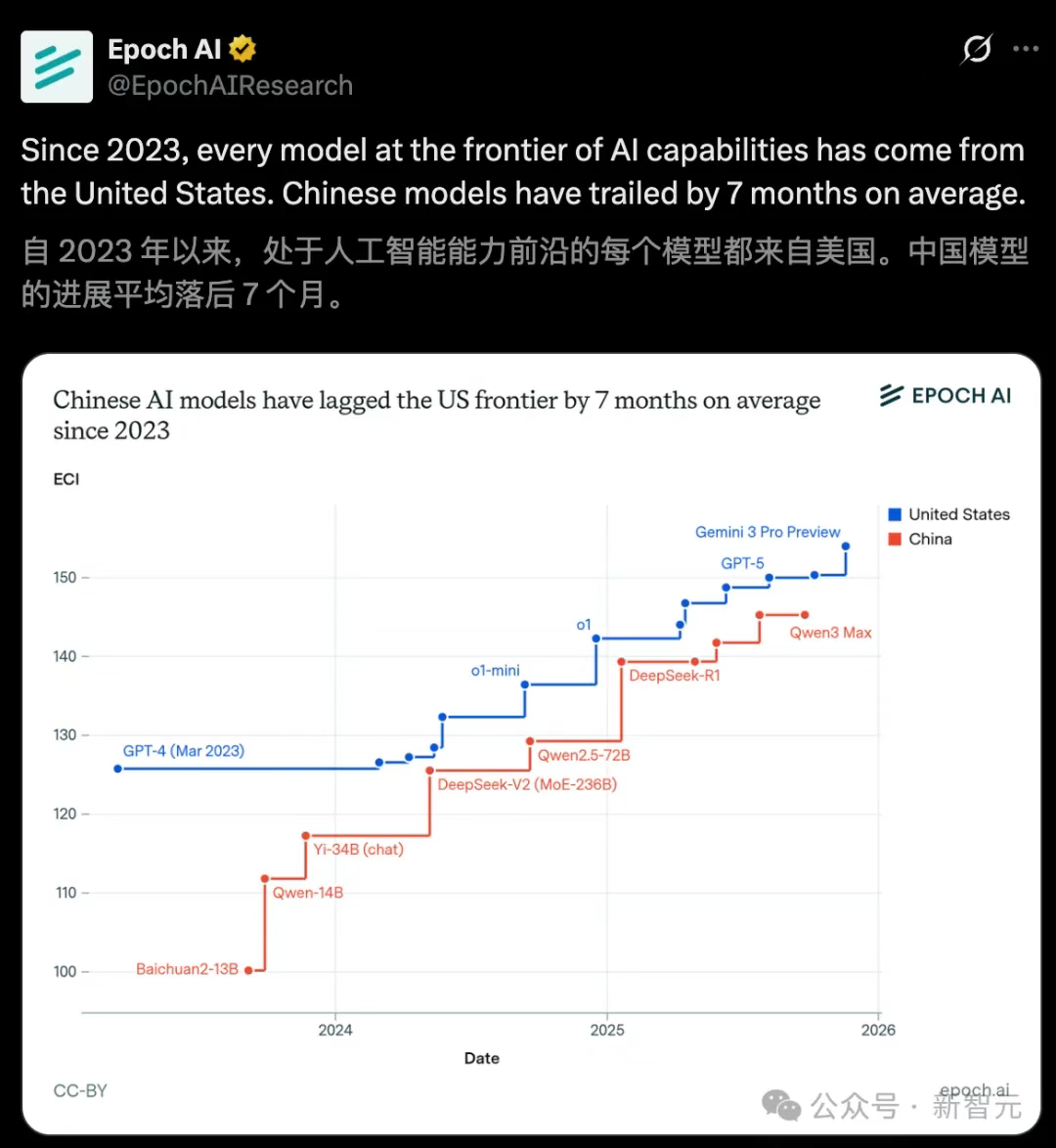

1、Epoch AI 新报告:中国平均落后 7 个月,最小差距 4 个月

近日,Epoch AI 发布了一份关于全球大模型进展的最新图表,通过量化数据揭示了中美 AI 实力之间的真实差距。报告指出,自 2023 年以来,中国前沿 AI 模型的进展平均落后于美国 7 个月,其中最小差距为 4 个月,最大差距则达到 14 个月。

报告采用了综合能力指数(ECI)作为衡量标准,全面评估了模型在语言理解、推理分解、多任务泛化及专家校准等维度的表现。图表显示,中美 AI 能力的演进曲线虽然方向一致,但节奏各异。美国 AI 表现出极为密集的更新频率,从 GPT-4、o1 到 Gemini 3 Pro,其能力的提升已不仅依赖参数规模,更在于推理路径设计和训练目标的重构。

相比之下,中国 AI 模型展现出明显的「跳跃式」追赶特征。从早期的 Baichuan2、Yi-34B 到近期的 DeepSeek-V2、Qwen2.5 及 Qwen3 Max,中国模型主要通过扩大参数规模和采用 MoE 架构来快速拉平差距。数据显示,双方代差已从 2023 年的 10–12 个月,逐步收敛并稳定在目前的 7 个月左右。

报告揭示了一个核心事实:这 7 个月的代差本质上也是「开源与闭源」的差距。目前,美国最顶尖的前沿模型(如 GPT-5、Gemini 3)均为闭源,持续拉高全球能力上限;而中国最领先的模型如 Qwen 和 DeepSeek 系列,大多选择开放权重。中美 LLM 能力的差距,几乎完全贴合了闭源与开源模型之间的整体能力落差。

尽管存在代差,但数据显示中国 LLM 已完全进入全球大模型第一竞争梯队。行业分析认为,未来的决胜关键将不再仅仅是参数规模的竞争,而是转向范式的跃迁。随着 2026 年「持续学习」信号的释放,如何在不重新训练的情况下实现参数内的自我迭代,以及让 AI 推理与行动深度耦合、具备智能体级的系统能力,将成为定义下一代前沿 AI 的核心。谁能率先跨越这条线,谁就将重新定义全球 AI 的竞争格局。

(@新智元)

阅读更多 Voice Agent 学习笔记:了解最懂 AI 语音的头脑都在思考什么

写在最后:

我们欢迎更多的小伙伴参与 「RTE 开发者日报」 内容的共创,感兴趣的朋友请通过开发者社区或公众号留言联系,记得报暗号「共创」。

对于任何反馈(包括但不限于内容上、形式上)我们不胜感激、并有小惊喜回馈,例如你希望从日报中看到哪些内容;自己推荐的信源、项目、话题、活动等;或者列举几个你喜欢看、平时常看的内容渠道;内容排版或呈现形式上有哪些可以改进的地方等。

作者提示: 个人观点,仅供参考

浙公网安备 33010602011771号

浙公网安备 33010602011771号