特征选择

将属性称为特征,把对当前学习任务有用的属性称为“相关特征”、没用的特征称为“无关特征”,从给定的特征集合中选择出相关特征子集的过程,称为“特征选择”

特征选择是一个数据预处理过程,和降维一样也可以减缓维数灾难问题,不过它们的区别在于:

- 特征选择是选择一部分原始特征,不改变特征的含义,只是减少特征的数量。

- 降维是通过变换生成新的特征,原始特征的含义会在降维过程中被融合或改变。

特征选择更注重保留原始特征的可解释性,而降维更注重通过数学变换来简化数据结构。

除了上面提到的两种特征外,还有一类特征称为“冗余特征”:它们所包含的信息能从其他特征中推演出来,这些特征虽然不是必须的,但是可以降低学习任务的难度

在不考虑冗余特征的情况下,我们要做的就是选取一个包含了所有重要信息的特征子集

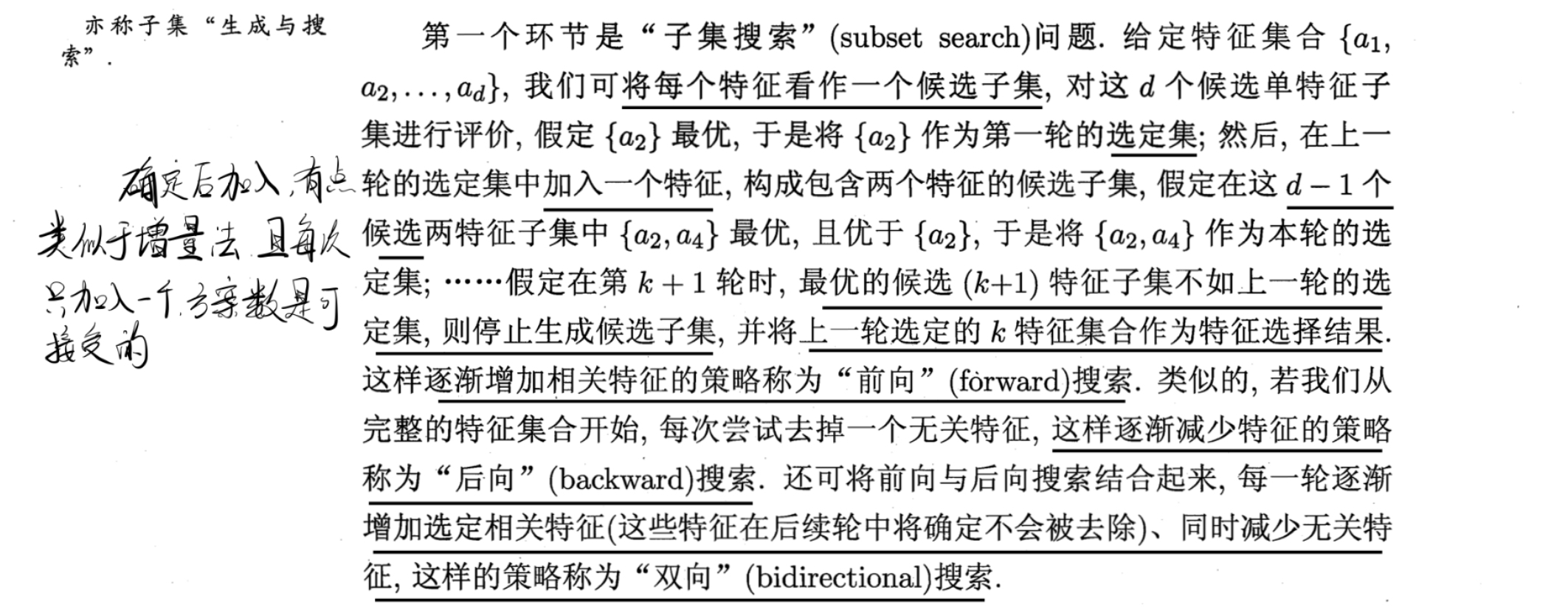

显然我们不能通过遍历子集的方式进行搜索,比较合适的方法是通过一种贪心策略:

当选择一个特征子集时,可以看作是对特征空间的一种划分,将原始特征空间划分为两个部分:

被选中的特征子集:这部分特征被认为是重要的,将用于后续的模型训练和分析。

被丢弃的特征集合:这部分特征被认为对模型的性能贡献较小,因此被排除在外。

特征子集的选择不仅划分了特征空间,也间接地划分了数据集。因为数据集中的每个样本都是由特征组成的,当特征被选择或丢弃时,样本的表示也会相应地改变。于是特征子集的选择降低了数据的维度。

从上面划分的角度出发,样本标记信息实际上也是一种划分,并且对应着D的真实划分,于是对比这两个划分,就能对我们得到的特征子集进行评价,具体评价指标比如信息增益

-

过滤式选择

先用特征选择过程对初始特征进行过滤,再用过滤后的特征来训练模型

在过滤式选择中,特征选择过程和后续学习器无关

Relief就是一种过滤式特征选择方法,其核心思想是好的特征应该使同类样本的相似度高,而异类样本的差异大,通过分析每个特征在"相近样本对"中的表现来评估特征重要性

Relief是为二分类问题设计的,其扩展Relief-F可用于解决多分类问题 -

包裹式选择

包裹式特征选择直接把将要使用的学习器的性能作为特征子集的评价标准

如LVW算法,它在拉斯维加斯方法框架下使用随机策略来进行子集搜索,并以最终分类器的误差为特征子集评价准则

浙公网安备 33010602011771号

浙公网安备 33010602011771号