AI

安装ollama千问

curl -fsSL https://ollama.com/install.sh | sh

ollama run qwen3:1.7b

$ ollama ps

NAME ID SIZE PROCESSOR CONTEXT UNTIL

qwen3:1.7b 8f68893c685c 5.3 GB 100% GPU 32768 4 minutes from now

安装/启动open-webui (Optianal)

pip install open-webui

open-webui serve

为 qwen3 暴露并使用 REST API

Ollama 自带本地 HTTP 接口 (默认: http://localhost:11434)。

基本生成:

curl -X POST http://localhost:11434/api/generate \

-H "Content-Type: application/json" \

-d '{"model":"qwen3:1.7b","prompt":"你好,简要自我介绍"}'

流式生成 (curl 会逐行返回 JSON):

curl -N -X POST http://localhost:11434/api/generate \

-H "Content-Type: application/json" \

-d '{"model":"qwen3:1.7b","prompt":"讲一个关于并发的笑话","stream":true}'

Chat 接口:

curl -X POST http://localhost:11434/api/chat \

-H "Content-Type: application/json" \

-d '{

"model":"qwen3:1.7b",

"messages":[{"role":"user","content":"总结一下Java的GC机制"}]

}'

Embedding:

curl -X POST http://localhost:11434/api/embeddings \

-H "Content-Type: application/json" \

-d '{"model":"qwen3:1.7b","prompt":"向量表示示例"}'

配置

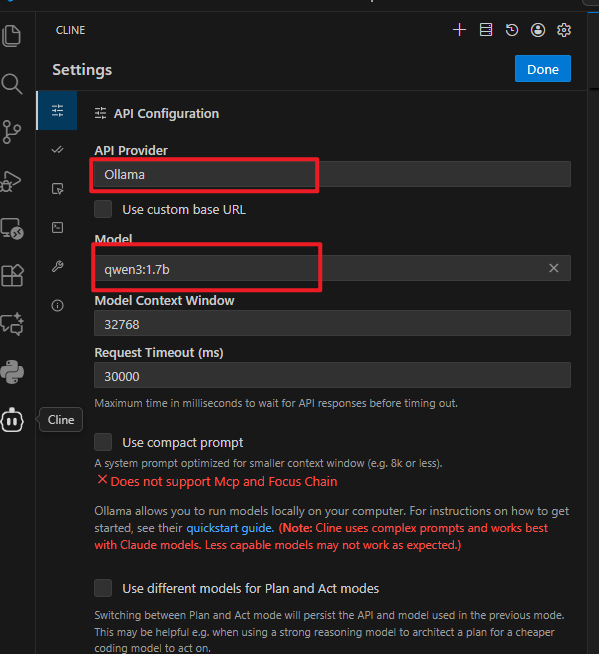

在vscode中安装cline,然后如图所示配置大语言模型。

本地起的语言模型受性能影响可能没有demo的效果好, demo使用的是gemini-2.5-pro

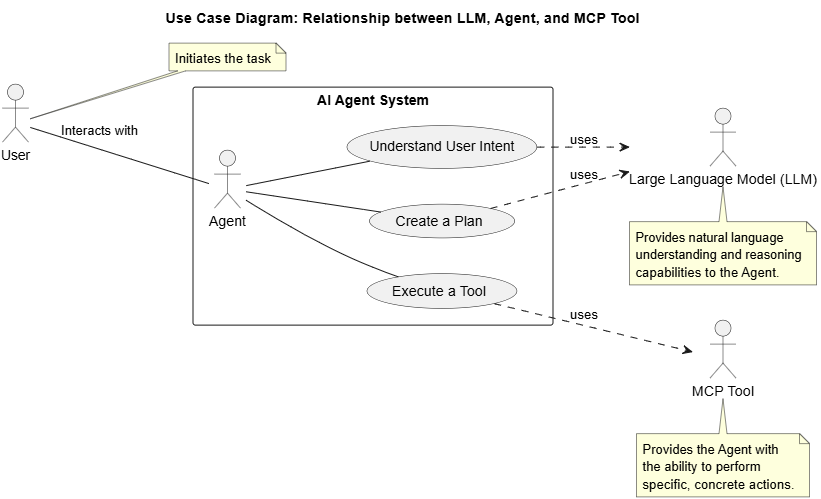

简单说,AI agent和MCP的关系,AI作为大语言模型,它什么也不会干,但它会思考知道该干什么,而MCP则是提供真正干活的工具,可以实实际际干活的,AI结合MCP才能真正做事情。而agent则是二者的粘合剂。

demo

浙公网安备 33010602011771号

浙公网安备 33010602011771号