springboot整合ollama本地大模型

常见的大模型有:ChatGPT、通义、讯飞、文心等,本文介绍下基于ollama的本地大模型

这个本地大模型的最大特点就是不用联网也能使用

Ollama 是一个开源的大型语言模型服务工具。它的主要作用是帮助用户快速在本地运行大模型,简化了在 Docker 容器内部署和管理大语言模型(LLM)的过程。

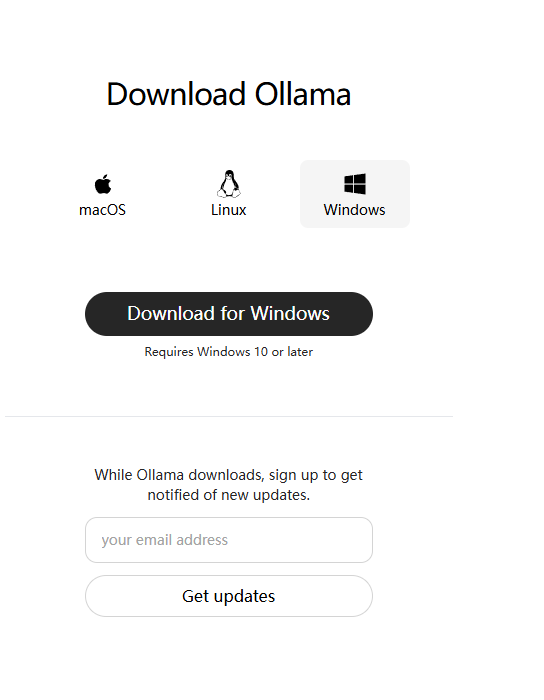

二、安装并运行本地大模型

将下载好的ollama下载好后,是个exe,将其安装,然后使用cmd打开命令窗口,执行安装大模型命令, 支持大模型列表:https://ollama.com/library,比如安装并运行通义千问:ollama run qwen2:0.5b,记得一定要带上哪个版本,比如这0.5b(此处的b代表billion,数字越大代表查询的结果越准确,当然也需要更多内存空间)

安装完成,可自行使用命令进行测试:

三、调用本地大模型接口

1、添加依赖

<!--ollama本地大模型-->

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-ollama-spring-boot-starter</artifactId>

</dependency>

可以不用写版本,让其根据你的springboot版本自动下载相应版本

2、在application.yml中添加配置

spring: ai: ollama: base-url: http://localhost:11434 chat: options: model: qwen2:0.5b

注意上面的model配置多少的,就看你安装的是多少的(当然你也可以乱填,到时候测试类会提醒你填的不可用)

3、测试

打开springboot工程,可以在测试类里面自行进行测试@SpringBootTest public class OllamaTest { @Resource private OllamaChatClient ollamaChatClient; @Test public void test() { String question = "什么是租金比"; String answer = ollamaChatClient.call(question); System.out.println(answer); } }

如果没问题,那么就可以在代码中进行业务代码写入了。

浙公网安备 33010602011771号

浙公网安备 33010602011771号