5.RDD操作综合实例

一、词频统计

A. 分步骤实现

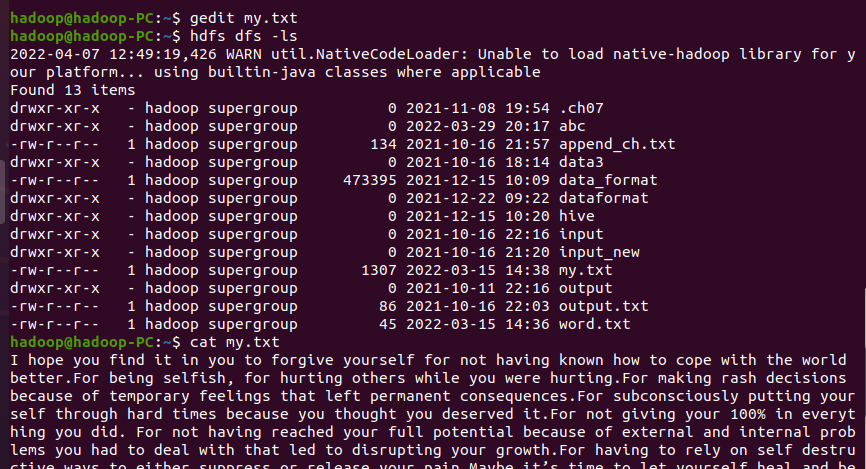

1.准备文件

- 下载小说或长篇新闻稿

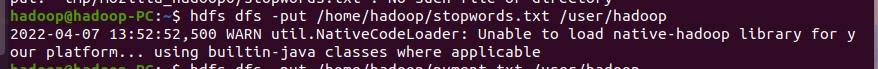

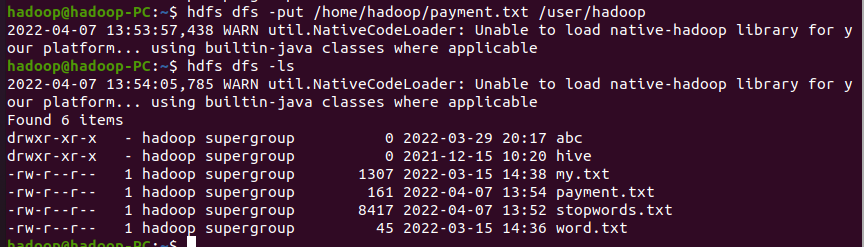

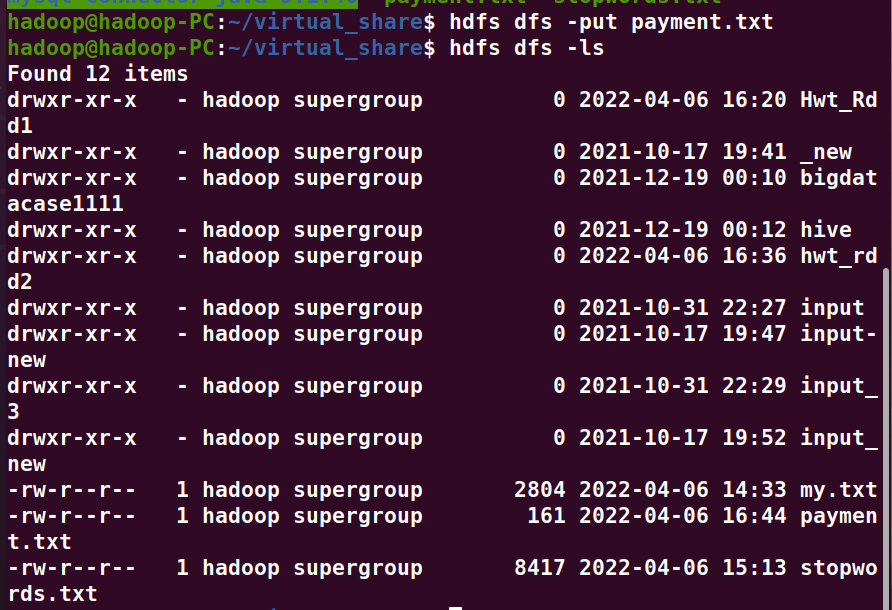

- 上传到hdfs上

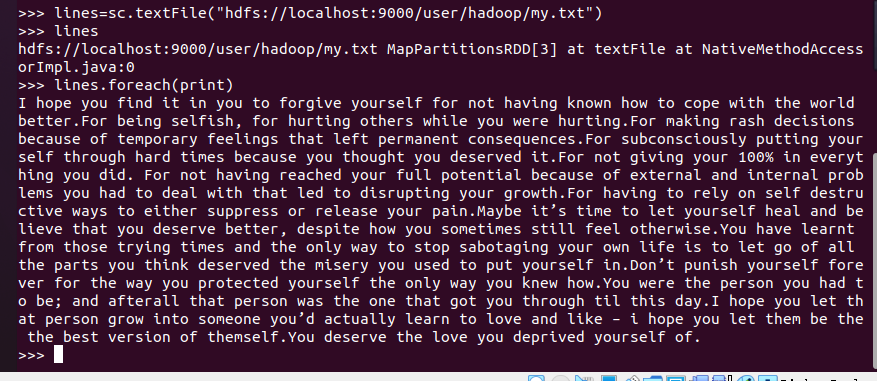

2.读文件创建RDD

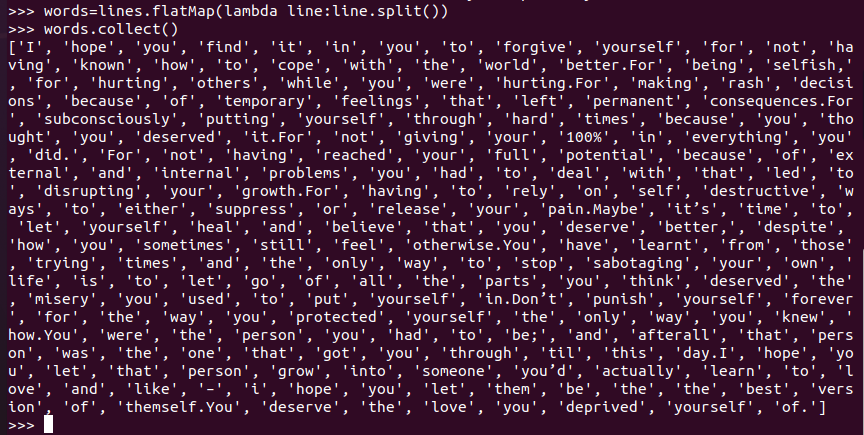

3.分词

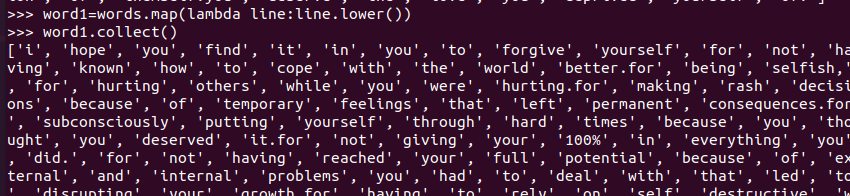

4.排除大小写lower(),map()

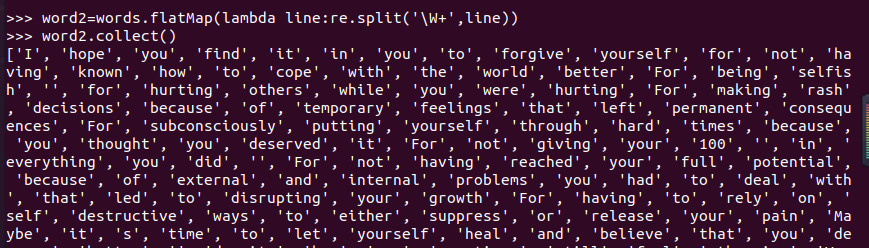

标点符号re.split(pattern,str),flatMap(),

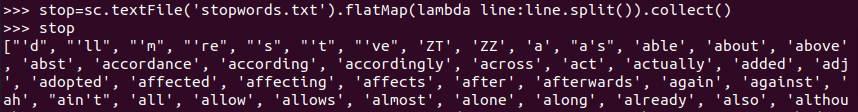

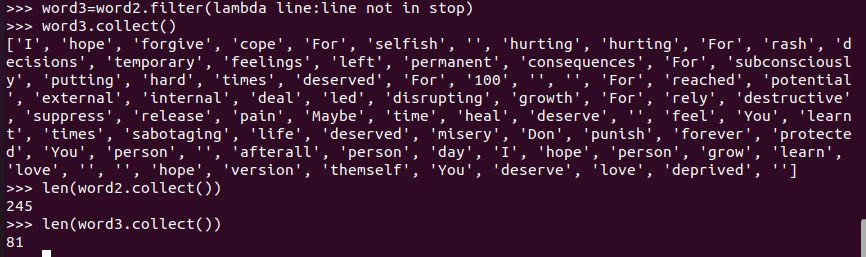

停用词,可网盘下载stopwords.txt,filter(),

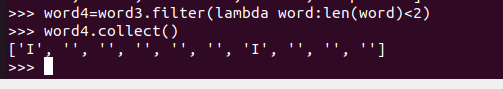

长度小于2的词filter()

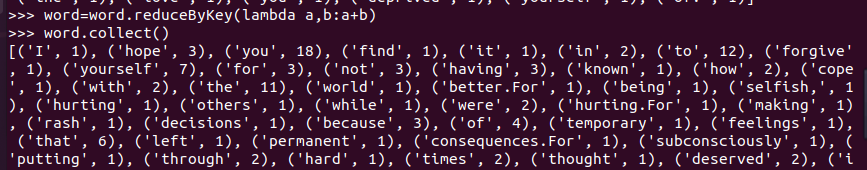

5.统计词频

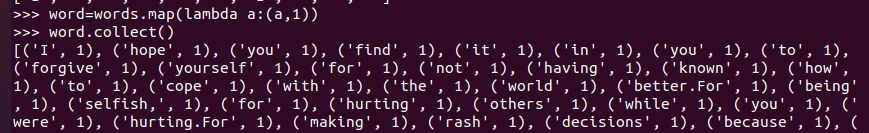

映射成键值对

统计

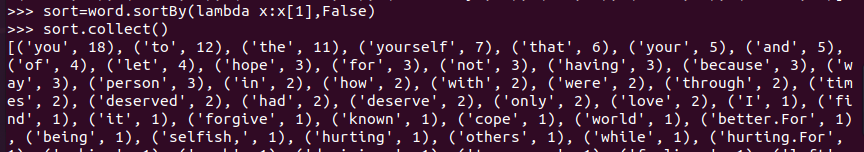

6.按词频排序

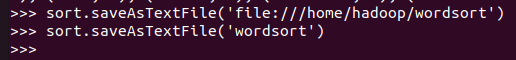

7.输出到文件

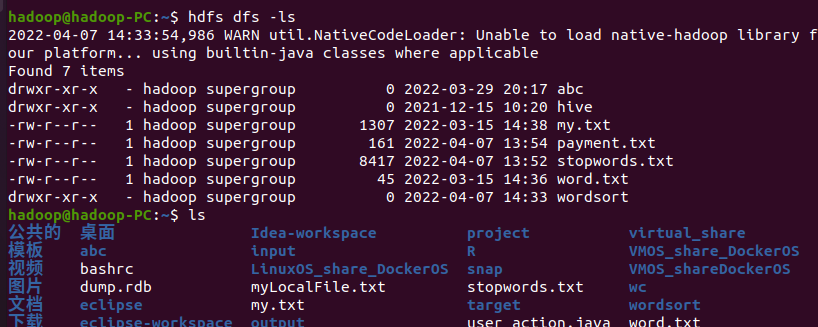

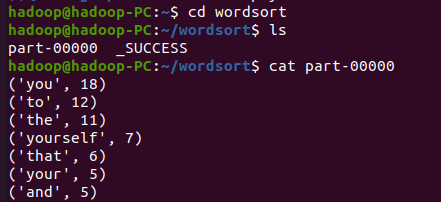

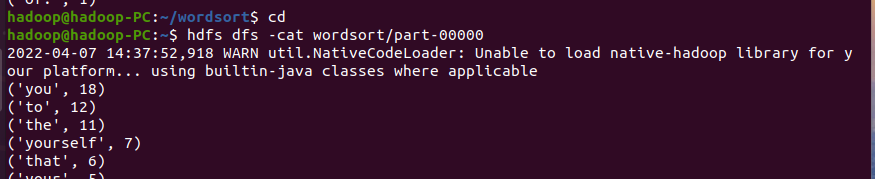

8.查看结果

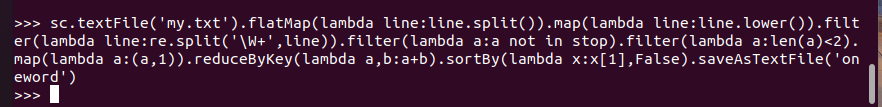

B. 一句话实现:

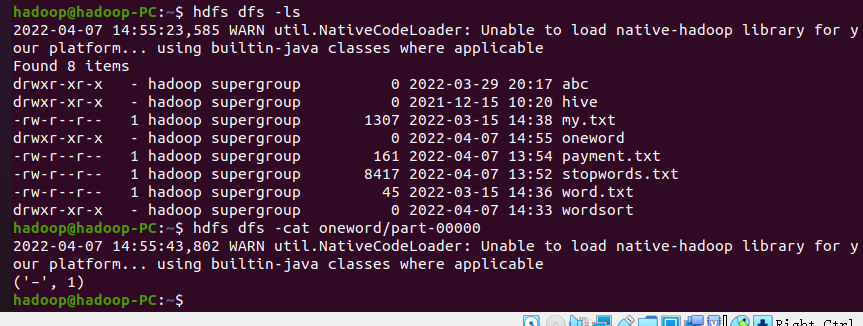

文件入文件出

C. 和作业2的“二、Python编程练习:英文文本的词频统计 ”进行比较,理解并用自己的话说明Spark编程的特点。

spark通过rdd的形式来存入,使用获取数据,python的话是,通过代码函数式编写,对文件进行操作,相对来讲,我个人认为,操作这一类数据时,spark更为简便。

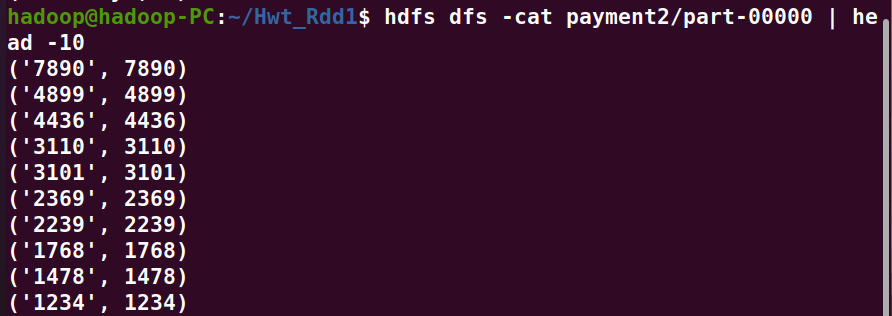

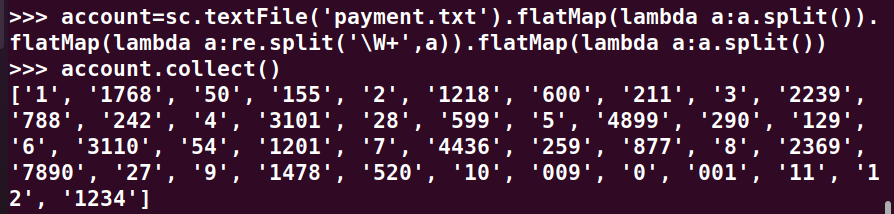

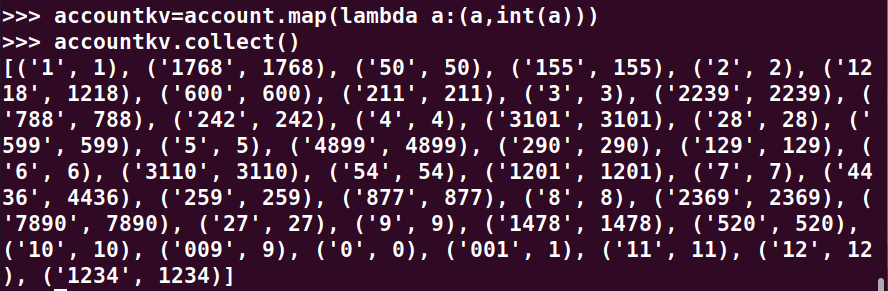

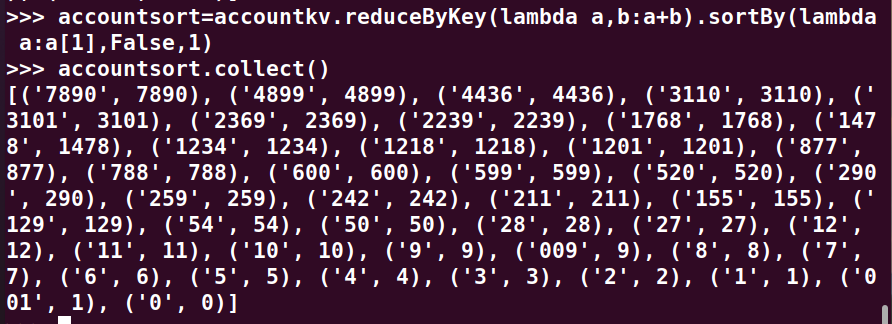

二、求Top值

网盘下载payment.txt文件,通过RDD操作实现选出最大支付额的用户。

1、丢弃不合规范的行:

·空行

·少数据项

·缺失数据

2、按支付金额排序

3、取出Top3