Kubernetes 基础指令

主要介绍如何使用Deployment管理Pod生命周期,实现服务不中断的滚动更新,通过服务发现来实现集群内部的服务间访问

并通过ingress-nginx实现外部使用域名访问集群内部的服务,同时介绍基于EFK如何搭建Kubernetes集群的日志收集系统

纯容器模式的问题?

- 业务容器数量庞大,哪些容器部署在哪些节点,适用了哪些端口,如何记录,管理,需要登录到每台机器上去管理?

- 跨主机通信,多个机器中的容器之间相互调用如何做,iptables规则手动维护?

- 跨主机容器间相互调用,配置如何写?写死固定IP+端口?

- 如何实现业务高可用?多个容器对外提供服务如何实现负载均衡?

- 容器的业务中断了,如何可以感知到,感知到以后,如何自动启动新的容器?

- 如何实现滚动升级保证业务的连续性?

容器调度管理平台

Docker Swarm Mesos Google Kubernetes

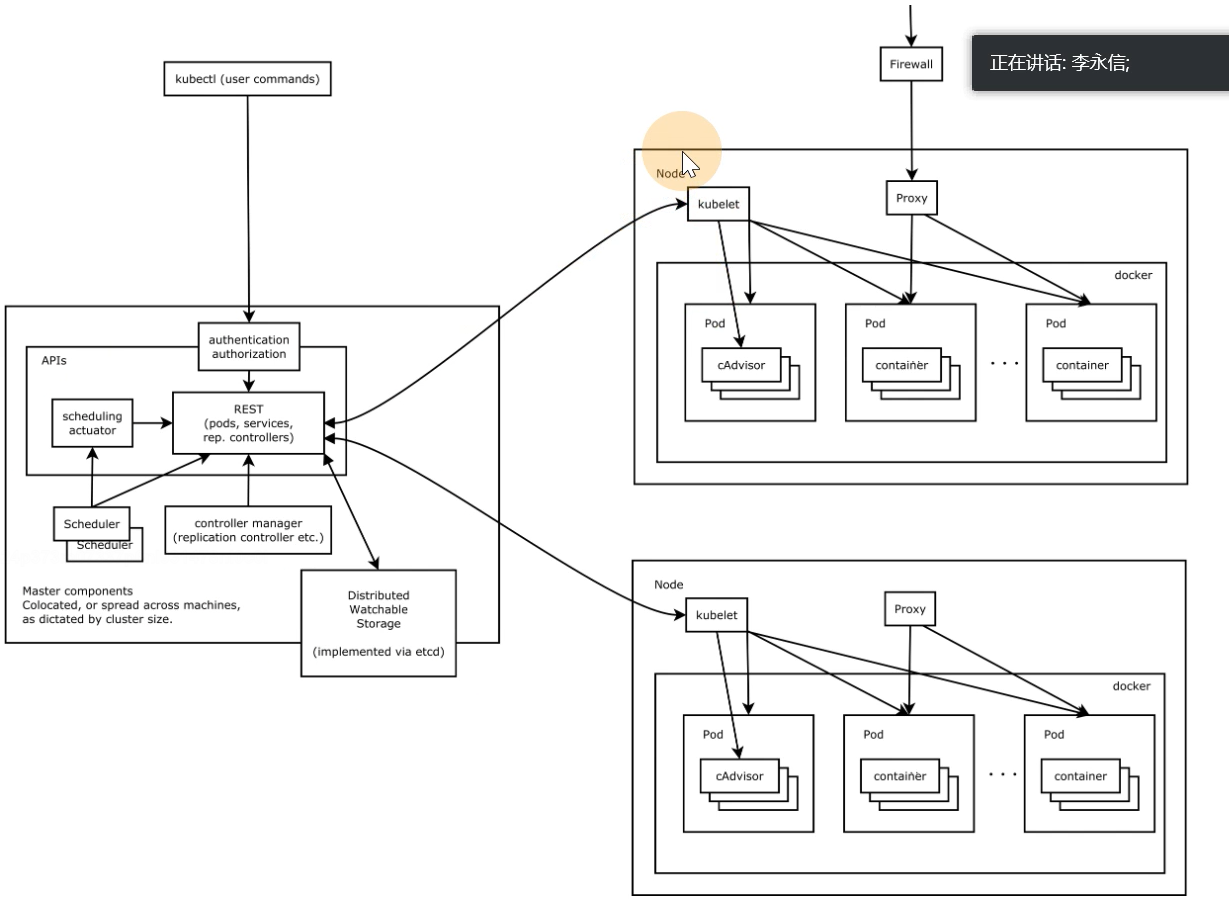

K8S 架构图

核心组件

- ETCD: 分布式高性能键值数据库,存储整个集群的所有元数据

- ApiServer : API服务器,集群资源访问控制入口,提供restAPI及安全访问控制

- Scheduler: 调度器,负责把业务容器调度到最合适的Node节点

- Controller Manager : 控制器管理,确保集群资源按照期望的方式运行

- Replication Controller

- Node controller

- ResourceQuota Controller

- Namespace Controller

...

- Kubelet: 运行在每个节点上的主要的节点代理

pod 管理: kubelet 定期从所监听的数据源获取节点上pod/container 的期望状态(运行什么容器,运行的副本数量,网络或者存储如何配置等等)

并调用对应的容器平台接口达到这个状态

容器健康检查: Kubelet 创建了容器之后还要查看容器是否正常运行,如果容器运行出错,就要根据pod设置的重启策略进行处理

kubectl : 命令行接口,用于对Kubernetes集群运行命令

CNI实现:通用网络接口,使用flannel来作为k8s集群的网络插件,实现跨节点通信

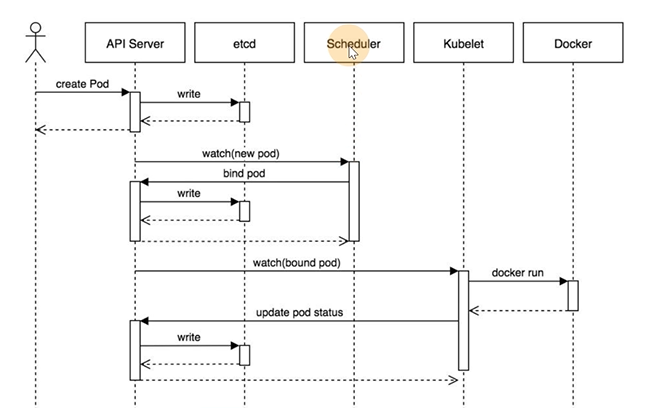

工作流程

- 用户准备一个资源文件(记录了业务应用的名称,镜像地址等信息),通过调用APIServer执行创建Pod

- APIServer收到用户的Pod创建请求,将Pod信息写入到etcd中

- 调度器通过list-watch方式,发现有新的Pod数据,但是这个Pod还没有绑定到某一个节点中

- 调度器通过调度算法,计算出最适合该Pod运行的节点,并调用APIServer,把信息更新到etcd中

- Kubelet同样通过list-watch方式,发现有新的Pod调度到本机的节点了,因此嗲用容器运行时,根据pod的描述信息,拉取镜像,启动容器,同时生成时间信息

- 同时,把容器的信息,事件及状态也通过APIServer 写入到etcd中

集群安装

非高可用版

1. 节点规划

部署k8s集群的节点按照用途可以划分为以下两类角色:

- master:集群的master节点,集群的初始化节点,基础配置不低于2C4G

- slave(node):集群的alave(node)节点,可以多台,基础配置不低于2C4G

为了演示slave节点的添加,会部署一台master + 2台slave 节点规划如下:

2. 组件版本

3. 安装前准备工作

- 设置hosts解析

操作节点:所有节点(k8s-master,k8s-slave)均需执行

核心组件

静态POD的方式:

kubectl -n kube-system get po

systemd服务方式

systemctl status kubelet

python防脱发技巧

浙公网安备 33010602011771号

浙公网安备 33010602011771号