embedding-all-MiniLM-L6-v2

MiniLM 是什么?

MiniLM 是微软研究院开发的一种轻量级的语言模型,旨在以较小的参数量和计算成本实现与大型语言模型(如 BERT)相当的性能。它是基于 Transformer 架构的预训练模型,通过深度自注意力蒸馏(Deep Self-Attention Distillation)等技术进行压缩和优化,使其能够在资源受限的环境下高效运行。

主要特点:

- 轻量级:MiniLM 显著减少了模型的参数量和计算成本,使其能够在移动设备、嵌入式系统等资源受限的环境下运行。

- 高性能:尽管参数量大幅减少,MiniLM 仍然保持了较高的性能,能够在多种自然语言处理(NLP)任务中取得优异的表现。

- 通用性:MiniLM 是一种通用的语言模型,适用于各种 NLP 任务,如文本分类、命名实体识别、问答系统、语言生成等。

- 灵活性:MiniLM 的学生模型(即压缩后的模型)无需与教师模型(即原始的大型模型)在层数或隐藏维度上严格匹配,实现了更高的灵活性。

all-MiniLM-L6-v2 是什么样的模型?

all-MiniLM-L6-v2 是一个小型语言模型,属于 MiniLM 系列,它通过知识蒸馏技术从更大的模型中压缩而来,旨在保持较高性能的同时减少计算资源需求。

all-MiniLM-L6-v2 是一个高效的轻量级语言模型,适合资源有限的环境,能够胜任多种 NLP 任务。

主要特点

- 模型结构:

- 层数:6 层 Transformer。

- 参数量:约 22M,属于轻量级模型。

- 训练方法:

- 知识蒸馏:从更大的模型(如 BERT 或 RoBERTa)中提取知识,保留大部分性能。

- 任务:支持多种 NLP 任务,如文本分类、语义相似度计算等。

- 性能:

- 在多个基准测试中表现良好,尤其在语义相似度和文本分类任务上接近大模型。

- 适合资源有限的环境。

- 应用场景:

- 语义搜索:用于计算文本相似度。

- 文本分类:如情感分析、垃圾邮件检测。

- 问答系统:用于理解问题和检索答案。

- 嵌入式系统:适合部署在计算资源有限的设备上。

优点

- 高效:计算速度快,适合实时应用。

- 轻量:参数量少,易于部署。

- 多功能:适用于多种 NLP 任务。

缺点

- 性能限制:在处理复杂任务时可能不如大模型。

- 知识局限:依赖蒸馏过程,可能丢失部分知识。

all-MiniLM-L6-v2 是基于微软研发的 MiniLM 架构进行微调或进一步开发的句子嵌入模型,而 sentence-transformers 是一个集成了多种预训练句子嵌入模型的库,包括 all-MiniLM-L6-v2。

sentence-transformers 是一个基于 PyTorch 的 Python 库,专门用于处理和生成句子嵌入(sentence embeddings)。它提供了多种预训练的句子嵌入模型,这些模型能够将句子或文本片段转换为固定长度的向量表示,从而方便地进行向量分析、处理和比较.

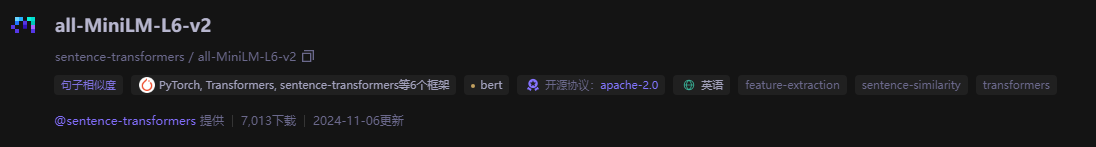

在 Hugging Face 或者 ModelScope 可以找到属于 sentence-transformers 的 all-MiniLM-L6-v2 模型。

使用示例

通过 Hugging Face 的 transformers 库可以加载和使用该模型:

from transformers import AutoModel, AutoTokenizer

model_name = "sentence-transformers/all-MiniLM-L6-v2"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModel.from_pretrained(model_name)

inputs = tokenizer("Hello, world!", return_tensors="pt")

outputs = model(**inputs)

浙公网安备 33010602011771号

浙公网安备 33010602011771号