2-梯度下降

1、理论基础

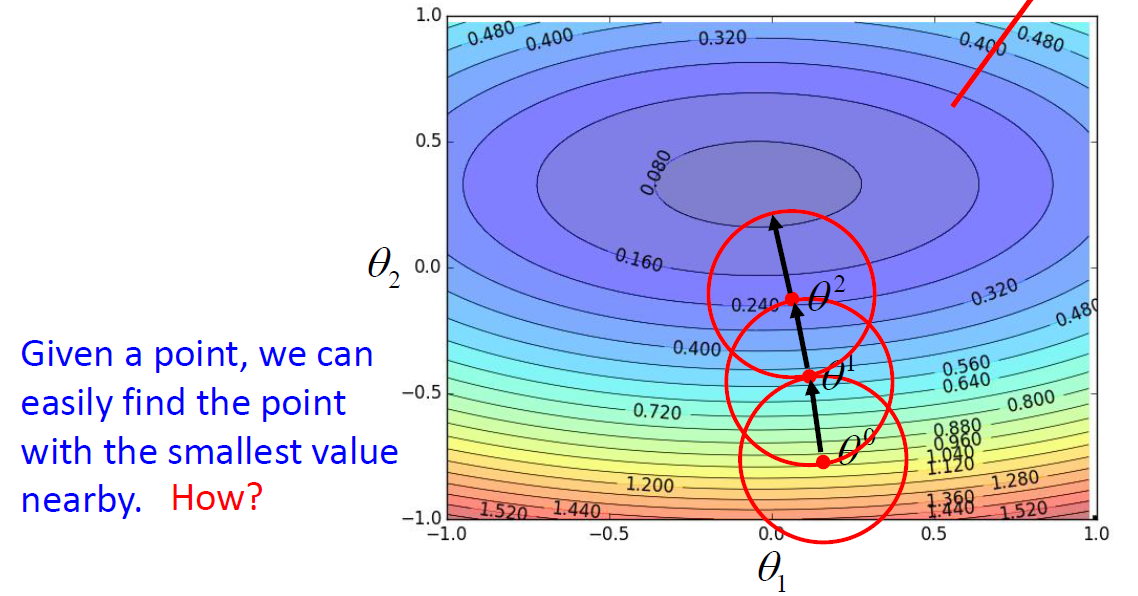

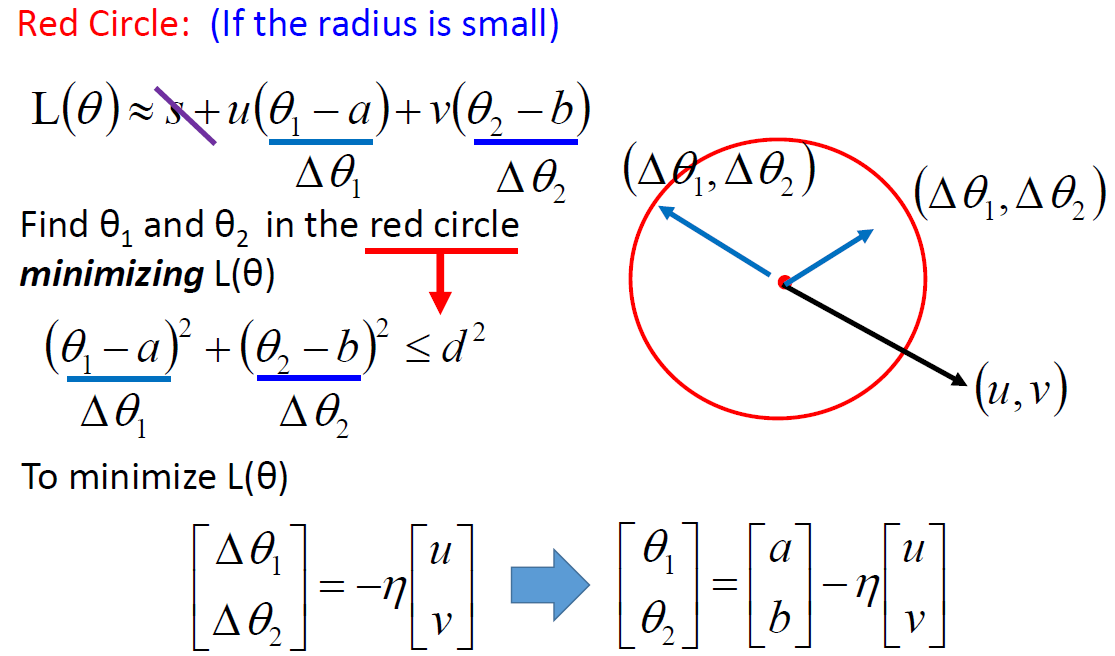

1.1 如下图所示,梯度下降就是找某个点附近使得loss最小值的参数

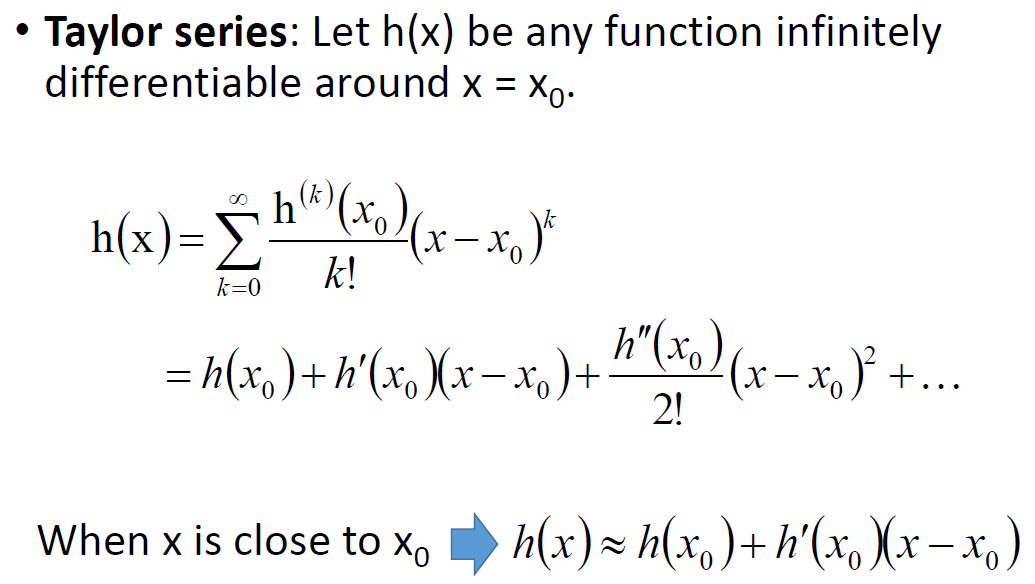

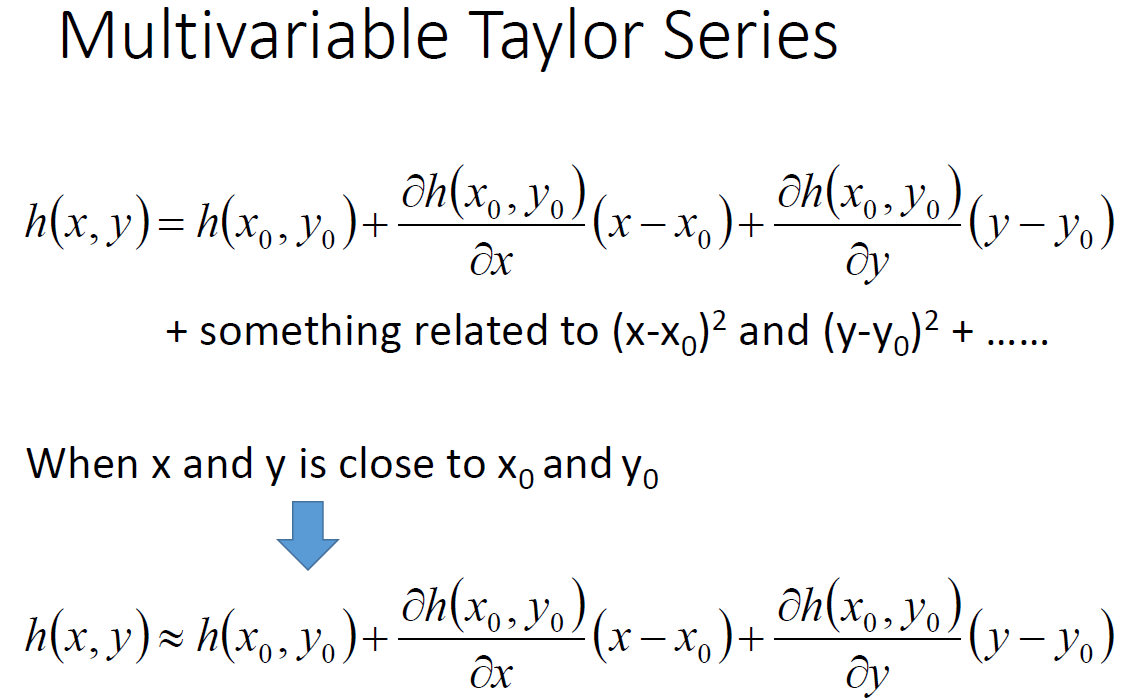

1.2 泰格公式

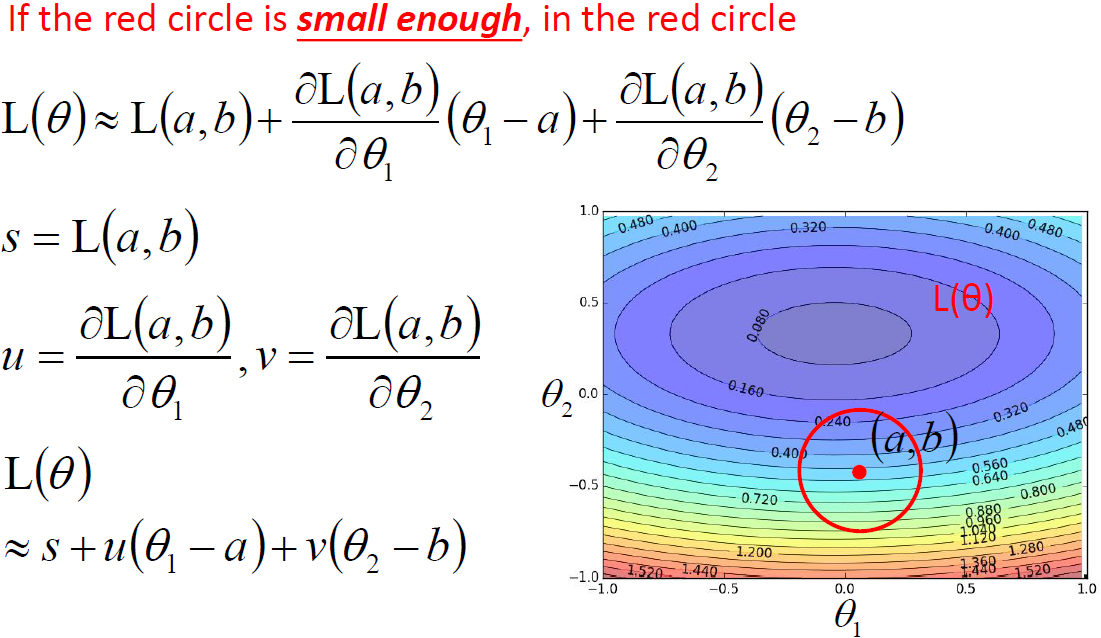

综上:为使Loss最小,应该使 和

和 和u,v的方向相反,值为圆圈半径。即为梯度下降方向

和u,v的方向相反,值为圆圈半径。即为梯度下降方向

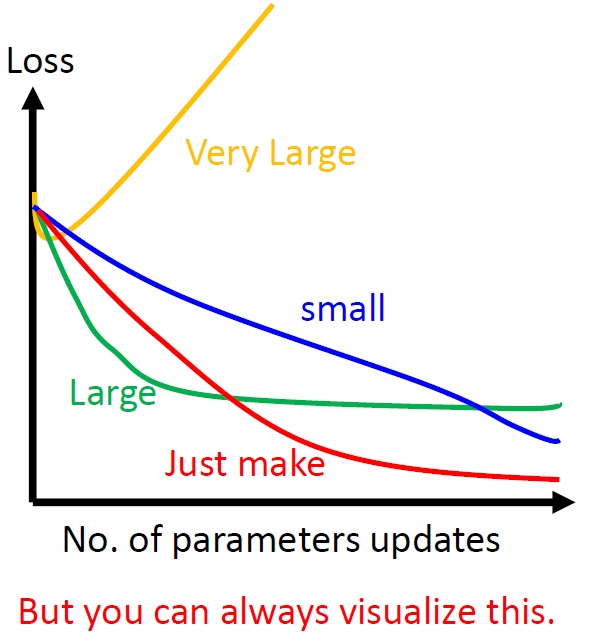

2、使用learning-rate进行梯度下降,调参learning-rate的方式是画出loss的变化图,如下。

当为黄色线,表示learning-rate设置的很大,其他的线详情见下图

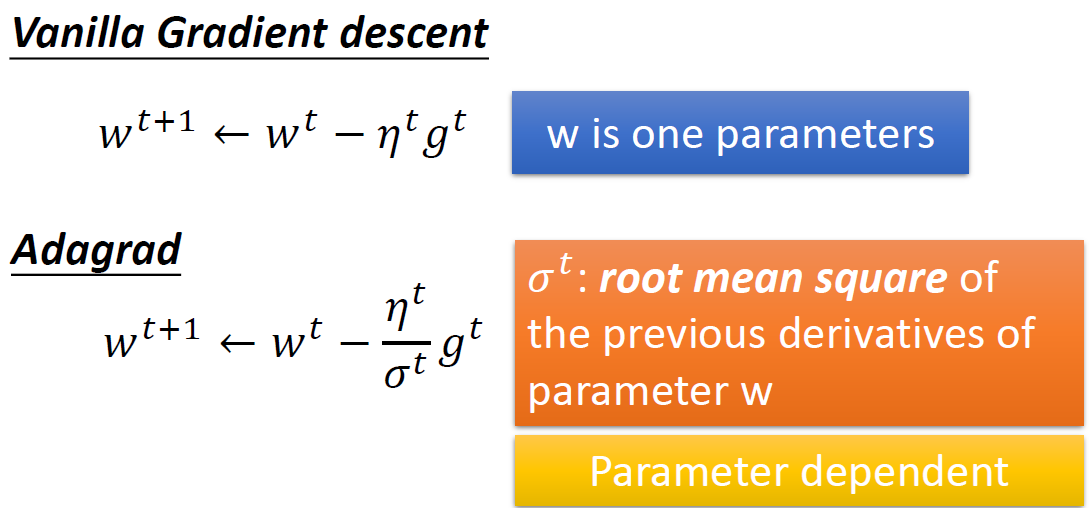

3、自适应设置learning-rate

1、随着训练逐步减小learning-rate,比如![]()

2、不同的参数有不同的learning-rate

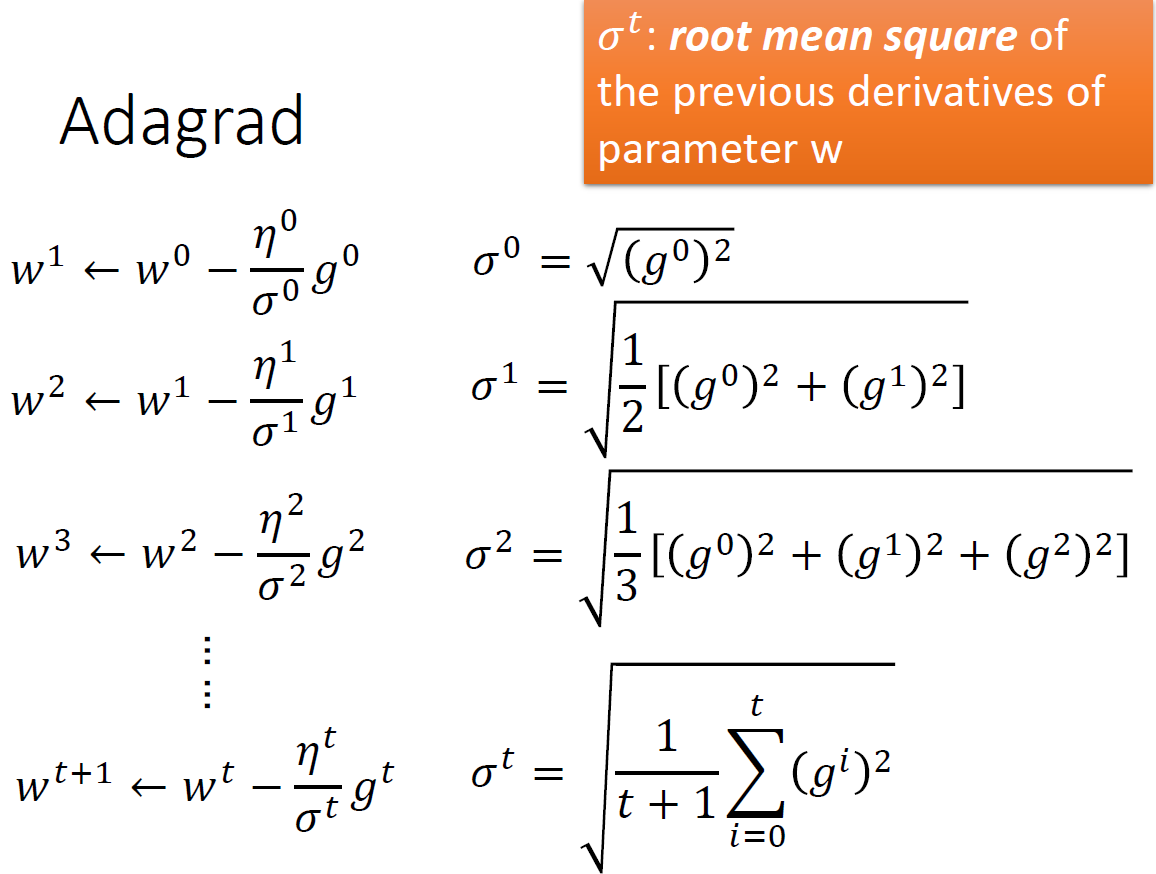

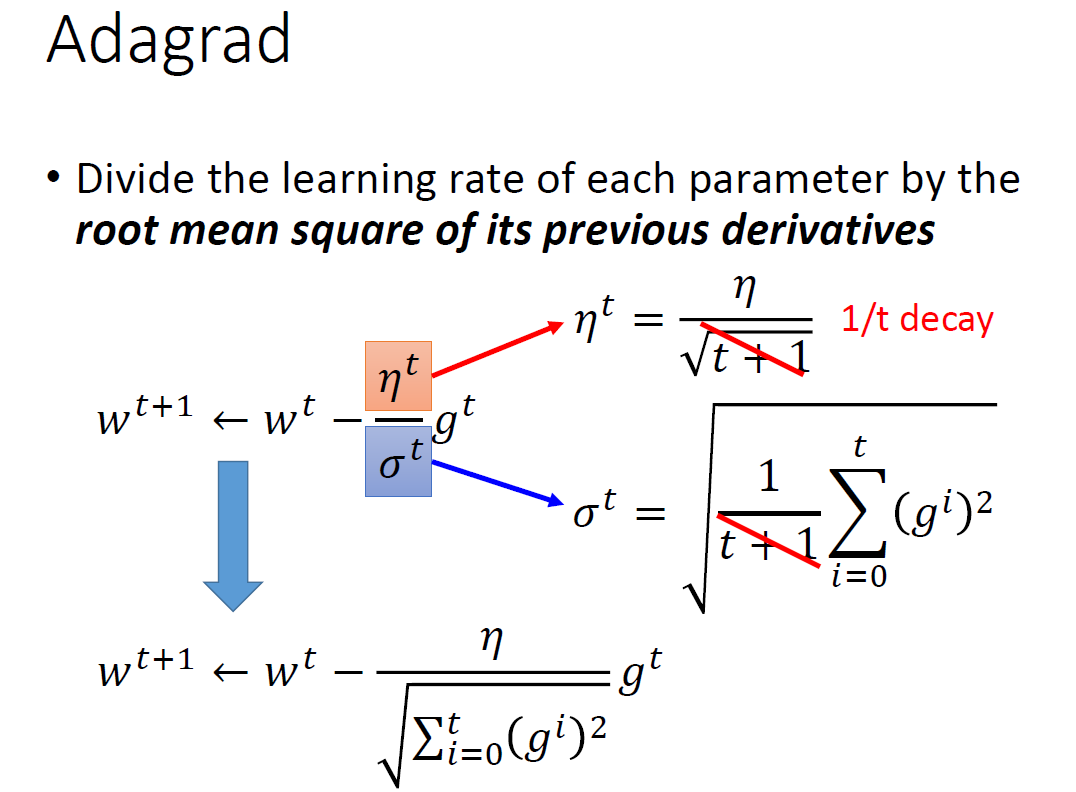

2.1 最简单的Adagrad

理论上 导数越大,参数变化应该越大。Adagrad的learnin-rate的分母部分有(gi)^2,影响了 导数越大,参数变化越大。 该处的解释为强调反差效果

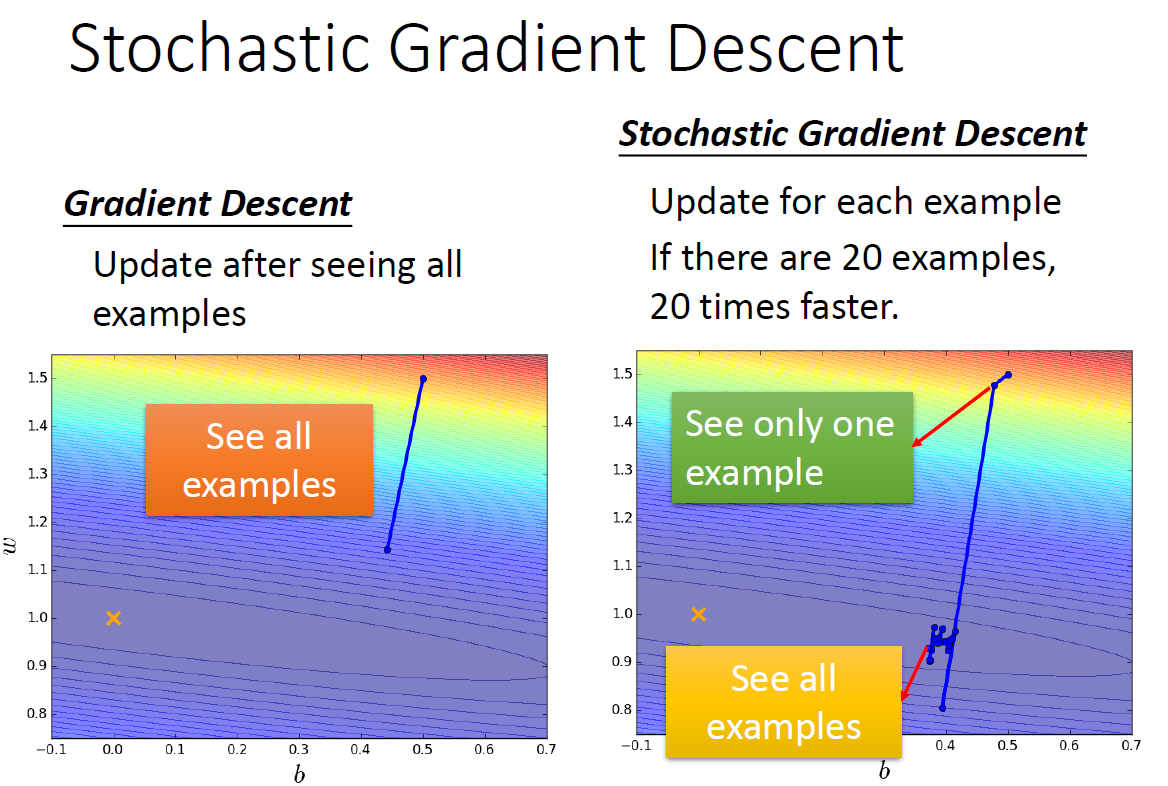

3.随机梯度下降

每次用全量的数据进行梯度下降,为使下降更快,使用随机取某个data计算loss,进行梯度下降

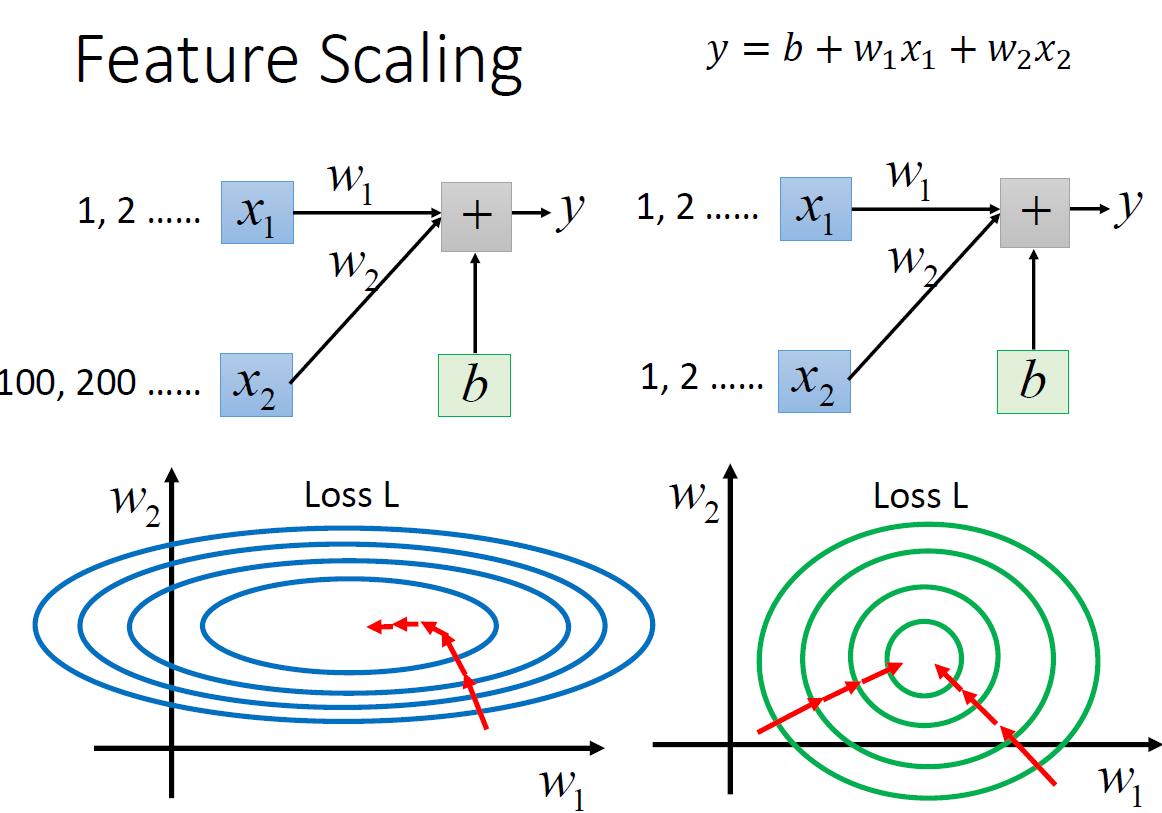

4、参数的归一化;

如下图,有边进行了归一化之后,每次的优化均指向圆心,梯度下降的效率高

4.1 最简单的归一化的方式是 x = (x - u)/标准差 ,这样就把所有的参数都变成 均值为0,方差为1

浙公网安备 33010602011771号

浙公网安备 33010602011771号