寒假学习进度6

二、 Spark集群安装

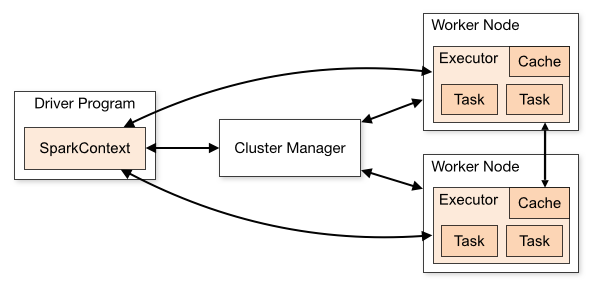

2.1 集群角色

从物理部署层面上来看,Spark主要分为两种类型的节点,Master节点和Worker节点,Master节点主要运行集群管理器的中心化部分,所承载的作用是分配Application到Worker节点,维护Worker节点,Driver,Application的状态。Worker节点负责具体的业务运行。

从Spark程序运行的层面来看,Spark主要分为驱动器节点和执行器节点。

2.2 机器准备

准备两台以上Linux服务器,安装好JDK1.8

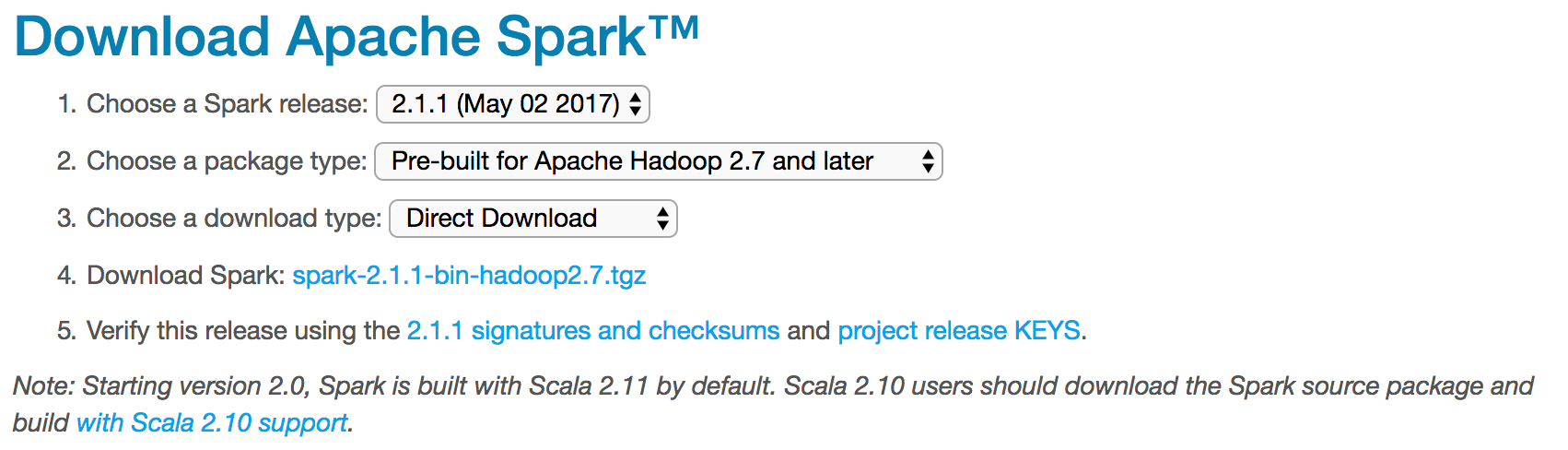

2.3 下载Spark安装包

上传解压安装包

上传spark-2.1.1-bin-hadoop2.7.tgz安装包到Linux上

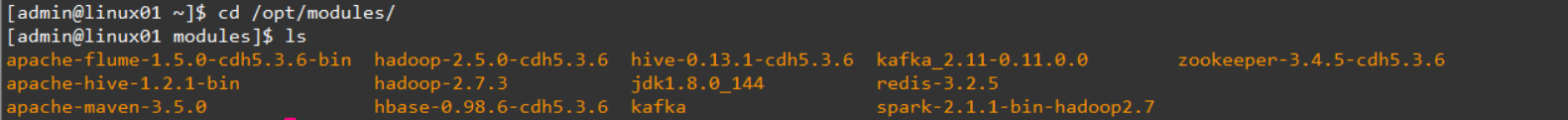

解压安装包到指定位置

tar -xf spark-2.1.1-bin-hadoop2.7.tgz -C /opt/modules

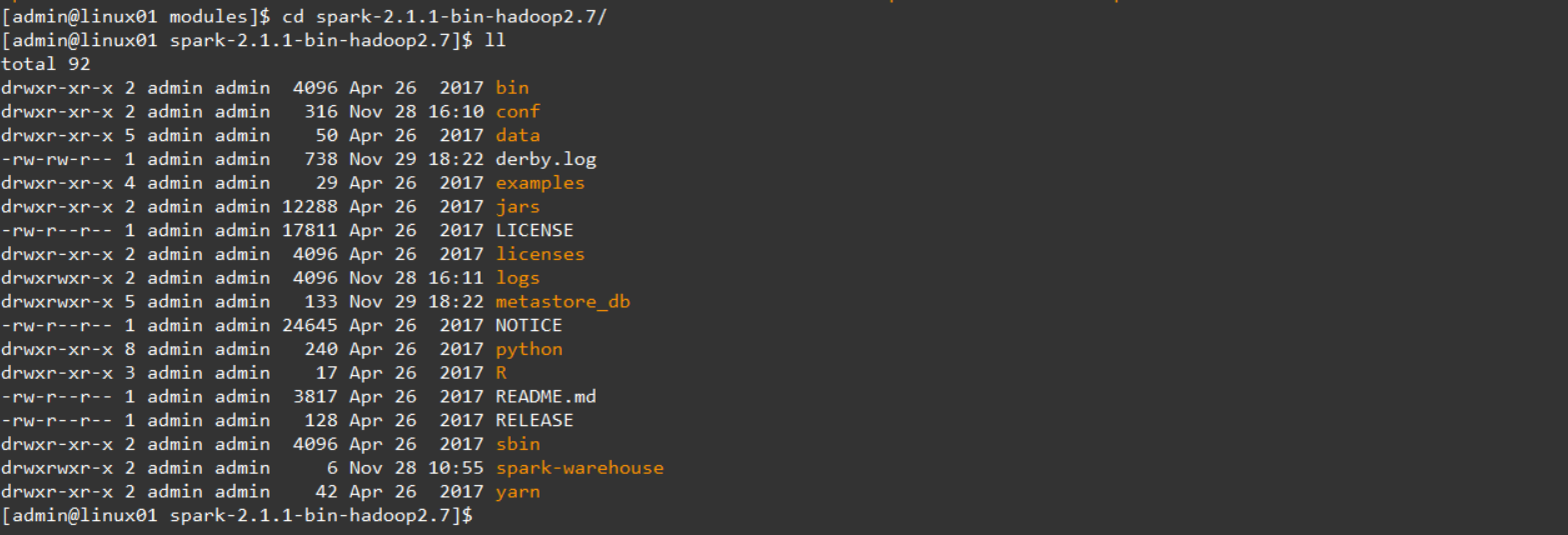

2.4 配置Spark【Standalone】

Spark的部署模式有Local、Local-Cluster、Standalone、Yarn、Mesos,我们选择最具代表性的Standalone集群部署模式。

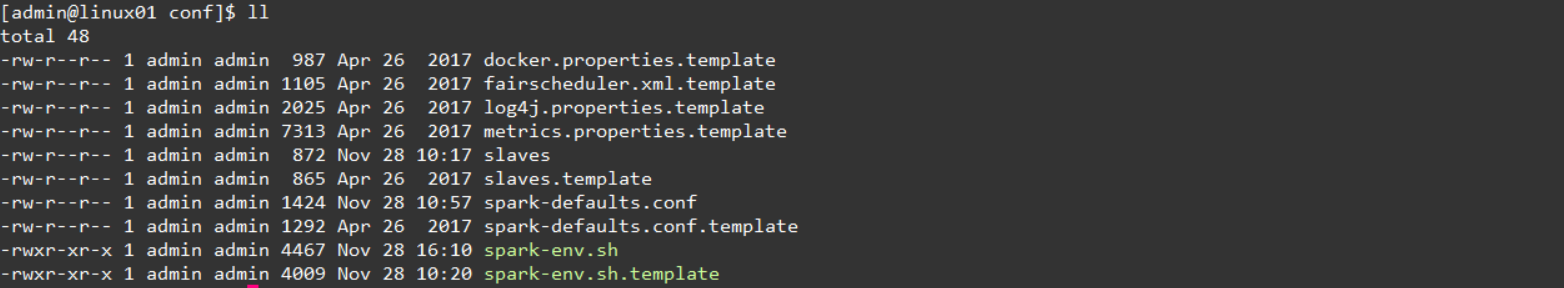

进入到Spark安装目录

cd /home/bigdata/hadoop/spark-2.1.1-bin-hadoop2.7/conf

将slaves.template复制为slaves

将spark-env.sh.template复制为spark-env.sh

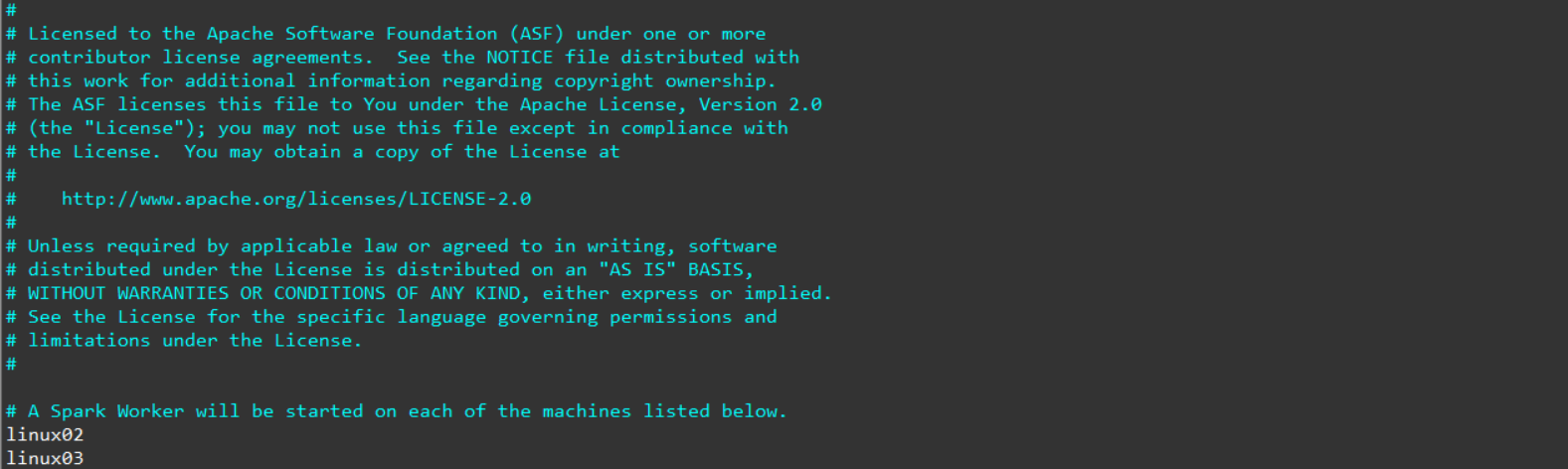

修改slave文件,将work的hostname输入:

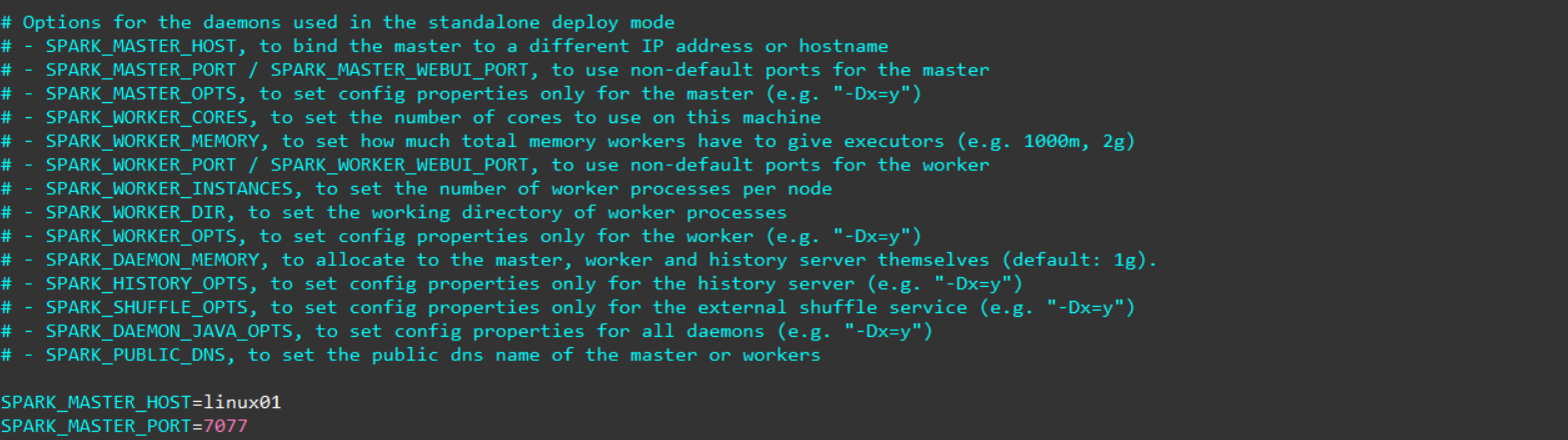

修改spark-env.sh文件,添加如下配置:

将配置好的Spark文件拷贝到其他节点上

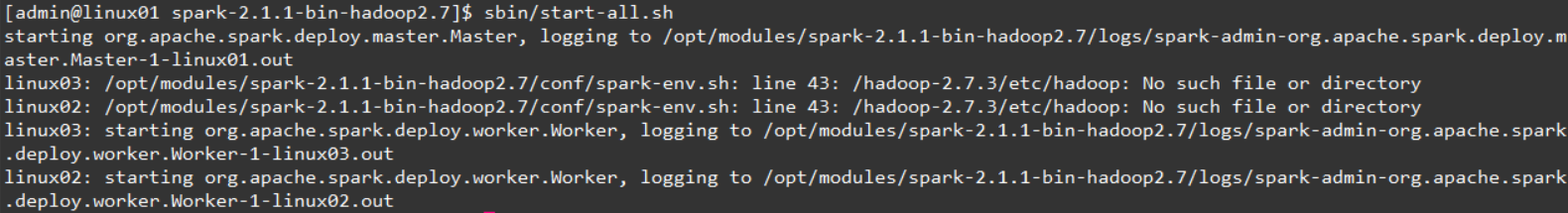

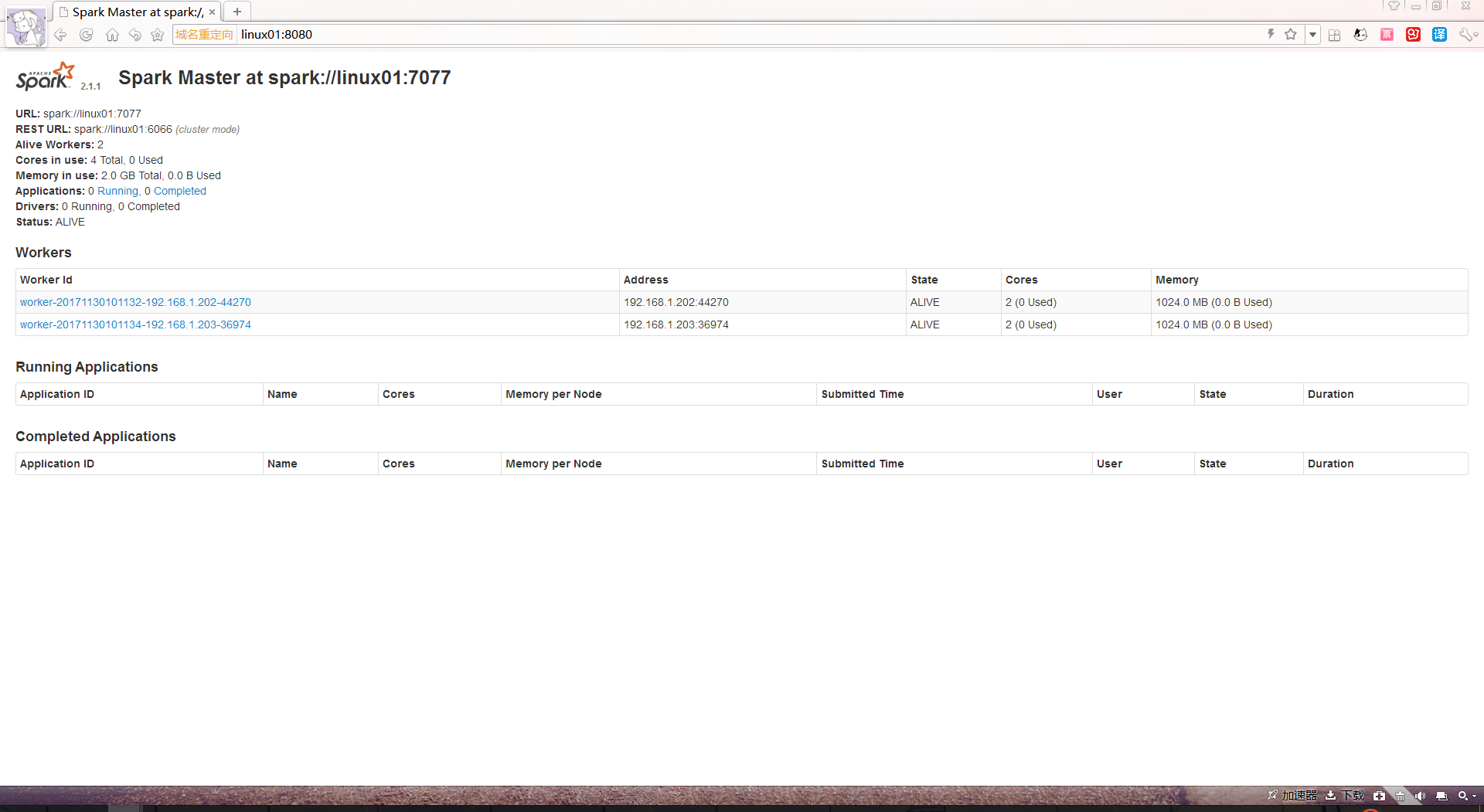

Spark集群配置完毕,目前是1个Master,2个Work,linux01上启动Spark集群

/opt/modules/spark-2.1.1-bin-hadoop2.7/sbin/start-all.sh

启动后执行jps命令,主节点上有Master进程,其他子节点上有Work进行,登录Spark管理界面查看集群状态(主节点):http://linux01:8080/

到此为止,Spark集群安装完毕.

注意:如果遇到 “JAVA_HOME not set” 异常,可以在sbin目录下的spark-config.sh 文件中加入如下配置:

export JAVA_HOME=XXXX

浙公网安备 33010602011771号

浙公网安备 33010602011771号