第一节:langchain调用本地ollama

1. 安装Ollama

在Mac上安装Ollama有两种方式,推荐使用Homebrew方式:

使用Homebrew安装(推荐)

如果您还没有安装Homebrew,先安装Homebrew:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

然后使用brew安装Ollama:

brew install ollama

启动Ollama服务

安装完成后,启动Ollama服务:

brew services start ollama

2. 下载并运行Llama3.2模型

下载Llama3.2模型

Ollama支持多种版本的Llama模型。要下载Llama3.2,可以使用以下命令:

# 下载默认版本的Llama3.2(通常是3b版本) ollama pull llama3.2 # 或者指定具体版本 ollama pull llama3.2:3b # 如果需要更大参数版本(需要更多内存) ollama pull llama3.2:7b

运行Llama3.2模型

下载完成后,可以通过以下方式与模型交互:

# 运行Llama3.2模型 ollama run llama3.2 # 或者指定具体版本 ollama run llama3.2:3b

安装golangchian 包

go get github.com/tmc/langchaingo

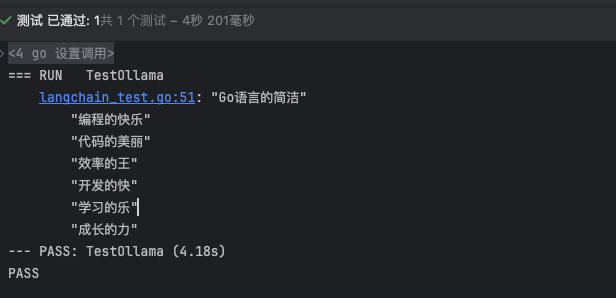

使用golangchian

func getLLmOpenaiClient(t *testing.T) *ollama.LLM { llm, err := ollama.New( ollama.WithModel("llama3.2"), // 指定使用的模型 ) if err != nil { log.Fatal(err) } return llm } func TestOllama(t *testing.T) { // 创建一个 LLM 模型对象 llm := getLLmOpenaiClient(t) prompt, err := llms.GenerateFromSinglePrompt(context.Background(), llm, "帮我写首绝句!关于go语言的") if err != nil { log.Fatal(err) } t.Log(prompt) }

浙公网安备 33010602011771号

浙公网安备 33010602011771号