spark,hadoop集群安装注意

安装步骤严格参看厦门大学数据实验室教程

Spark 2.0分布式集群环境搭建(Python版)

安装Hadoop并搭建好Hadoop集群环境

遇到的问题

1.ubuntu 安装后升级。python是3.6版本的。但是spark不支持3.6版本

伪分布式和分布式都遇到这个问题:

报如下问题

namedtuple() missing 3 required keyword-only arguments: 'verbose', 'rename',

解决办法

vim hadoop@master:/usr/local/spark/conf$ vim spark-env.sh 追加下面代码

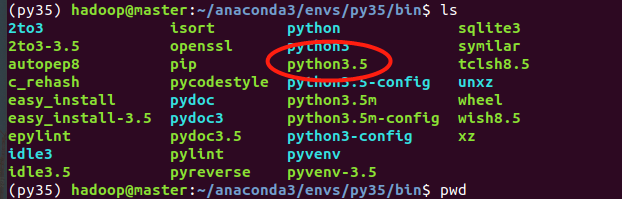

(通过激活对应的anaconda环境,查看$PATH ,进入目录寻找对应路径)

export PYSPARK_DRIVER_PYTHON=/home/hadoop/anaconda3/envs/py35/bin/python3.5

export PYSPARK_PYTHON=/home/hadoop/anaconda3/envs/py35/bin/python3.5

之后就ok了

2.安装时遇到java拒绝连接

检查 core-site.xml hdfs-site.xml mapred-site.xml yarn-site.xml 这个几个配置文件(伪分布式时也配置了这些,配置参数不同,容易搞错)

浙公网安备 33010602011771号

浙公网安备 33010602011771号