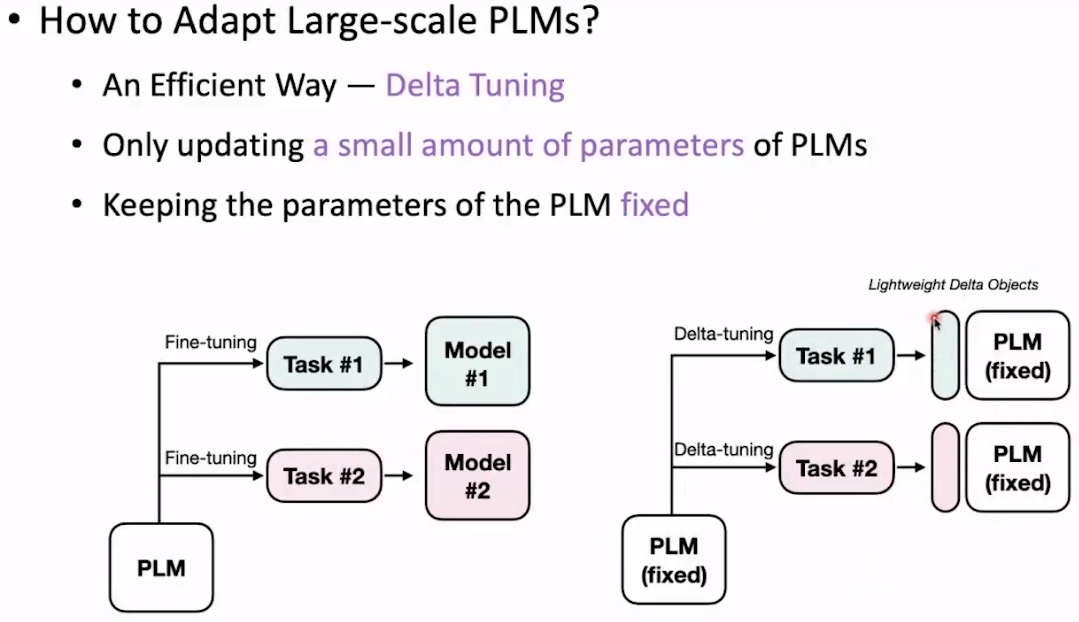

Delta Tuning 清华大模型课程

微调一小部分参数 、

首先要明确为什么这种参数高效的微调是work的?

在过去是不可能实现的。过去神经网络初始化都是随机的。有了预训练,有了通用只是,更多是对特定领域任务的一个激发。

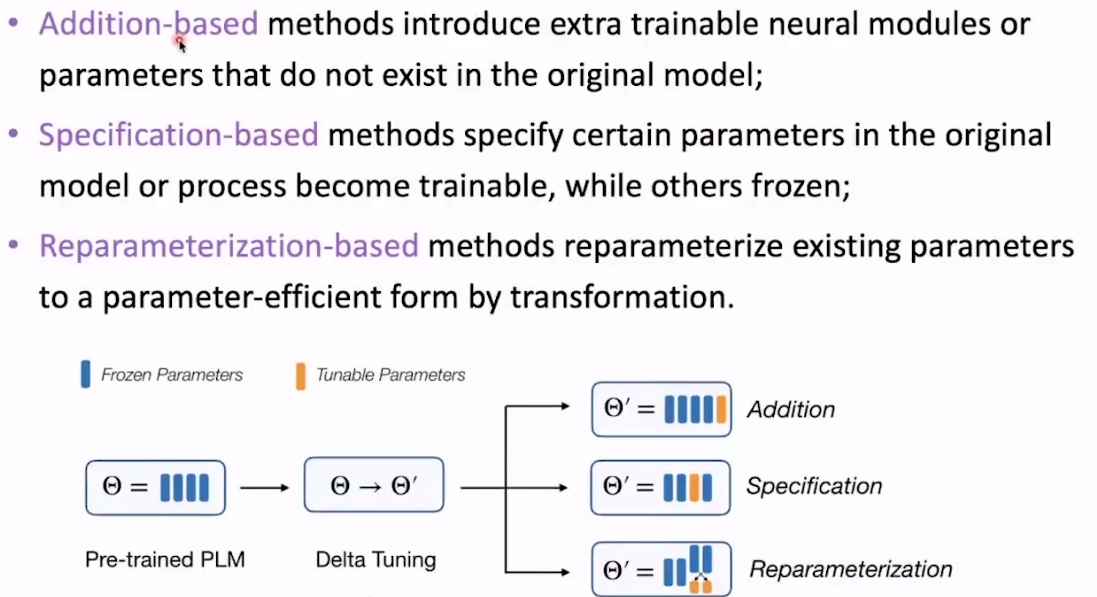

Delta Tuning包含三种方式

1.addition-based增量式的。本来模型中不存在的参数 额外加进来 之训练这种

2.指定某些参数可变

3.重参数化式。

视频51

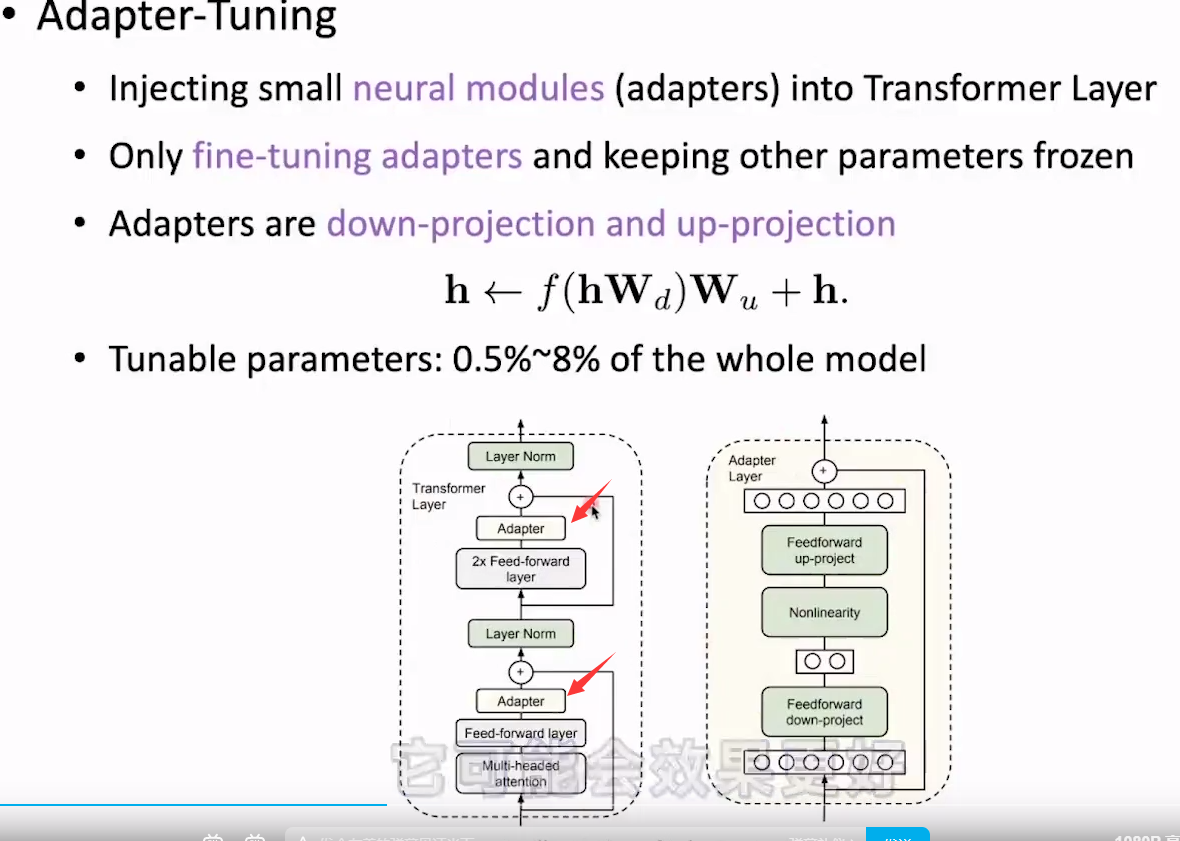

增量式tuning

首先讲一下adapter,这是个比较早的工作 是BERT提出后不久就发表了。那时候不重视,因为BERT不算大。

做法很简单 就是一个简单的MLP 双 层的神经网络。达到和全参数微调差不多的效果。

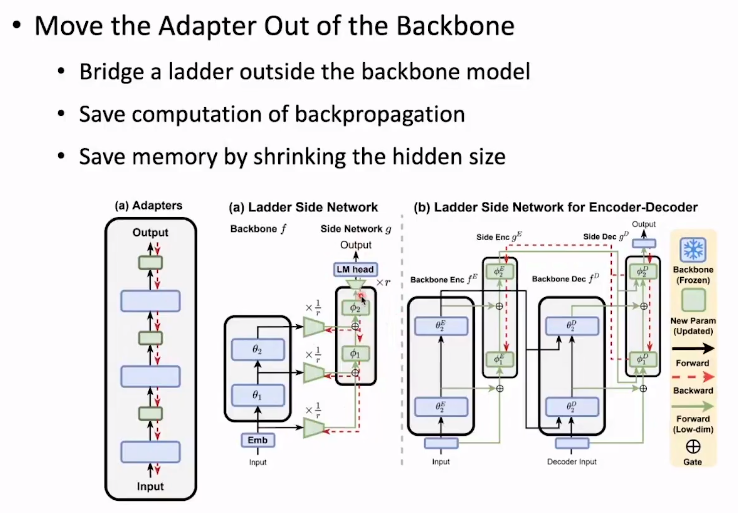

另一个做法是将adapter放到架构外边

这样做有两个好处:

1.不需要沿着模型的主干网络去优化。只需要adapter 省去了很多计算。

2.先降维 既减少了计算又减少了显存

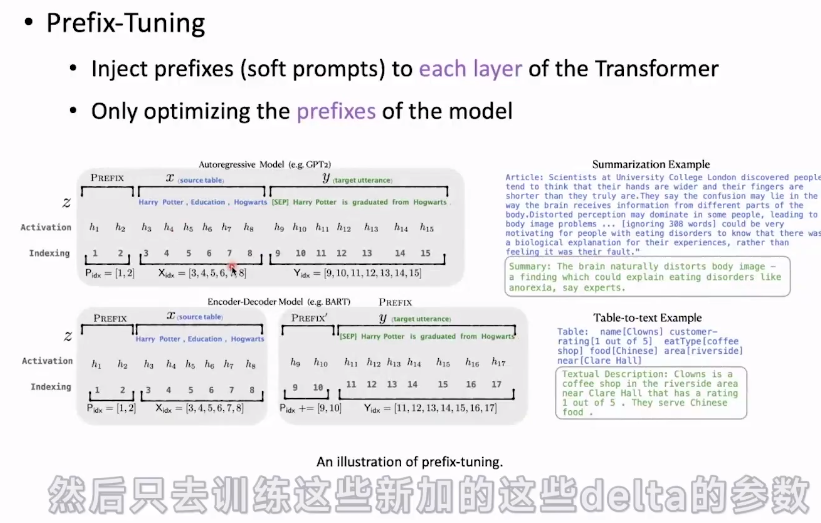

prefix-tuning是怎么做的呢?

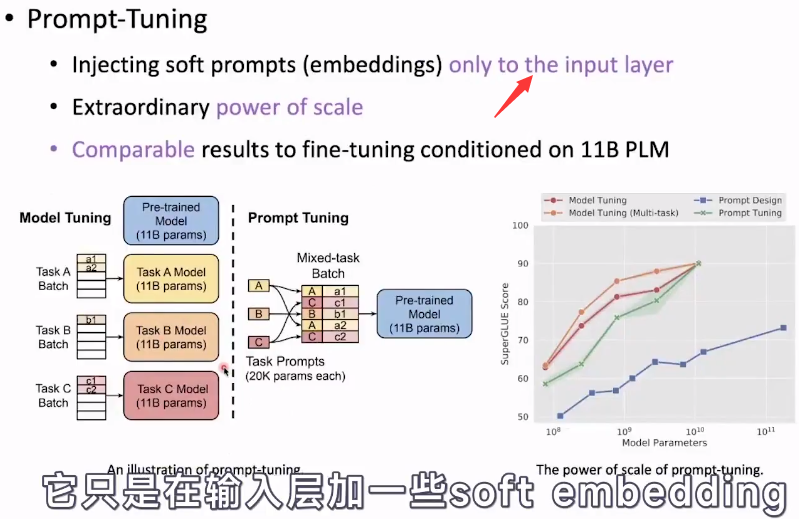

Prompt-Tuning

效果可能没有Prefix-tuning在每一层添加那么好。

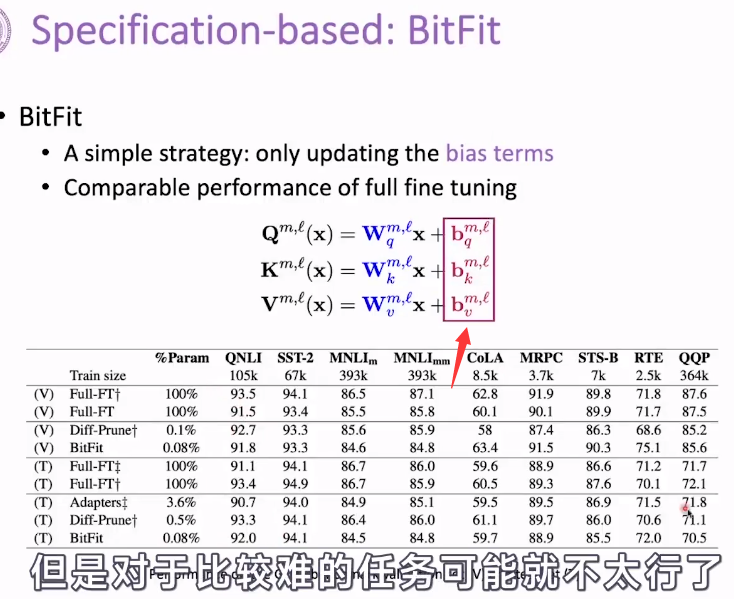

指定式tuning

这里只介绍specification这一种方法 。这种方法只是对偏置的微调

重新参数化tuning

这里讲的两种方法不太懂啊。。

此处统一框架不太懂啊

总结

在超大模型上很有效果

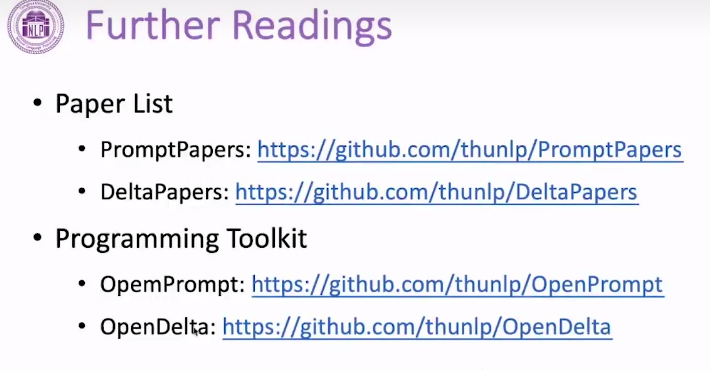

关于这两个方向的论文:

浙公网安备 33010602011771号

浙公网安备 33010602011771号