SGDR: Stochastic Gradient Descent with Warm Restarts

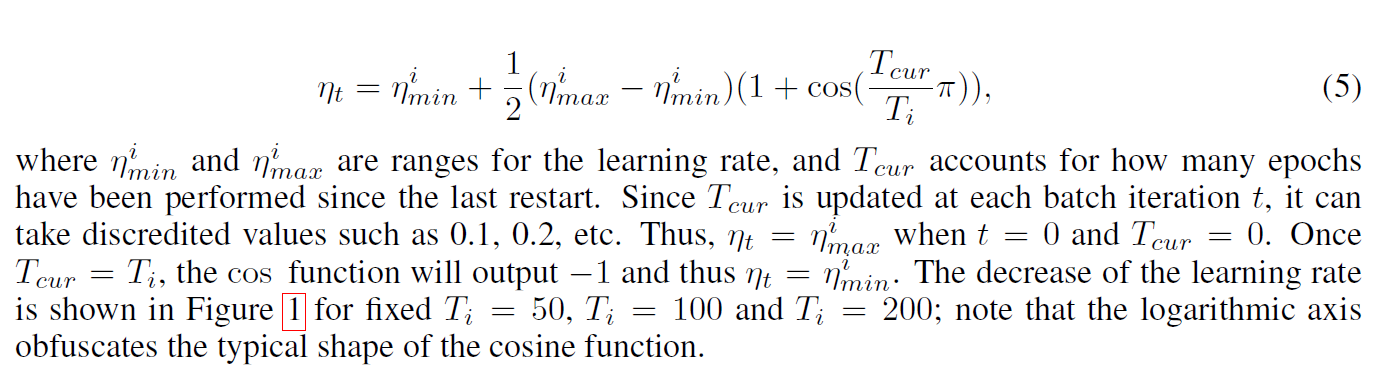

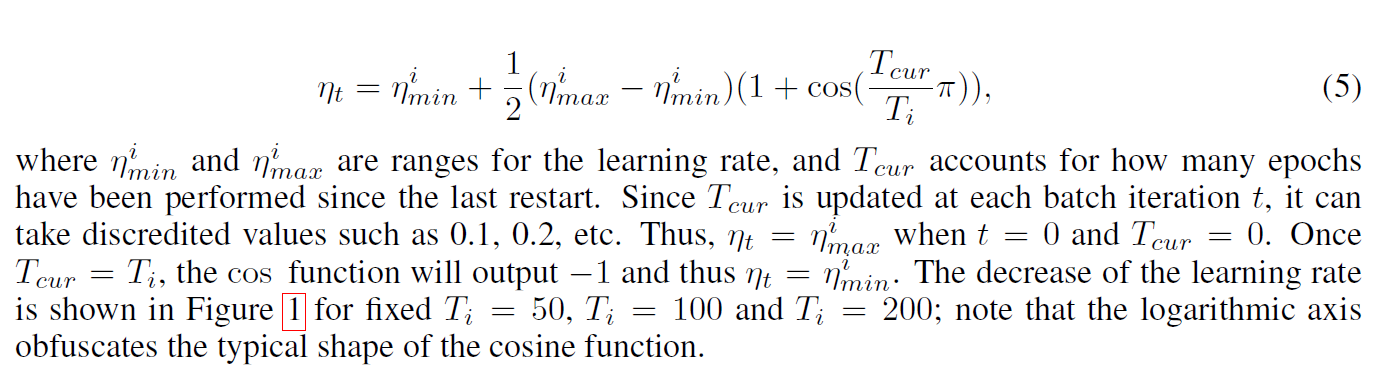

SGDR和CLR比较类似,都是给学习率设置周期和变化范围,按照下面的公式让学习率周期性的变化:

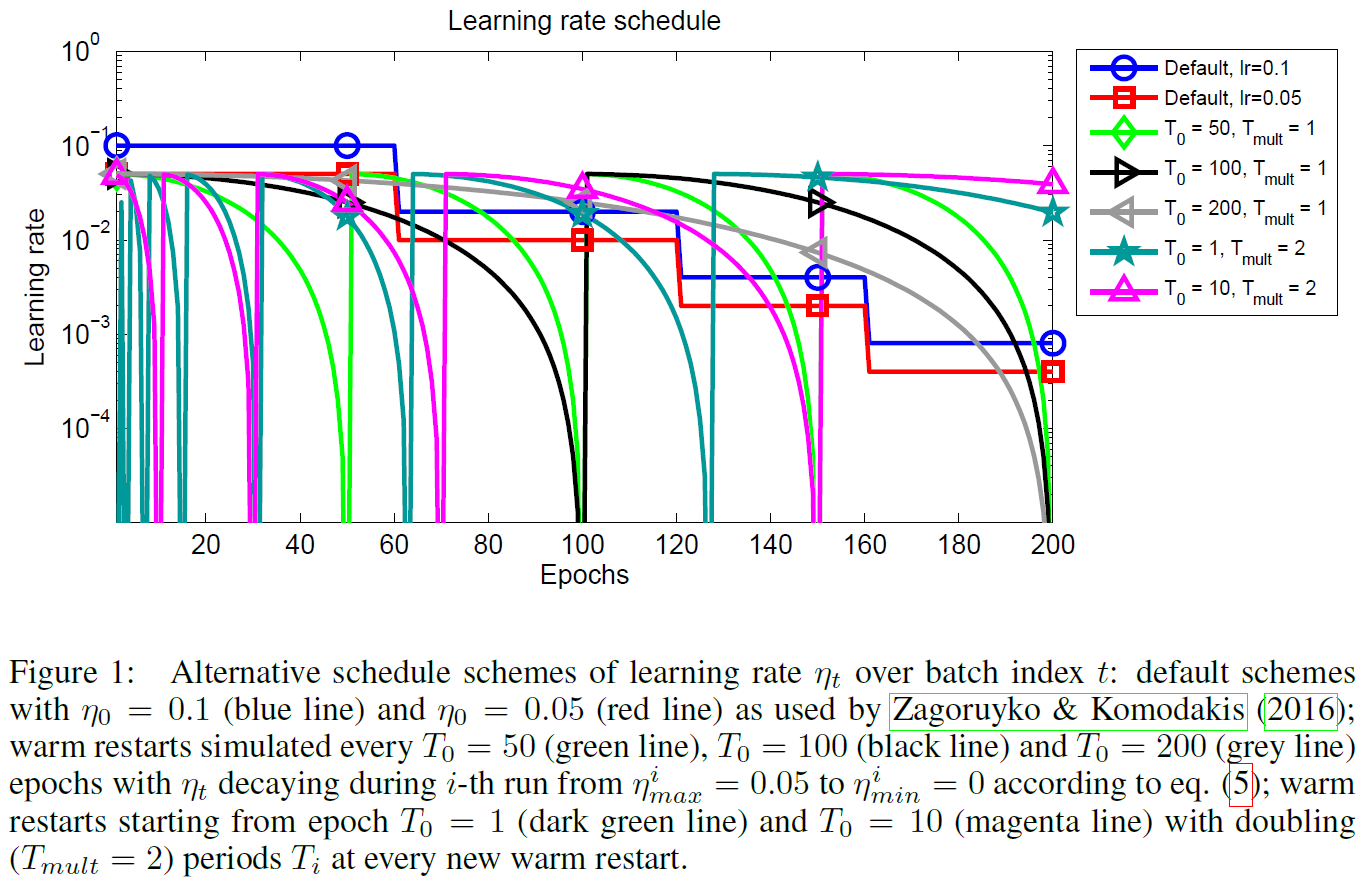

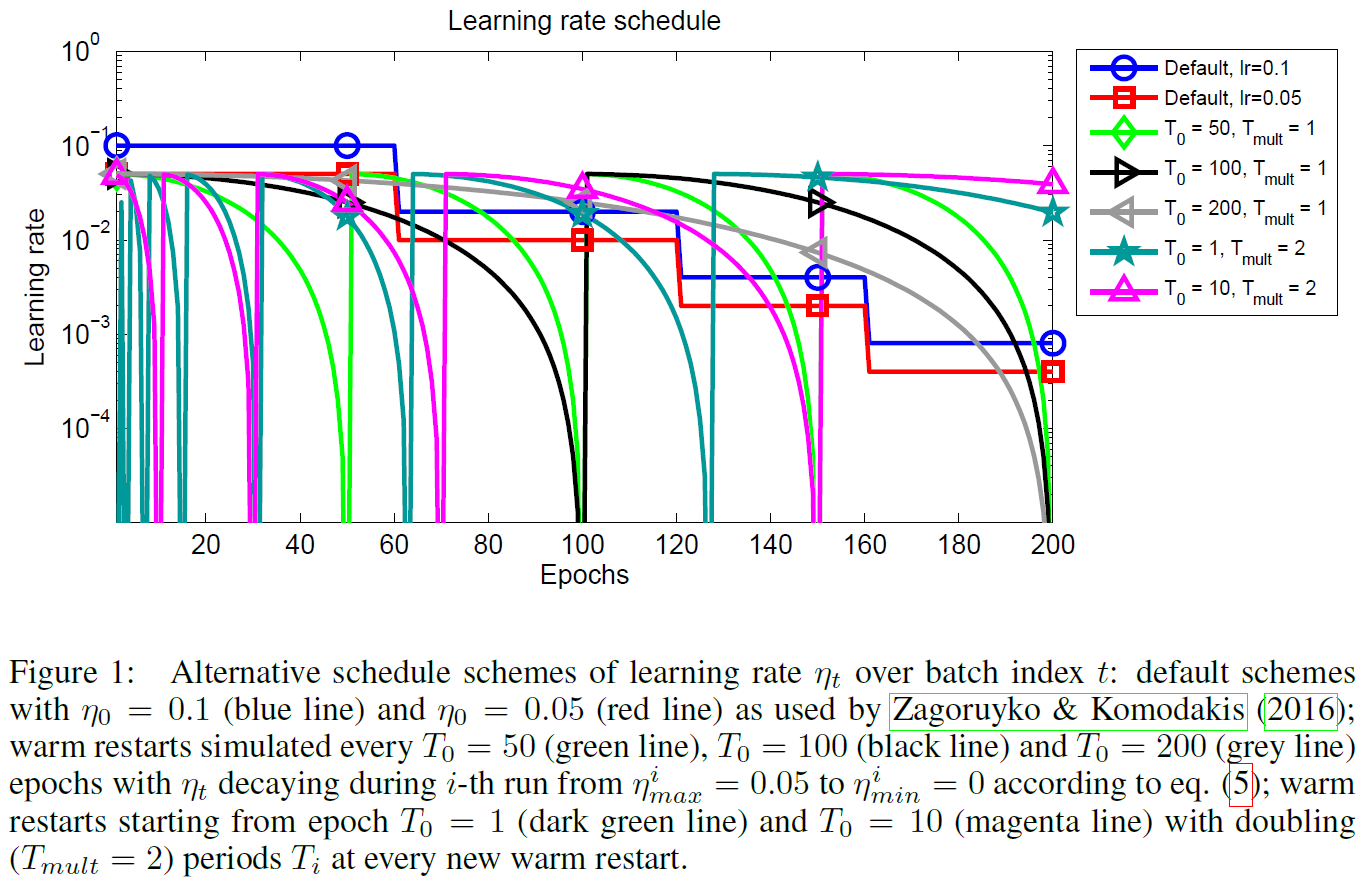

总的来说,就是在一个周期开始时,将学习率设置为最大值,然后按照余弦函数减小到最小值,再开始下一个周期的循环.尝试了各种超参数的设置.

SGDR和CLR比较类似,都是给学习率设置周期和变化范围,按照下面的公式让学习率周期性的变化:

总的来说,就是在一个周期开始时,将学习率设置为最大值,然后按照余弦函数减小到最小值,再开始下一个周期的循环.尝试了各种超参数的设置.