全网最简单DeepSeek-R1本地部署教程

1.安装ollama

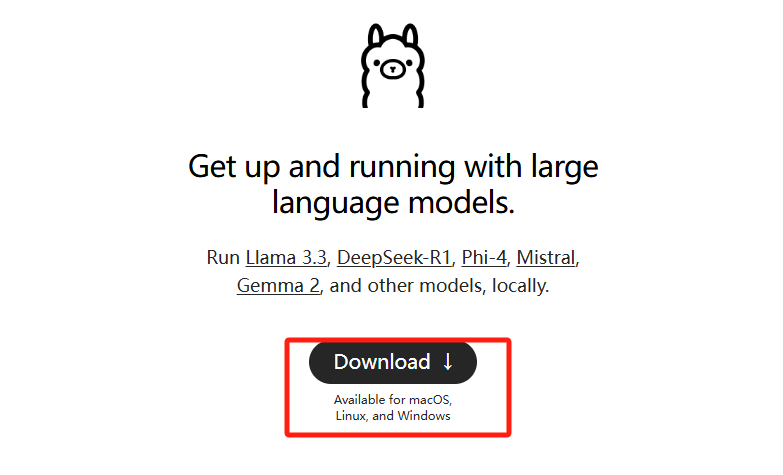

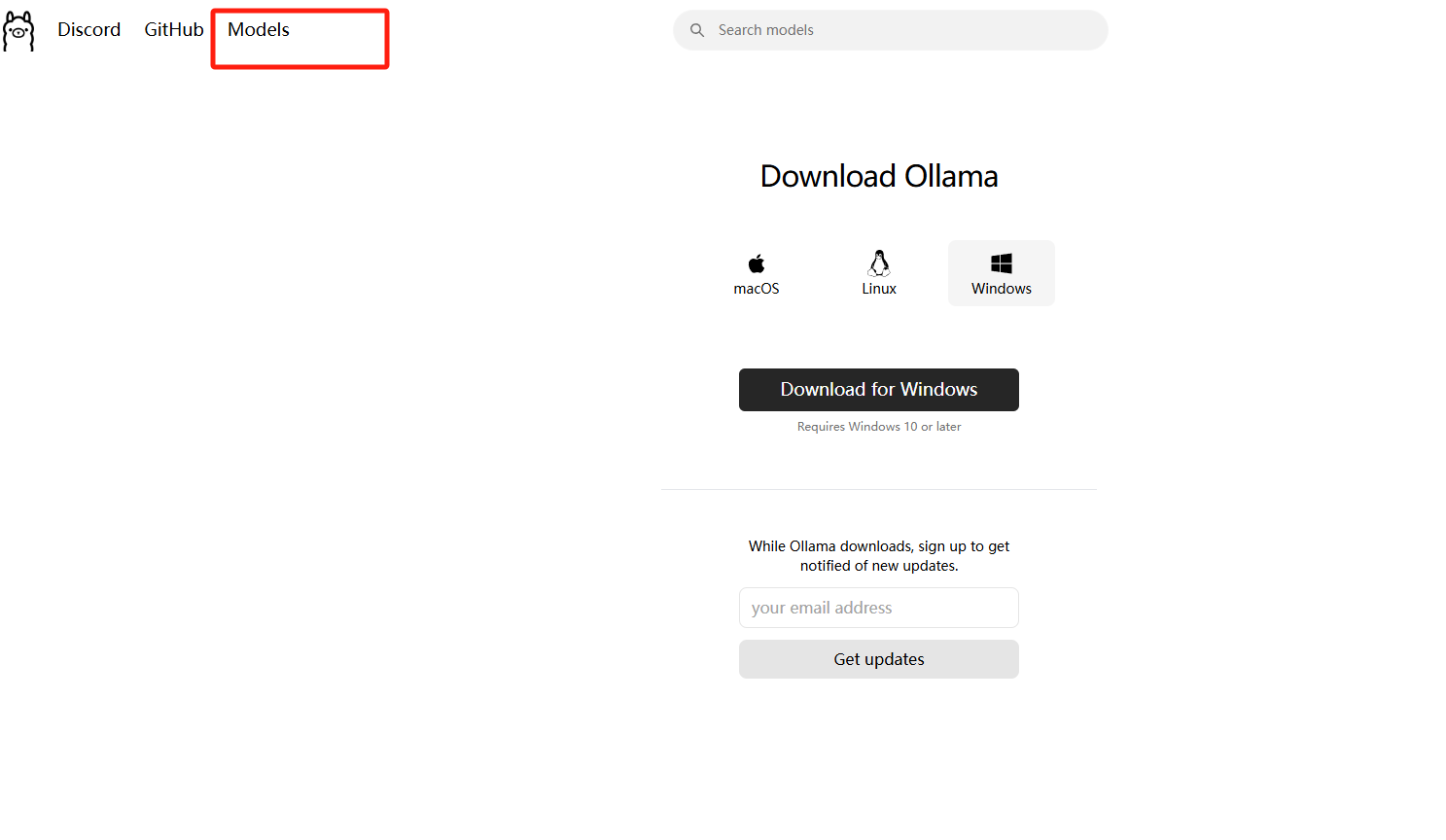

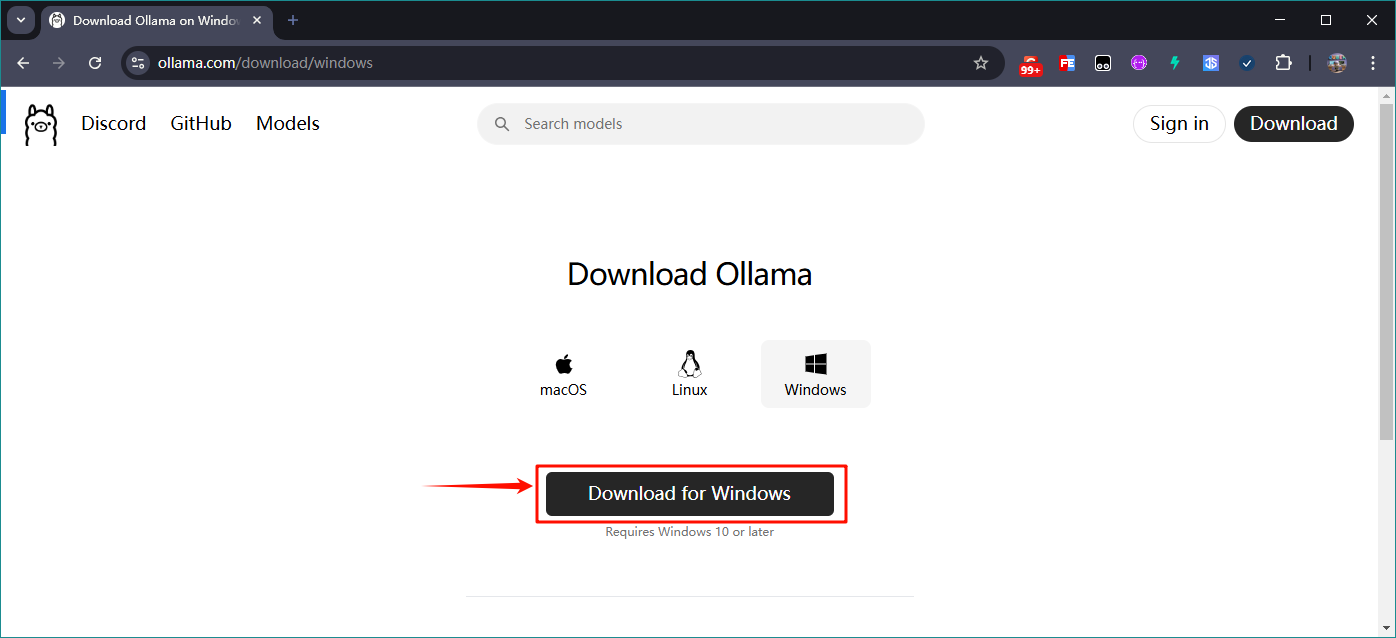

打开ollama网址:https://ollama.com/

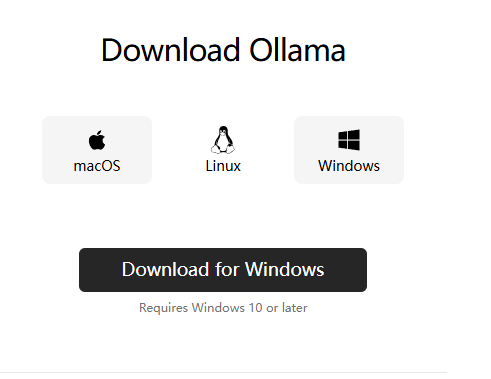

选择你电脑的系统进行下载

我的电脑是windows的就点击windows然后点击下载即可

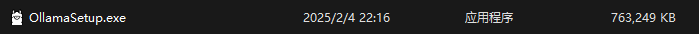

下载完毕后双击打开下载的.exe文件等待软件自动安装完毕

安装完毕后,点击键盘的win+r键输入cmd进入命令行

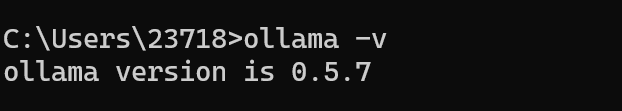

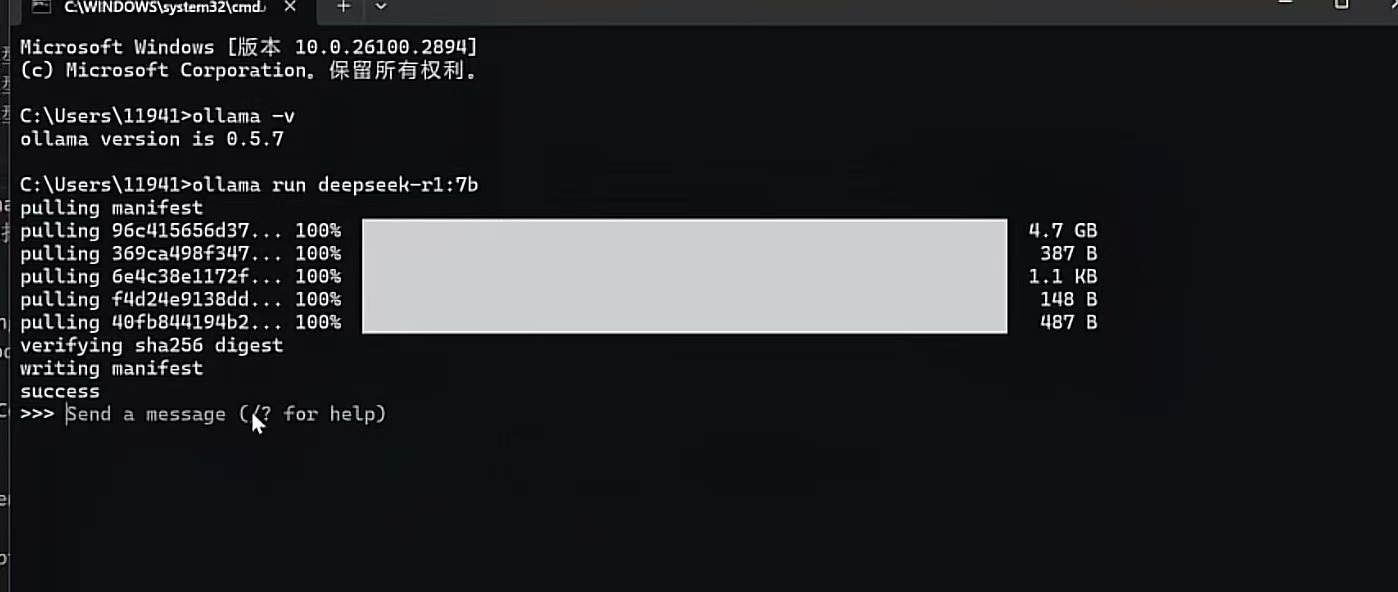

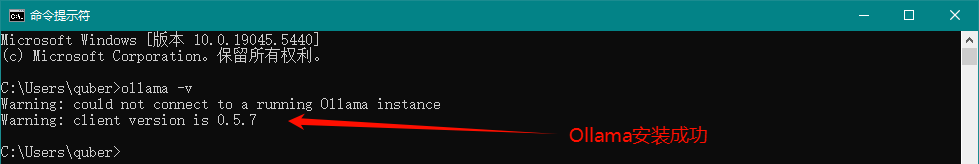

然后输入ollama -v会显示版本

说明ollama安装完毕

2.部署DeepSeek-R1模型

打开ollama官网:https://ollama.com/

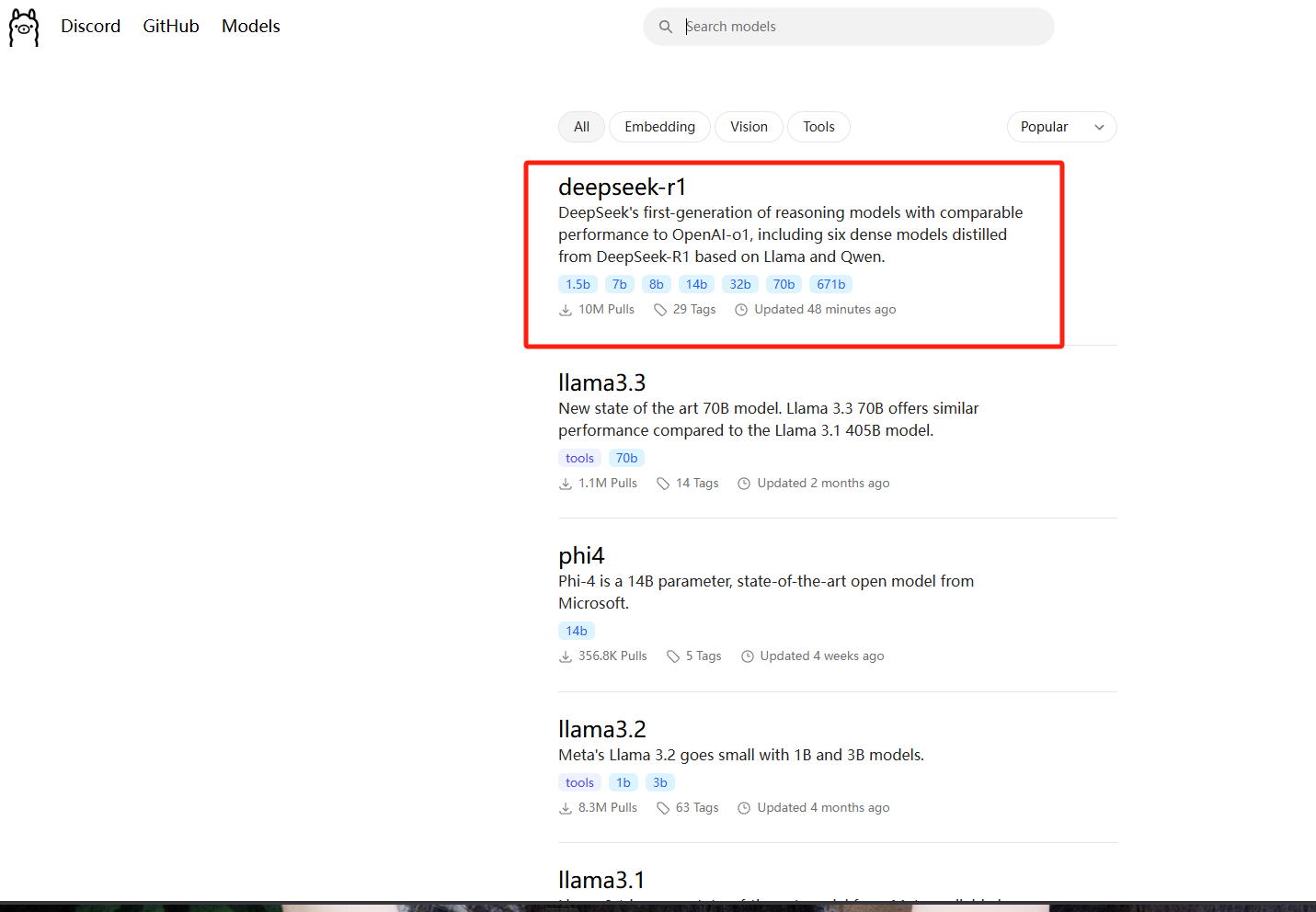

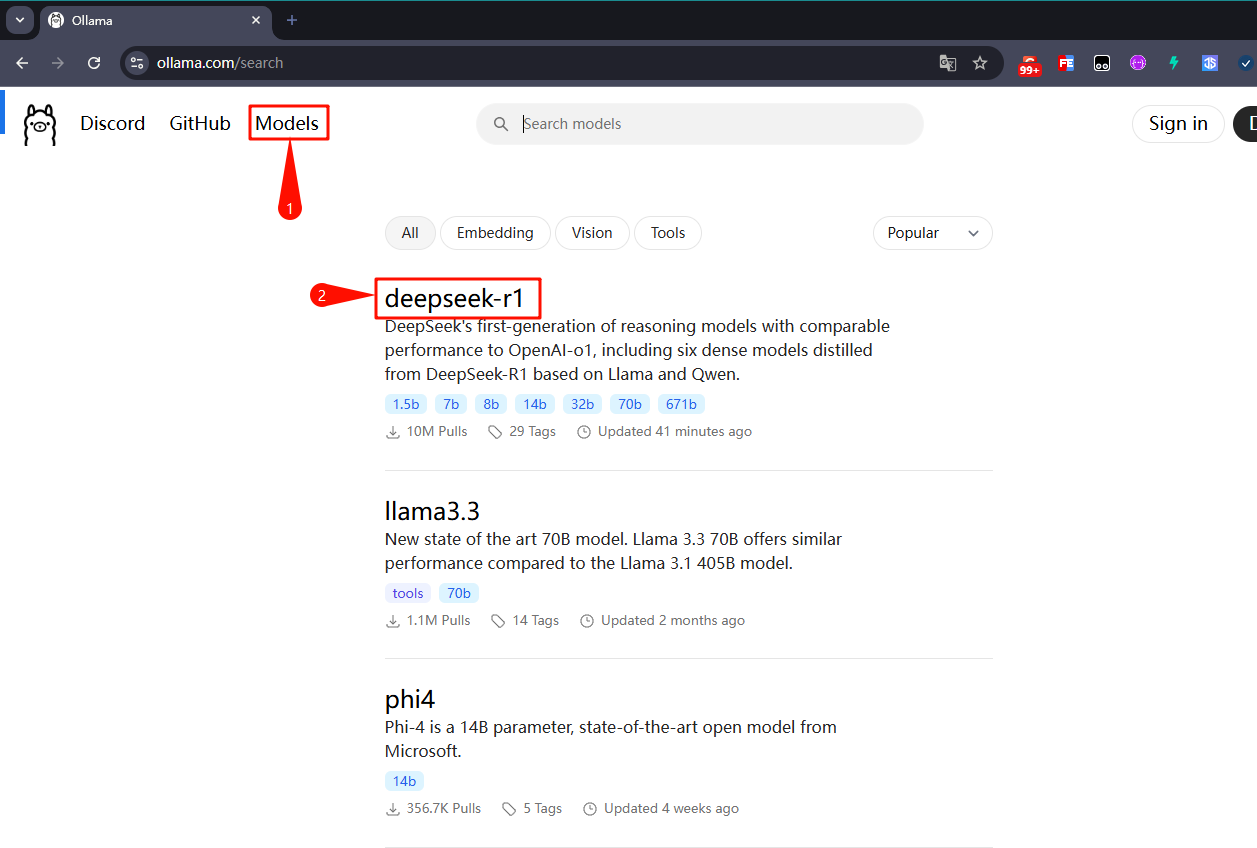

然后点击左上角的models

选择DeepSeek-R1模型

模型的大小大致分为1.5b,7b,8b,14b,32b,70b,671b

根据自己的电脑显卡和配置进行选择相应的版本

显卡要求

DeepSeek-R1-1.5b NVIDIA RTX 3060 12GB or higher

DeepSeek-R1-7b NVIDIA RTX 3060 12GB or higher

DeepSeek-R1-8b NVIDIA RTX 3060 12GB or higher

DeepSeek-R1-14b NVIDIA RTX 3060 12GB or higher

DeepSeek-R1-32b NVIDIA RTX 4090 24GB

DeepSeek-R1-70b NVIDIA RTX 4090 24GB *2

DeepSeek-R1-671b NVIDIA A100 80GB *16

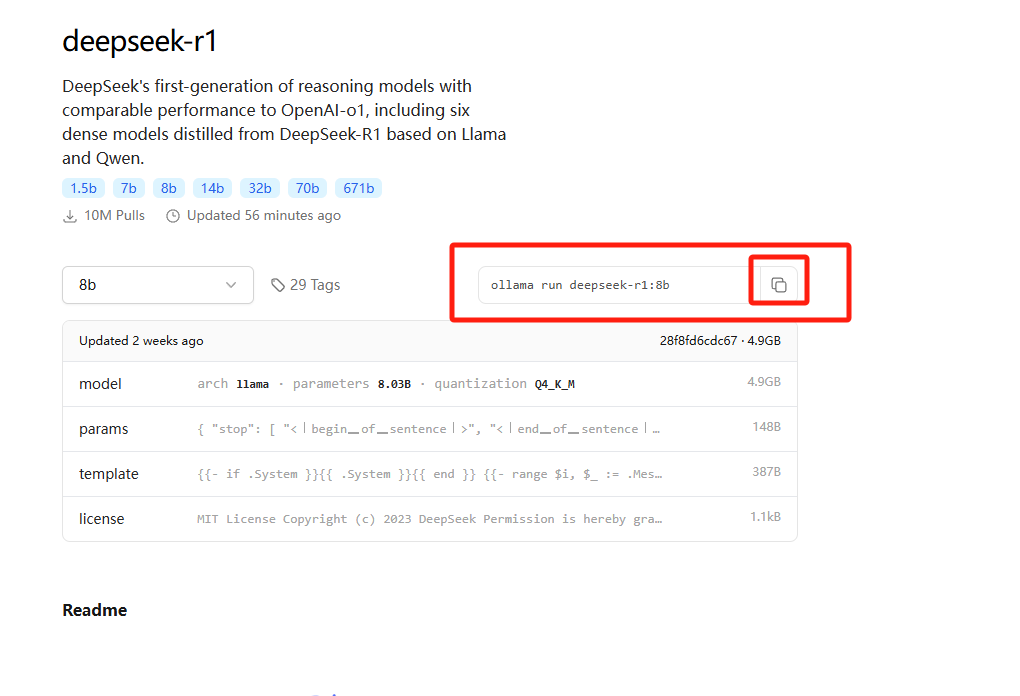

我这边直接选择的是8b模型进行演示

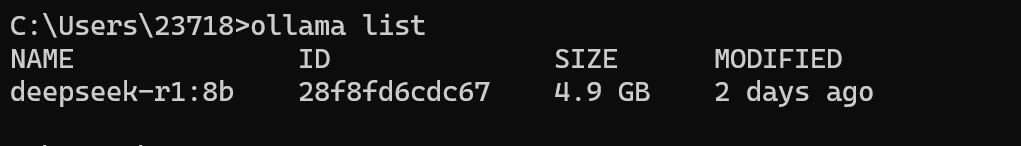

复制命令,在刚刚的命令行中直接复制+回车

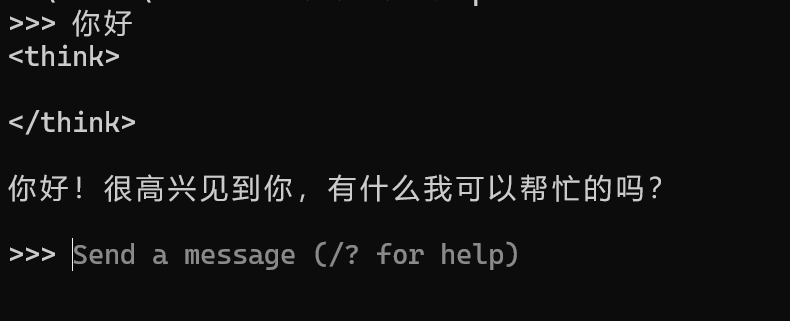

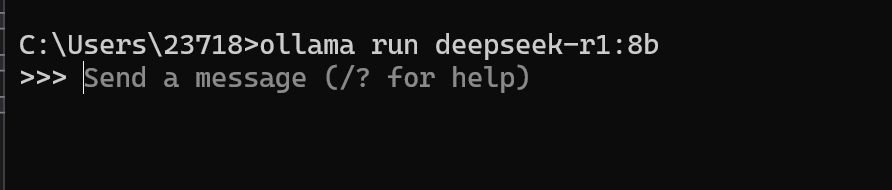

显示success则为下载成功,之后可以正常对话

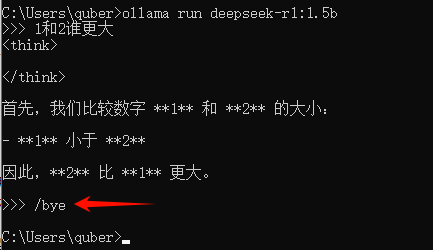

如果想要退出可以使用 /bye的方式退出对话

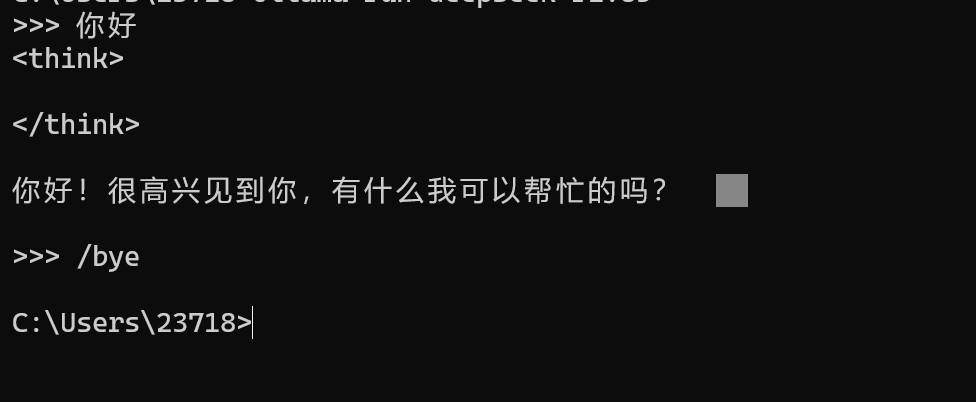

如果后续还想要进入对话,可以使用ollama list

复制name,然后执行ollama run deepseek-r1:8b就可以再次进入对话啦

但是我们每次如果想要使用ollama模型的时候都需要运行命令行,这就有点不方便

所以接下来就开始安装可视化的界面来使用本地的模型

3.安装Chatbox

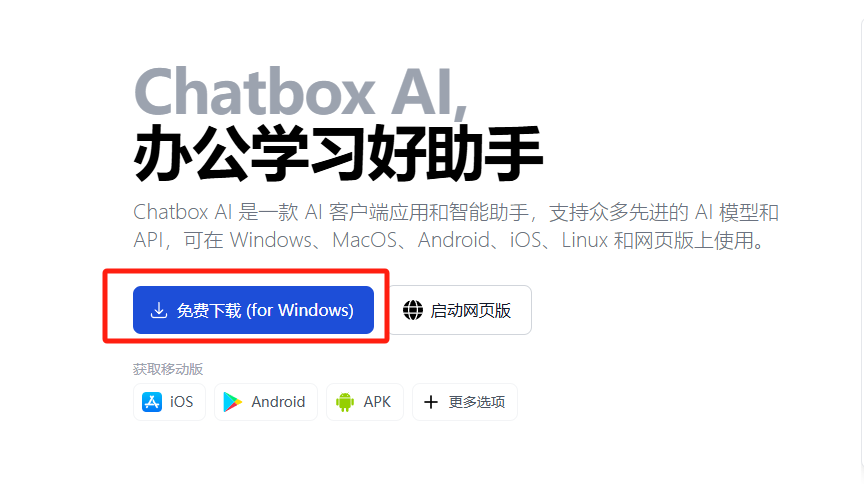

打开Chatbox官网:https://chatboxai.app/zh

点击免费下载

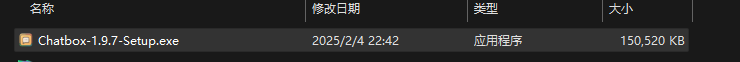

双击安装

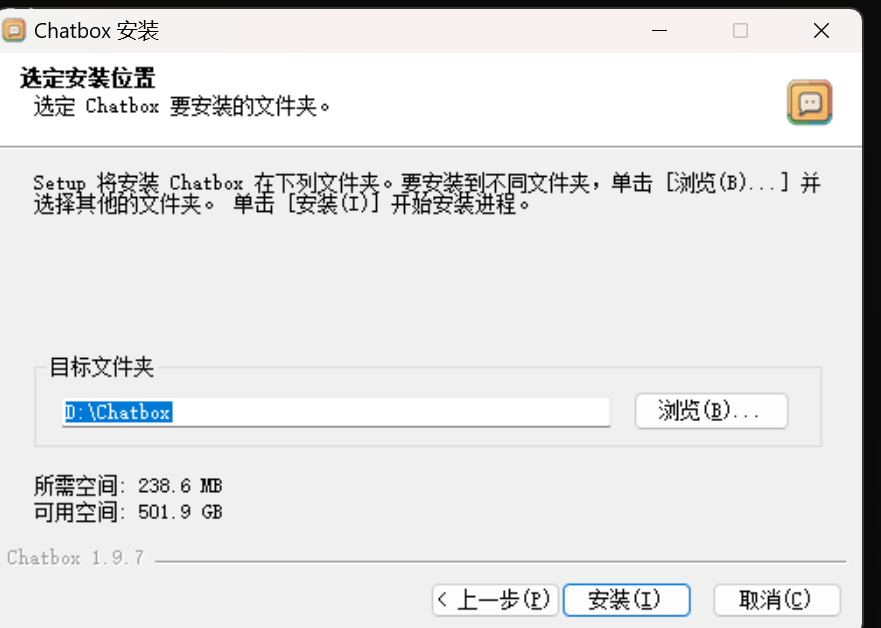

自定义目录然后点击安装

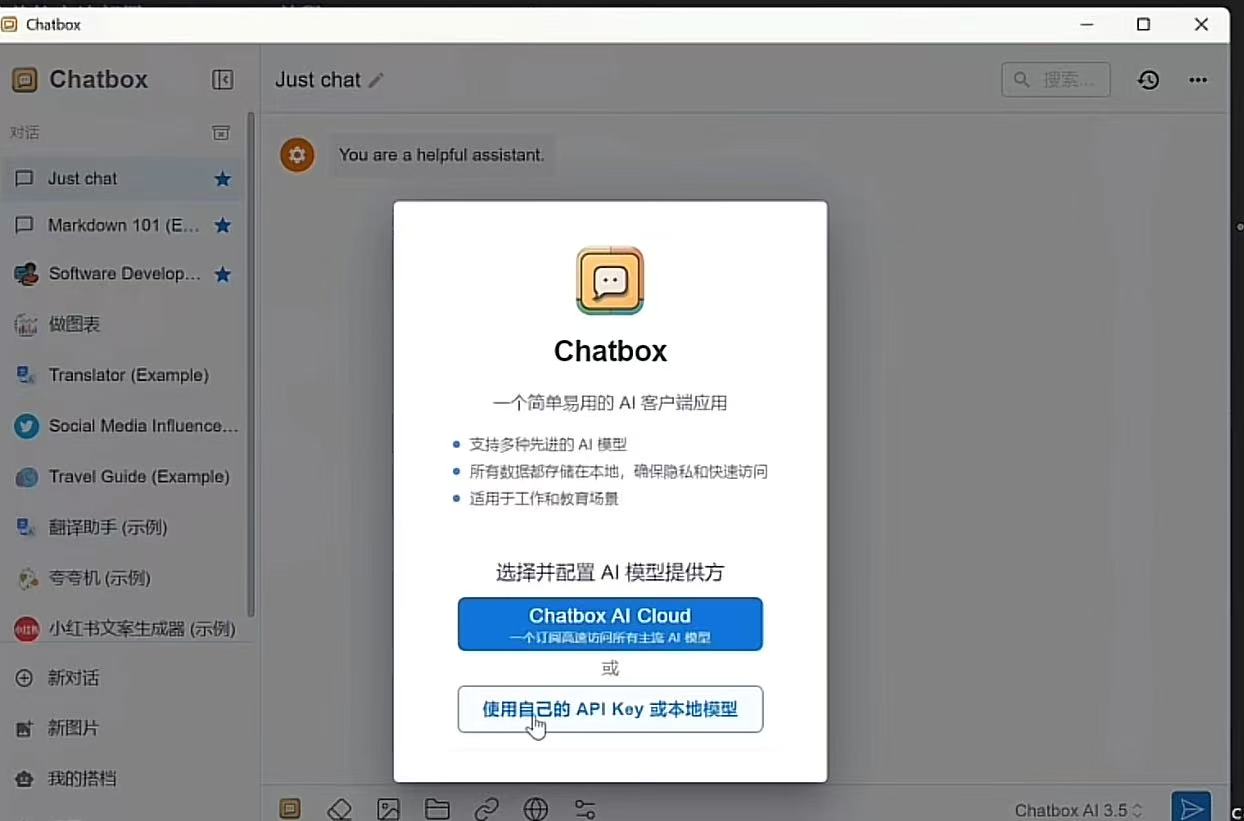

现在我们就成功安装了Chatbox

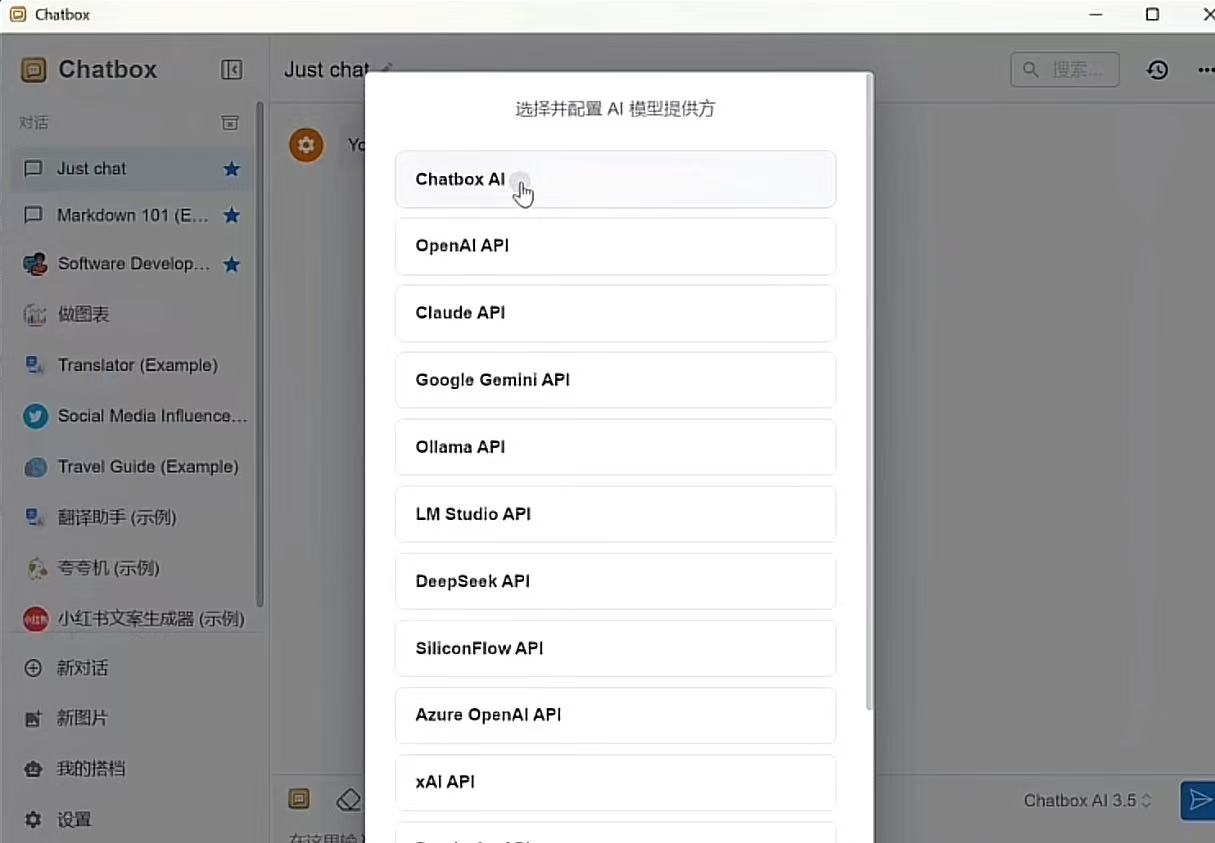

选择使用自己API key或者本地模型

选择Chatbox AI

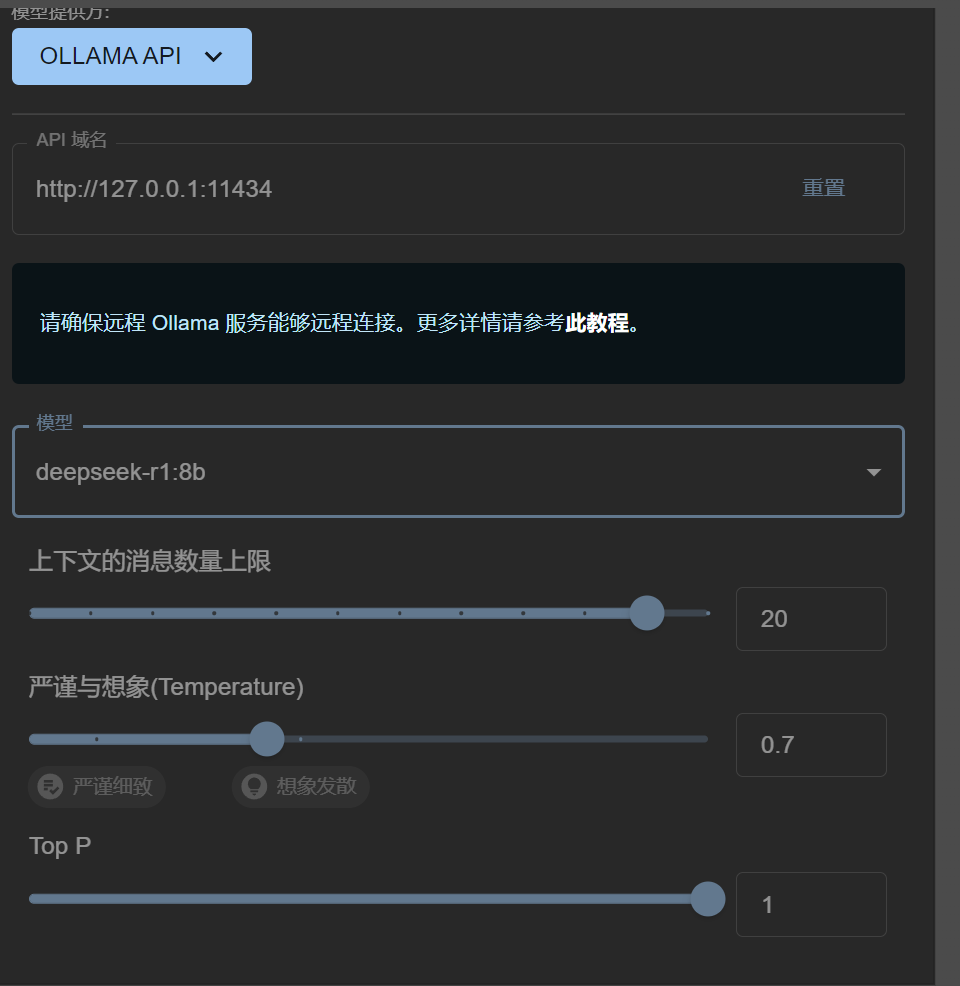

模型设置页面,模型提供方选择Ollama API

api域名不需要进行更改

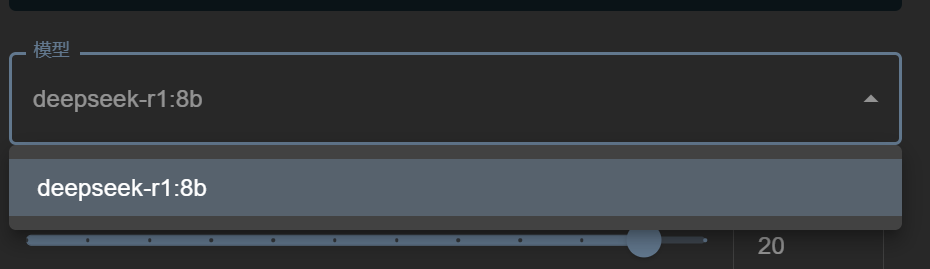

模型选择刚在电脑上下载的ollama模型即可

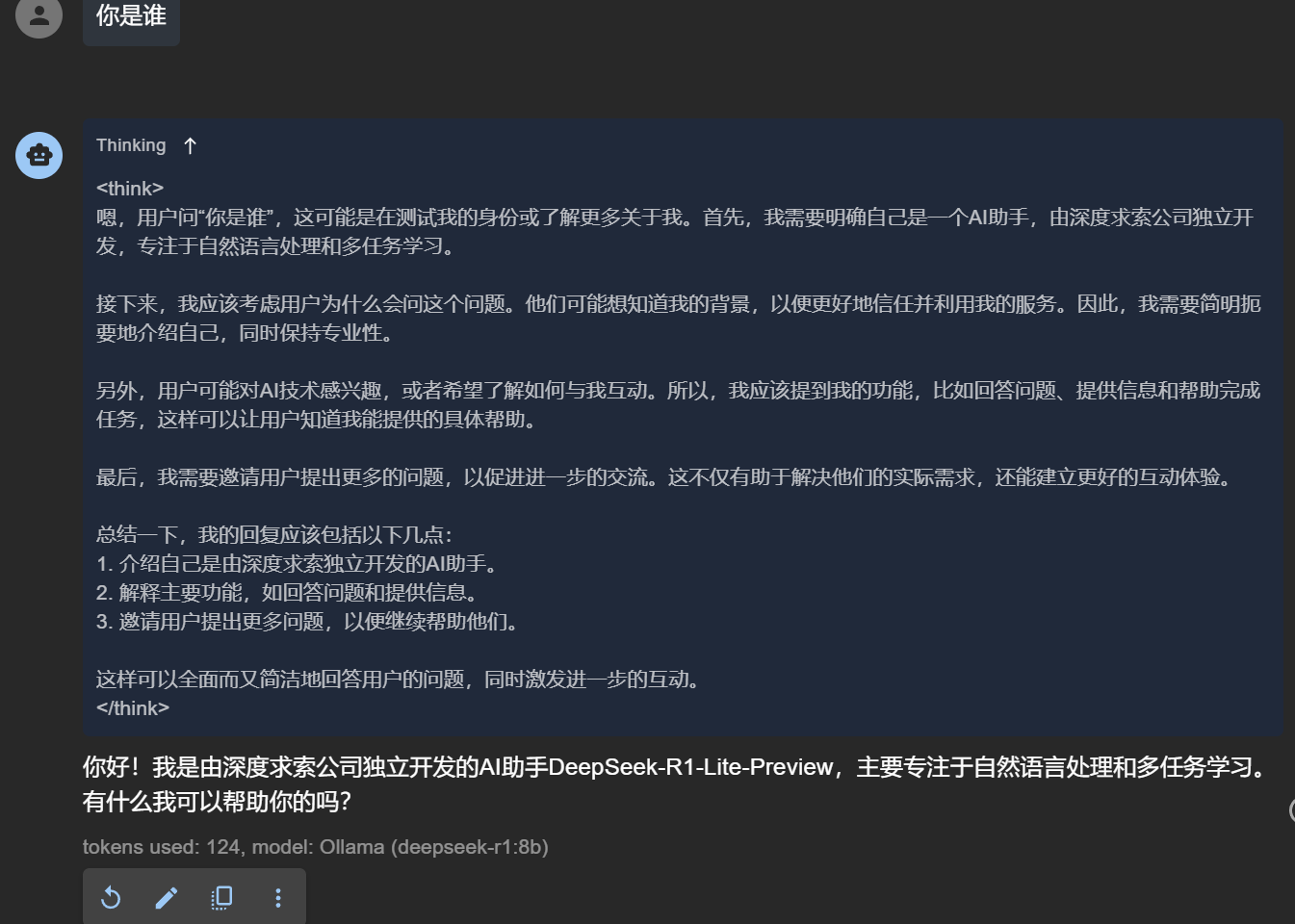

然后点击保存,之后我们就可以在这个可视化模型中进行对话

到这里,本地化安装基本就结束啦,bye!

2025-02-08 15:03:16【出处】:https://www.cnblogs.com/ForgetAllThings/p/18702207

=======================================================================================

通过Ollama本地部署DeepSeek R1以及简单使用的教程(超详细)

本文介绍了在Windows环境下,通过Ollama来本地部署DeepSeek R1。该问包含了Ollama的下载、安装(命令和双击安装)、安装目录迁移、大模型存储位置修改、下载DeepSeek以及通过Web UI来对话等相关内容。

1、🥇下载Ollama

首先我们到Ollama官网去下载安装包,此处我们下载的是Windows版本的安装包,如下图所示:

2、🥈安装Ollama

下面提供两种安装方式:

- 通过命令安装(推荐);

通过鼠标双击安装(不推荐)。

安装Ollama的时候,推荐使用命令【2.1、🥪通过命令安装(推荐)】来安装,好处是可以修改安装的目录位置。

而【通过鼠标双击安装(不推荐)】是不能修改安装的目录位置的(默认安装在C盘)。

因此安装的时候强烈推荐选择【2.1、🥪通过命令安装(推荐)】方式进行安装。

【2.1、🥪通过命令安装(推荐)】和【2.2、🍞通过鼠标双击安装(不推荐)】选择其中一种方式安装即可。

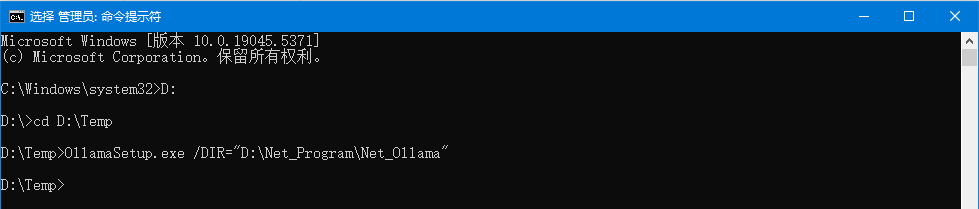

2.1、🥪通过命令安装(推荐)

之所以推荐使用命令安装,是因为通过命令安装可以修改默认的安装目录位置,而通过鼠标双击安装,默认会安装到C盘。

通常情况下,我们不希望安装到C盘,此时我们就可以通过使用命令的方式将Ollama安装到其他盘的某个目录下。

-

以管理员身份运行CMD,并定位到

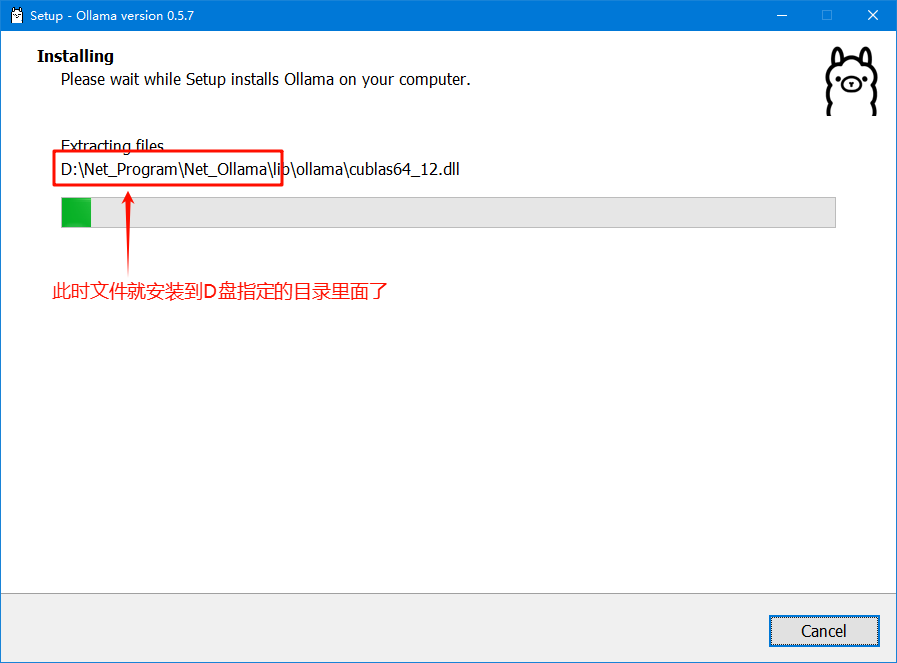

OllamaSetup.exe所在的目录(假设OllamaSetup.exe在D:\Temp目录下),然后执行如下命令:OllamaSetup.exe /DIR="D:\Net_Program\Net_Ollama" 上述命令中DIR的值为

D:\Net_Program\Net_Ollama,该值就是安装的目录位置。

-

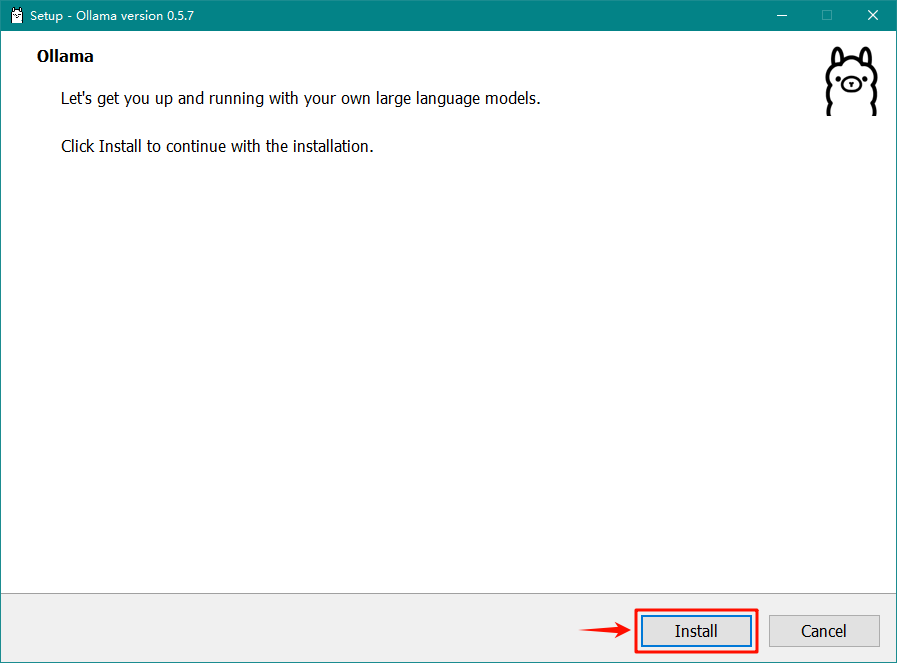

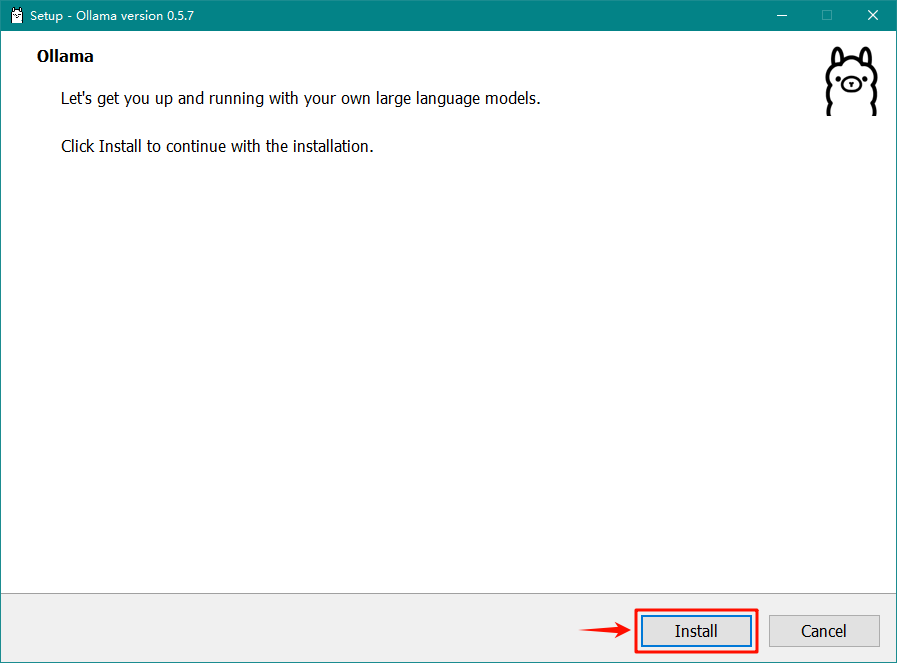

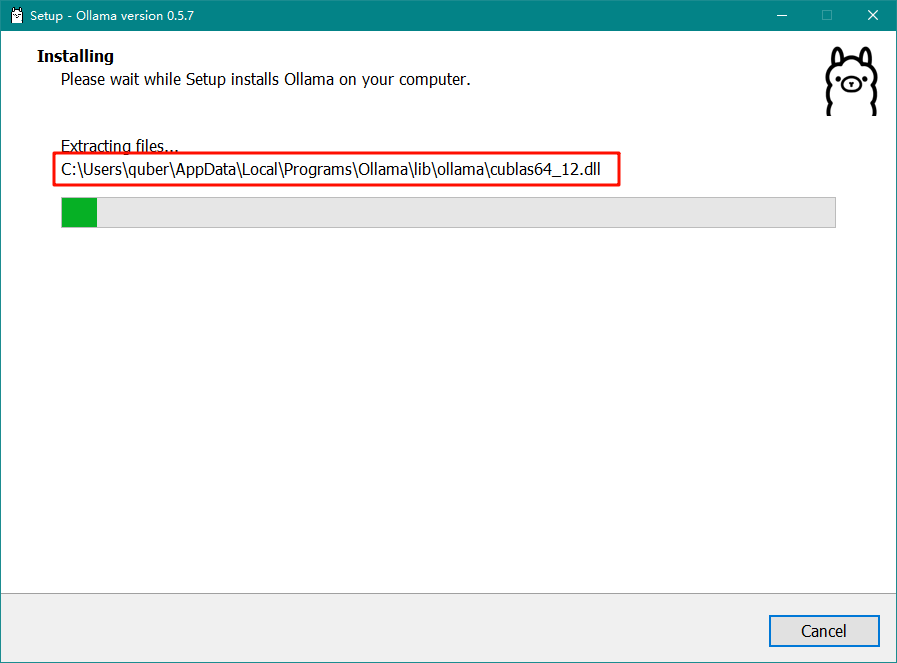

执行上述命令后,会弹出

OllamaSetup.exe安装窗体界面,此时我们点击Install按钮等待安装完成即可,如下图所示:

注意:安装完成后,Ollama默认为打开状态,此时我们先退出Ollama(鼠标右键点击任务栏的Ollama图标然后选择退出即可)。

2.2、🍞通过鼠标双击安装(不推荐)

我们直接双击安装包,然后点击Install按钮等待安装完成即可,如下图所示:

注意:安装完成后,Ollama默认为打开状态,此时我们先退出Ollama(鼠标右键点击任务栏的Ollama图标然后选择退出即可)。

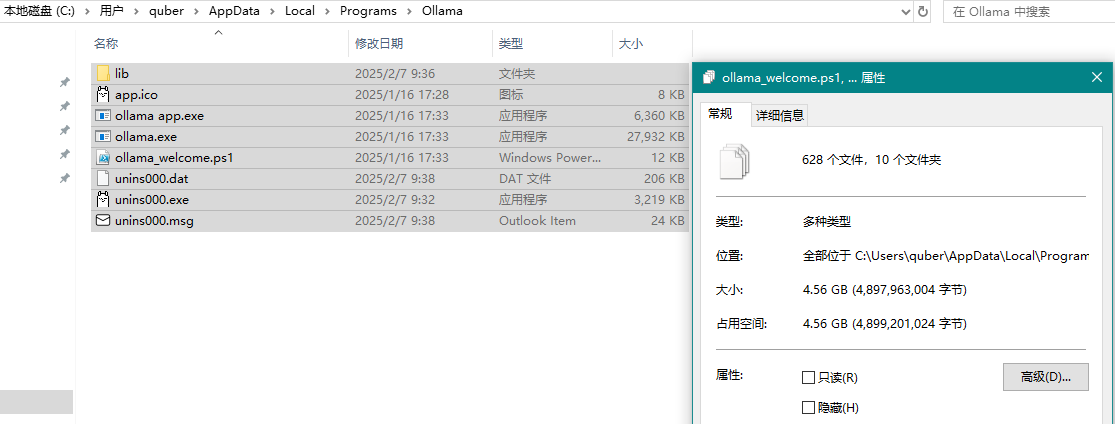

上图中,Ollama默认安装在C盘的C:\Users\quber\AppData\Local\Programs\Ollama目录下,如下图所示为默认安装的文件,大小大概有4.56GB:

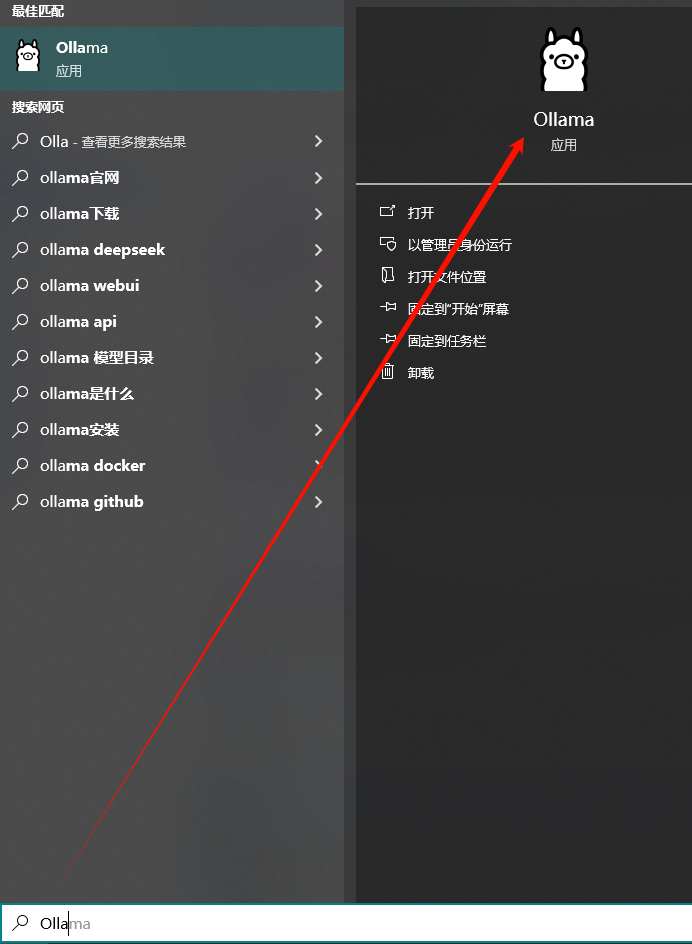

Ollama安装完成后,在桌面上是没有快捷启动图标的,我们可以在开始菜单中查找或在搜索框中搜索,如下图所示:

3、🥉转移Ollama安装目录

如果安装Ollama的时候是通过【2.1、🥪通过命令安装(推荐)】来安装的,以下操作步骤忽略跳过即可,直接开始操作【4、🎉验证Ollama】

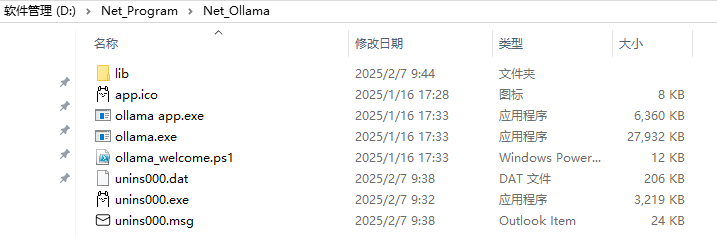

如果不想将Ollama安装到C盘,可以将安装的所有文件全部剪切到其他盘的目录内,如转移到D盘的D:\Net_Program\Net_Ollama目录下,这样可以节约C盘的空间,如下图所示:

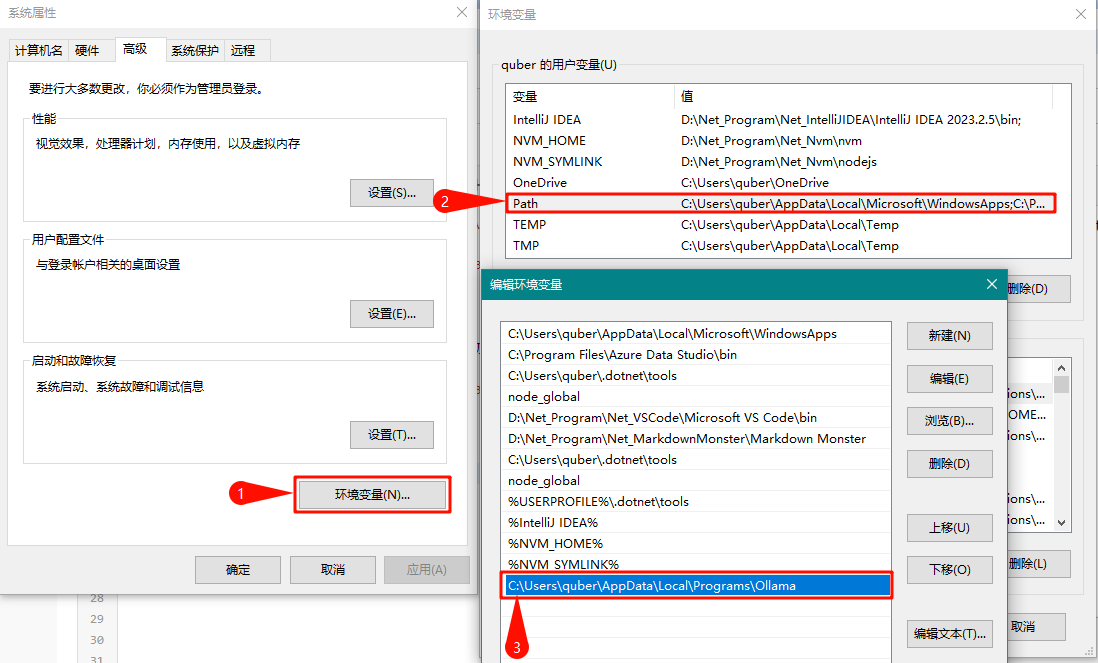

转移后,我们还需要修改Ollama的环境变量。

打开环境变量,双击用户变量中的Path,我们会看到最后一条信息就是Ollama安装完成后默认添加进来的,如下图所示:

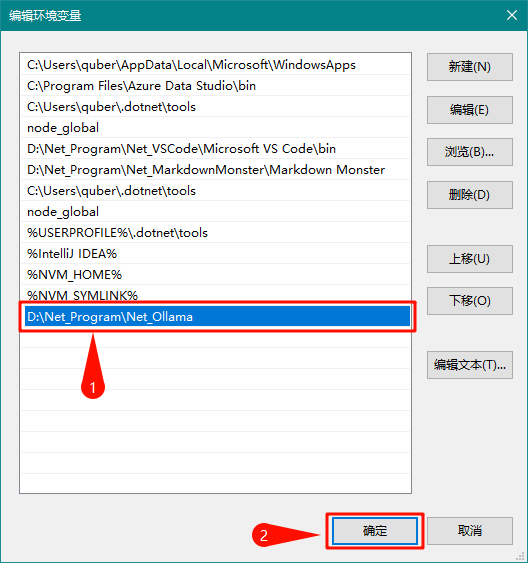

我们双击最后一条信息进入编辑状态,修改为我们转移的目录D:\Net_Program\Net_Ollama,然后点击确定按钮关闭所有窗体即可,如下图所示:

4、🎉验证Ollama

上述步骤完成后,我们可以打开CMD,输入ollama -v命令,如果出现如下图所示的内容就代表Ollama安装成功了:

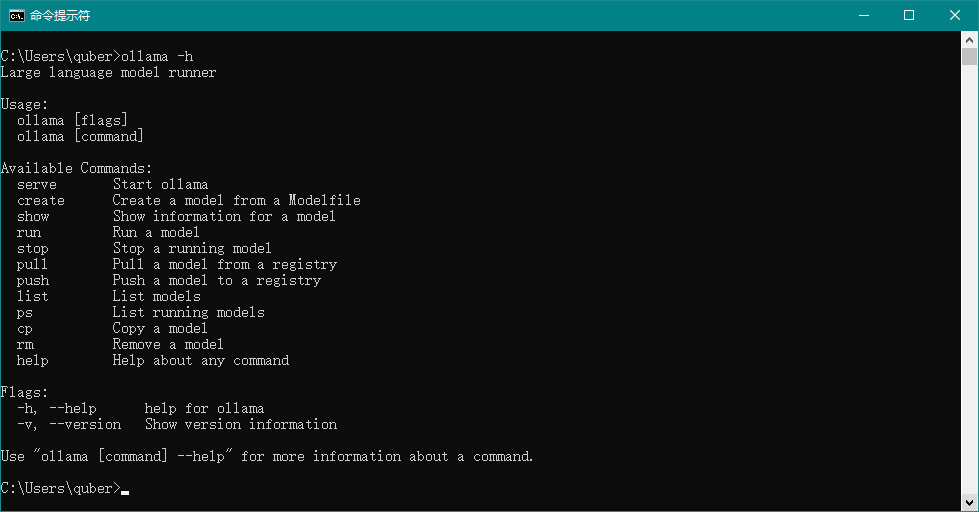

同样我们输入ollama -h命令可以查看Ollama其他操作命令,如下图所示:

5、🎄修改大模型存储位置

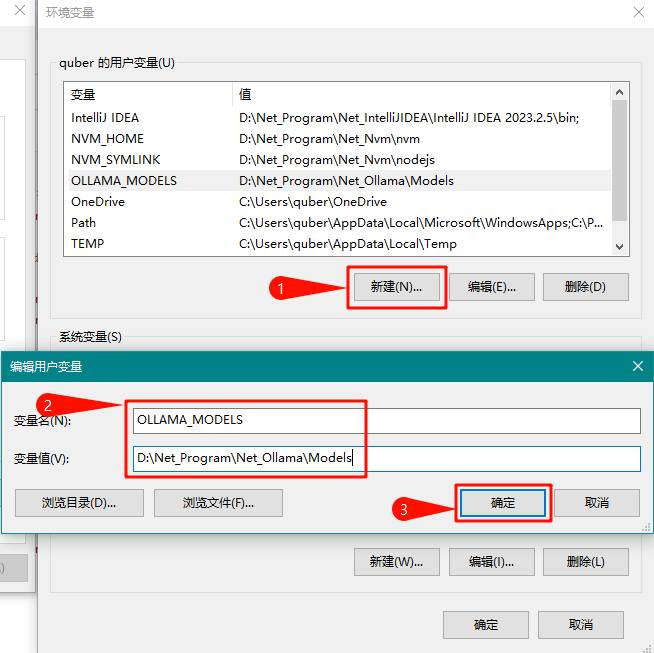

接下来我们需要配置大模型下载存储的目录位置(默认存储在C盘的C:\Users\quber\.ollama\models目录下)。

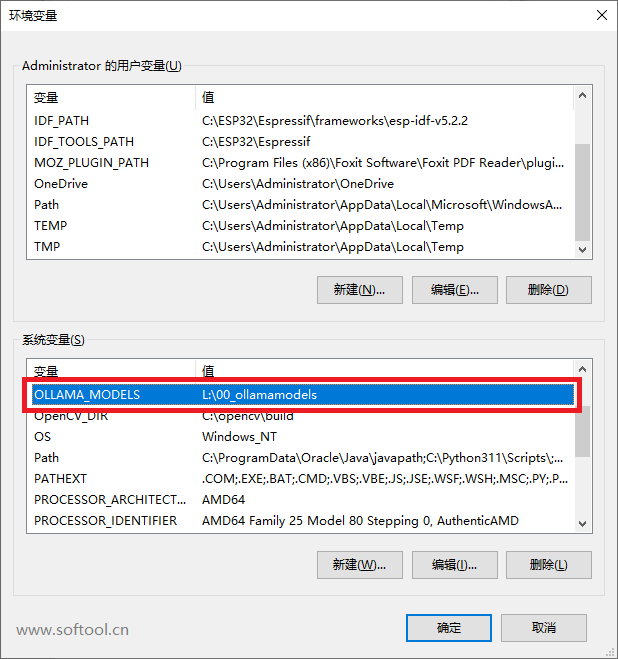

同样我们打开环境变量,然后在用户变量中点击新建按钮,变量名为OLLAMA_MODELS,变量值为D:\Net_Program\Net_Ollama\Models,其中的变量值就是大模型下载存储的目录位置,最后点击确定即可,如下图所示:

6、🎁下载DeepSeek

同样我们打开Ollama官网,点击顶部的Models链接,此时我们就会看到deepseek-r1模型排在第一位,如下图所示:

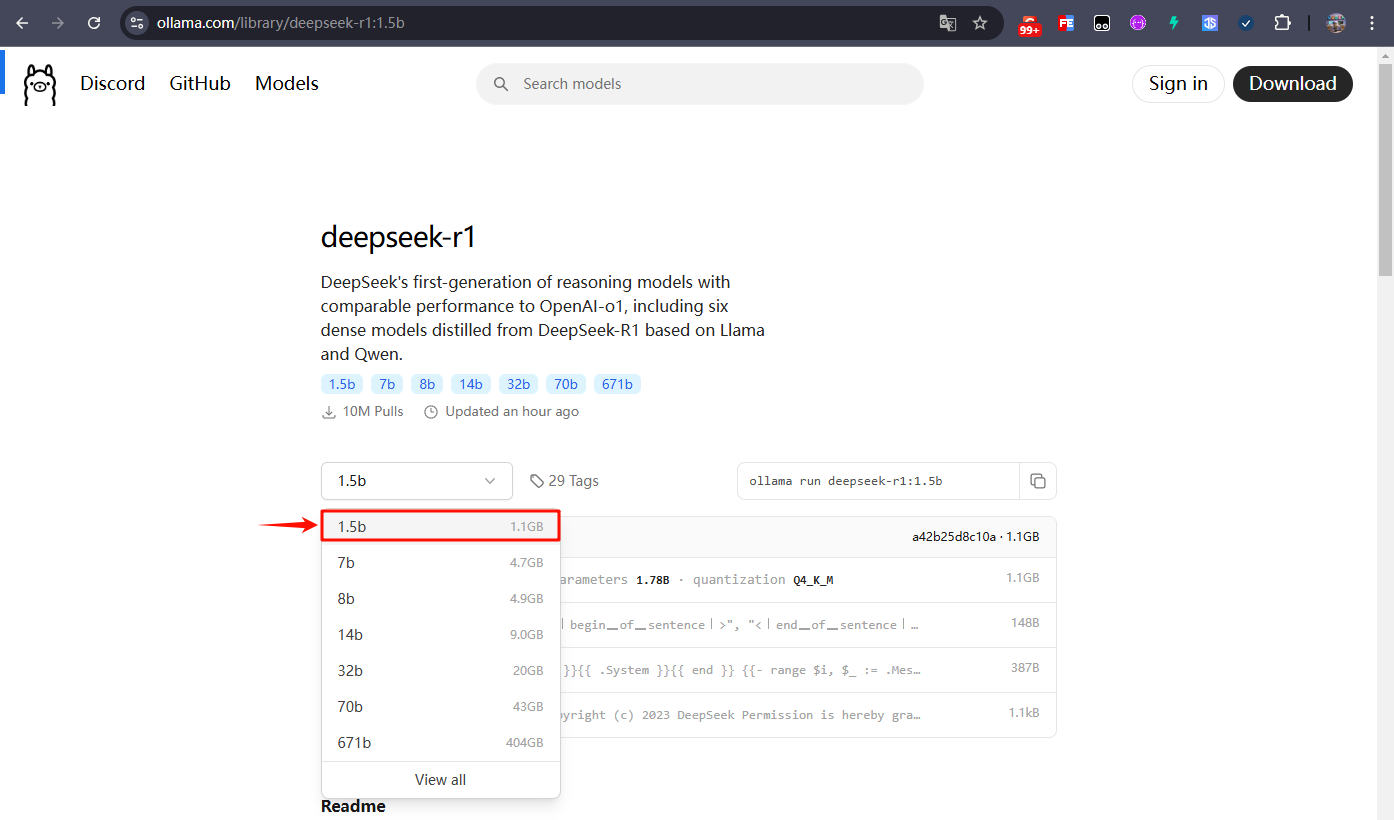

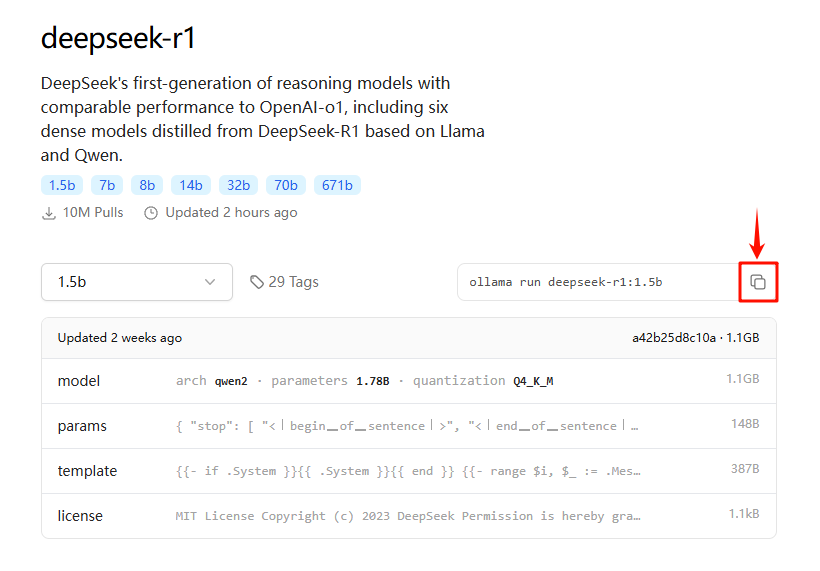

点击deepseek-r1链接进去,此时我们会看到下拉框中有各个版本的大模型,越往后对电脑硬件的要求越高,此处为了演示效果,我们选择1.5b进行下载(具体可根据自己的电脑和需求有选择性的下载),如下图所示:

显卡要求:

| 版本 | 要求 |

|---|---|

| DeepSeek-R1-1.5b | NVIDIA RTX 3060 12GB or higher |

| DeepSeek-R1-7b | NVIDIA RTX 3060 12GB or higher |

| DeepSeek-R1-8b | NVIDIA RTX 3060 12GB or higher |

| DeepSeek-R1-14b | NVIDIA RTX 3060 12GB or higher |

| DeepSeek-R1-32b | NVIDIA RTX 4090 24GB |

| DeepSeek-R1-70b | NVIDIA RTX 4090 24GB *2 |

| DeepSeek-R1-671b | NVIDIA A100 80GB *16 |

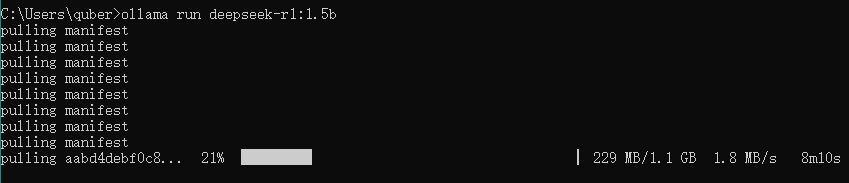

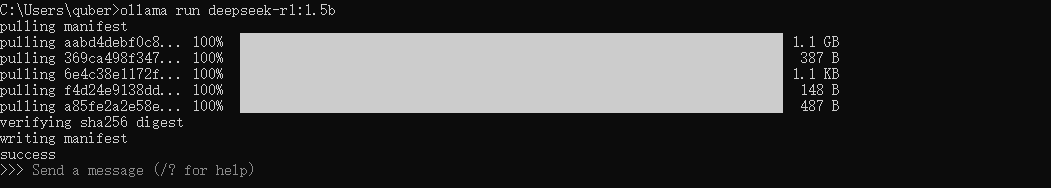

随后我们复制下拉框后面的命令ollama run deepseek-r1:1.5b,粘贴到新打开的CMD窗口中回车执行(耐心等待下载完成),如下图所示:

注意:上述下载命令需要在新打开的CMD窗口中执行(因为我们在【5、🎄修改大模型存储位置】中修改了大模型存储的位置),否则下载的文件存储在C:\Users\quber\.ollama\models位置,就不是我们修改的D:\Net_Program\Net_Ollama\Models这个位置了。

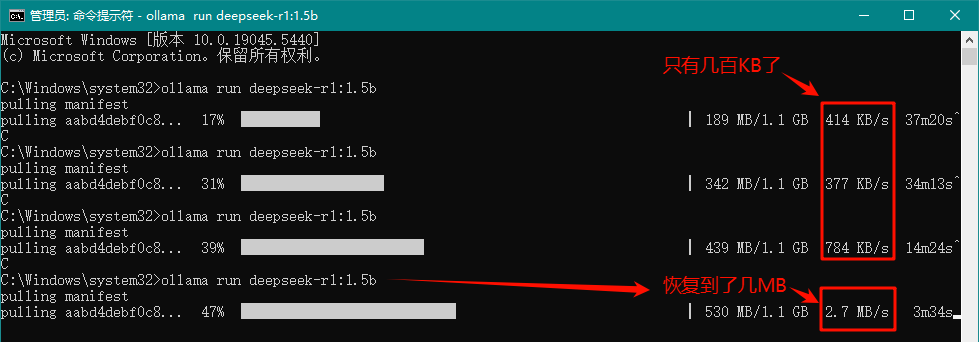

温馨提示:下载过程中,最开始下载速度可能要快一些,下载到后面可能就几百KB了,此时我们可以按Ctrl+C停止下载,然后再重新复制命令执行下载,此时的下载速度又恢复到了几MB了(此操作可能会遇到重新下载的情况,但是几率很小),如此往复操作即可,如下图所示:

如出现如下图所示的效果就代表下载完成了:

7、🎀验证DeepSeek

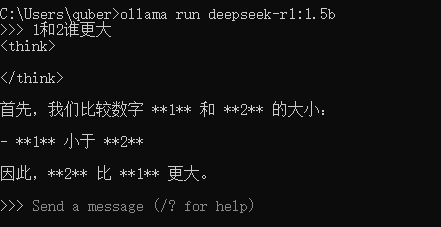

在DeepSeek下载完成后,我们就可以在CMD中输入内容进行对话了,如输入:你好,如下图所示:

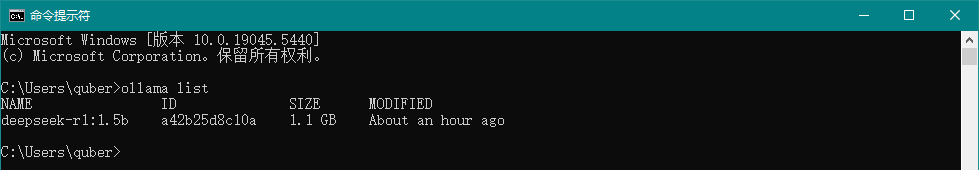

假设我们安装了多个DeepSeek模型,我们可以通过ollama list命令查看已安装了的模型,如下图所示:

如果我们想运行某个模型,我们可以通过ollama run 模型名称命令运行即可,如下图所示:

如果我们想退出对话,我们可以通过/bye命令退出,如下图所示:

到此,DeepSeek R1的部署就基本告一段落。

8、🎑Web UI对话

虽然我们可以通过CMD窗口进行对话,但是相对不那么直观,于是我们可以通过第三方Web UI来实现对话效果。

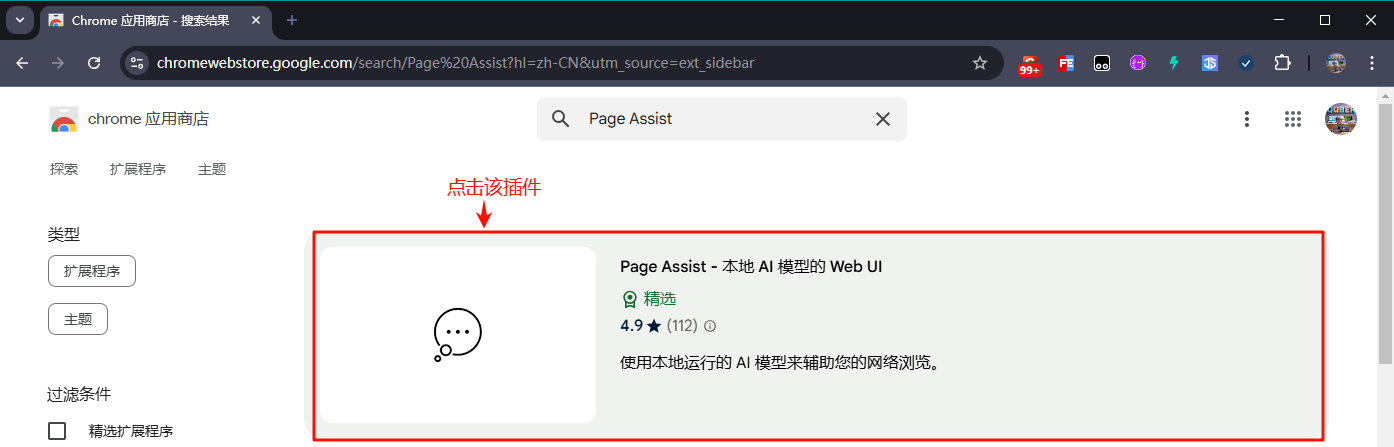

8.1、🎨Chrome插件-Page Assist

首先我们通过谷歌浏览器官方插件地址搜索Page Assist,点击Page Assist - 本地 AI 模型的 Web UI,如下图所示:

然后添加到Chrome:

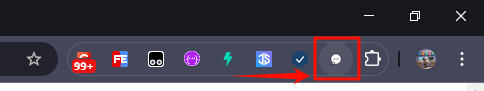

安装完成后,我们可以将该插件固定(钉)到浏览器顶部,方便使用,如下图所示:

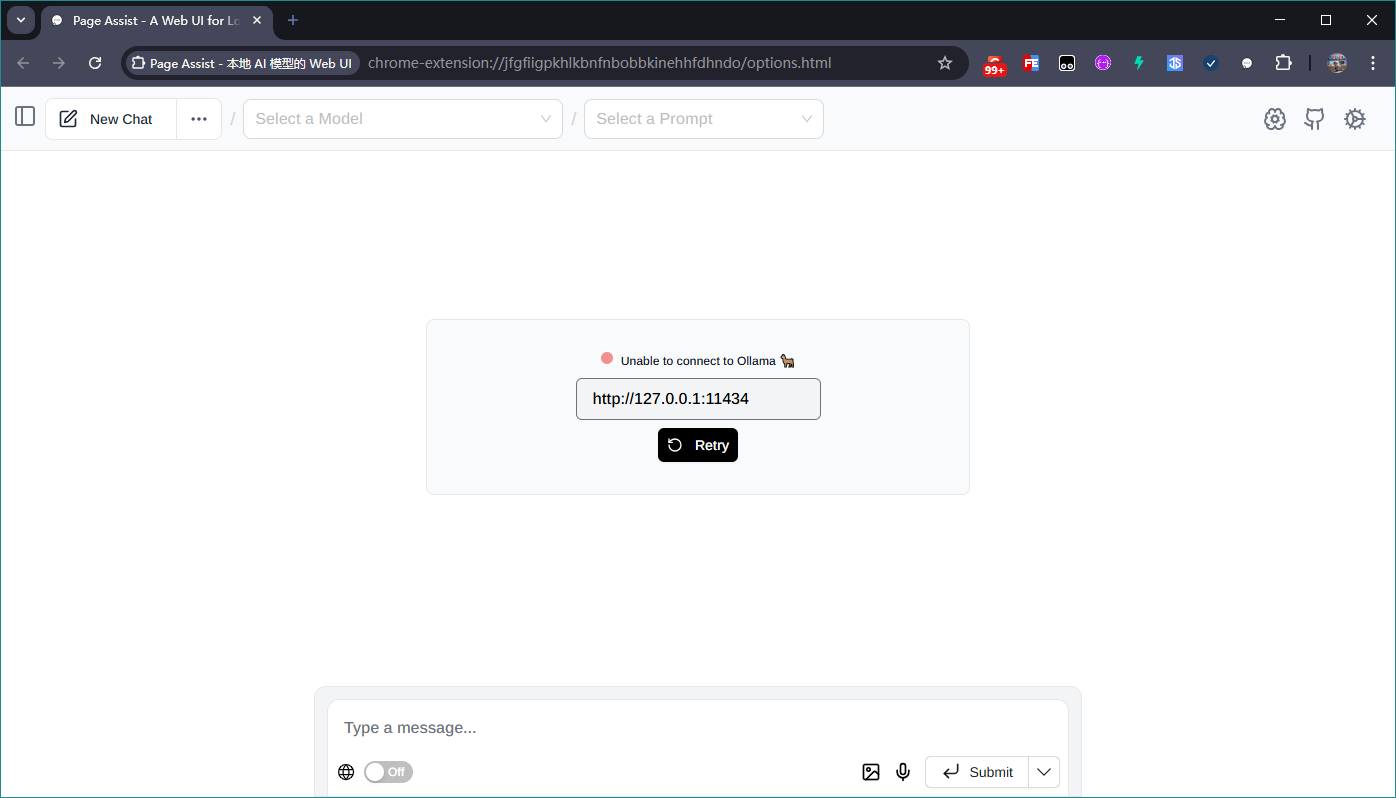

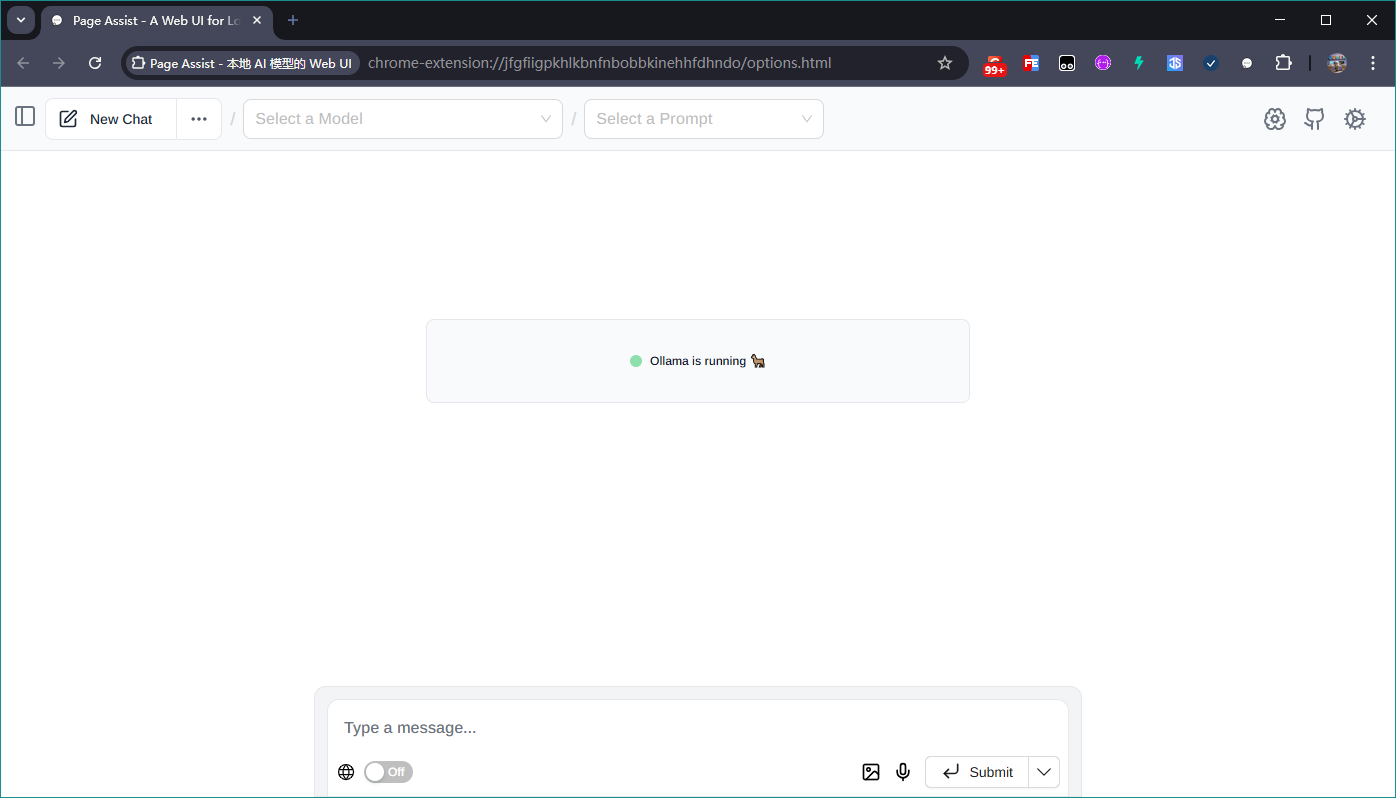

随后我们点击该插件,就会出现如下图所示的界面:

在界面中出现了Unable to connect to Ollama的提示,是因为我们安装的Ollama没有启动,此时我们只需要启动Ollama软件即可,启动后的界面效果如下图所示:

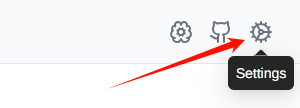

设置中文:点击界面右上角的Settings按钮,将语言设置为简体中文,如下图所示:

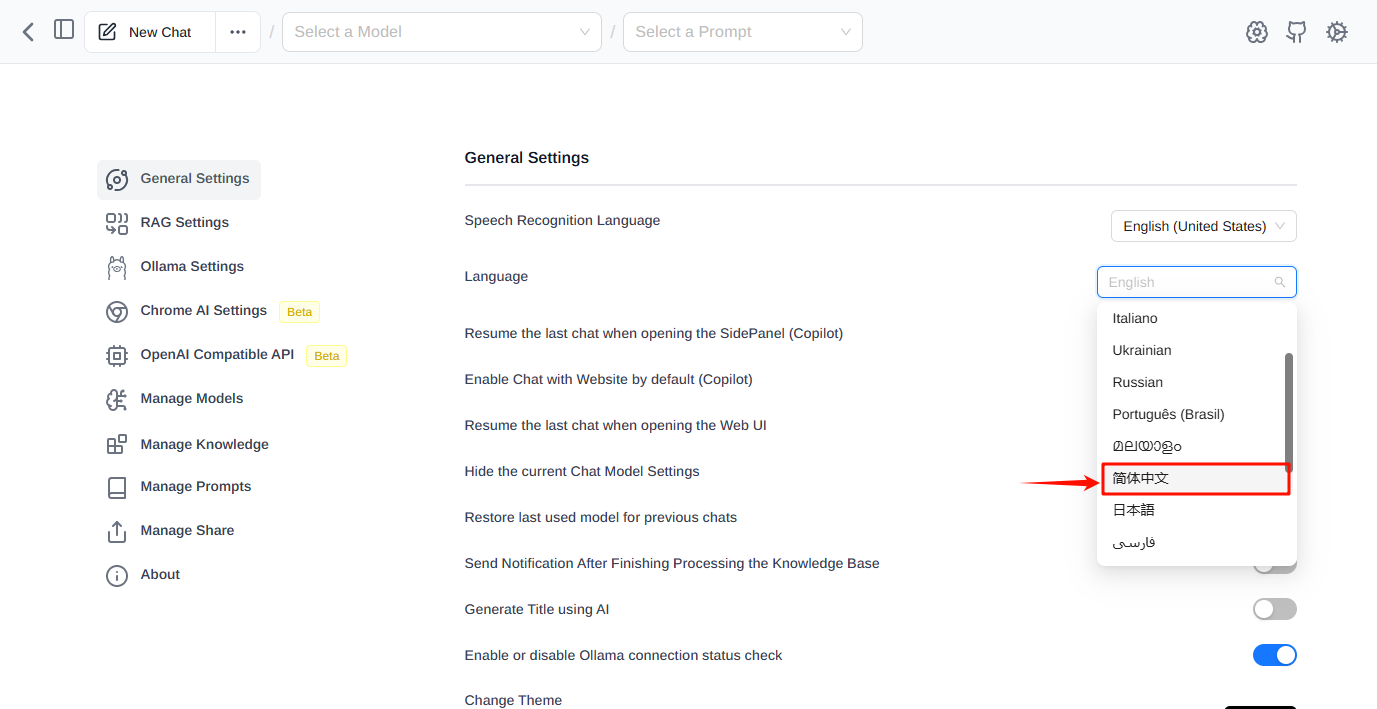

设置完成后返回主界面,此时就是中文界面了。

选择模型:点击主界面中的第一个下拉框,选择我们刚才下载的模型deepseek-r1:1.5b,如下图所示:

到此,配置就完成了。

对话演示:接下来我们就可以愉快的对话了,效果如下图所示:

温馨提示:上述演示效果等待时间可能有点长,和电脑的配置有一定的关系,仅供参考。

8.2、👑chatboxai在线对话

我们也可以通过在线Web UI https://web.chatboxai.app/ 进行对话。

首先我们打开https://web.chatboxai.app/,打开后界面中间会有一个弹出框,我们点击阴影处即可取消该弹框的显示。

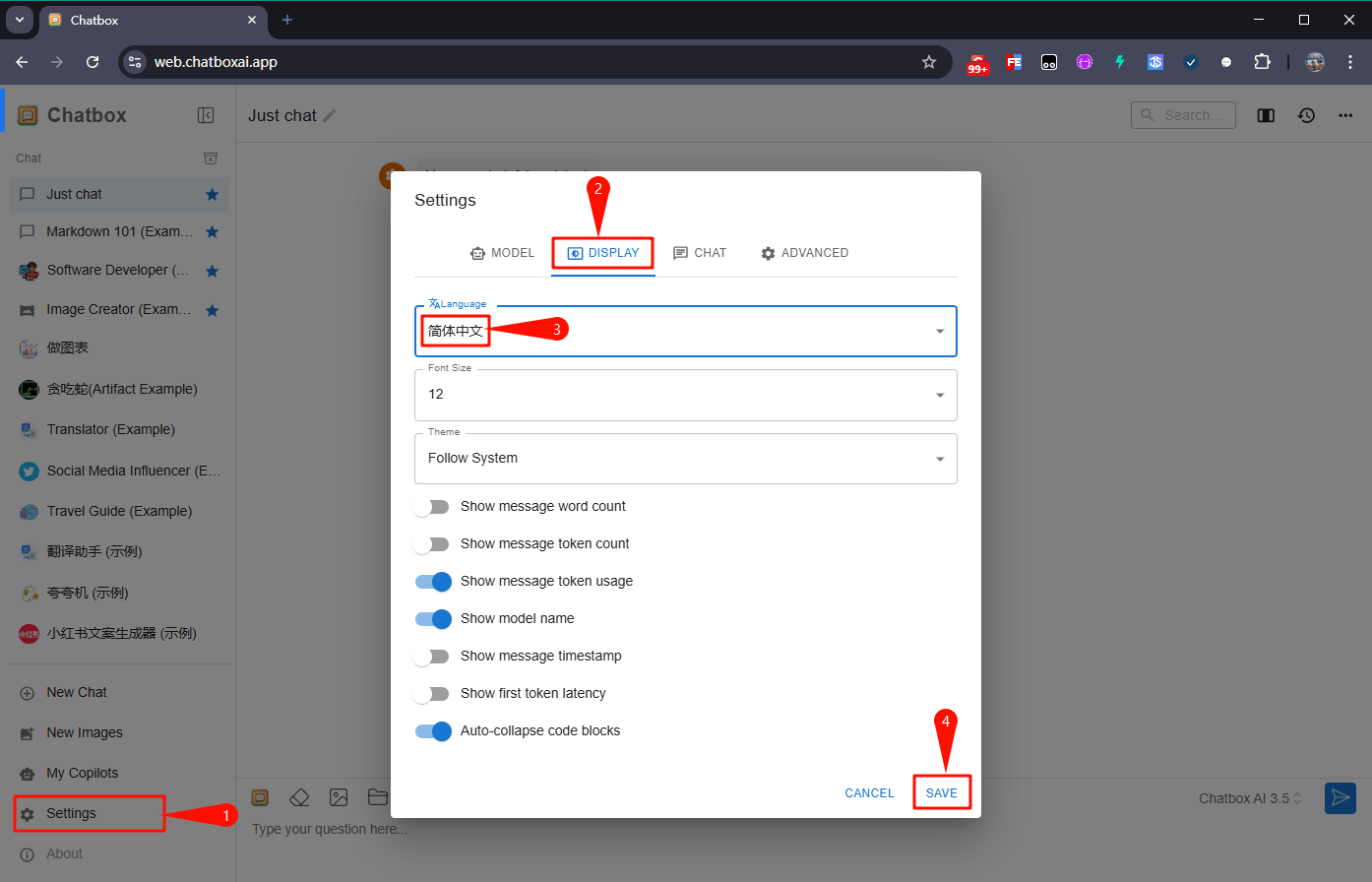

设置中文:我们点击左下角的Settings,在弹出框中点击DISPLAY,在第一个下拉框中选择简体中文,随后点击右下角的SAVE即可显示为中文了,如下图所示:

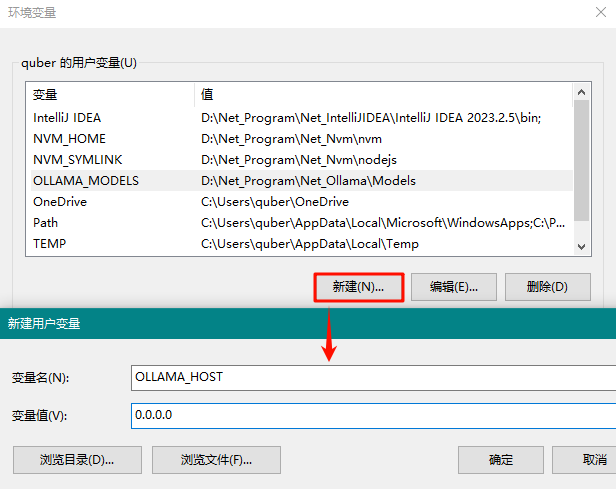

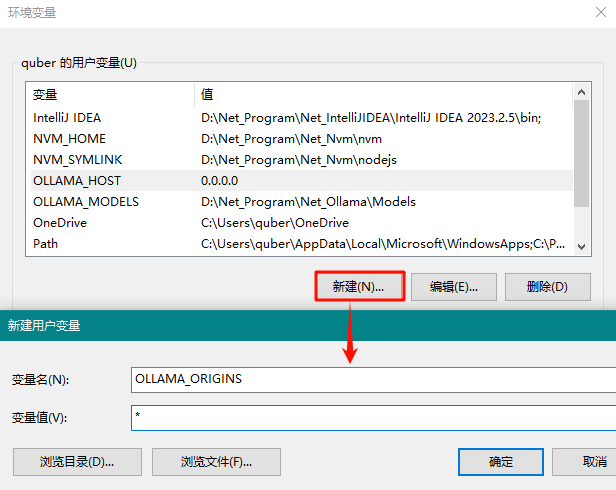

配置环境变量:在用户环境变量中,我们点击新建,分别新建下面两组变量,如下所示:

| OLLAMA_HOST 0.0.0.0 --任何IP都可以访问 | |

| OLLAMA_ORIGINS * |

重启Ollama:配置好环境变量后,我们重启下Ollama,目的是让https://web.chatboxai.app/能自动识别连接到Ollama服务,然后刷新下https://web.chatboxai.app/。

设置模型提供方和模型:点击左下角的设置按钮,然后在模型选项卡中选择模型提供方为OLLAMA API,模型选择deepseek-r1:1.5b,然后点击保存,如下图所示:

对话演示:接下来我们就可以愉快的对话了,效果图下图所示:

到此,DeepSeek R1模型的本地部署以及简单对话应用就完成了!!!

2025-02-08 15:03:44【出处】:https://www.cnblogs.com/qubernet/p/18702147

=======================================================================================

Deepseek本地部署指南:在linux服务器部署,远程open web-ui访问

1. 在Linux服务器上部署DeepSeek模型

要在 Linux 上通过 Ollama 安装和使用模型,您可以按照以下步骤进行操作:

步骤 1:安装 Ollama

-

安装 Ollama:

使用以下命令安装 Ollama:curl -sSfL https://ollama.com/install.sh | sh -

验证安装:

安装完成后,您可以通过以下命令验证 Ollama 是否安装成功:ollama --version

步骤 2:下载模型

ollama run deepseek-r1:32b这将下载并启动DeepSeek R1 32B模型。

DeepSeek R1 蒸馏模型列表

| 模型名称 | 参数量 | 基础架构 | 适用场景 |

|---|---|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | 1.5B | Qwen2.5 | 适合移动设备或资源受限的终端 |

| DeepSeek-R1-Distill-Qwen-7B | 7B | Qwen2.5 | 适合普通文本生成工具 |

| DeepSeek-R1-Distill-Llama-8B | 8B | Llama3.1 | 适合小型企业日常文本处理 |

| DeepSeek-R1-Distill-Qwen-14B | 14B | Qwen2.5 | 适合桌面级应用 |

| DeepSeek-R1-Distill-Qwen-32B | 32B | Qwen2.5 | 适合专业领域知识问答系统 |

| DeepSeek-R1-Distill-Llama-70B | 70B | Llama3.3 | 适合科研、学术研究等高要求场景 |

RTX 4090 显卡显存为 24GB,32B 模型在 4-bit 量化下约需 22GB 显存,适合该硬件。32B 模型在推理基准测试中表现优异,接近 70B 模型的推理能力,但对硬件资源需求更低。

步骤 3:运行模型

ollama run deepseek-r1:32b

通过上面的步骤,已经可以直接在 Linux服务器通过命令行的形式使用Deepseek了。但是不够友好,下面介绍更方便的形式。

2. 在linux服务器配置Ollama服务

1. 设置Ollama服务配置

设置OLLAMA_HOST=0.0.0.0环境变量,这使得Ollama服务能够监听所有网络接口,从而允许远程访问。

sudo vi /etc/systemd/system/ollama.service[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/local/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="OLLAMA_HOST=0.0.0.0"

Environment="PATH=/usr/local/cuda/bin:/home/bytedance/miniconda3/bin:/home/bytedance/miniconda3/condabin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/usr/games:/usr/local/games:/snap/bin"

[Install]

WantedBy=default.target2. 重新加载并重启Ollama服务

sudo systemctl daemon-reload

sudo systemctl restart ollama3. 验证Ollama服务是否正常运行

运行以下命令,确保Ollama服务正在监听所有网络接口:

sudo netstat -tulpn | grep ollama您应该看到类似以下的输出,表明Ollama服务正在监听所有网络接口(0.0.0.0):

tcp 0 0 0.0.0.0:11434 0.0.0.0:* LISTEN - ollama4. 配置防火墙以允许远程访问

为了确保您的Linux服务器允许从外部访问Ollama服务,您需要配置防火墙以允许通过端口11434的流量。

sudo ufw allow 11434/tcp

sudo ufw reload5. 验证防火墙规则

确保防火墙规则已正确添加,并且端口11434已开放。您可以使用以下命令检查防火墙状态:

sudo ufw status状态: 激活

至 动作 来自

- -- --

22/tcp ALLOW Anywhere

11434/tcp ALLOW Anywhere

22/tcp (v6) ALLOW Anywhere (v6)

11434/tcp (v6) ALLOW Anywhere (v6)6. 测试远程访问

在完成上述配置后,您可以通过远程设备(如Mac)测试对Ollama服务的访问。

在远程设备上测试连接:

在Mac上打开终端,运行以下命令以测试对Ollama服务的连接:

curl http://10.37.96.186:11434/api/version显示

{"version":"0.5.7"}测试问答

curl -X POST http://10.37.96.186:11434/api/generate \

-H "Content-Type: application/json" \

-d '{"model": "deepseek-r1:32b", "prompt": "你是谁?"}'显示

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.118616168Z","response":"\u003cthink\u003e","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.150938966Z","response":"\n\n","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.175255854Z","response":"\u003c/think\u003e","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.199509353Z","response":"\n\n","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.223657359Z","response":"您好","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.24788375Z","response":"!","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.272068174Z","response":"我是","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.296163417Z","response":"由","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.320515728Z","response":"中国的","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.344646528Z","response":"深度","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.36880216Z","response":"求","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.393006489Z","response":"索","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.417115966Z","response":"(","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.441321254Z","response":"Deep","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.465439117Z","response":"Seek","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.489619415Z","response":")","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.51381827Z","response":"公司","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.538012781Z","response":"开发","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.562186246Z","response":"的","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.586331325Z","response":"智能","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.610539651Z","response":"助手","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.634769989Z","response":"Deep","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.659134003Z","response":"Seek","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.683523205Z","response":"-R","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.70761762Z","response":"1","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.731953604Z","response":"。","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.756135462Z","response":"如","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.783480232Z","response":"您","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.807766337Z","response":"有任何","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.831964079Z","response":"任何","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.856229156Z","response":"问题","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.880487159Z","response":",","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.904710537Z","response":"我会","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.929026993Z","response":"尽","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.953239249Z","response":"我","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:15.977496819Z","response":"所能","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:16.001763128Z","response":"为您提供","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:16.026068523Z","response":"帮助","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:16.050242581Z","response":"。","done":false}

{"model":"deepseek-r1:32b","created_at":"2025-02-06T00:47:16.074454593Z","response":"","done":true,"done_reason":"stop","context":[151644,105043,100165,30,151645,151648,271,151649,198,198,111308,6313,104198,67071,105538,102217,30918,50984,9909,33464,39350,7552,73218,100013,9370,100168,110498,33464,39350,12,49,16,1773,29524,87026,110117,99885,86119,3837,105351,99739,35946,111079,113445,100364,1773],"total_duration":3872978599,"load_duration":2811407308,"prompt_eval_count":6,"prompt_eval_duration":102000000,"eval_count":40,"eval_duration":958000000}通过上述步骤,已经成功在Linux服务器上配置了Ollama服务,并通过Mac远程访问了DeepSeek模型。接下来,将介绍如何在Mac上安装Web UI,以便更方便地与模型进行交互。

3. 在Mac上安装Web UI

为了更方便地与远程Linux服务器上的DeepSeek模型进行交互,可以在Mac上安装一个Web UI工具。这里我们推荐使用 Open Web UI,它是一个基于Web的界面,支持多种AI模型,包括Ollama。

1. 通过conda安装open-webui

打开终端,运行以下命令创建一个新的conda环境,并指定Python版本为3.11:

conda create -n open-webui-env python=3.11

conda activate open-webui-env

pip install open-webui2. 启动open-webui

open-webui serve

3. 浏览器访问

http://localhost:8080/-

使用管理员身份(第一个注册用户)登录

-

在Open webui界面中,依次点击“展开左侧栏”(左上角三道杠)–>“头像”(左下角)–>管理员面板–>设置(上侧)–>外部连接

-

在外部连接的Ollama API一栏将switch开关打开,在栏中填上http://10.37.96.186:11434(这是我的服务器地址)

-

点击右下角“保存”按钮

-

点击“新对话”(左上角),确定是否正确刷出模型列表,如果正确刷出,则设置完毕。

4. 愉快的使用本地deepseek模型

2025-02-14 19:54:43【出处】:https://blog.csdn.net/qq_34941290/article/details/145465550

=======================================================================================

Ollama+Docker+OpenWebUI 的安装

安装Ollama

下载Ollama

登录 Ollama官网(https://ollama.com/) 下载 Ollama。

安装 Ollama

Ollama默认各位置:

默认安装后的目录:C:\Users\username\AppData\Local\Programs\Ollama

默认安装的模型目录:C:\Users\username\ .ollama

默认的配置文件目录:C:\Users\username\AppData\Local\Ollama因为 Ollama 安装过程中不支持修改以后模型目录的下载位置,所以安装前需要修改系统环境变量:

安装完成之后打开终端,查看安装版本:

ollama -v下载模型

在 https://ollama.com/search 搜索需要下载的模型.

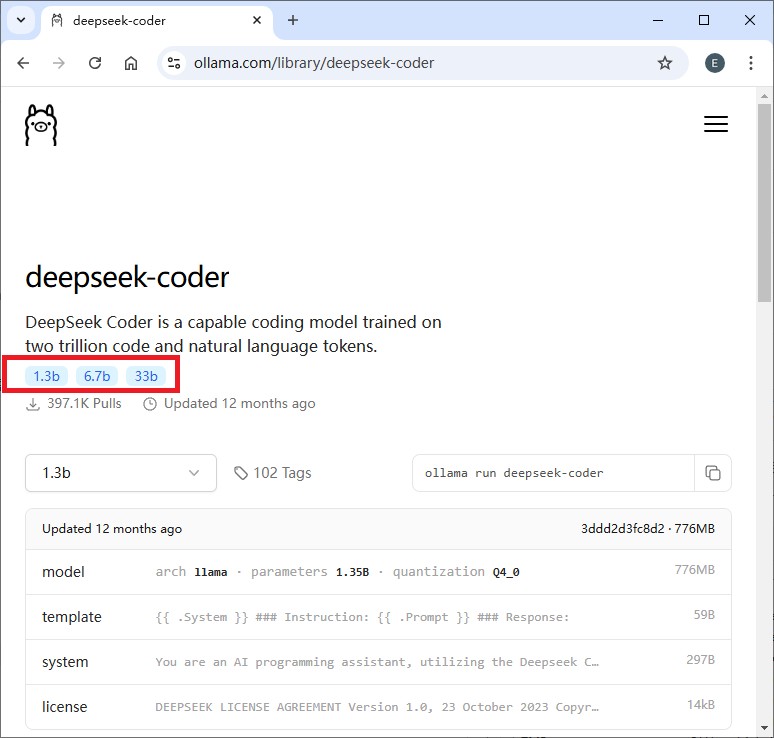

例如,想下载 deepseek-coder ,那么就搜索 deepseek-coder,那么会看到有三种参数:

假如想下载 33b 的 deepseek-codere,那么就可以运行:

ollama run deepseek-coder:33b安装 Docker

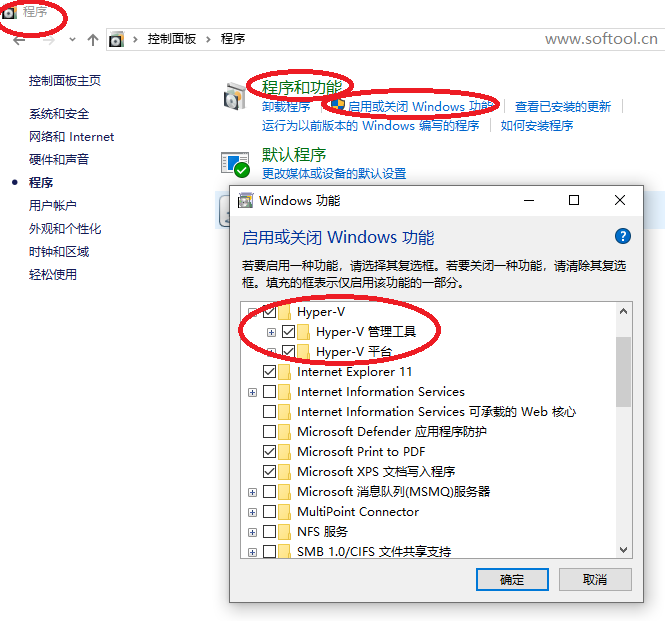

开启 Windows 系统虚拟化

勾选Hyper-V选项

官网下载Docker:

https://docs.docker.com/desktop/setup/install/windows-install/

一路安装。

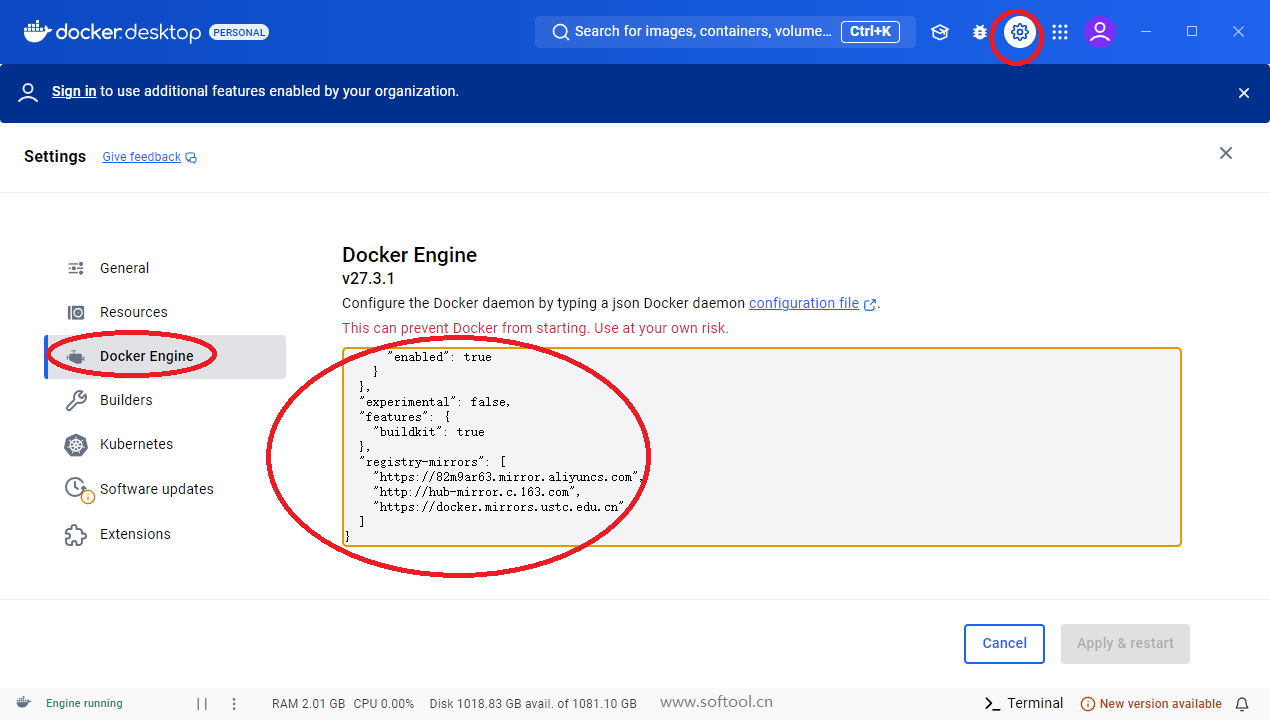

配置国内镜像源:

{

"builder": {

"gc": {

"defaultKeepStorage": "20GB",

"enabled": true

}

},

"experimental": false,

"features": {

"buildkit": true

},

"registry-mirrors": [

"https://82m9ar63.mirror.aliyuncs.com",

"http://hub-mirror.c.163.com",

"https://docker.mirrors.ustc.edu.cn"

]

}安装 OpenWebUI

下载地址: https://github.com/open-webui/open-webui

运行下面的命令之前,先启动 docker。

我使用的终端命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main浏览器地址栏访问: http://localhost:3000/

第一次注册即可(注册内容保存在本地)。

注册成功,左上角可选择自己的大模型。

效果演示:

参考源:https://blog.csdn.net/weixin_43012017/article/details/138253446

如果,您希望更容易地发现我的新博客,不妨点击一下绿色通道的【关注我】。(●'◡'●)

因为,我的写作热情也离不开您的肯定与支持,感谢您的阅读,我是【Jack_孟】!

本文来自博客园,作者:jack_Meng,转载请注明原文链接:https://www.cnblogs.com/mq0036/p/18704336

【免责声明】本文来自源于网络,如涉及版权或侵权问题,请及时联系我们,我们将第一时间删除或更改!

浙公网安备 33010602011771号

浙公网安备 33010602011771号