经典网络结构(二)AlexNet

一、 前言

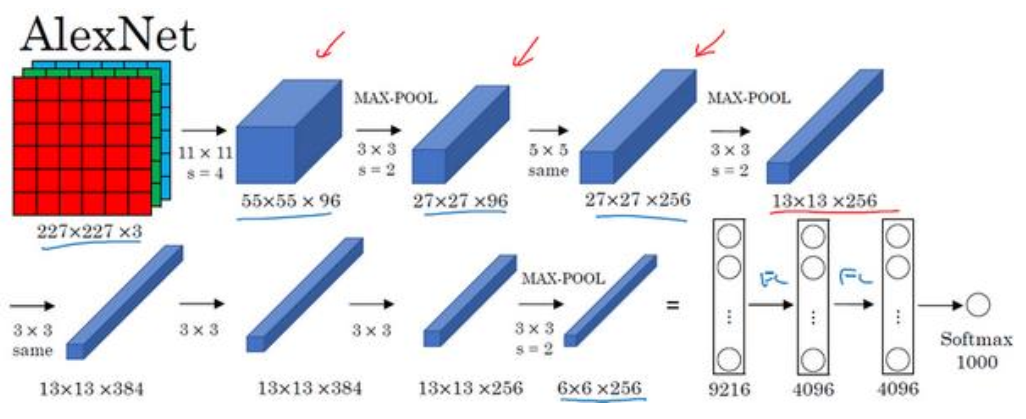

8层,5卷积,3全连接。卷积层与卷积层之间采用了padding操作

AlexNet是2012年ImageNet竞赛冠军获得者Hinton和他的学生Alex Krizhevsky设计的。也是在那年之后,更多的更深的神经网路被提出,比如优秀的vgg,GoogleLeNet。

二、 AlexNet网络基本结构

论文中给出的输入图像时224*224*3,227*227*3的输入是优化后的输入尺寸。

下图展示出来的是caffe中的AlexNet的网络结构,采用的是两台GPU服务器,所以看到流程图中包含两列,其将卷积操作和池化操作都均分为两个部分,分配给两个GPU进行操作。(卷积核和池化操作各自之间是独立的)

AlexNet取得比较好的结果的原因:

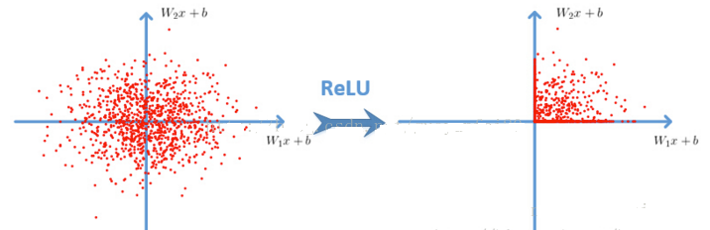

1. 使用了ReLU激活函数,替换了LeNet中使用的sigmoid/tanh激活函数。而且由于ReLU函数形式简单,也会加快训练的过程。

2. 在全连接层使用了Dropout操作进行正则化,防止模型在训练过程中过拟合。

3. 局部相应归一化层(Local response normalization, LRN),目的是为了减少高激活神经元的数量。但研究员发现此设计作用并不大,已不再使用。

4. 损失函数添加正则项

作者:墨殇浅尘

-------------------------------------------

算法届的小学生,虔诚而不迷茫,做一个懂生活并有趣的人!

如果觉得这篇文章对你有小小的帮助的话,记得在右下角点个 [推荐] 噢! 欢迎共同交流机器学习,机器视觉,深度学习~

欢迎转载,转载请声明出处!

浙公网安备 33010602011771号

浙公网安备 33010602011771号