函数

1.3.3 tanh函数

𝑓(𝑥)=tanh(𝑥)=21+𝑒−2𝑥−1=2sigmoid(2𝑥)−1tanh𝑥=𝑒𝑥−𝑒−𝑥𝑒𝑥+𝑒−𝑥f(x)=tanh(x)=21+e−2x−1=2sigmoid(2x)−1tanhx=ex−e−xex+e−x

这个tanh函数又被称作双曲正切函数,可以看出它的函数范围是(-1,1)而均值为0。

缺点:该函数依旧没有解决梯度消失和幂运算的问题。

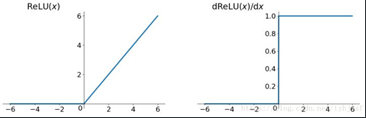

1.3.4 ReLu函数

ReLu函数是当前最常用的一个激活函数,尤其是在卷积神经网络和层次较深的神经网络中。

Relu =max(0,𝑥) Relu =max(0,x)

优点:

- 解决了gradient vanishing问题 (在正区间),因为大于0的梯度始终为1

- 计算速度非常快,只需要判断输入是否大于0,不含数学运算

- 收敛速度远快于 sigmoid 和 tanh

缺点:对于小于0的这部分值,梯度会迅速降为0而不再影响网络训练。这会造成部分神经元从来不被激活,也称作“死区”。

浙公网安备 33010602011771号

浙公网安备 33010602011771号