Motivation

- Facebook 的 MetaICL,牛逼就对了;

- 对 LM 针对 ICL 进行微调(而不是特定的任务);

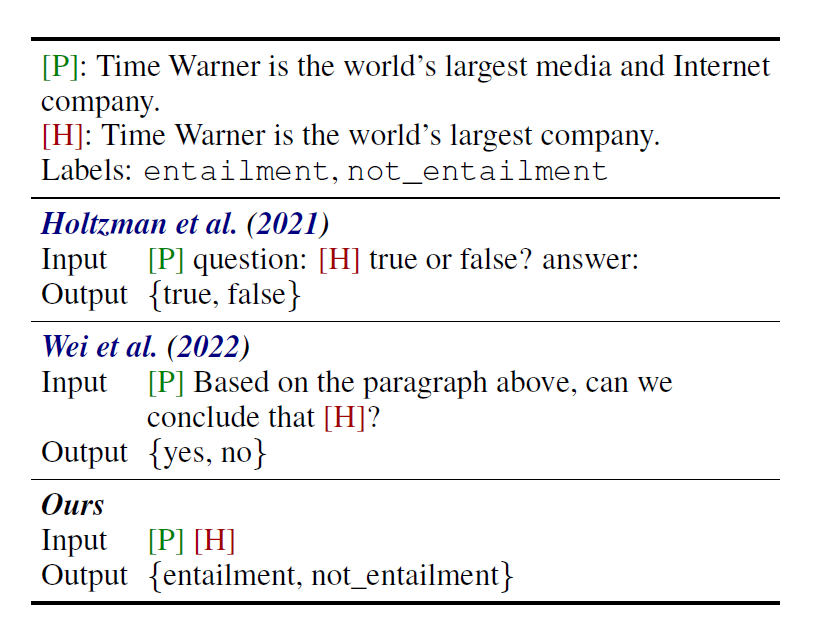

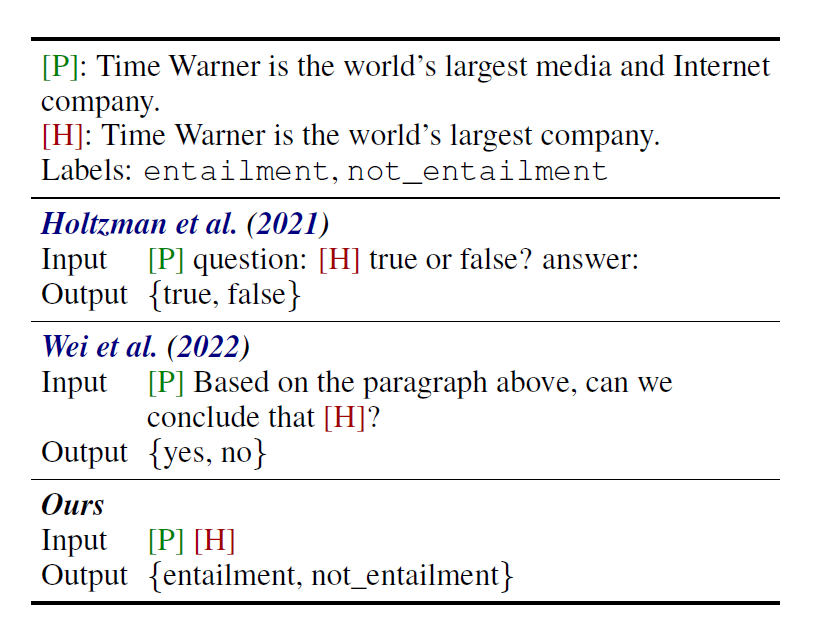

- 去除了自然语言的 Template,使用更直接的方式,排除了 Template 设计对 output distribution 造成的影响,让模型自己推测要进行的任务(所以感觉这种方式无法进行 Zero-Shot 了?):

- $$former:\;This\;movie \;is \;funny, \;so \;my \;altitude \;towards \;this \;movie \;is <positive>$$

- $$now:\;Iput: \;This \;movie\; is \;funny. \;output:\;<positive>$$

- Noisy Channel 模式;(这里应该有个链接但是相关的文章我还没看🤣)

Analysis

- 为了验证 Meta-training 确实很行,提出了三种实验设置:

- $HR\rightarrow LR$ 训练集很大,验证集很小;

- $X\rightarrow X$ 训练任务和测试任务一样;

- $Non-X\rightarrow X$ 训练任务和测试任务不一样(这个表现好说明泛化能力很强)。

posted @

2022-10-17 20:51

MetaZ

阅读(

147)

评论()

收藏

举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号