Ollama的安装及AI人工智能本地大模型的部署

手动部署最简单的方式就是使用Ollama,这是一个帮助你部署和运行大模型的工具。官网如下:

首先,我们需要下载一个Ollama的客户端,在官网提供了各种不同版本的Ollama,大家可以根据自己的需要下载。

下载后双击即可安装。

注意:Ollama默认安装目录是C盘的用户目录,如果想安装到其他盘中,就不能直接双击安装了。需要通过命令行安装。

具体操作如下:

在OllamaSetup.exe所在目录打开cmd命令行,然后命令如下:

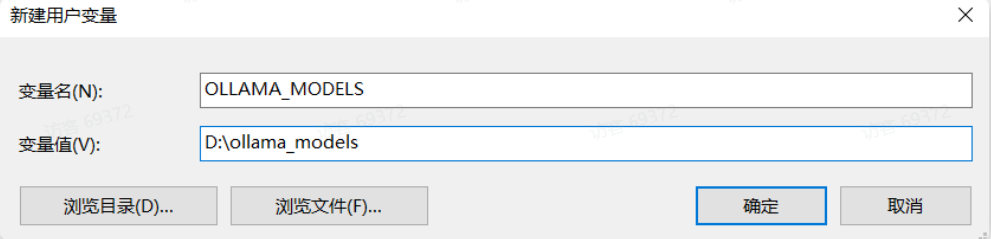

OllamaSetup.exe /DIR=你要安装的目录位置安装完成后,还需要配置一个环境变量,更改Ollama下载和部署模型的位置。环境变量如下:

OLLAMA_MODELS=你想要保存模型的目录环境变量配置方式相信学过Java的都知道,配置完成如图:

打开控制台,输入Ollama help 列举相应的操作命令即安装成功。

ollama serve # Start ollama

ollama create # Create a model from a Modelfile

ollama show # Show information for a model

ollama run # Run a model

ollama stop # Stop a running model

ollama pull # Pull a model from a registry

ollama push # Push a model to a registry

ollama list # List models

ollama ps # List running models

ollama cp # Copy a model

ollama rm # Remove a model

ollama help # Help about any command

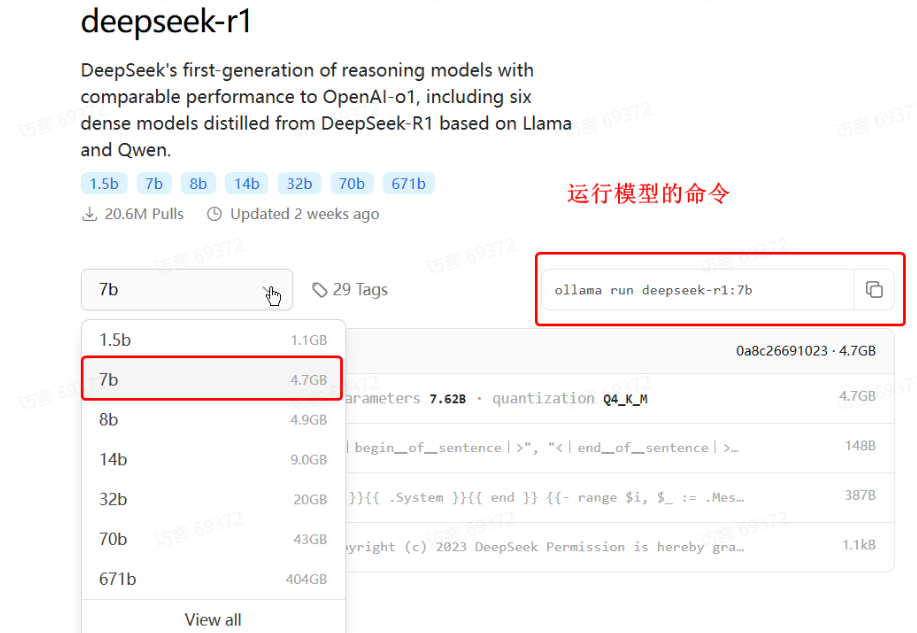

注意事项:- 首次运行命令需要下载模型,根据模型大小不同下载时长在5分钟~1小时不等,请耐心等待下载完成。

- ollama控制台是一个封装好的AI对话产品,与ChatGPT类似,具备会话记忆功能。

选择自己合适的模型后,ollama会给出运行模型的命令:

Ollama在本地部署时,会自动提供模型对应的Http接口,访问地址是:http://localhost:11434/api/chat

接口说明

- 请求方式:通常是POST,因为要传递JSON风格的参数

-

请求URL:与平台有关

- DeepSeek官方平台:https://api.deepseek.com/chat/completions

- 阿里云百炼平台:https://dashscope.aliyuncs.com/compatible-mode/v1

- 本地ollama部署的模型:http://localhost:11434

-

请求头:开放平台都需要提供API_KEY来校验权限,本地ollama则不需要

- Content-Type: application/json,请求参数的格式,必须是application/json,稍后解释

- Authorization: Bearer <DeepSeek API Key>,上一节创建的API_KEY

-

请求参数:JSON格式:

{

"model": "deepseek-chat",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"},

{"role": "assistant", "content": "你好,我叫令狐冲"}

],

"stream": false

}model:模型名称,DeepSeek支持deepseek-reasoner和deepseek-chat两者模型-

messages:发送给大模型的消息,[]是数组的意思,里面可以有多条消息。消息结构:content:是消息的内容-

role:消息的角色,有system、user、assisant三种角色system:是给大模型设定一个角色,比如你让她扮演你的奶奶,让她哄你睡觉user:就是用户提问的问题assistant:是大模型的回答

stream:true,代表响应结果流式返回;false,代表响应结果一次性返回,但需要等待。

下面就自己动手试下吧~~

浙公网安备 33010602011771号

浙公网安备 33010602011771号