有关GBDT(Gradient Boosting Decison Tree,梯度提升树)

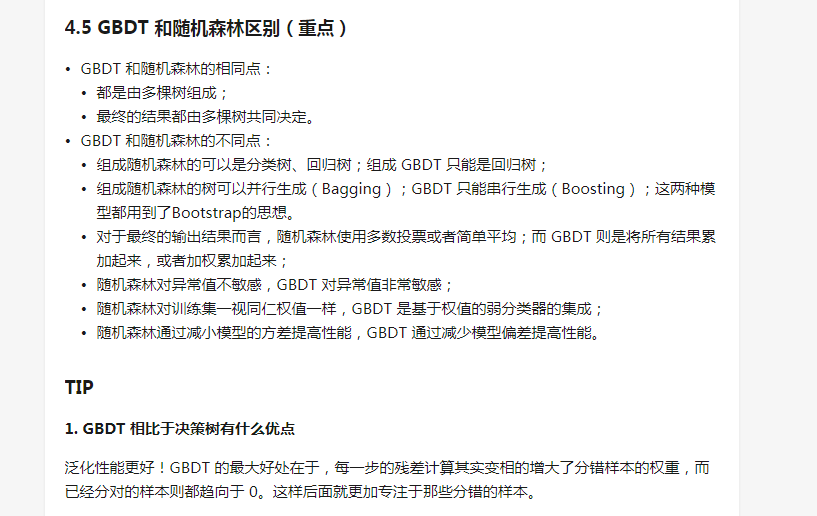

集成学习有两大家族,Bagging家族与Boosting家族;相同家族的算法,思想有类似之处,例如Bagging家族主要并行思想,典型代表:随机森林;Boosting家族主要是串行思想,主要代表有AdaBoost,GBDT.

AdaBoost与GBDT虽都是Boosting家族,但是还是有一定的区别。先说常说的AdaBoost,它的思想是通过前一轮的弱学习器的误差率改变训练数据集的权重;GBDT是用前一轮的弱学习器的残差再去训练学习器。

此处主要讲解GBDT,注意GBDT中的弱学习器特指决策树,并且特指CART决策树。所以得先了解CART,主要看这里与辅看这里。对于GBDT原理部分主要看这里与这里。关于它的应用与调参数,看这里。

关于GBDT,它既可以回归,也可以分类。除了上面的知识,还得了解一些

浙公网安备 33010602011771号

浙公网安备 33010602011771号