卷积神经网络

卷积神经网络

一、卷积神经网络的特点:

- 平移不变性(translation invariance):不管检测对象出现在图像中的哪个位置,神经网络的前面几层应该对相同的图像区域具有相似的反应,即为“平移不变性”。

- 局部性(locality):神经网络的前面几层应该只探索输入图像中的局部区域,而不过度在意图像中相隔较远区域的关系,这就是“局部性”原则。最终,可以聚合这些局部特征,以在整个图像级别进行预测。

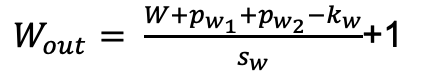

二、模型:

2.1 模型介绍

每个阶段用到的Layer

2.2 模型详解

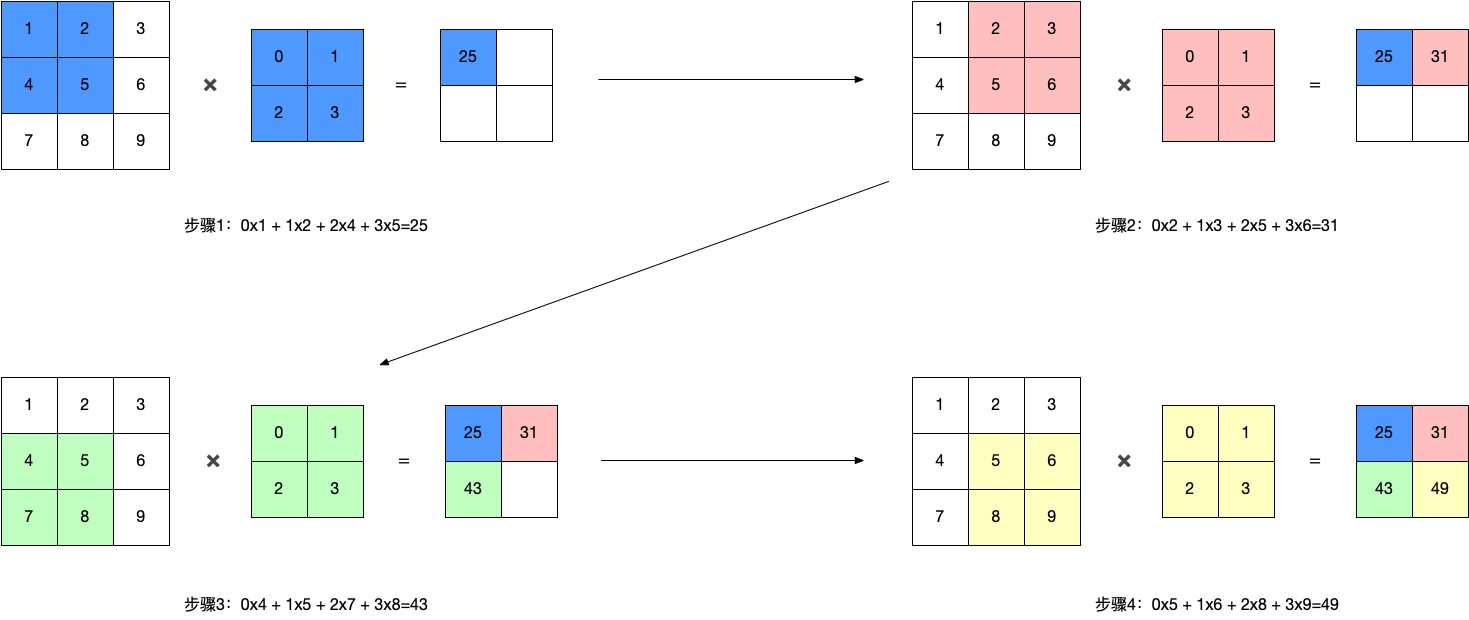

- 卷积操作:

- 单通道卷积:\(y=w*x+b(x是输入,y是输出,w是卷积核,b是贝叶斯)\)

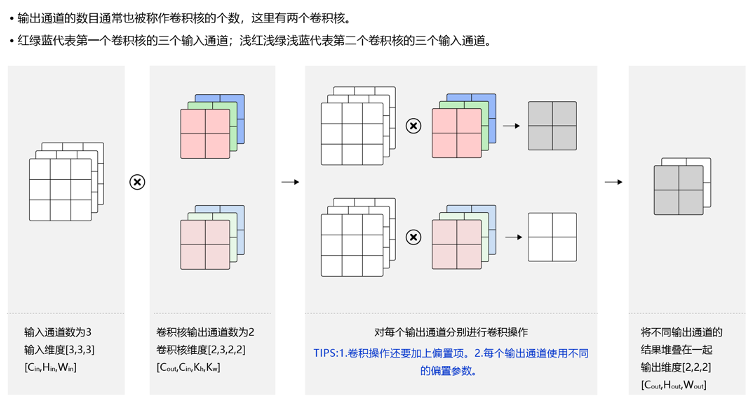

- 多通道卷积

这里多通道对应的卷积核也是相应维度的,分别计算出对应维度的结果如何把对应位置的加起来就是最后输出的降维结果

1101 = 805 + 271 + 25

这里三通道的数据经过一个卷积核得到了一个单通道的表示

- 多通道输出

通过多个卷积核得到多个特征然后再堆叠得到一个多通道的输出Batch

卷积核信息不变,卷积操作会多一定的倍数(和样本数有关)。

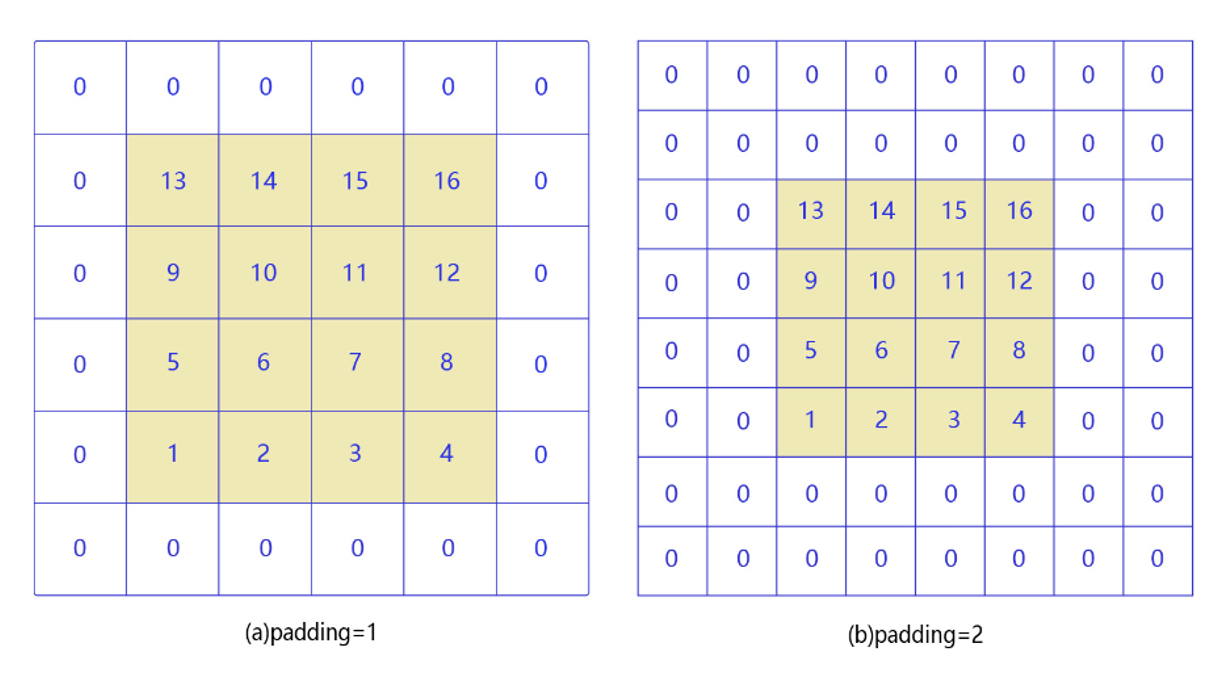

- 填充操作(padding)

角落边缘的像素,只被一个过滤器输出所使用,因为它位于这个3×3的区域的一角。但如果是在中间的像素点,就会有许多3×3的区域与之重叠。所以那些在角落或者边缘区域的像素点在输出中采用较少,意味着你丢掉了图像边缘位置的许多信息。

使用填充的好处:

- 在原图像外围以0进行填充,在不影响特征提取的同时,增加了对边缘信息的特征提取。

- 在做卷积操作时,每经过一次卷积输入图像大小就会变小,最后经过多次卷积后图像可能会变得特别小,如果不希望图像变小的话就可以通过填充操作。

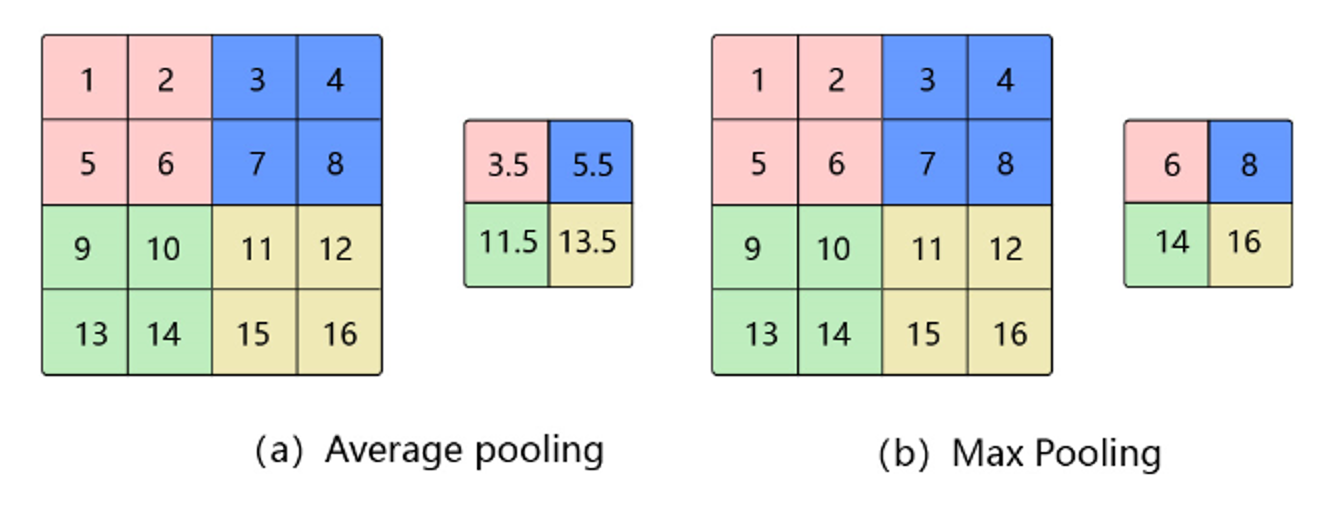

- 池化层(pooling)

池化是使用某一位置的相邻输出的总体统计特征代替网络在该位置的输出,其好处是当输入数据做出少量平移时,经过池化函数后的大多数输出还能保持不变。比如:当识别一张图像是否是人脸时,我们需要知道人脸左边有一只眼睛,右边也有一只眼睛,而不需要知道眼睛的精确位置,这时候通过池化某一片区域的像素点来得到总体统计特征会显得很有用。由于池化之后特征图会变得更小,如果后面连接的是全连接层,能有效的减小神经元的个数,节省存储空间并提高计算效率.

池化的作用 池化层是特征选择和信息过滤的过程,过程中会损失一部分信息,但是会同时会减少参数和计算量,在模型效果和计算性能之间寻找平衡,随着运算速度的不断提高,慢慢可能会有一些设计上的变化,现在有些网络已经开始少用或者不用池化层。

平均池化(Avg Pooling)

对邻域内特征点求平均

- 优缺点:能很好的保留背景,但容易使得图片变模糊

- 正向传播:邻域内取平均

- 反向传播:特征值根据领域大小被平均,然后传给每个索引位置

最大池化(Max Pooling)

对邻域内特征点取最大

- 优缺点:能很好的保留一些关键的纹理特征,现在更多的再使用Max Pooling而很少用Avg Pooling

- 正向传播:取邻域内最大,并记住最大值的索引位置,以方便反向传播

- 反向传播:将特征值填充到正向传播中,值最大的索引位置,其他位置补0

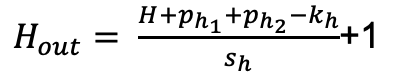

计算结果的大小公示

2.3. 模型实现

network_2 = nn.Sequential(

nn.Conv2D(in_channels=1, out_channels=6, kernel_size=3, stride=1, padding=1),

nn.ReLU(),

nn.MaxPool2D(kernel_size=2, stride=2),

nn.Conv2D(in_channels=6, out_channels=16, kernel_size=5, stride=1, padding=0),

nn.ReLU(),

nn.MaxPool2D(kernel_size=2, stride=2),

nn.Flatten(),

nn.Linear(in_features=400, out_features=120), # 400 = 5x5x16,输入形状为32x32, 输入形状为28x28时调整为256

nn.Linear(in_features=120, out_features=84),

nn.Linear(in_features=84, out_features=10)

)

2.4. 模型可视化

paddle.summary(network_2, (1, 1, 28, 28))

---------------------------------------------------------------------------

Layer (type) Input Shape Output Shape Param #

===========================================================================

Conv2D-49 [[1, 1, 28, 28]] [1, 6, 28, 28] 60

ReLU-13 [[1, 6, 28, 28]] [1, 6, 28, 28] 0

MaxPool2D-13 [[1, 6, 28, 28]] [1, 6, 14, 14] 0

Conv2D-50 [[1, 6, 14, 14]] [1, 16, 10, 10] 2,416 # 16(卷积核个数)X6(卷积核通道 数)X5X5+16(偏置项)

ReLU-14 [[1, 16, 10, 10]] [1, 16, 10, 10] 0

MaxPool2D-14 [[1, 16, 10, 10]] [1, 16, 5, 5] 0

Flatten-10972 [[1, 16, 5, 5]] [1, 400] 0

Linear-43 [[1, 400]] [1, 120] 48,120

Linear-44 [[1, 120]] [1, 84] 10,164

Linear-45 [[1, 84]] [1, 10] 850

===========================================================================

Total params: 61,610

Trainable params: 61,610

Non-trainable params: 0

---------------------------------------------------------------------------

Input size (MB): 0.00

Forward/backward pass size (MB): 0.11

Params size (MB): 0.24

Estimated Total Size (MB): 0.35

---------------------------------------------------------------------------

{'total_params': 61610, 'trainable_params': 61610}

卷积神经网络的简单介绍

卷积神经网络的简单介绍

浙公网安备 33010602011771号

浙公网安备 33010602011771号