GPT前世今生-transformer

GPT前世今生-transformer

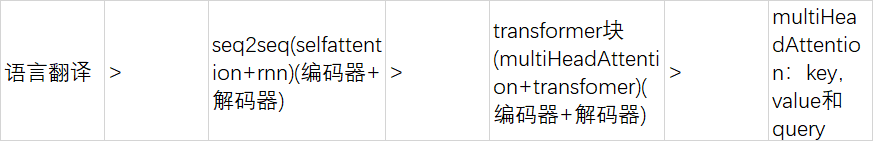

路线: hugging(tang)->transformer(tang)-> GPT2

NLP 中的transformer 都是分类问题

hugging中 怎么查预训练模型。

FAQ

1 多头注意力机制中什么是key,value和query?

答:

在Transformer中的多头注意力机制中,每个头都会有自己的“key(键)”、“value(值)”和“query(查询)”向量。它们的作用如下:

- Query:用来产生注意力分数的向量,可以理解为是要查询的信息,对于每个头来说是不同的,可以通过线性变换从输入向量得到。

- Key:用来计算注意力分数的向量,可以理解为是提供了对输入信息的某种描述,同样对于每个头来说是不同的,可以通过线性变换从输入向量得到。

- Value:作为每个头注意力机制的输出,是权重计算的结果,代表了输入信息的某种表示,同样对于每个头来说是不同的,可以通过线性变换从输入向量得到。 在多头注意力机制中,每个头都会产生一组注意力分数,然后将这些分数进行加权平均,得到最终的注意力表示。这样做的好处在于,每个头可以关注输入向量的不同方面,从而产生更加丰富的表达能力。同时,多头注意力机制也可以并行计算,进一步提高计算效率。

浙公网安备 33010602011771号

浙公网安备 33010602011771号