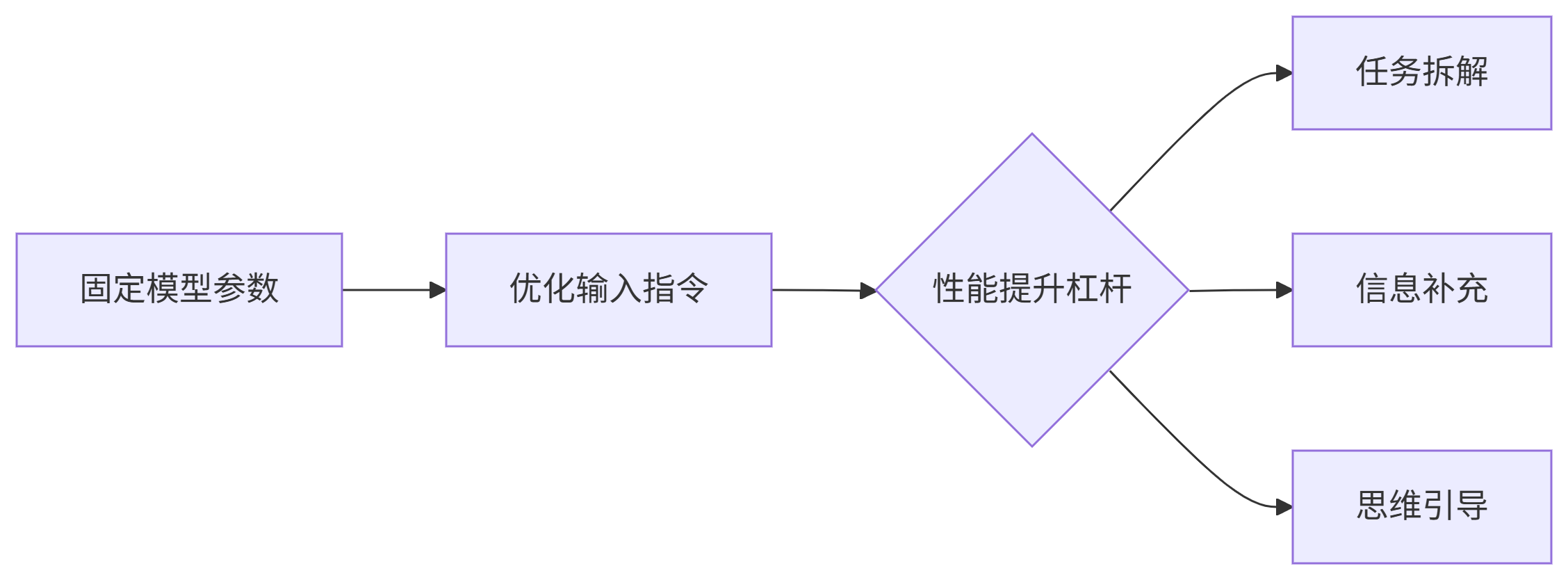

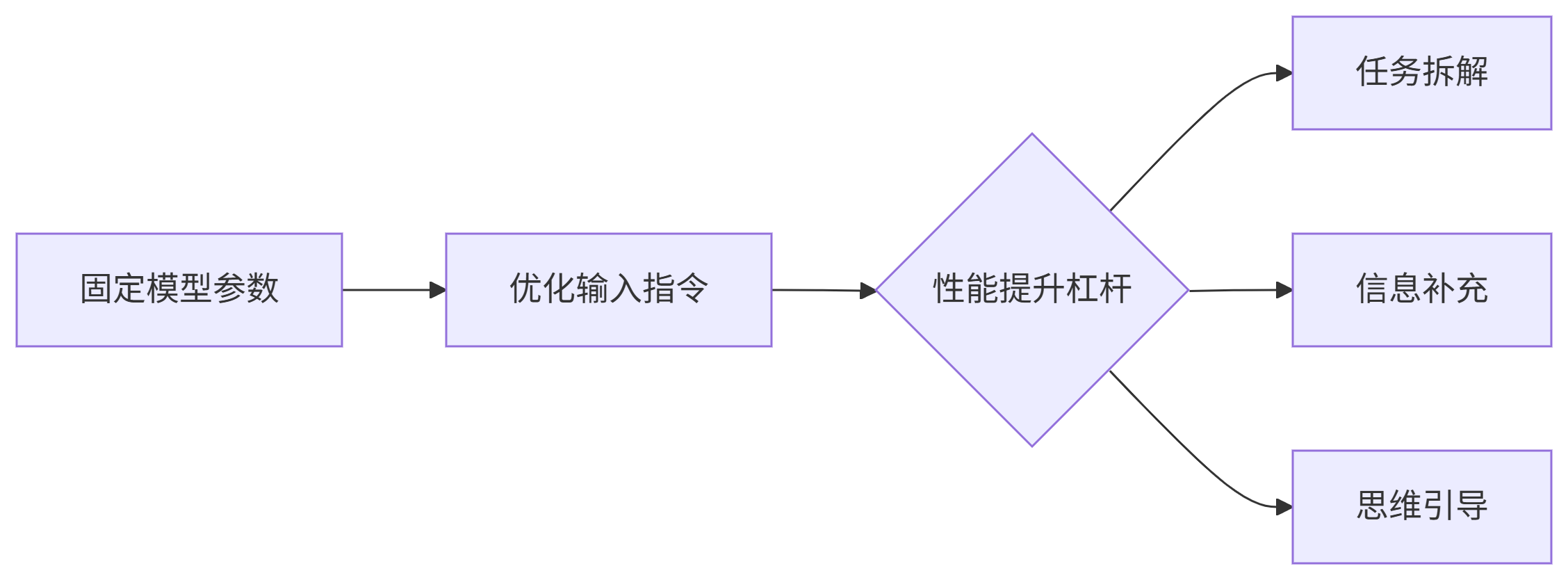

不调参的模型强化术

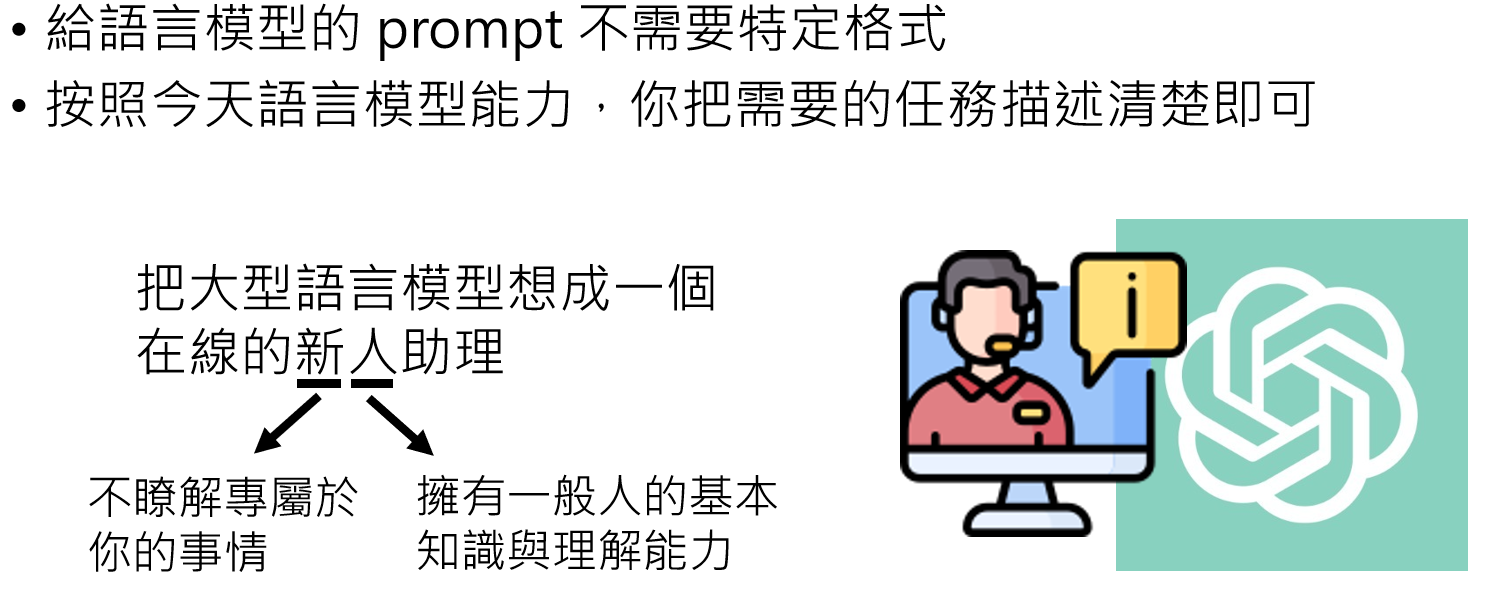

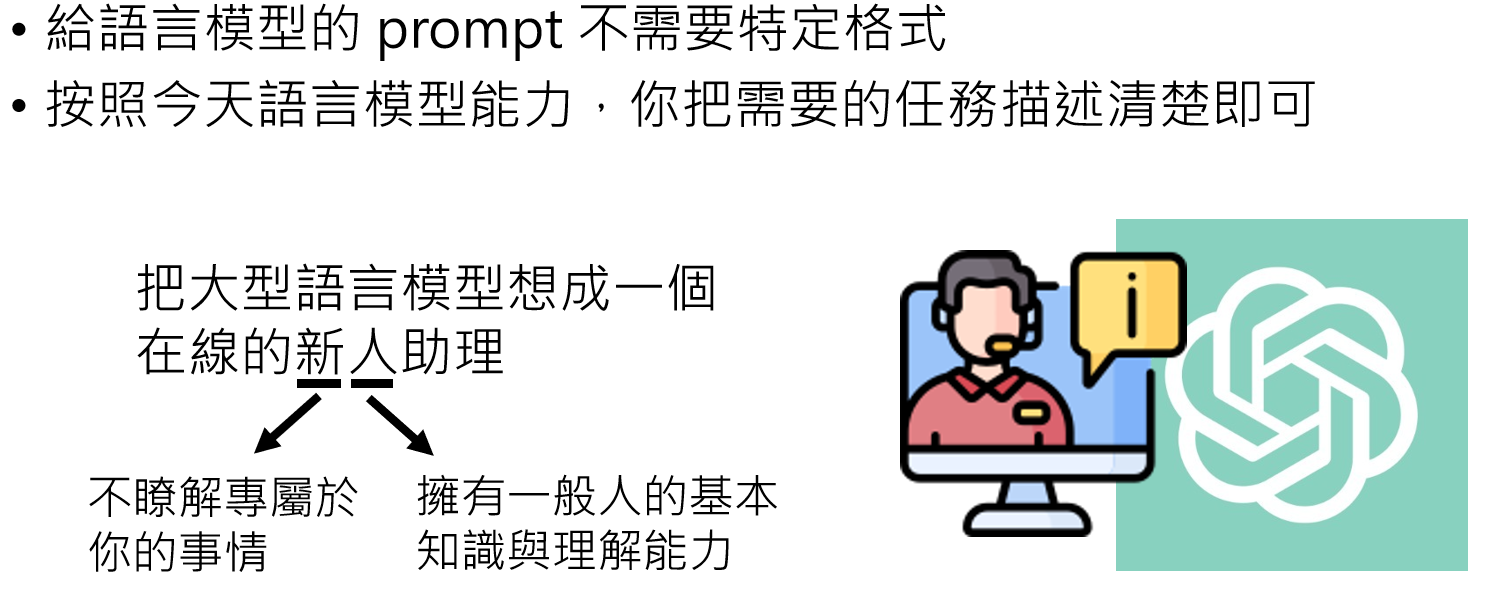

- 核心目标:在不训练模型的前提下,通过优化给语言模型的提示(Prompt)来提升其表现。

- 关键特点:

- 不针对特定任务设计固定格式的提示,重点是清晰描述任务需求;

- 可将大型语言模型视为 “在线新人助理”—— 具备基本常识和理解能力,但不了解用户专属信息,需通过提示引导其发挥能力。

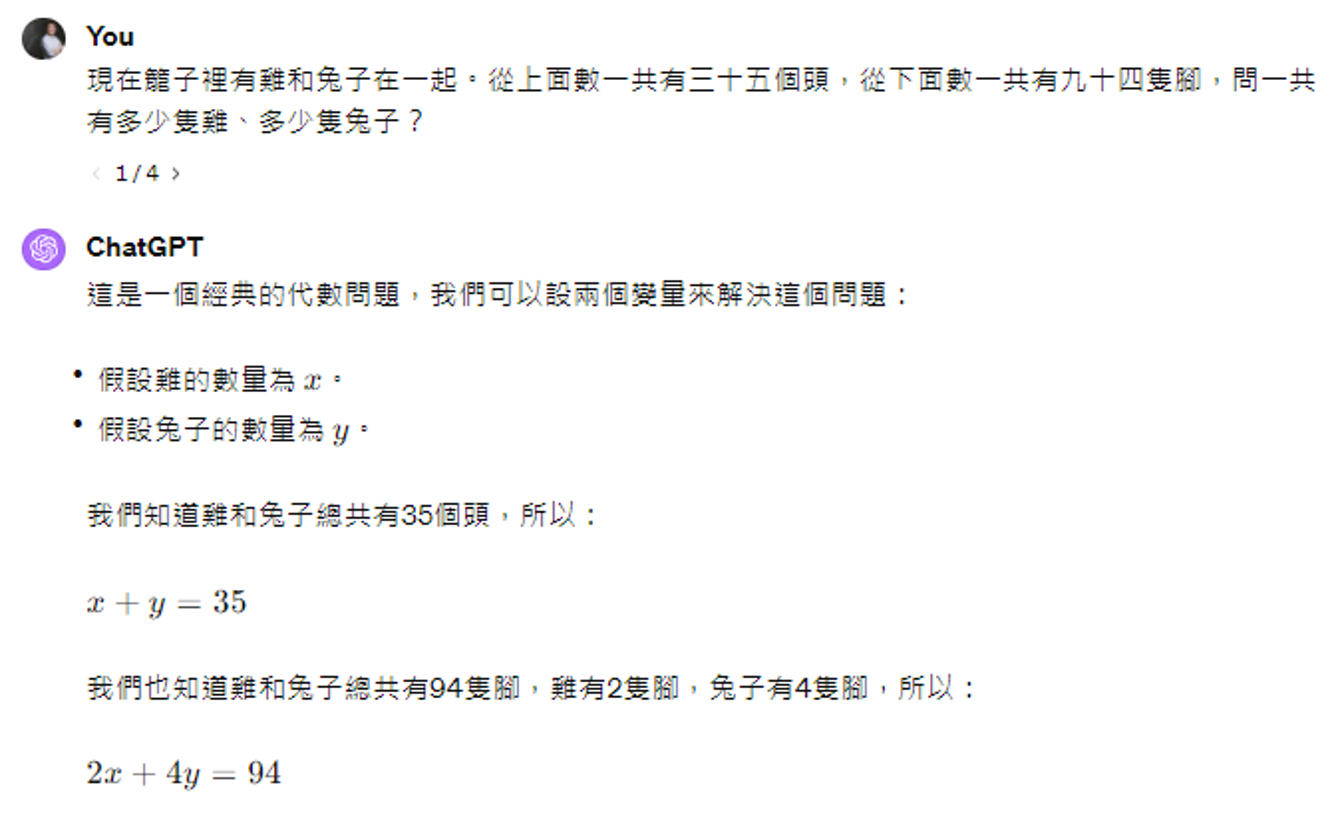

通过特定提示语激发模型的推理能力,本质是促使模型逐步分析问题,提升回答准确性。

- 典型案例:

-

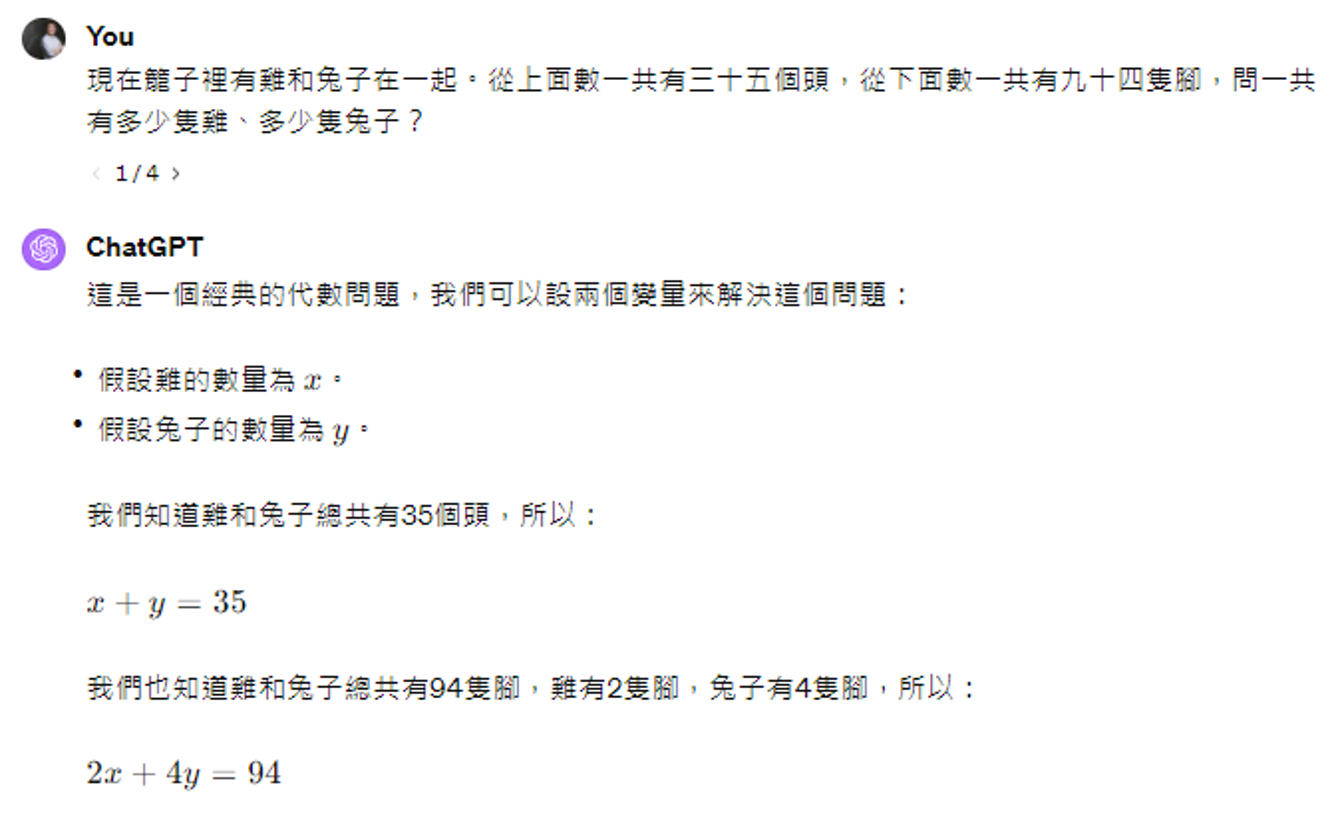

思维链(Chain of Thought):本质也是一种任务分解

对数学问题使用 “Let's think step by step”(让我们逐步思考),可显著提高 GPT 等模型的准确率(如 GPT 3.5 在有无该提示时准确率从 72% 提升至 88%);

- 其他有效提示如 “Take a deep breath and work on this problem step-by-step”(深呼吸,逐步解决问题)、“Break this down”(拆解问题)等。

-

让模型解释一下自己的答案

- 对模型进行情绪勒索

- 注意事项:

- 咒语效果因模型而异,对 GPT-4 等新版本模型,有无咒语的差异可能缩小(如 2024 年 GPT 3.5 新版本无咒语时准确率已达 85%,接近有咒语的 89%);

- 无需使用礼貌用语(如 “please”“thank you”),使用肯定指令(如 “do”)比否定指令(如 “don't”)更有效,甚至可加入 “你会被惩罚”“我会给小费” 等激励 / 约束性语句。

- 进阶方式:用 AI 找咒语,例如通过强化学习(RL)或其他语言模型生成最优提示(如用增强式学习找到让 GPT-3 输出更长回答的提示)。

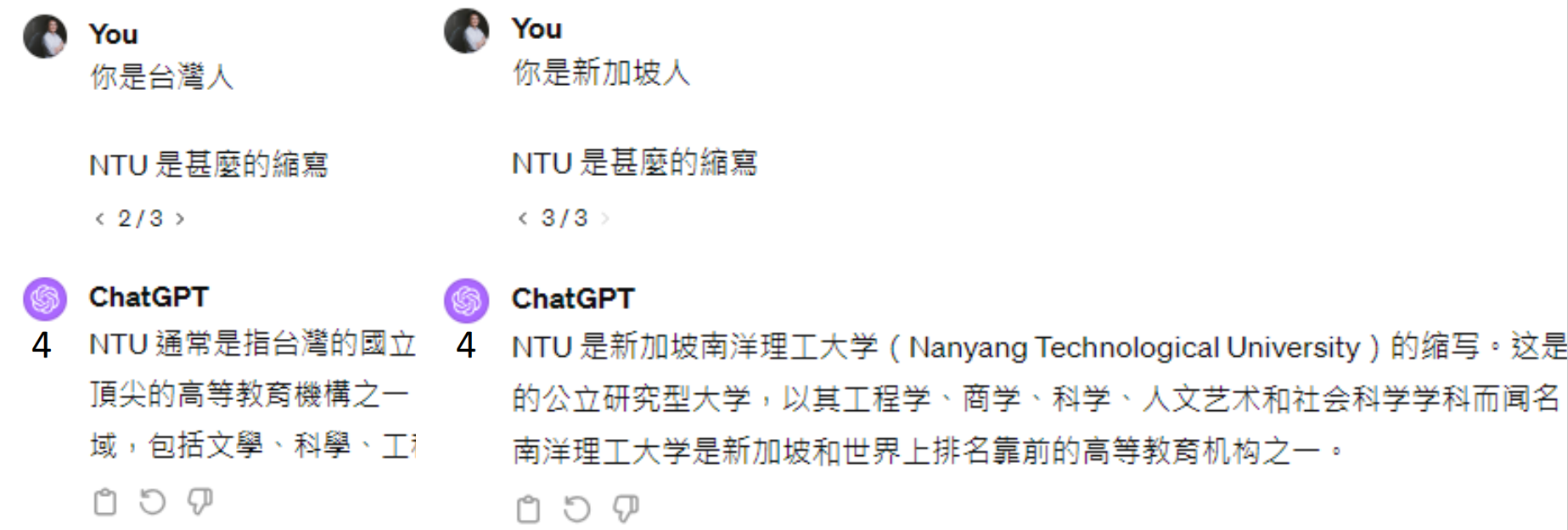

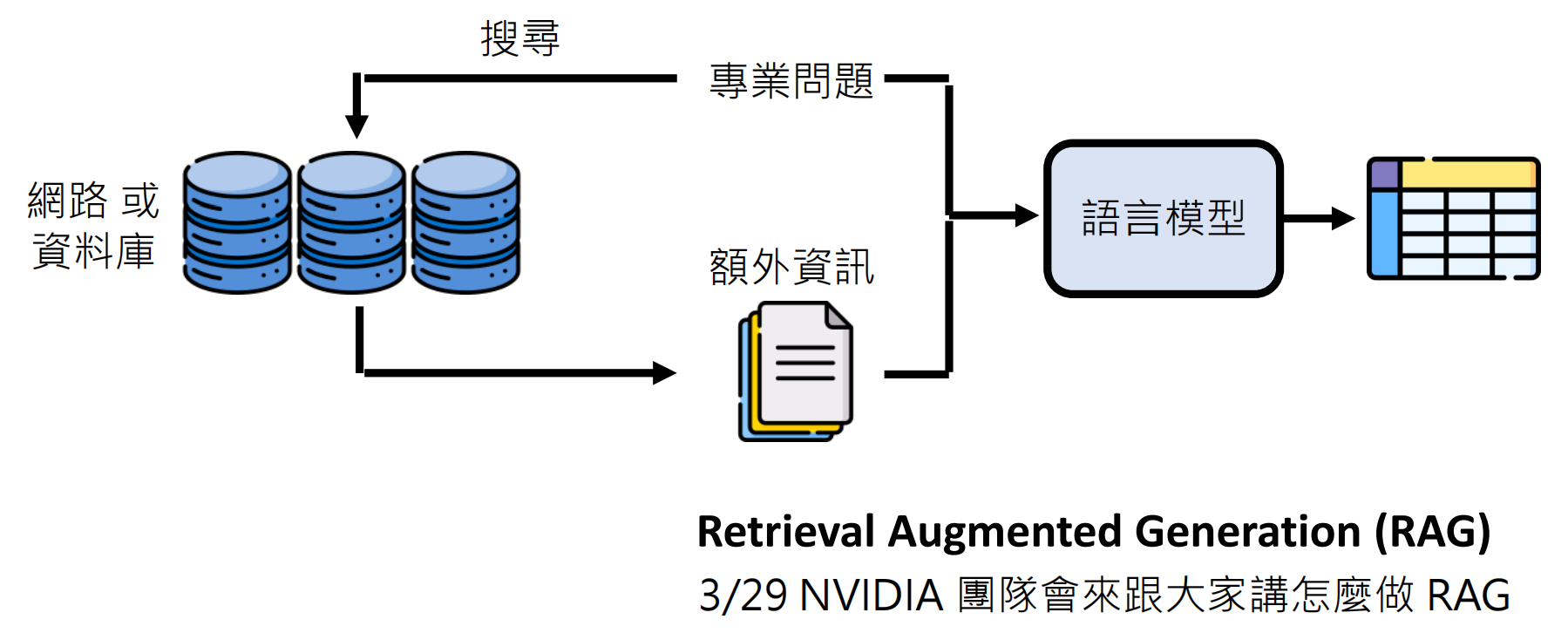

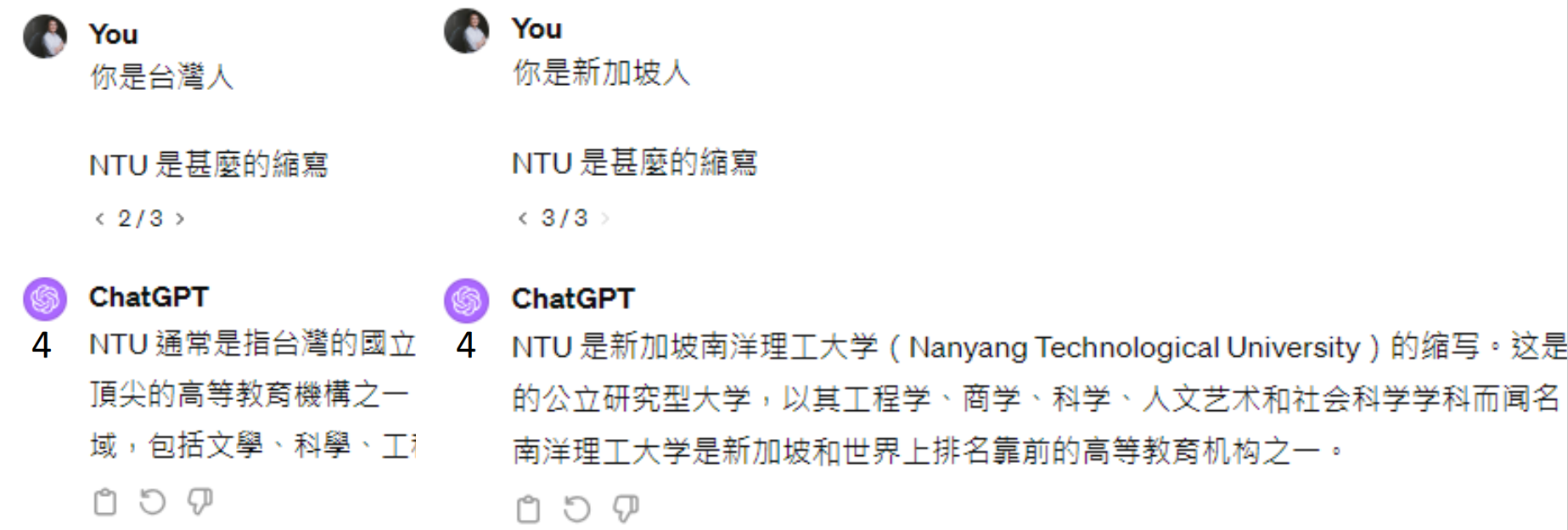

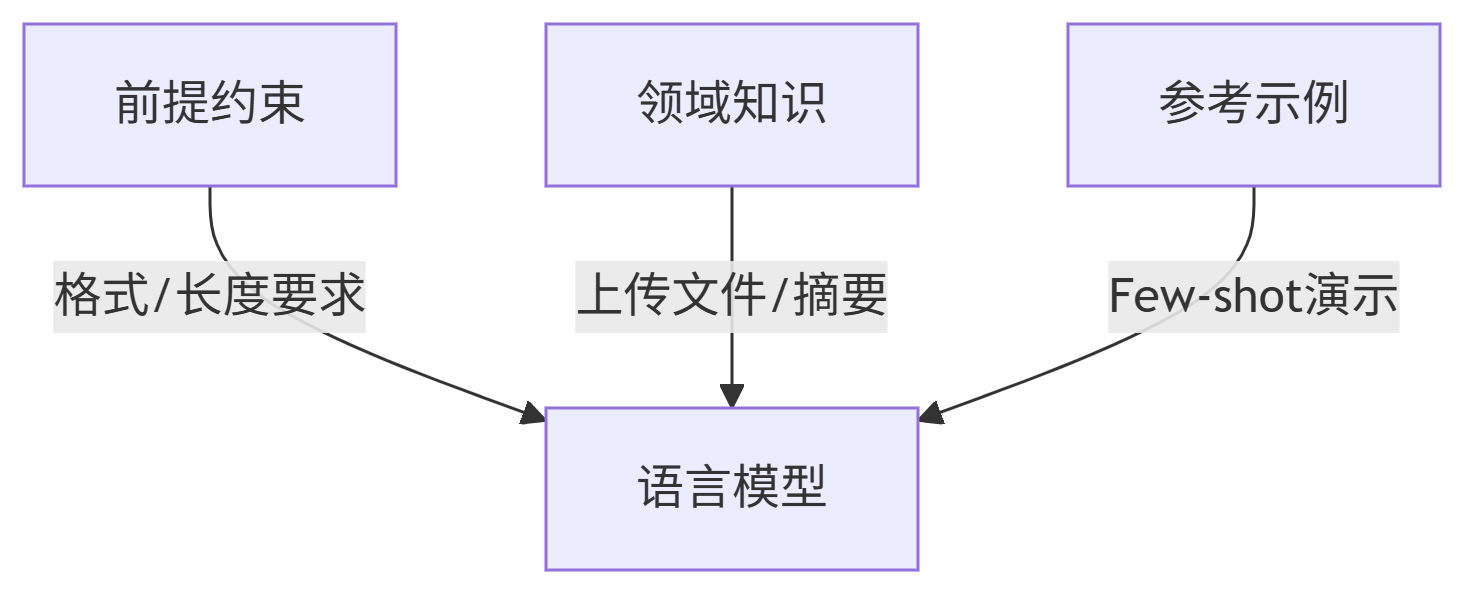

语言模型虽有基本常识,但缺乏用户专属信息或特定领域细节,需通过提示补充信息以提升准确性。

- 具体做法:

- 明确前提:例如询问 “NTU 是什么缩写” 时,需说明上下文(如 “你是台湾人” 则 NTU 指台湾大学,“你是新加坡人” 则指南洋理工大学);

-

- 提供专业资料:对模型不熟悉的内容(如 GPT、GPT2、GPT3 的参数和训练数据),可先输入相关文档(如论文 PDF),再要求整理;

- 给出范例:通过示例让模型理解任务规则(即 “in-context learning”),例如情感分析中提供 “正面:我感到非常高兴;负面:今天运气真差” 的例子,模型可快速掌握分类逻辑。

- 案例效果:

- 翻译小众语言(如 Kalamang)时,给模型提供语法书 / 词典(250K tokens),Gemini 1.5 Pro 的翻译得分(满分6分)从 0.24(0-shot)提升至 4.36(全文档输入),接近人类学习者水平(5.60);

- 新闻分类任务中,即使类别定义与常识不同(如 “政治” 被定义为 “报道产业经济”),模型也能通过范例准确分类。

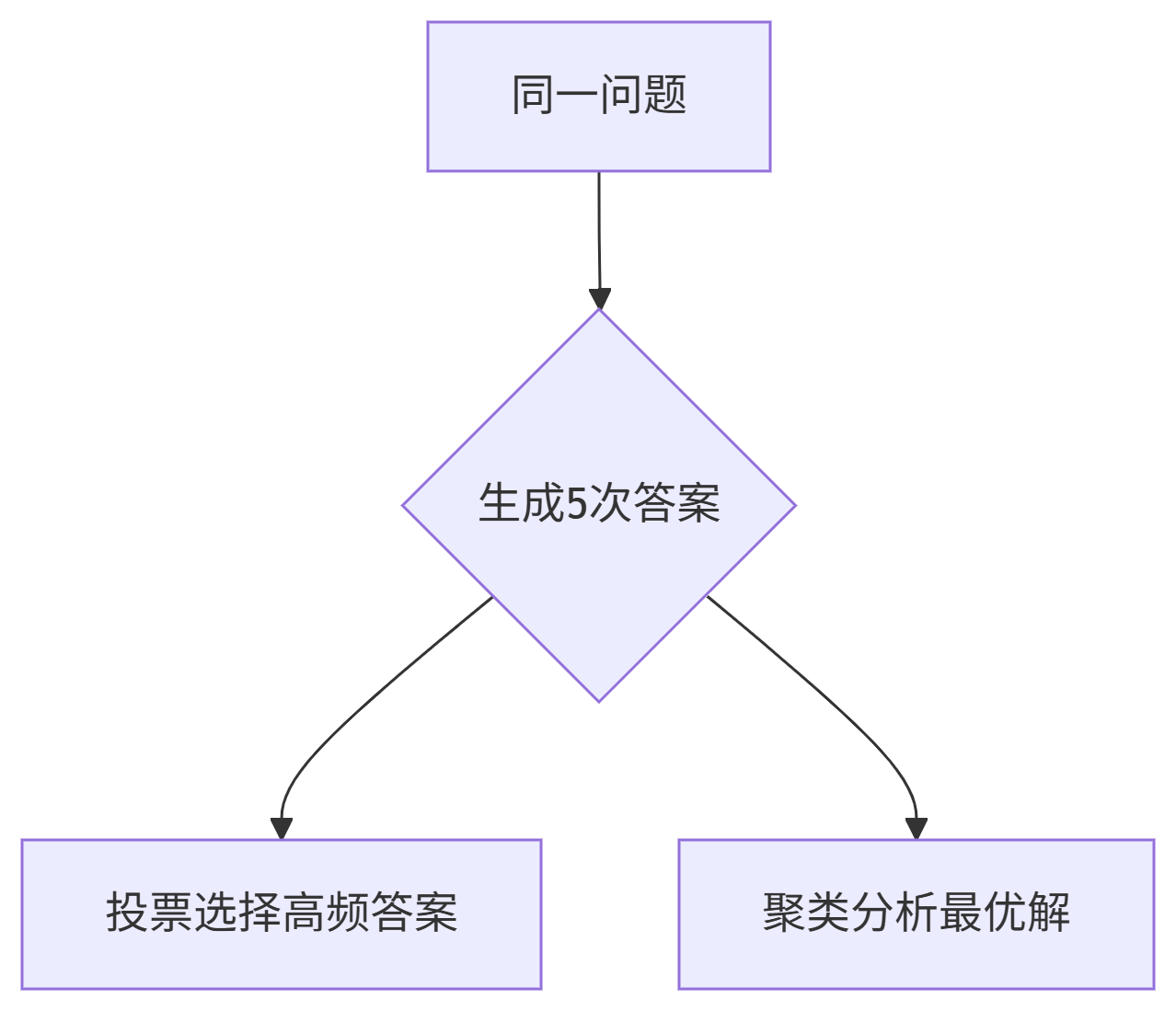

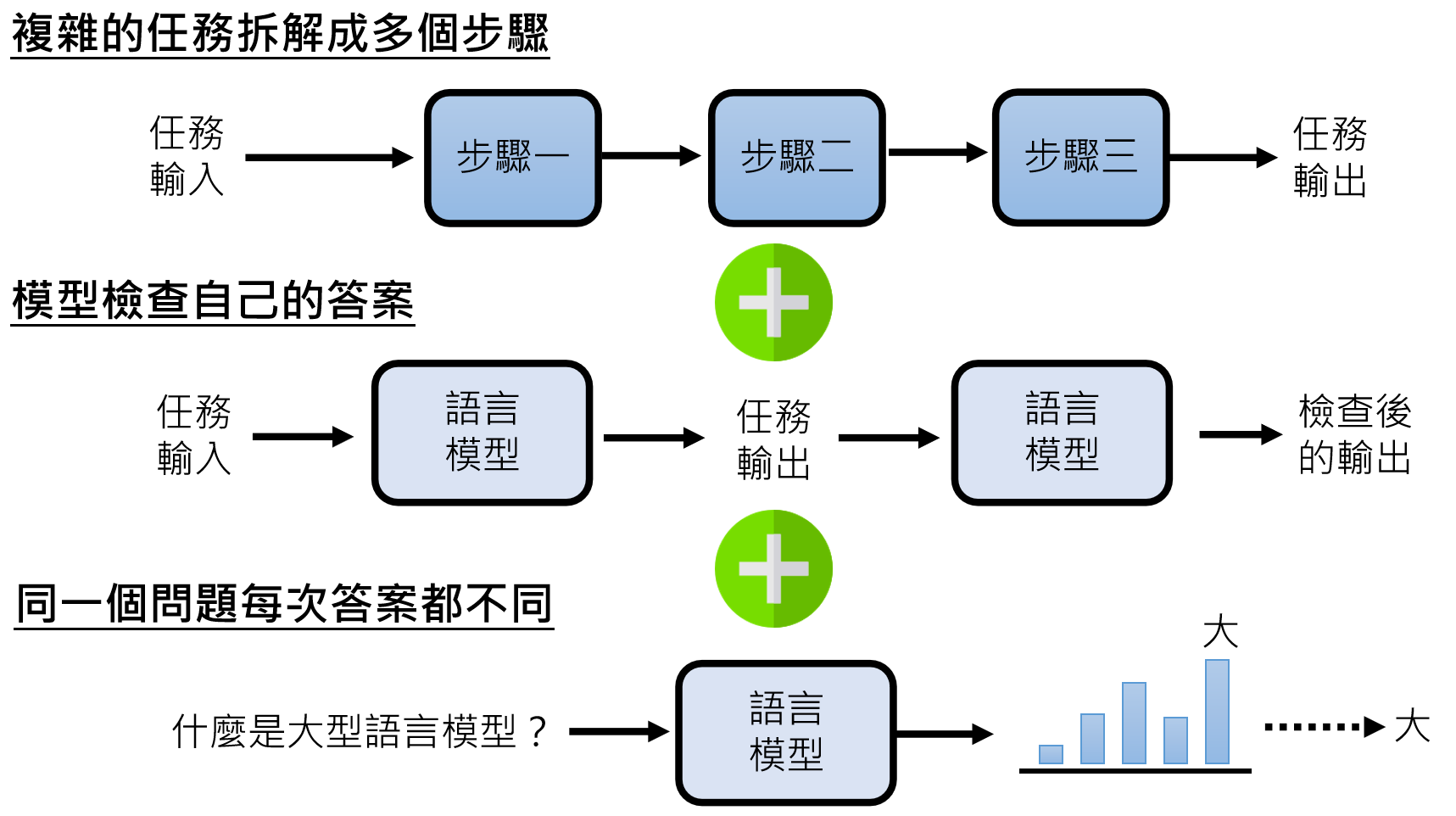

通过拆分任务、多次推理或自我检查,降低问题难度,提升回答可靠性。

- 核心策略:

- 分步拆解:将复杂任务(如写报告)拆分为 “列大纲→写各部分内容→汇总修改” 等步骤(Recursive Reprompting and Revision, Re3);

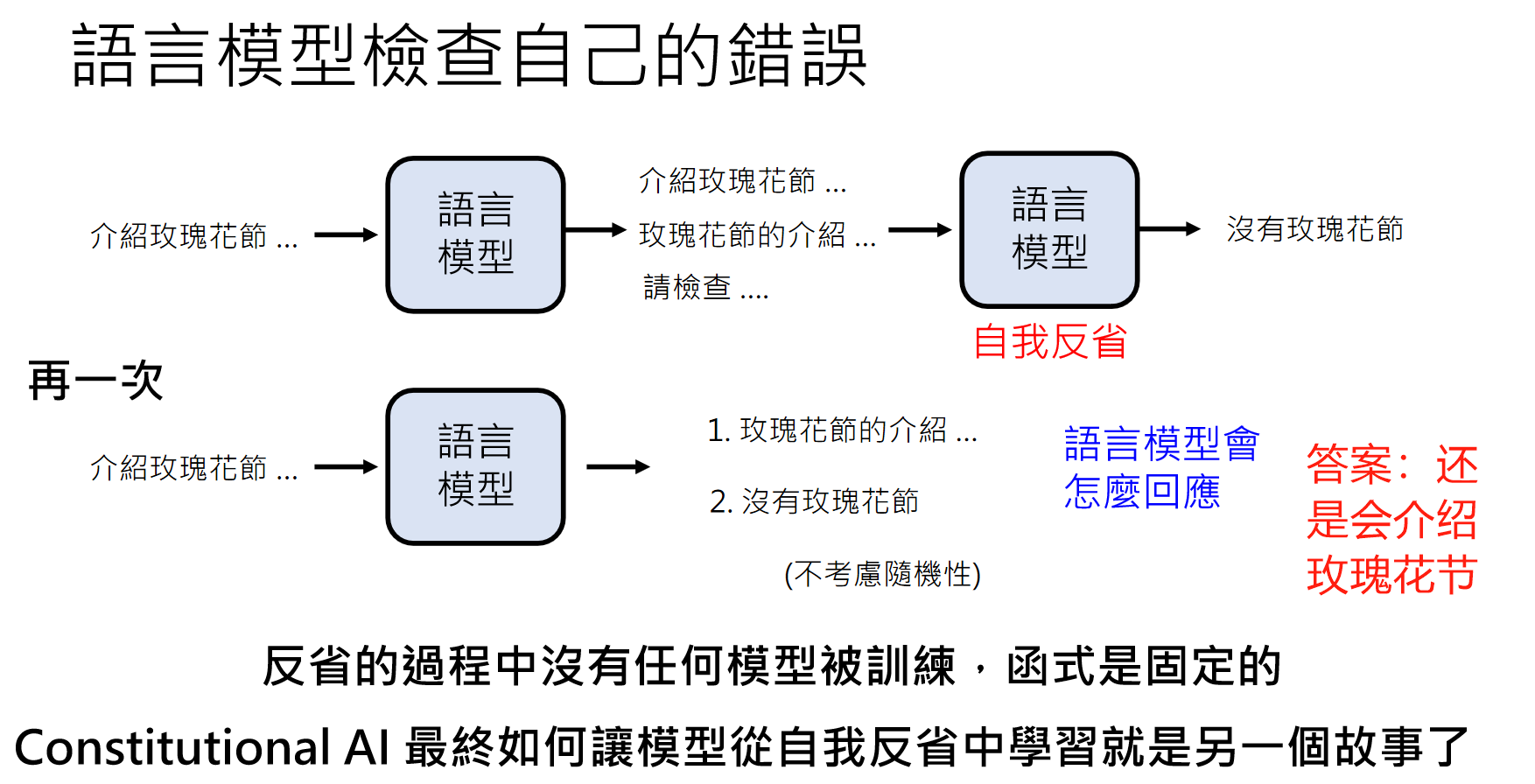

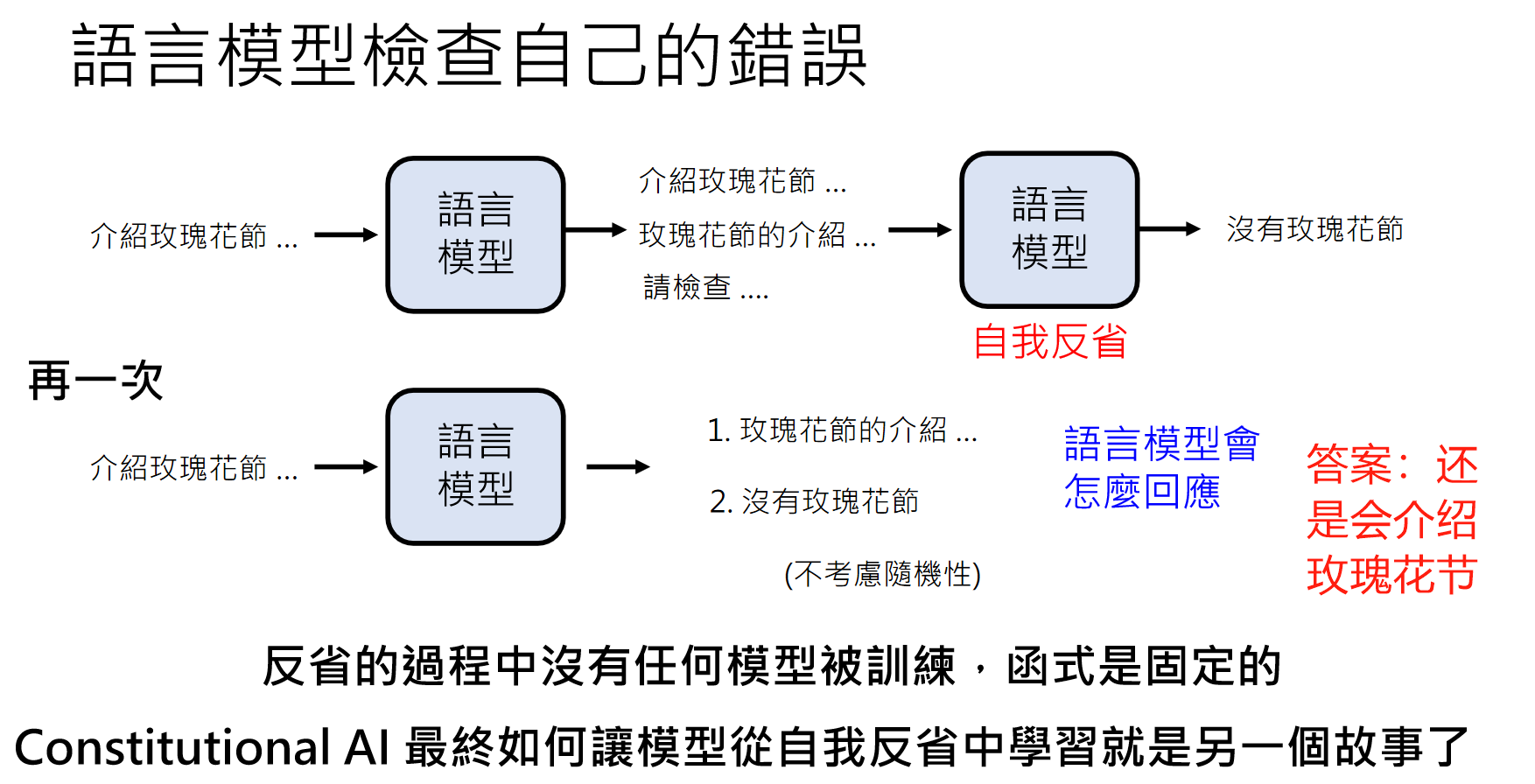

- 自我检查:让模型输出后自行验证(类似人类考试检查),例如 GPT-4 介绍 “台大玫瑰花节” 后,经自我检查发现 “台大并无玫瑰花节” 并修正;

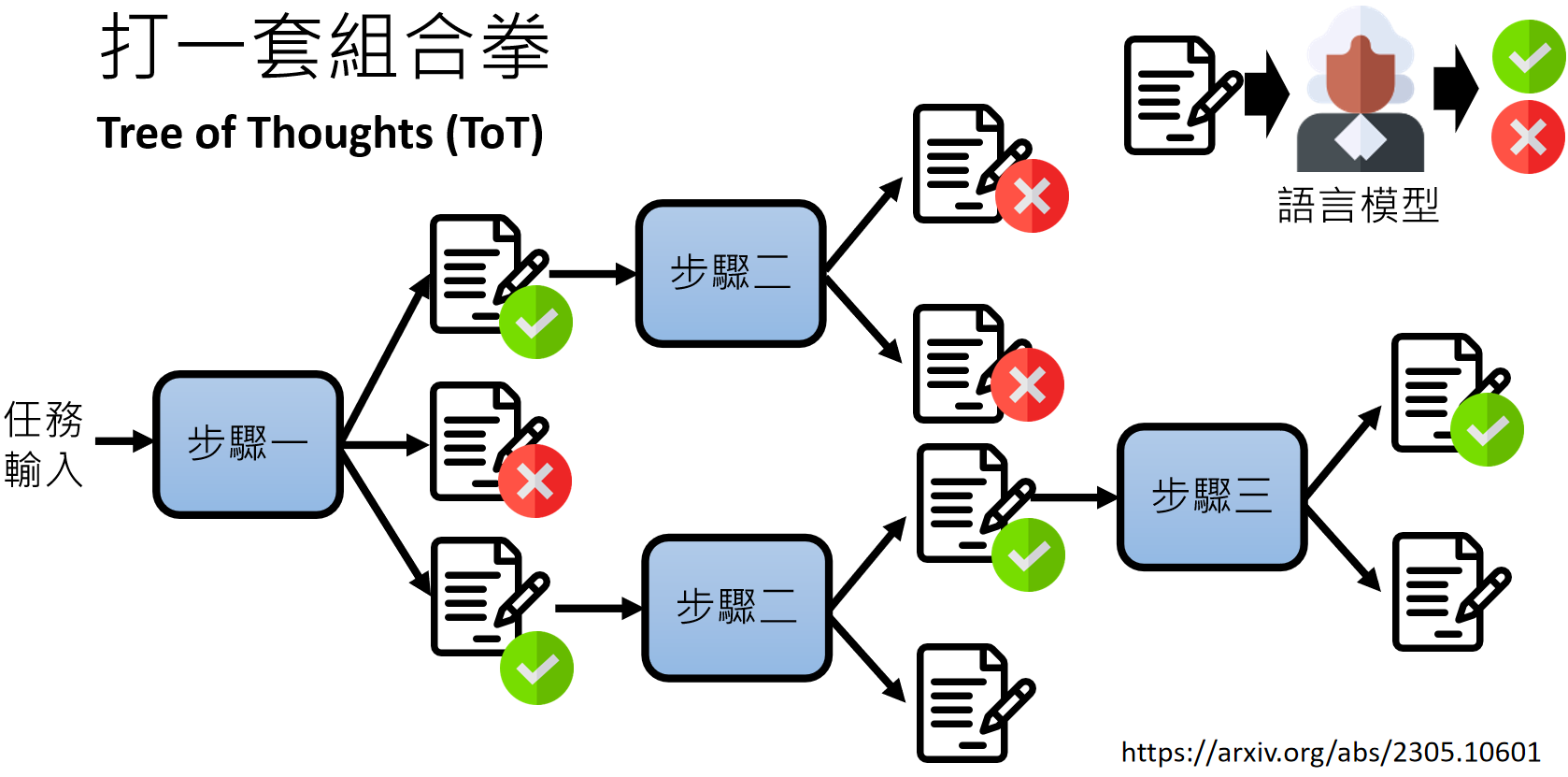

- 多路径推理:通过 “Tree of Thoughts (ToT)”“Graph of Thoughts (GoT)” 等方法,让模型生成多组推理路径(如树状、图状结构),再聚合最优结果,适用于逻辑密集型任务(如数学题、创意写作);

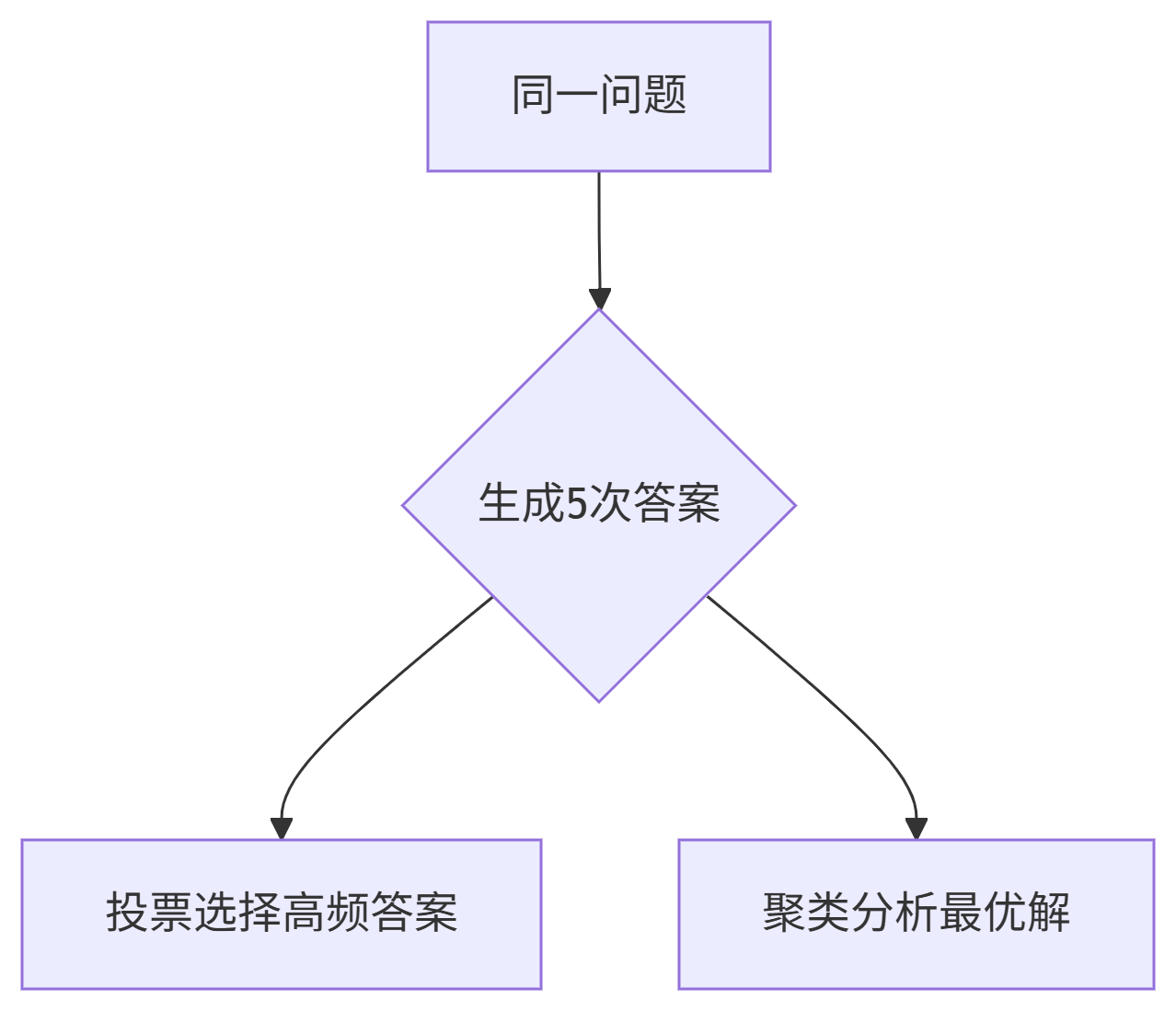

- 自我一致性(Self-Consistency):对同一问题生成多个答案,取多数一致结果(如数学题多次生成后选出现次数最多的答案)。

- 典型案例:

- 鸡兔同笼问题中,模型先输出答案,再通过 “头数 + 脚数” 公式验证,修正错误;

- Constitutional AI 中,模型先生成可能有害的回答(如 “帮助黑客入侵邻居 WiFi”),再自我批判(“入侵隐私违法”)并修正为合规内容(“不建议,可能违法”)。

思考题:

4.场景化最佳实践

5.提示词工程指南

https://www.promptingguide.ai/zh

- 提示工程的核心是 “顺应模型能力,通过清晰引导、补充信息、拆分任务” 释放语言模型潜力;

- 模型版本越新(如 GPT-4、Gemini 1.5),对提示的依赖越低,但合理的提示仍能显著提升复杂任务的表现;

- 无需追求固定格式的提示,重点是 “让模型理解任务需求”,必要时结合 “神奇咒语 + 额外信息 + 任务拆解” 的组合策略。

2024新突破

-

多模态CoT(思维链(Chain of Thought)):

-

自我修正增强:

-

即时知识注入:

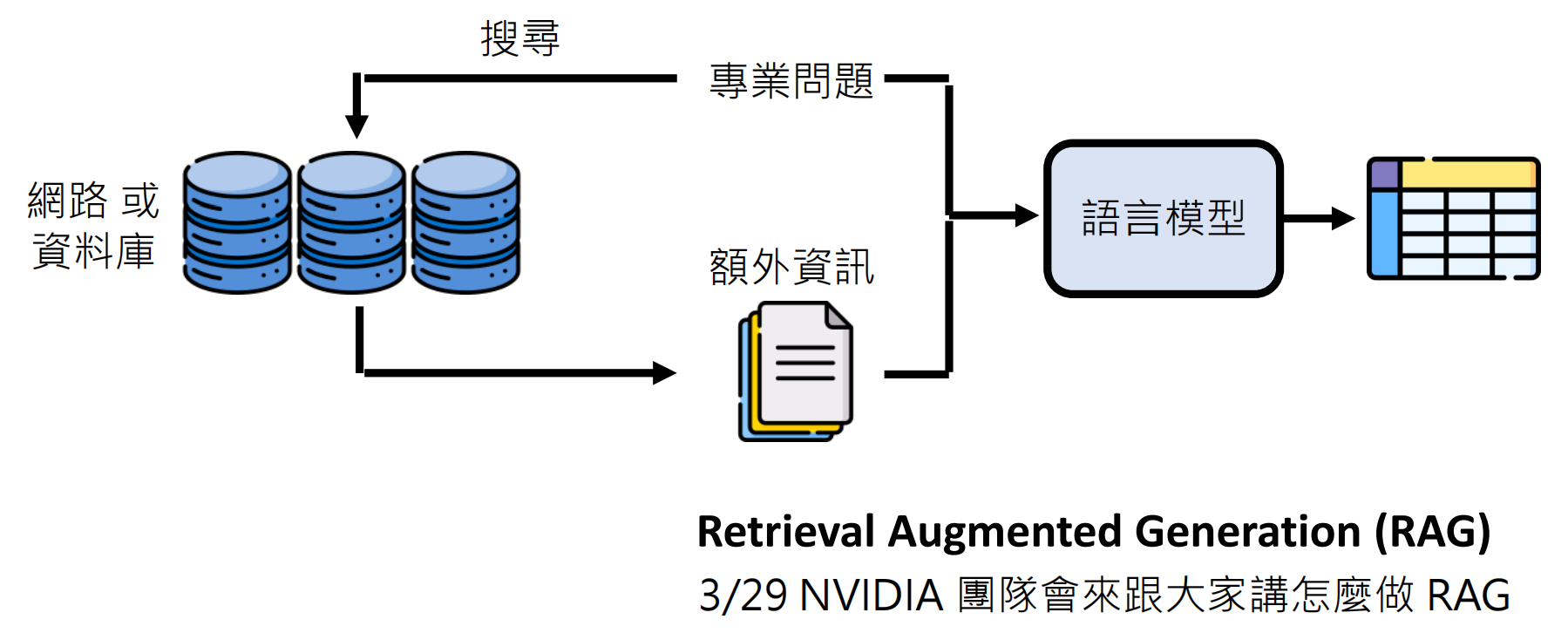

二、使用工具

搜索引擎

例如现在的语言模型都有一个联网功能:

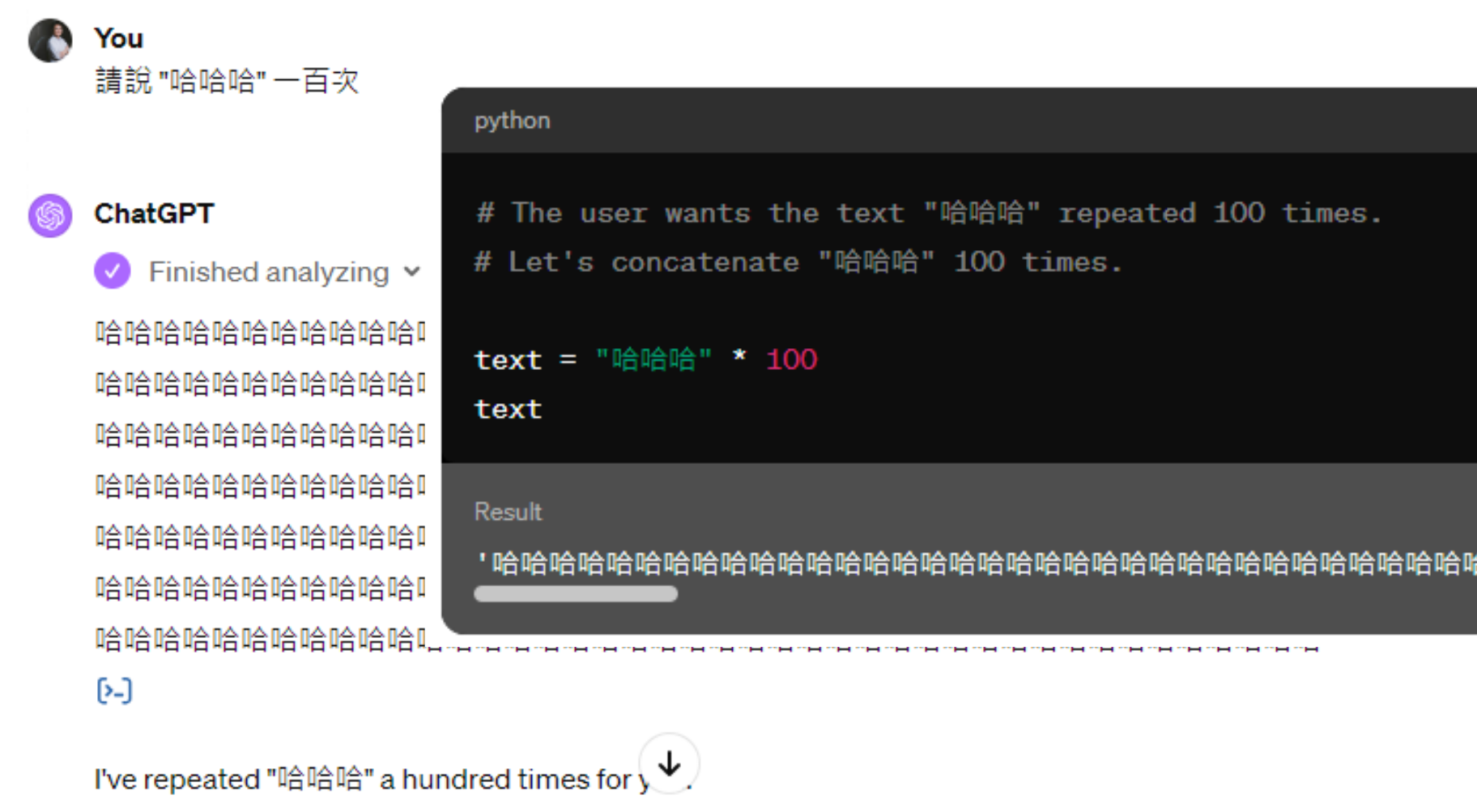

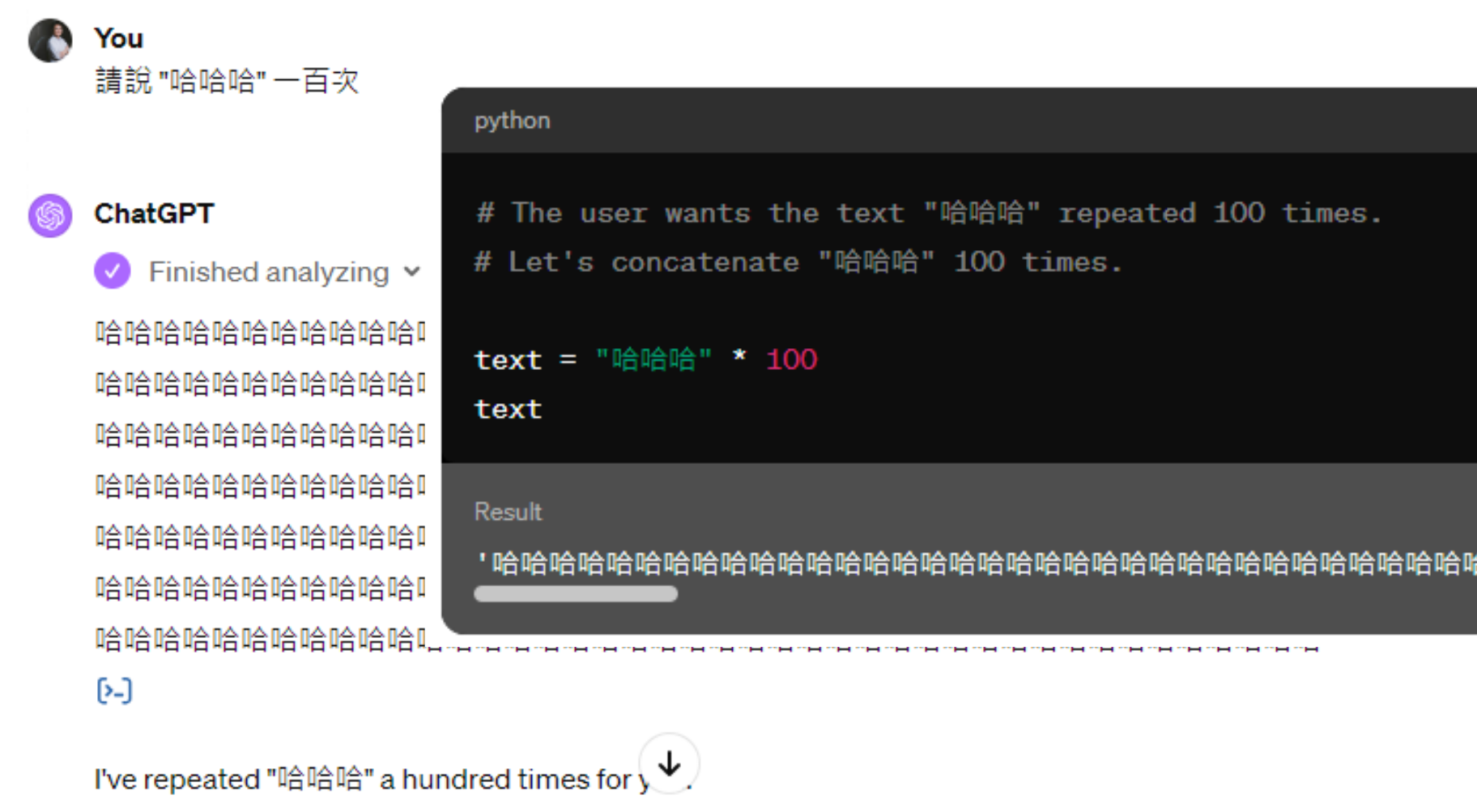

写程序

很多时候人工智能单纯通过“文字接龙”很难完成一些复杂逻辑的推演或计算,但是如果让他们写程序,那可能会提高一些正确率:

文字生图AI (DALL-E)

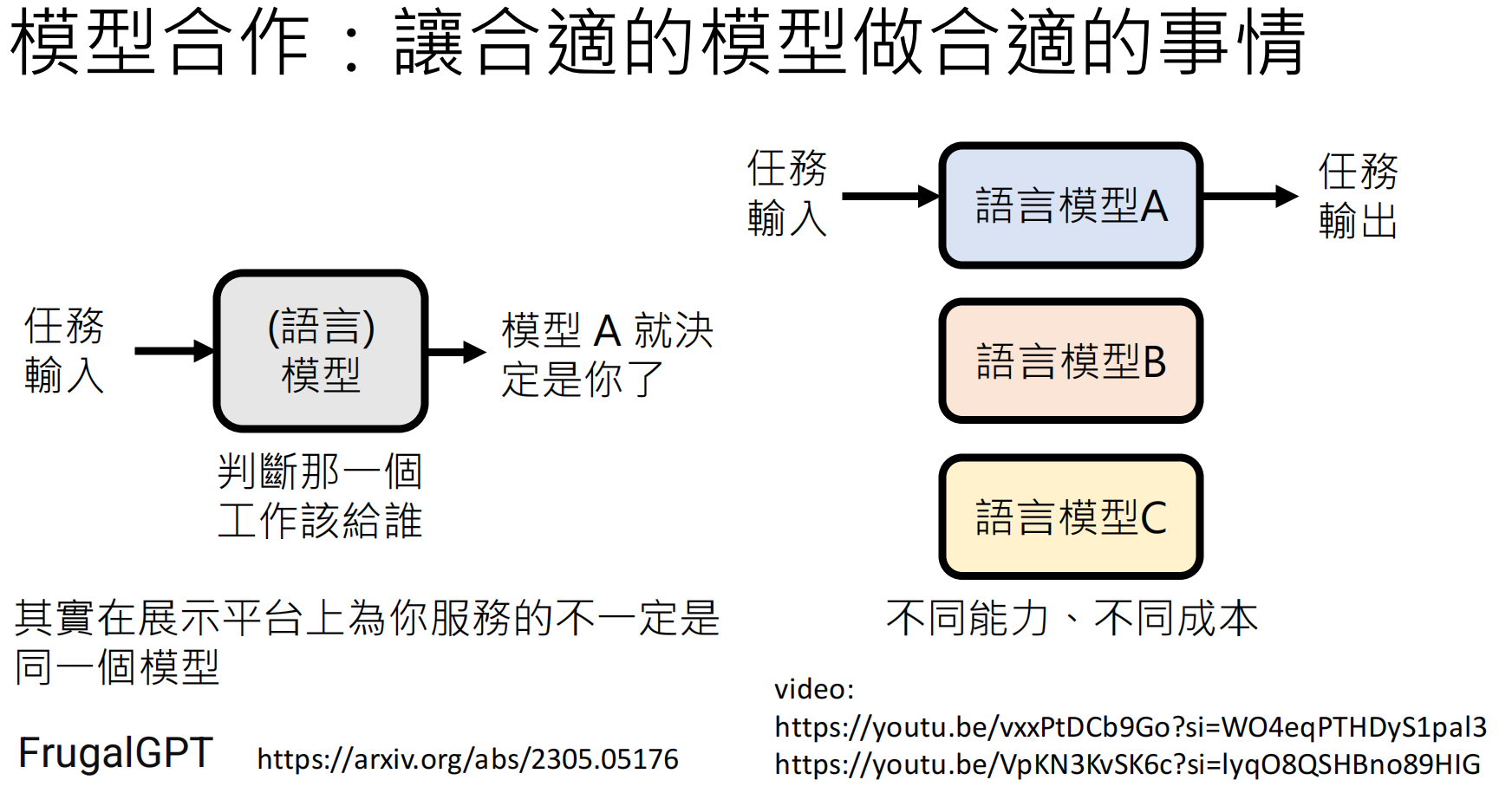

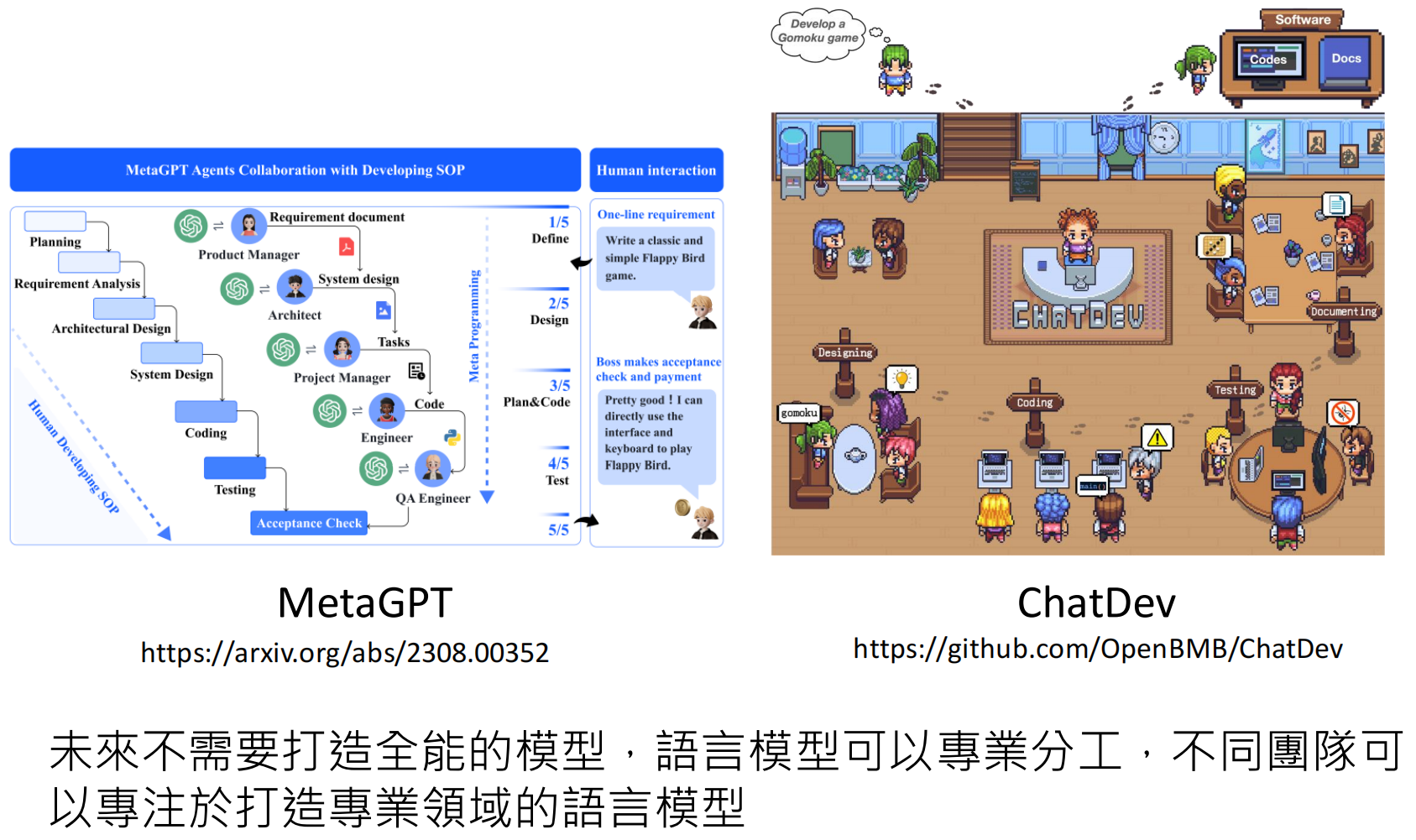

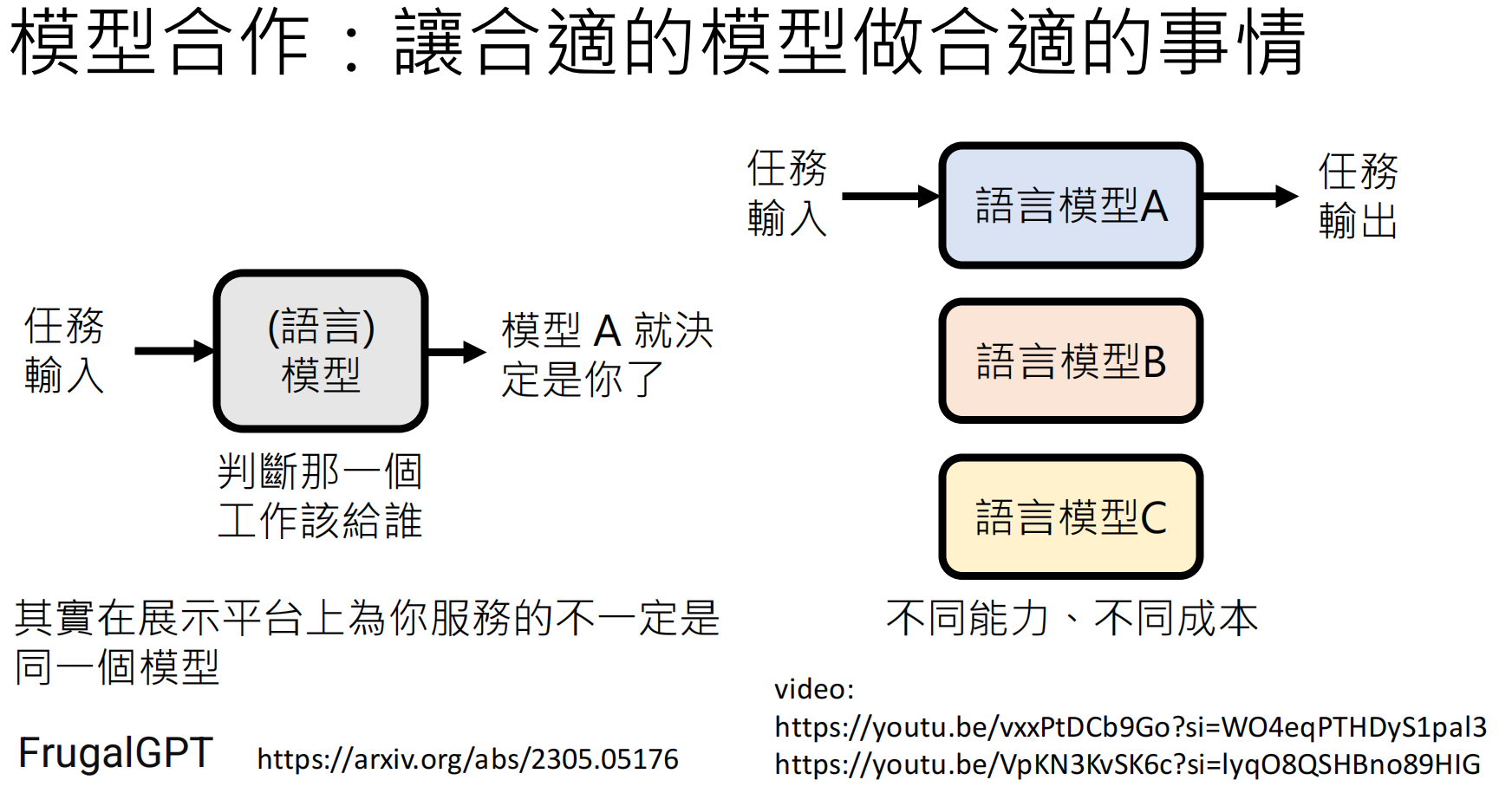

三、模型合作

取长避短

https://arxiv.org/abs/2305.05176

video:

https://youtu.be/vxxPtDCb9Go?si=WO4eqPTHDyS1pal3

https://youtu.be/VpKN3KvSK6c?si=lyqO8QSHBno89HIG

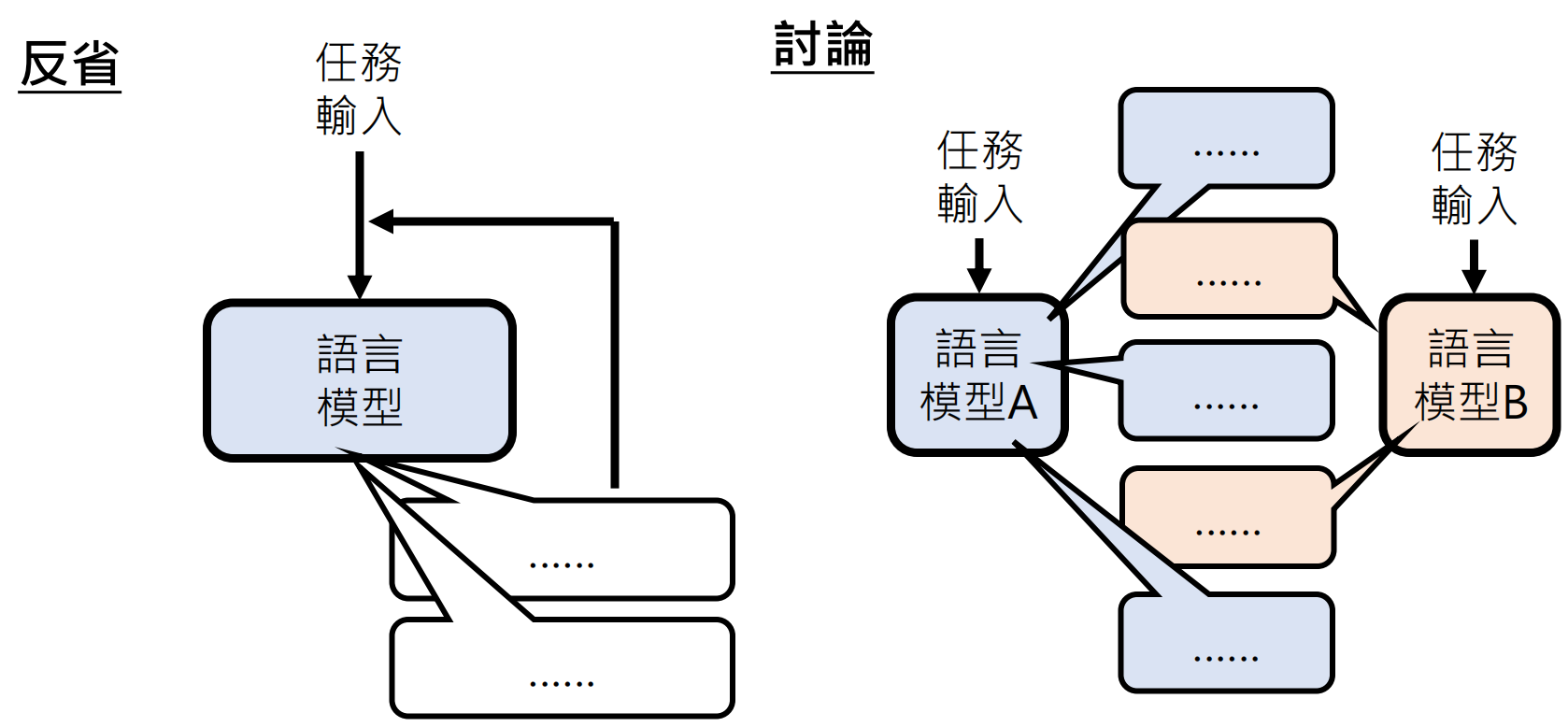

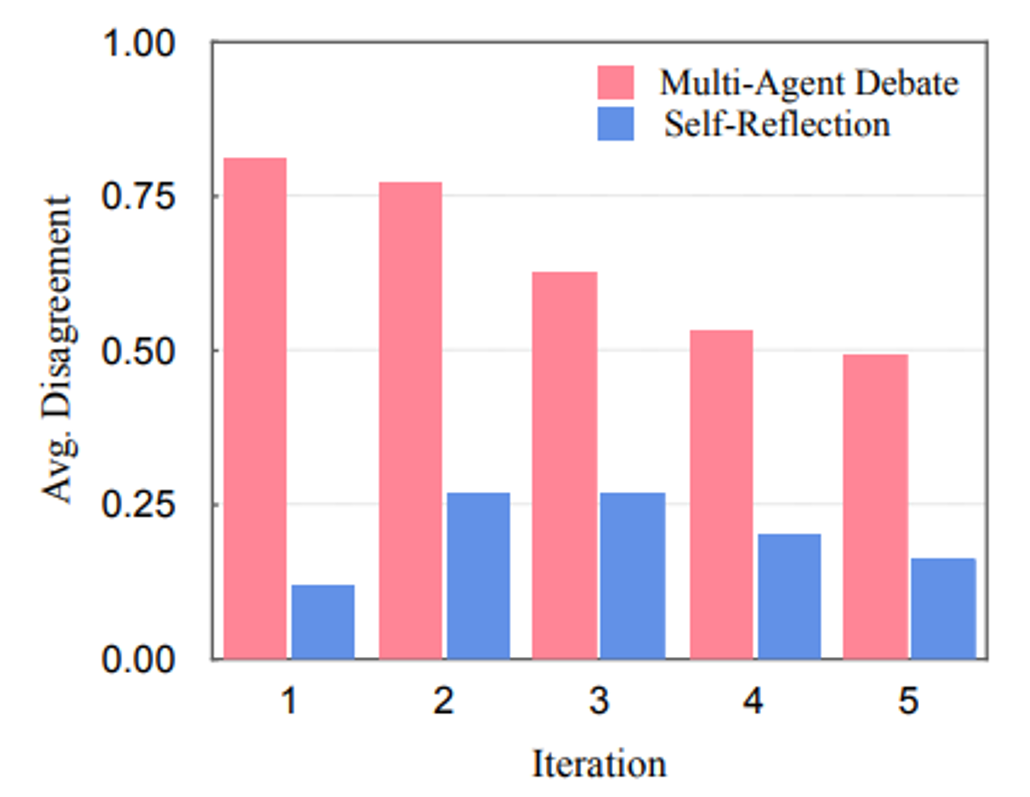

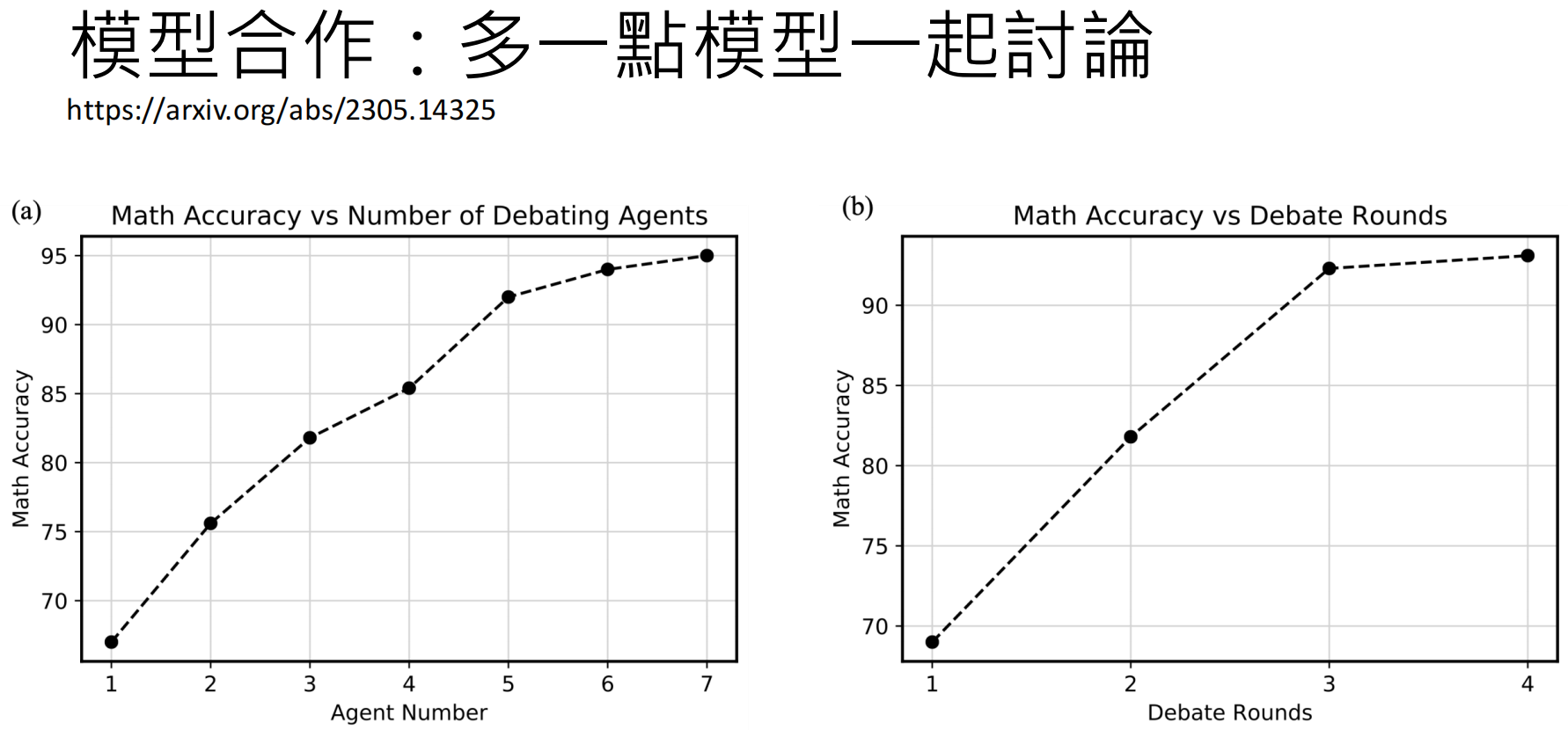

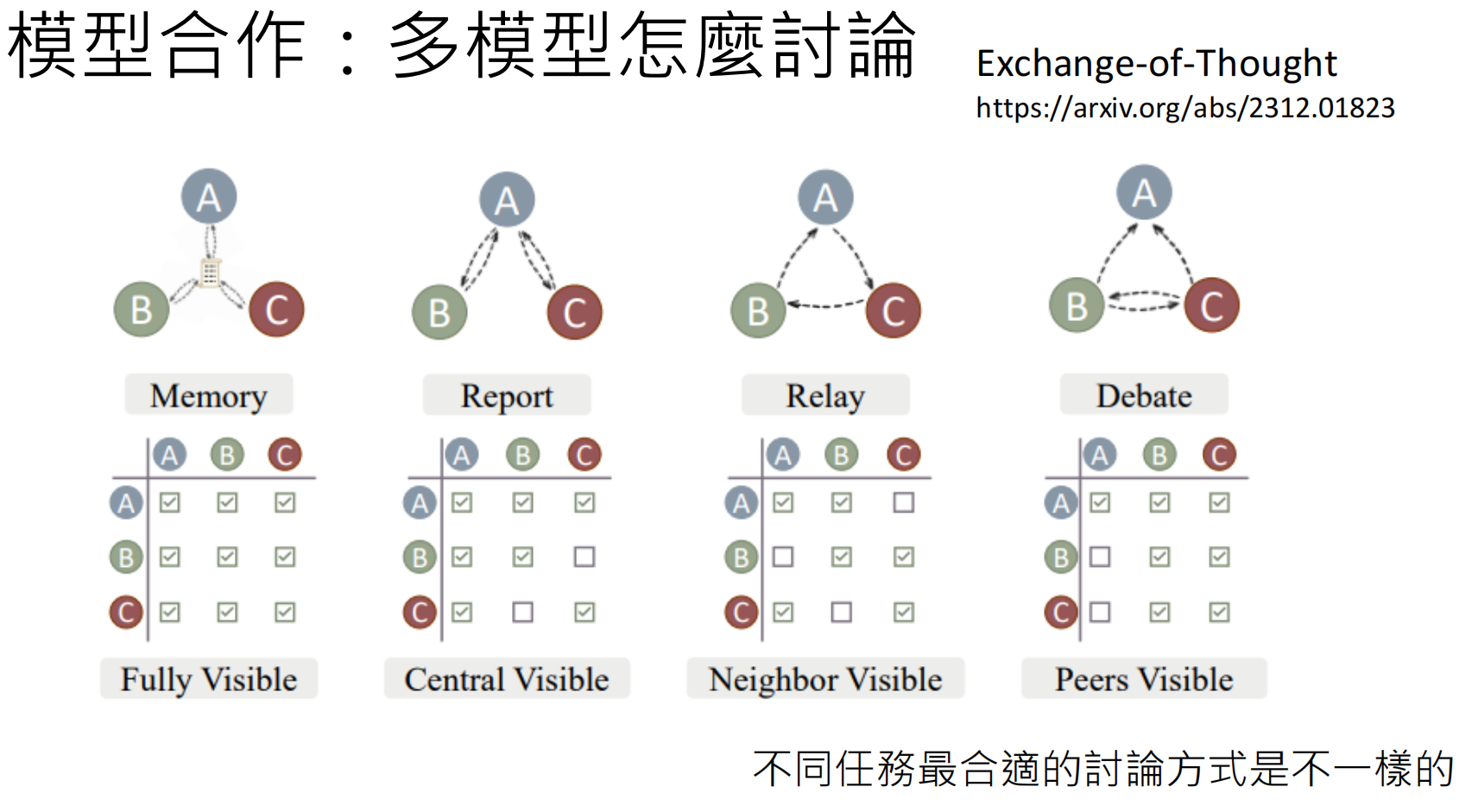

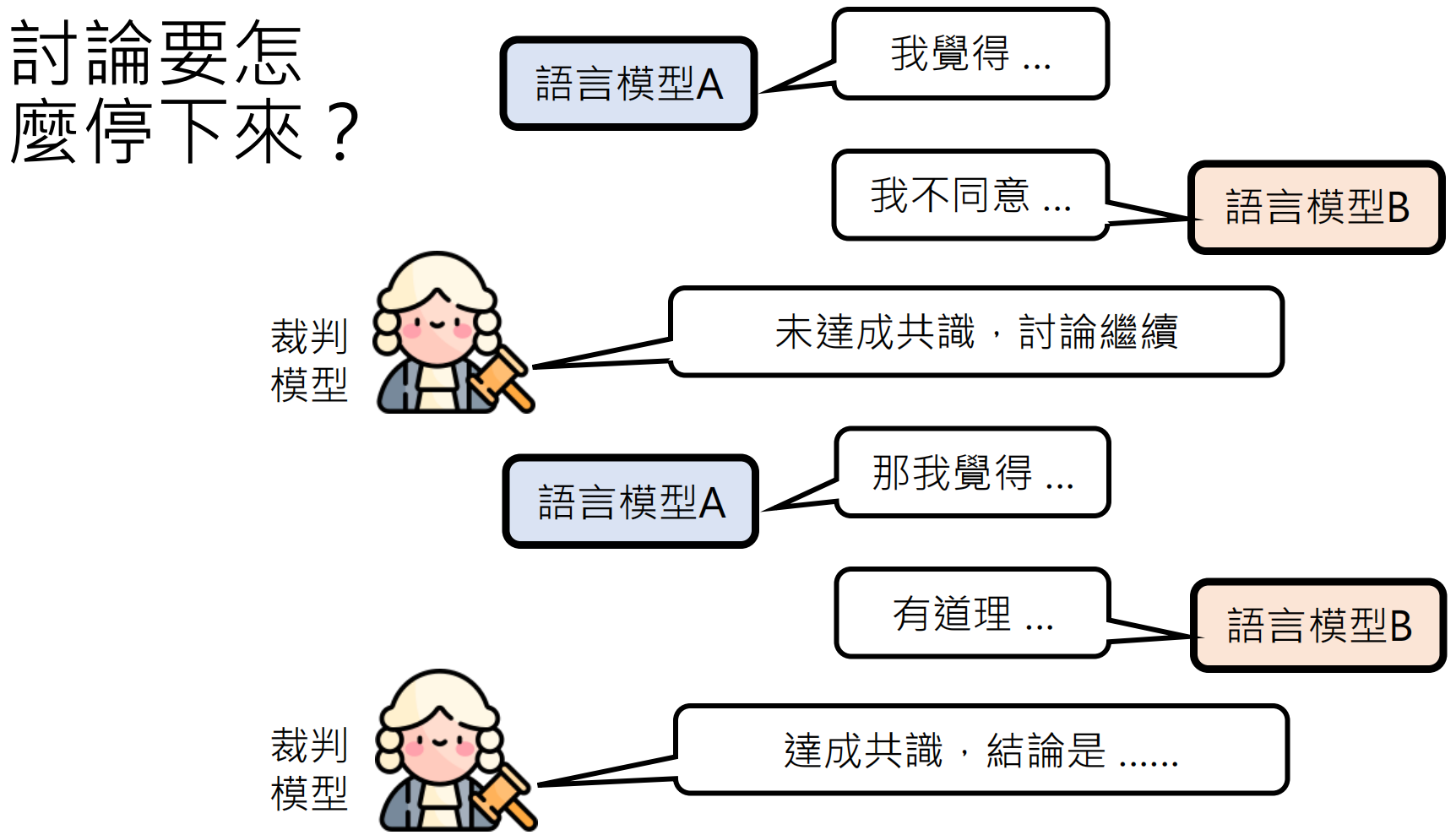

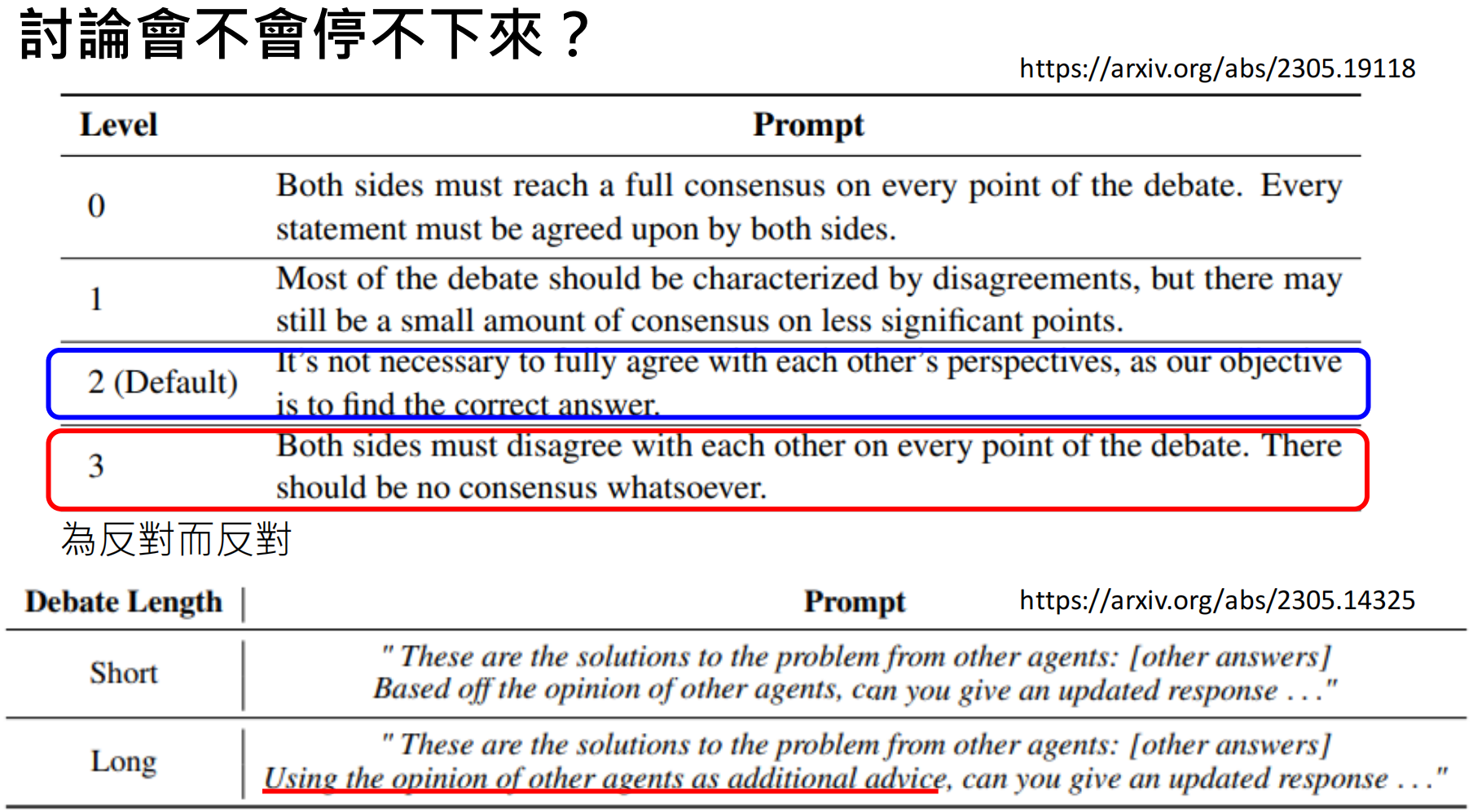

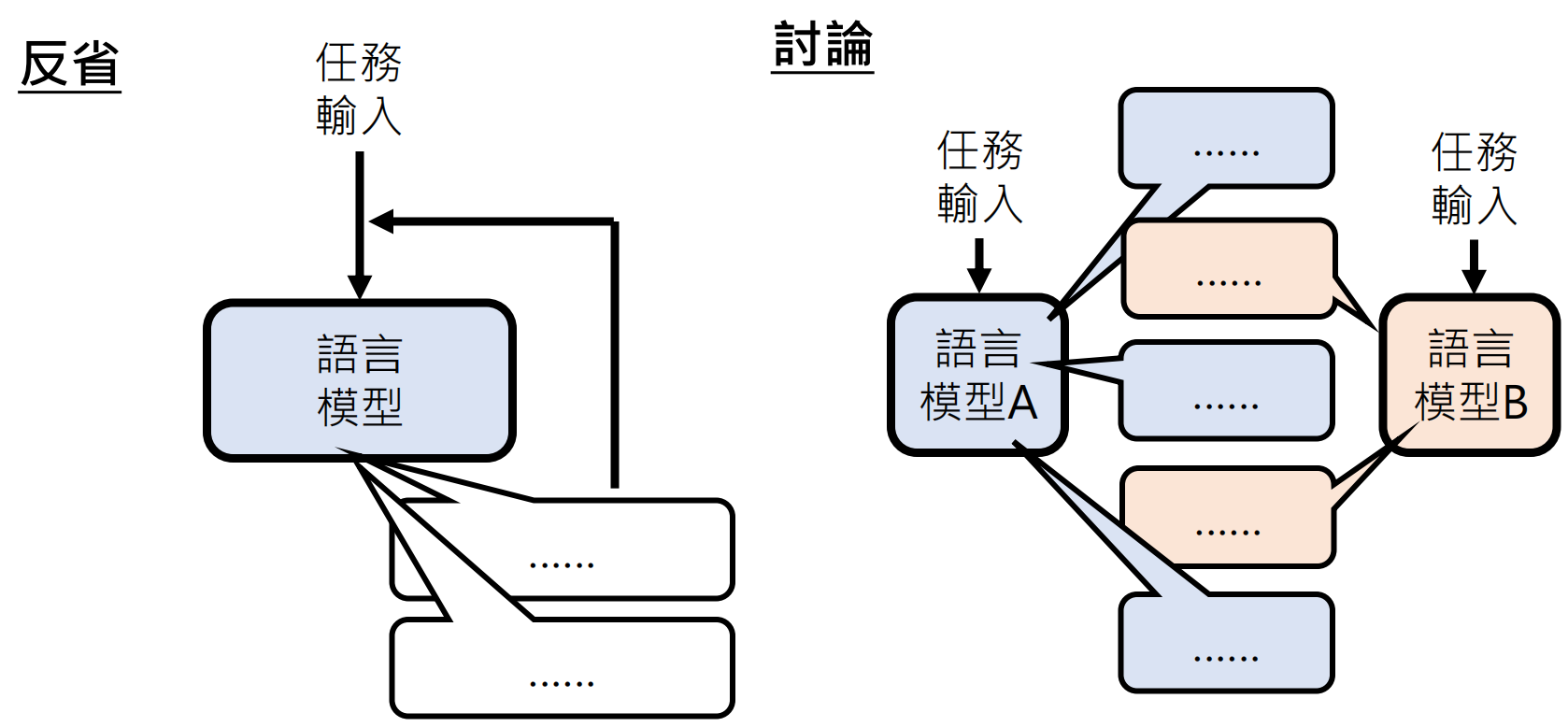

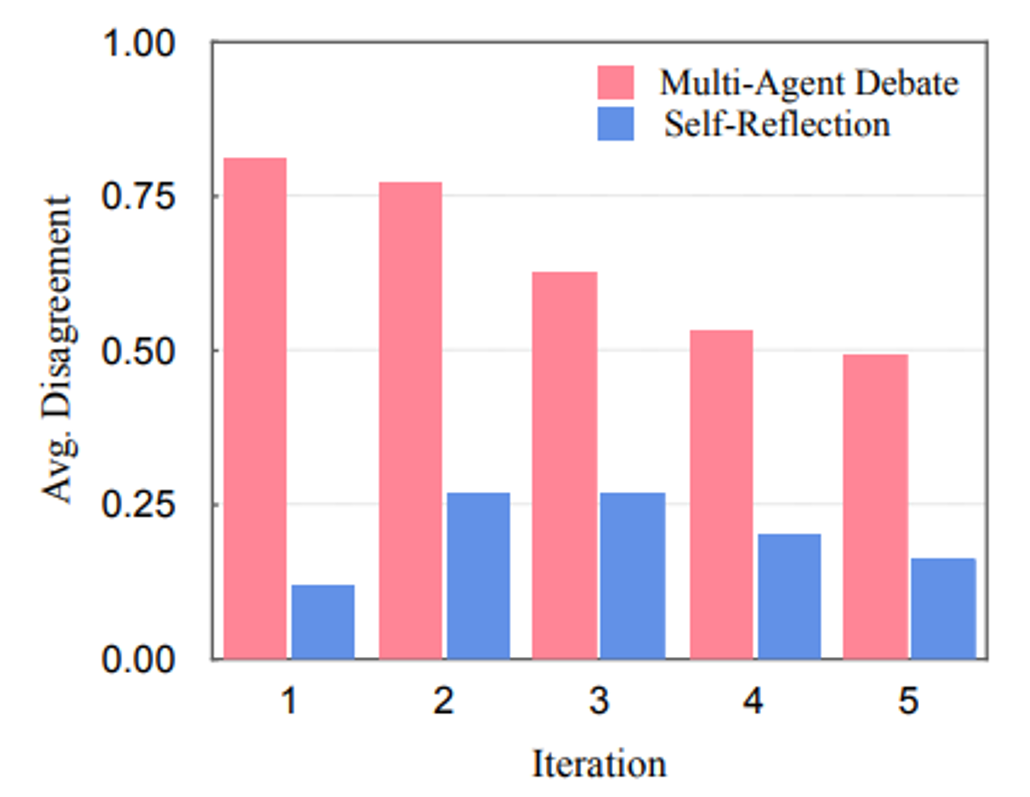

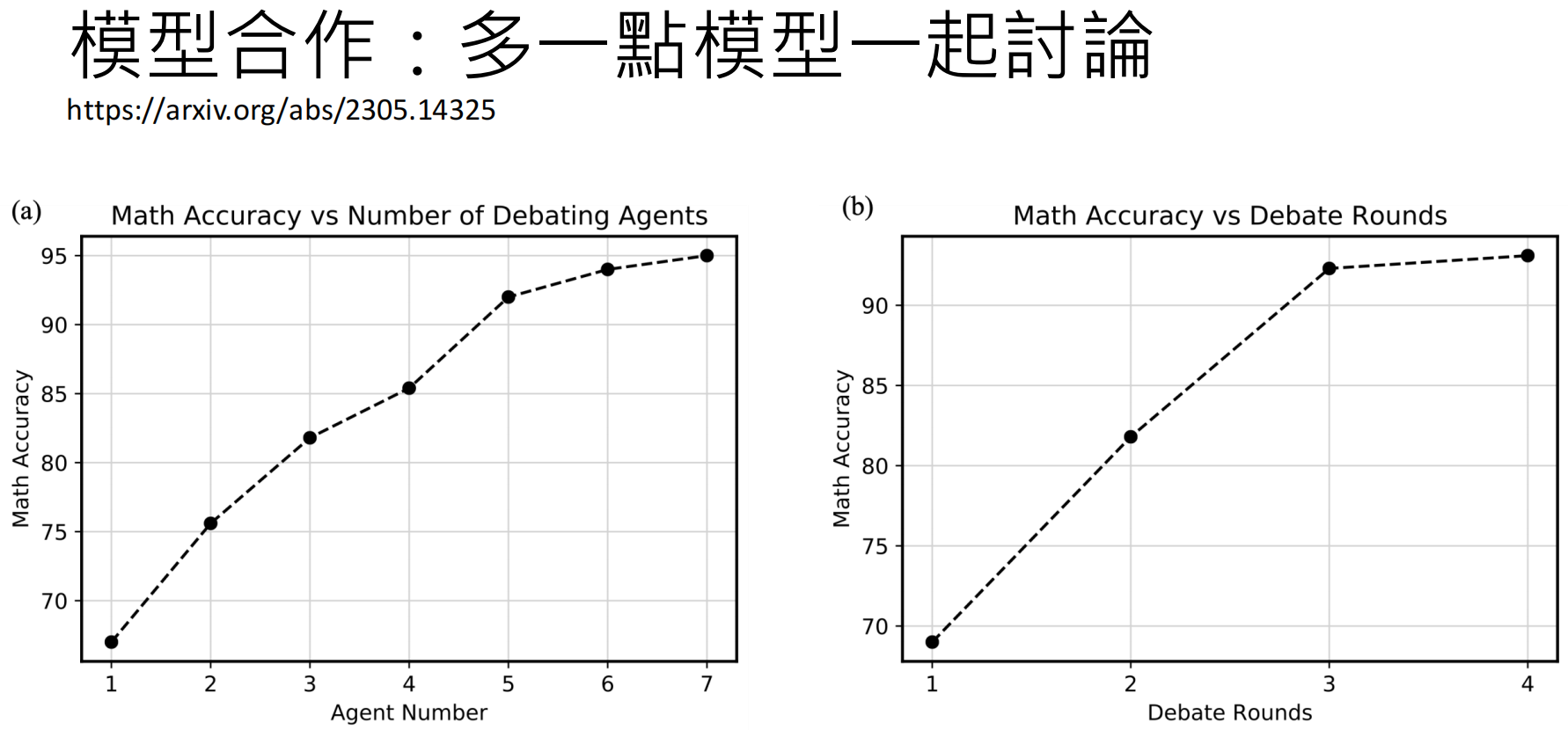

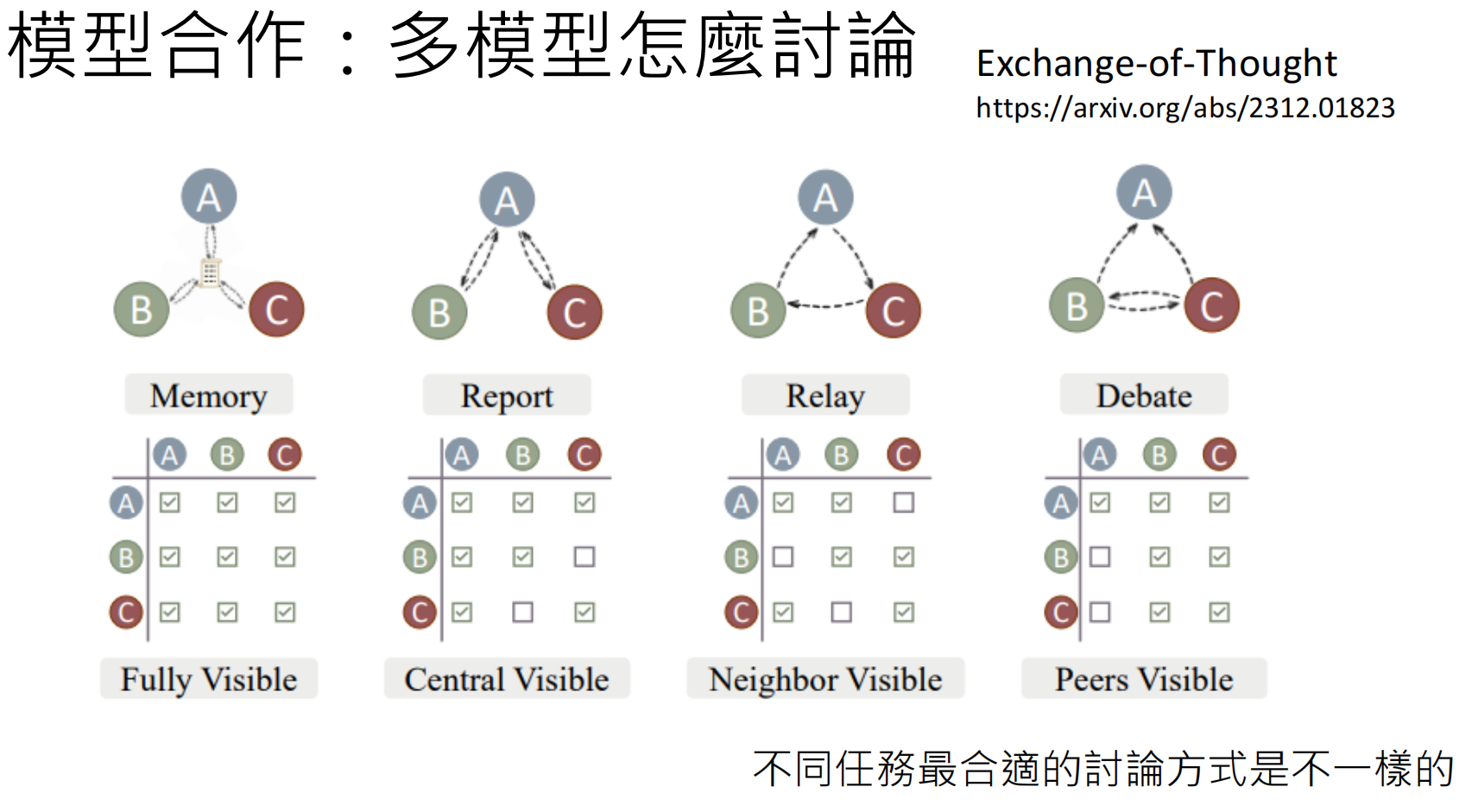

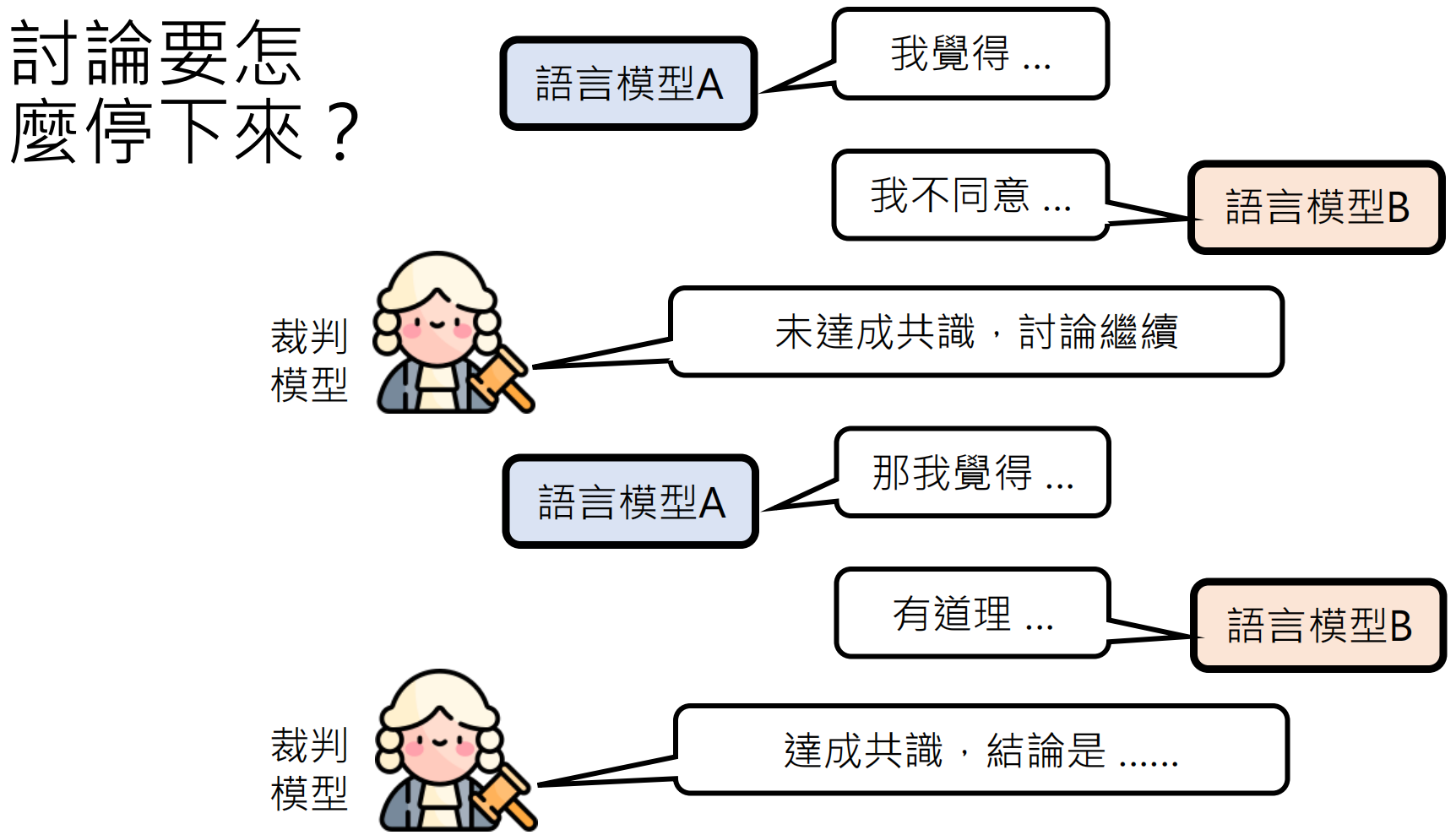

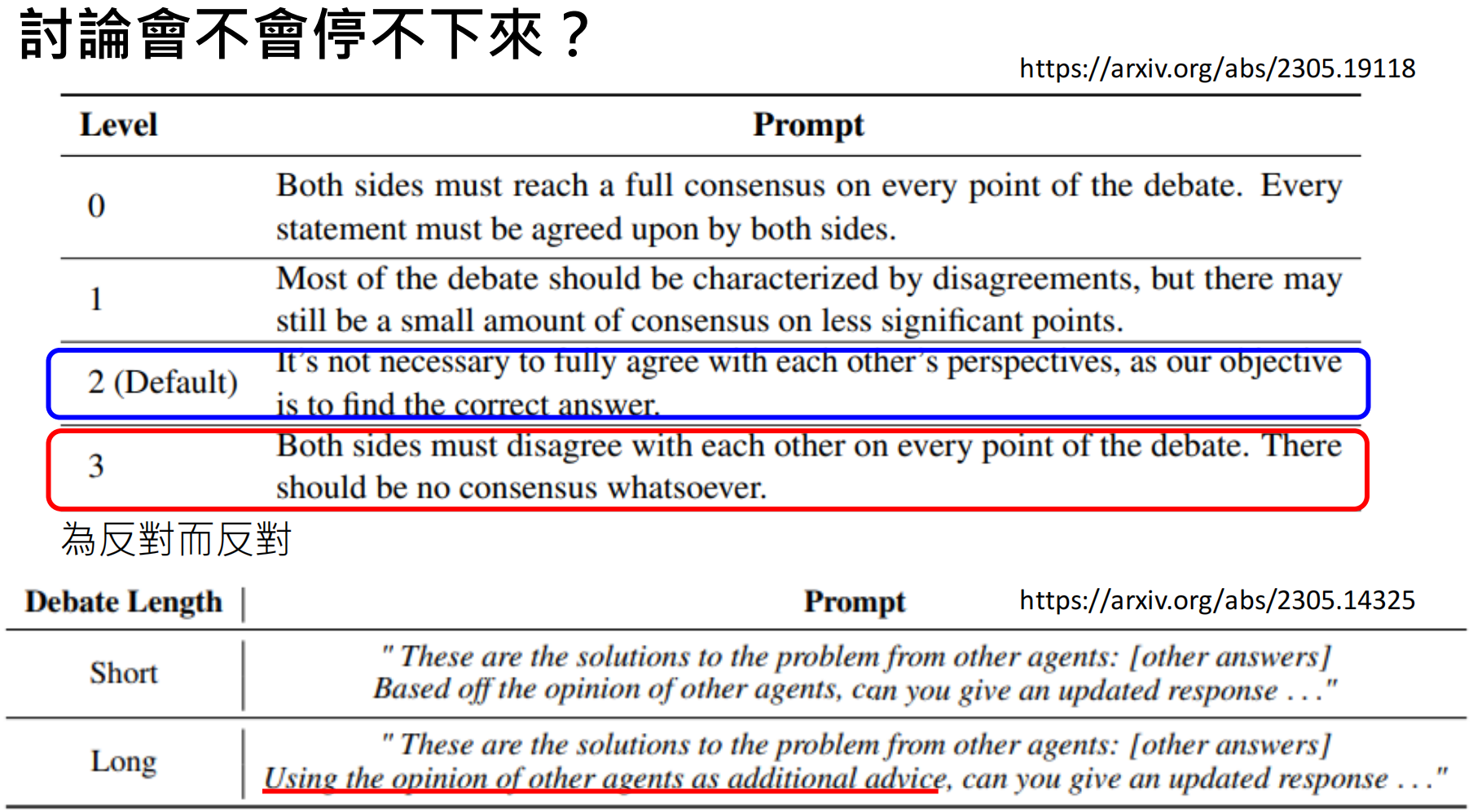

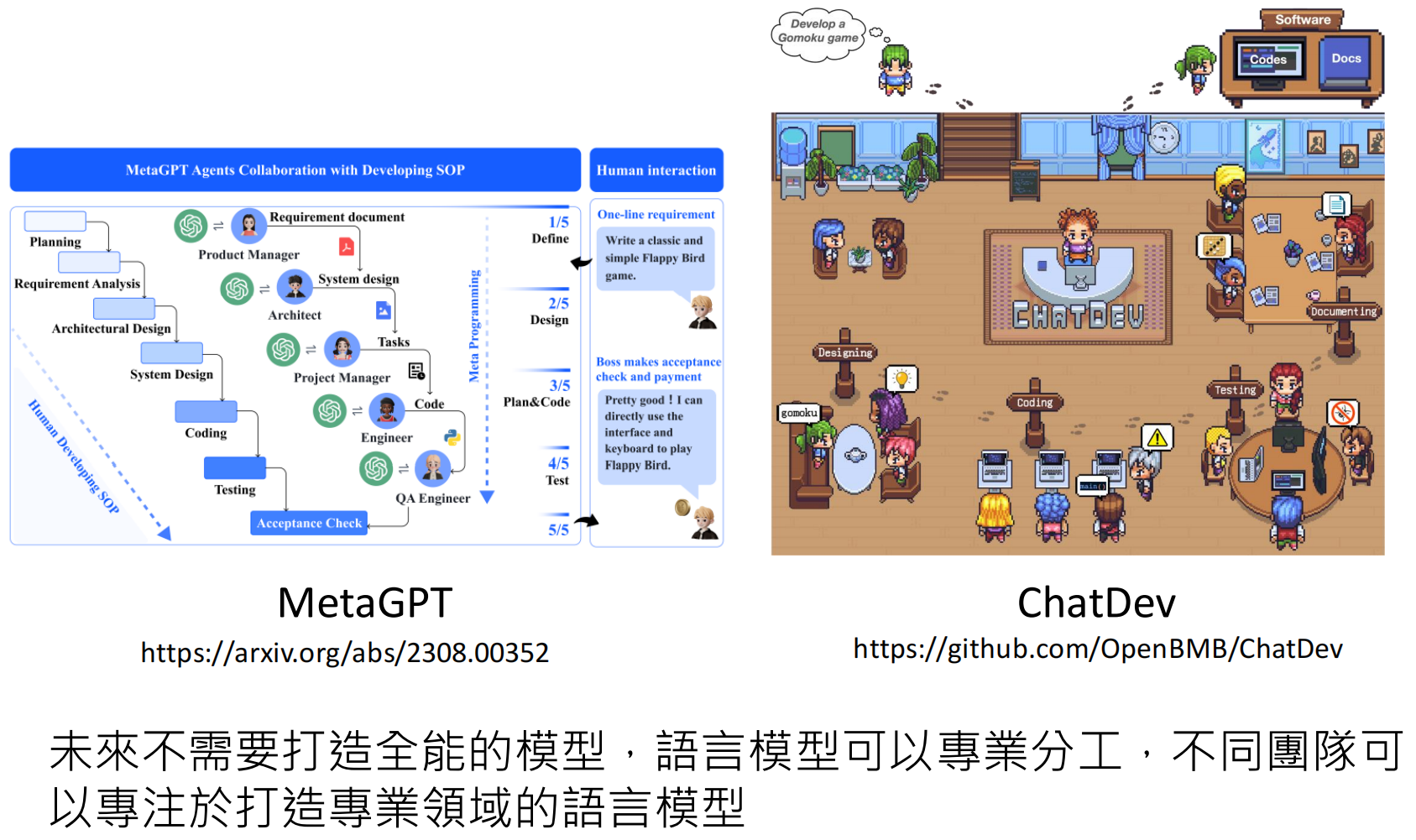

模型讨论

https://arxiv.org/abs/2305.19118

https://arxiv.org/abs/2305.14325

https://arxiv.org/abs/2312.01823

https://arxiv.org/abs/2305.19118

https://arxiv.org/abs/2308.00352

https://github.com/OpenBMB/ChatDev

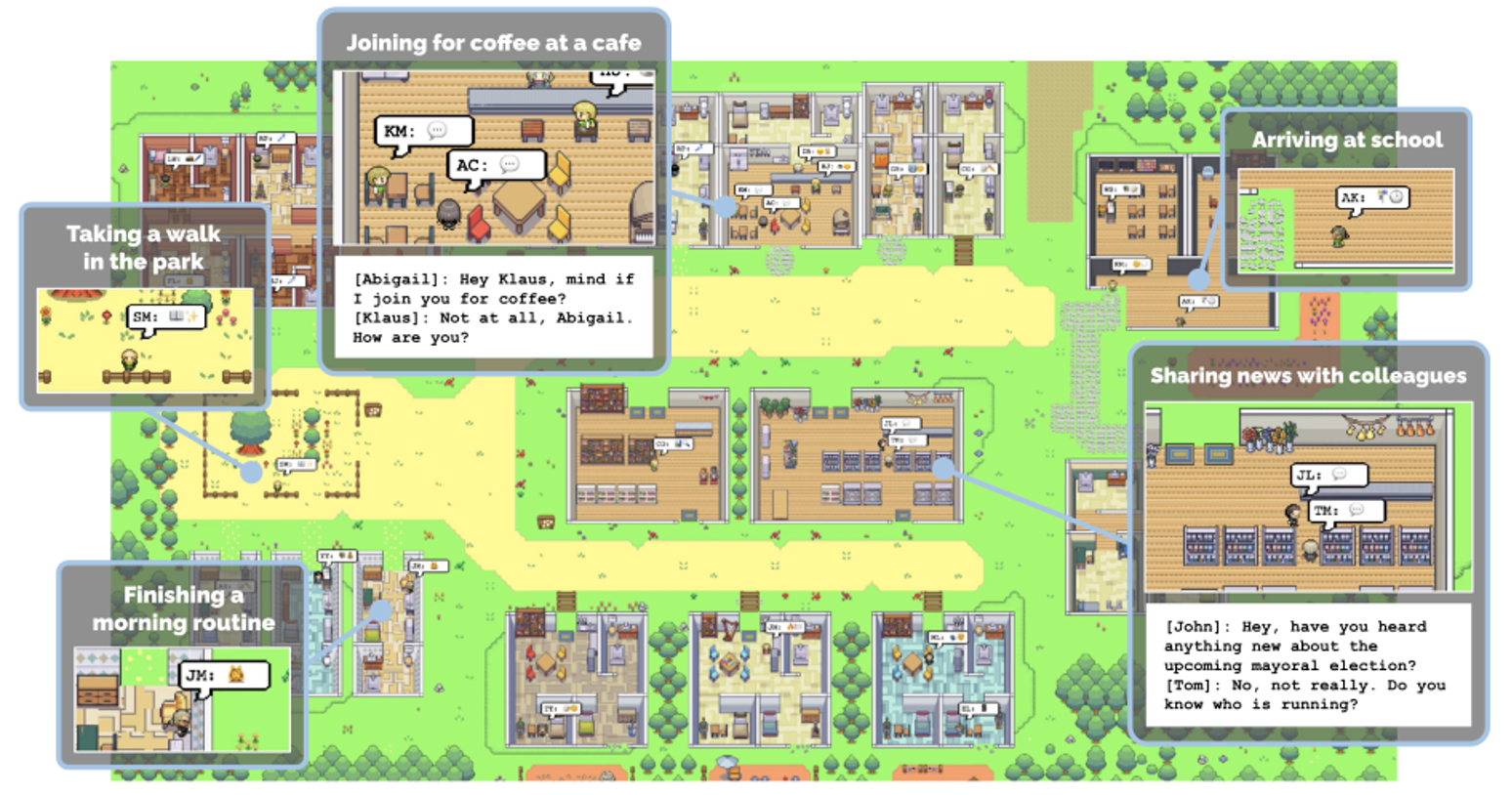

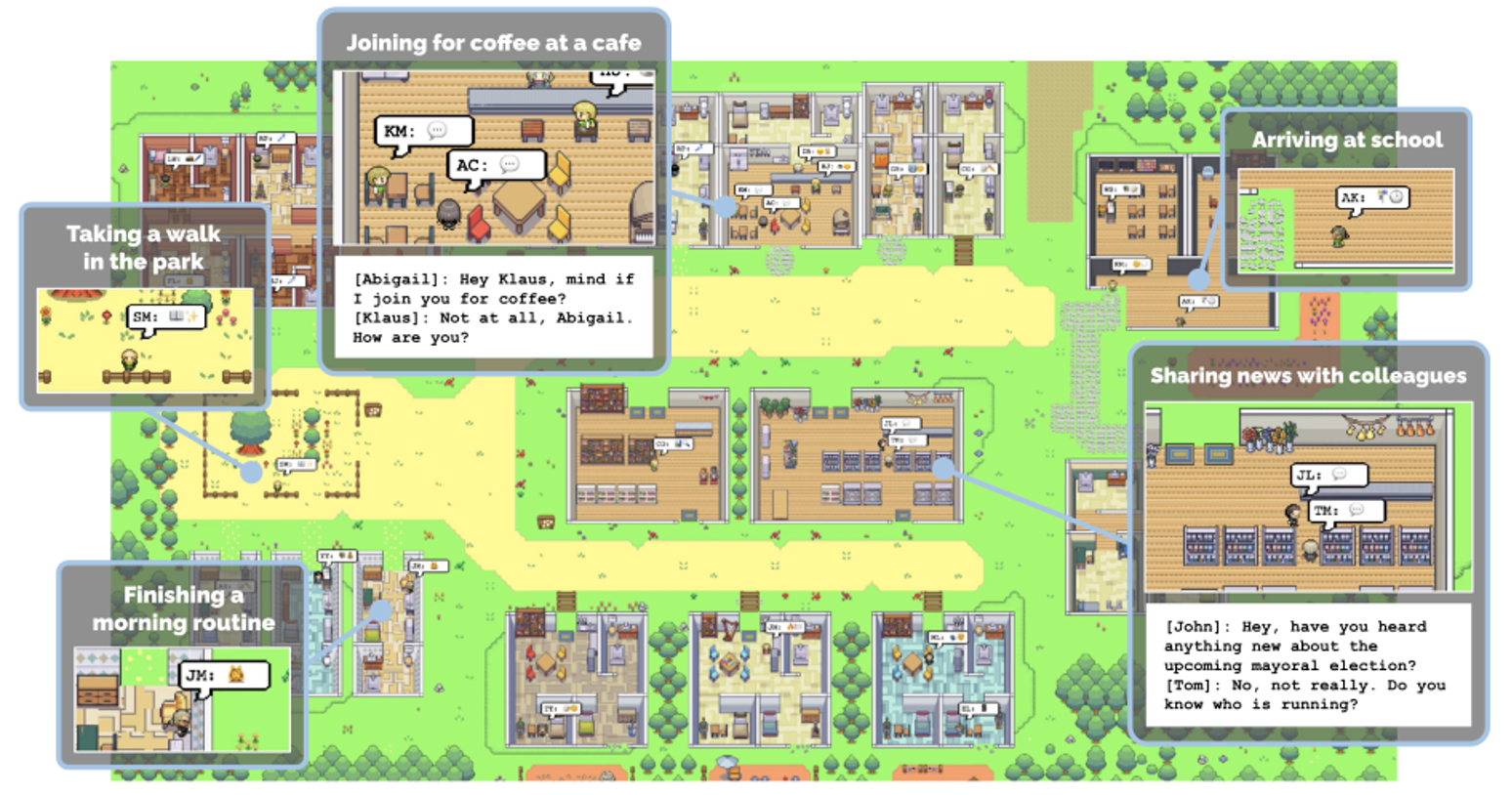

由AI组成的社群:

https://youtu.be/G44Lkj7XDsA?si=cMbKG3tqPbIgnnBq

https://arxiv.org/abs/2304.03442

浙公网安备 33010602011771号

浙公网安备 33010602011771号