【论文翻译】AN INVESTIGATION OF INCORPORATING MAMBA FOR SPEECH ENHANCEMENT

论文路径 AN INVESTIGATION OF INCORPORATING MAMBA FOR SPEECH ENHANCEMENT

摘要

本研究旨在探究一种近期提出的、无需注意力机制且具有扩展性的状态空间模型(SSM)——“曼巴”(Mamba)在语音增强(SE)任务中的应用。具体而言,我们使用“曼巴”来部署具有不同配置(即基础、高级、因果和非因果)的不同基于回归的语音增强模型(SEMamba)。此外,还考虑了基于信号级距离或基于度量的损失函数。实验结果表明,在 VoiceBank-DEMAND 数据集上,采用高级非因果配置的 SEMamba 实现了 3.55 的 PESQ 评分,表现相当出色。当 SEMamba 与感知对比拉伸(PCS)相结合时,还报告了新的最先进的 PESQ 评分 3.69。与基于转换的等效语音增强解决方案相比,采用高级非因果配置时观察到高达约 12%的 FLOPs 减少。最后,SEMamba 可用作自动语音识别(ASR)之前的预处理步骤,其表现与近期的语音增强解决方案相当。

1. 介绍

语音增强(SE)过程是指从失真信号中提取清晰的语音成分,以生成具有更优声学特性的改进版本[1, 2]。在各种语音应用中,例如辅助听力技术[3, 4]、说话人识别[5, 6]和自动语音识别(ASR)[7, 8],SE 作为关键的前端处理环节发挥着重要作用。近年来,语音增强被定义为一个回归任务,利用基于神经网络的映射函数将输入的有噪语音信号转换为更清晰的输出。具体而言,深度神经模型被用于实现增强有噪语音的映射功能。多种深度架构,包括深度去噪自编码器[9]、深度全连接神经网络[10, 11]、卷积神经网络[12]、长短期记忆[13]、卷积循环神经网络[14, 15],以及最近的 Transformer 及其变体 Conformer,都被用于构建映射功能,从而取得了显著的语音增强性能[16, 17, 18, 19]。

除了探索先进的模型架构外,还有多项研究旨在开发有效的客观函数以增强语音增强能力。通常,在训练过程中,信号级距离度量会作为基本的客观函数,例如 L1/L2 范数[20]、SI-SDR[21] 或多分辨率损失[22]。针对下游语音增强任务专门设计和优化的客观函数也已被提出。例如,诸如语音质量感知评估(PESQ)[23] 或短时客观可懂度(STOI)[24] 这样的客观得分是使用神经网络模型在[25, 26] 中学习的,然后用于优化语音增强模型。同样,在[27] 中,主观评估结果是通过质量估计器学习的,并用于训练语音增强模型。此外,有几项研究表明,在模型训练前对目标语音进行预处理可以提高语音增强效果。例如,感知对比拉伸(PCS)[28] 基于目标特征的感知重要性增强了其对比度,有效地提高了语音增强性能,且在运行时不会显著增加计算成本。

最近,一种极具前景的神经架构——被称为“曼巴”(Mamba)[29]——应运而生,它利用了状态空间模型,并采用了全新的选择机制。Mamba 在各种任务中均能展现出与最先进的(SOTA)基于 Transformer 的模型相当或更出色的性能[30, 31],这得益于其在模拟极长依赖关系方面的内在能力。Mamba 的突出之处在于其对计算资源的高效利用,其在序列长度上的扩展呈线性增长,而 Transformer 的复杂度则呈二次方增长,因此对于长序列而言,Mamba 更具资源效率。

在本研究中,我们旨在比较和对比基于 Transformer 和 Mamba 的自编码器(SE)解决方案,并由此引入了一种新的基于 Mamba 的 SE 解决方案,名为 SEMamba。我们评估了不同的 SEMamba 配置:首先,我们部署了一个基本的 SE 配置,称为 SEMambabasic。接下来,我们实现了具有高级配置的 SEMamba,称为 SEMamba-advanced。我们同时测试了因果和非因果解决方案以及传统的基于距离和基于度量的损失。我们在 VoiceBank-DEMAND 数据集 [32] 上评估了我们的 SEMamba,并将其与基于 Transformer 的同类方案进行了对比。实验结果表明:(i)在具有高级非因果配置的情况下,SEMamba 在 VoiceBank-DEMAND 数据集上实现了与 Transformer 基础架构相当的 3.55 的 PESQ;(ii)当与 PCS 结合使用时,可获得新的最先进的 PESQ 为 3.69。与基于转换的基本架构相比,我们还观察到参数数量减少了约 60% 和约 28%,以及在因果和非因果配置下每秒浮点运算次数(FLOPs)分别减少了约 66% 和约 53%。在高级配置中,当用 Mamba 替换 Transformer 时,观察到浮点运算次数(FLOPs)显著减少了约 12%,同时参数数量保持不变。最后,SEMamba 可以作为 ASR 之前的预处理步骤使用,其性能与近期的 SE 解决方案相当。

2. MAMBA:具有选择性状态空间的线性时间序列建模

结构化状态空间模型(SSM)[33] 已展现出能够以较低的计算和内存需求来处理长依赖序列的能力。它可以作为卷积神经网络(CNN)的替代方案,用于高效并行训练,或者作为循环神经网络(RNN)的替代方案,用于快速自回归生成[34]。最近,Mamba [29] 在 SSM 的离散数据建模方面引入了显著的改进,包括两个关键的改进措施。首先,Mamba 引入了基于输入的自选机制,通过根据输入信息参数化 SSM 模块来实现高效的信息过滤。其次,Mamba 引入了一种硬件感知算法,其与输入序列长度呈线性比例增长,从而能够通过扫描快速反复计算模型。Mamba 架构将 SSM 块与线性层集成在一起,明显比基于 Transformer 的同类架构更简单,并在各种长序列模式(包括语言和基因组学)中展示了最先进的性能。因此,在训练和推理阶段都实现了显著的计算效率。

如《曼巴方法》[29]所述,结构化的 SSM(状态空间模型)通过一个更高维度的潜在状态 \(h\) 将输入 \(x\) 映射到输出 \(y\) ,具体过程如下:\(hn = \bar{A} h_{n-1} + \bar{B} x_{n}\) ,并且 \(y_n = Ch_n\) 。$\bar{A} $ 和 $\bar{B} $ 表示离散化的状态矩阵。离散化过程将连续参数\((∆、A、B)\)转换为离散形式\((\bar{A} 、\bar{B} )\)。曼巴将 H3 架构[35]的组件以及门控多层感知机块整合到一个堆叠结构中,从而扩展了模型的内部表示维度,并将大部分参数集中在线性投影中。这种设计使得内部 SSM 的参数更少,并采用了 SiLU/Swish 激活函数以及标准归一化和残差连接。如需更多详细信息,请参阅[29]。

3. 语音增强中的“曼巴”技术

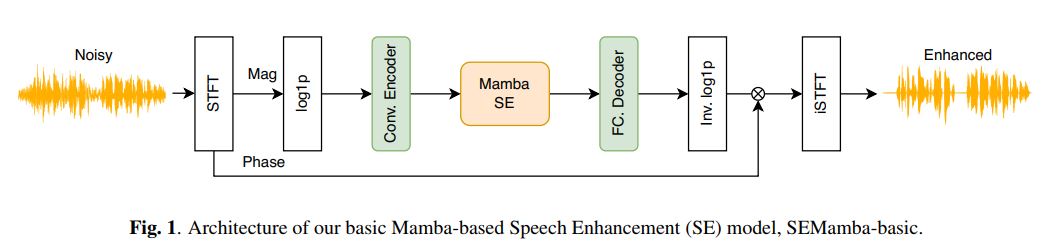

部署了两种 SEMamba 架构:第一种架构将 Mamba 集成到基本的 SE 架构中(见图 1)。第二种架构利用了 MP-SENet,但用 Mamba 块取代了基于注意力机制的块(见图 2)。

3.1. SEMamba-basic

SEMamba-basic 是一种因果模型,即在时间 $t$ 时的输出 $y_t$ 只受前序输入 $x_n$ 的影响,其中 $n ∈ \left \{ 0, …, t\right \} $。如图 1 所示,先使用短时傅里叶变换(STFT)将输入的噪声波形转换为其频谱表示形式。接下来,使用 $log1p$ 函数$log1p(z) = log(1 + z)$对 STFT 的幅度(Mag)分量进行压缩以调节幅度的动态范围。压缩后的频谱幅度随后被输入到 SE 模块中,该模块包括(i)具有 4 个卷积层的卷积编码器,(ii)两个单向 Mamba 块,以及(iii)一个全连接解码器层。增强后的幅度通过 log1p 的逆函数进行解压缩,然后与噪声相位在 iSTFT 块中结合以重建增强后的波形。我们还使用 Transformer 实现了基本的 SEMamba-basic 架构,遵循了 [36] 中所使用的架构。另一方面,SEMamba basic 使用 Mamba 块来替换 Transformer 块。两个基本模型都使用幅度的均方误差作为损失函数进行训练。3.2. SEMamba-advanced

在图 2 所示的架构中,因果性约束被取消,采用了更为复杂的 SE 结构。具体而言,MP-SENet [18](它同时利用了幅度谱和相位谱)构成了架构的基础。使用短时傅里叶变换(STFT)从输入的有噪声波形中获得频谱表示。首先对幅度分量进行压缩,然后将其与相位分量一起堆叠在一起。这些分量由一个特征编码器处理,该编码器具有一个扩张的密集网络核心,两侧各有一个卷积层。特征编码器的输出通过时间-频率Mamba块进行多次变换,变换次数为 \(N\) 次(本研究中 \(N = 4\)),以增强其频谱特性。时间-频率Mamba块的输出随后分别路由到两个独立的解码器,分别用于幅度和相位处理。每个解码器由一个扩张的密集网络和一个反卷积块组成,最后以一个使用二维卷积的输出层结束。

用于训练 SEMamba-advanced 的损失函数采用了损失值的线性组合,其中包括基于 PESQ 的 GAN 辨别器、时间损失、幅度损失、复数损失和相位损失,与 MP-SENet 中的做法相同。

3.3. SEMamba-advanced & additional designs

3.3.1. From uni- to bi-directional Mamba

我们探讨了将 Mamba 结构从单向配置改为双向配置可能带来的益处。这一修改包括使模块能够处理输入序列的原始形式和反转形式。输入数据通过 Mamba 模块并行处理,之后将输出进行拼接。最后,输出被送入一个 Conv1D 层:\(y = Conv1D(Muni(x) ⊕ flip(Muni(flip(x))))\),

其中,\(x、y、Muni()、flip()、Conv1D()\) 和 \(⊕\) 分别表示输入、输出、单向Mamba、翻转操作、一维卷积和连接操作。

3.3.2. 一致性损失Consistency loss (CL)

在训练过程中,通过利用文献[37]中提出的一致性损失,可以提高稳定性。该一致性损失旨在最小化直接从模型输出(包括幅度和相位)获得的复杂谱与经过逆短时傅里叶变换(iSTFT)处理后再次应用傅里叶变换到所得波形所得到的复杂谱之间的差距。这种差距的产生是因为模型直接预测的复杂谱可能超出傅里叶变换的范围。一旦通过 iSTFT 处理并再次应用傅里叶变换,该谱就会重新进入傅里叶变换的范围,从而闭合这个差距。这种机制确保了我们在复域中的增强能够在时频域中有效地转换。3.3.3. Perceptual contrast stretching (PCS)

PCS 是一种频谱处理技术,旨在提升语音信号的感知质量。它利用了人类听觉系统中不同敏感度水平的实证观察结果。PCS 利用这一现象,根据每个频率带的感知重要性来拉伸信号的幅度频谱。在本文中,我们将 PCS 介绍为增强过程之后的一个辅助步骤,旨在进一步提升语音信号的感知质量[28]。

3.4. Dataset

我们使用了 VoiceBank-DEMAND 数据集[32]来进行我们的研究。该数据集包含了由 VoiceBank 收集的纯净语音与 DEMAND 数据集中的噪声混合生成的有噪声语音记录,并且被广泛用作声学增强(SE)基准数据集之一。它包含 30 个不同的说话者,其中 28 个用于训练,2 个用于测试。在训练过程中([0, 5, 10, 15] 分贝)和测试过程中([2.5, 7.5, 12.5, 17.5] 分贝),纯净样本与噪声样本以四种信噪比(SNR)进行了混合。训练数据集总共有 11,572 次语音表述,而测试集包括 824 次语音表述。

3.5. Experimental Setup

依照[40]所述,所有录音均从 48 千赫兹采样率降为 16 千赫兹。用于评估语音增强性能的评估指标包括:(i)宽带 PESQ [23],(ii)信号失真预测(CSIG),(iii)背景干扰预测(CBAK),(iv)整体语音质量预测(COVL),以及(v)STOI [24]。对于所有指标,数值越高表示增强效果越好。 在我们的实验设计中,我们系统地评估了多个方面,以全面评估所提出的 SEMamba 系统的性能。首先,我们评估了 SEMamba 的基础版本。接下来,我们使用更先进的模型架构来评估 Mamba。最后,我们检验了 SEMamba-高级版在结合 CL 和 PCS 的情况下的效果,并评估其在语音识别场景中作为预处理步骤所产生的影响。4. EXPERIMENTS

4.1. Experimental Results

表 1 展示了采用基本 SE 架构并结合 Mamba 或 Transformer 块的实验结果,这些结果如第二部分 A 节所述。此外,还实现了一种非因果配置作为对比支持。结果表明,在因果和非因果配置中,Mamba 的性能与 Transformer 相当或更优,同时其使用的浮点运算次数和参数更少。值得注意的是,在因果配置中,Mamba 块降低了计算需求,所需的浮点运算次数比 Transformer 少 66.37%,参数也少 60.22%;而在非因果设置中,其所需的浮点运算次数减少 53.09%,参数减少 28.28%。在第二组实验中,我们对基于“曼巴”和“Transformer”的高级 SE 架构进行了比较。实验结果列于表 2 中。原始的 MP-SENet 使用 Conformer 作为核心组件。在我们的实验中,Conformer 和 Transformer 得到了相似的结果。表 2 中呈现的所有三个 SE 系统由于特征编码器中的扩张密集网络而都是非因果的。曼巴(双向)采用双向架构,而曼巴(单向)则采用单向架构。比较表 1 和表 2 中的结果,我们发现将曼巴集成到高级模型架构中显著提高了性能。此外,表 2 显示,曼巴不仅性能优越,而且与 Conformer 相比,其运算量减少了 11.88%。

第三,我们在 VoiceBank-DEMAND 数据集上将所提出的 SEMamba 方法与几种著名的 SE 方法进行了对比。结果列于表 3 中。为了便于比较,我们还纳入了基于状态空间模型的三种 SE 方法:S4DSE、S4ND-UNet 和 Spiking-S4 [42、43、44]。该表还报告了有和没有一致性损失(-CL)时的结果,以及有(+PCS)和没有 PCS 的结果,以便进行详细的性能分析。从表 3 中,我们首先注意到 SEMamba(-CL)的性能与 MP-SENet 相当。SEMamba(-CL)与 MP-SENet 的主要区别在于,SEMamba(-CL)使用 Mamba 作为核心模型,而 MP-SENet 使用 Conformer。结果再次证实了 Mamba 产生了相似的评估分数。值得注意的是,当包含一致性损失(CL)时,SEMamba 在 VoiceBank-DEMAND 数据集上达到了 3.55 的高 PESQ 分数。最后,通过应用 PCS,SEMamba 的 PESQ 分数达到 3.69,从而在该数据集上取得了最先进的结果。

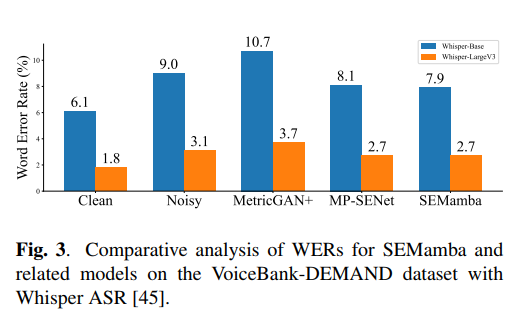

最后,我们还使用 WhisperBase 和 Whisper-LargeV3 在经过 SEMambaadvanced2 预处理的 VoiceBankDEMAND 测试集上对 ASR 结果进行了测试。为了进行对比,我们还测试了相关方法,即 MetricGAN+ 和 MP-SENet,如表 3 所示,并且这两者都是在 VoiceBank-DEMAND 上进行训练的。图 3 中展示的结果表明,SEMamba 在几乎所有情况下都优于其他方法,在 Whisper-Base 上实现了显著的相对词错误率(WER)降低 12.22%(从 9.0% 降至 7.9%),在 WhisperLargeV3 上实现了 12.90%(从 3.1% 降至 2.7%)的降低。

5. CONCLUSION

本研究探索了“曼巴”这一新型的自适应信号模型,该模型具备选择性机制,旨在解决语音增强任务。研究过程中,对基本和高级的语音增强神经方案进行了全面的调查,并采用了传统的信号层面和基于指标的目标函数。实验结果表明,“曼巴”在提升语音增强性能方面具有显著的潜力。实际上,在 VoiceBankDEMAND 数据集上,使用 PCS 的 SEMamba 实现了 3.69 的 SOTA PESQ 分数。此外,将 SEMamba 作为在高级技术辅助下的自动语音识别之前的预处理步骤,总体上能够实现更低的 WER。在未来的研究中,我们计划探索“曼巴”在其他语音生成任务中的潜力。

浙公网安备 33010602011771号

浙公网安备 33010602011771号