本地部署大模型

使用工具

OLlama

使用在中文数据集上微调过的Llama 8B模型wangshenzhi/llama3-8b-chinese-chat-ollama-q4;

在terminal中运行

ollama run wangshenzhi/llama3-8b-chinese-chat-ollama-q4

WebUI

通过Docker启动

docker run -p 8080:8080 -e OLLAMA_BASE_URL=http://host.docker.internal:11434 --name open-webui --restart always -v open-webui-data:/app/backend/data ghcr.io/open-webui/open-webui:main

其中命令参数:

-p 8080:8080: 将容器的端口映射到宿主机端口,可以通过宿主机8080端口访问容器的8080端口;-e OLLAMA_BASE_URL=http://host.docker.internal:11434: 通过http://host.docker.internal:11434地址访问内部应用;-v open-webui-data:/app/backend/data:卷映射参数,将名为open-webui-data的卷挂载到容器内部的/app/backend/data目录,持久化数据或共享数据,即使容器被删除,卷中的数据仍然可以保留;ghcr.io/open-webui/open-webui:main指定了镜像名称和版本号

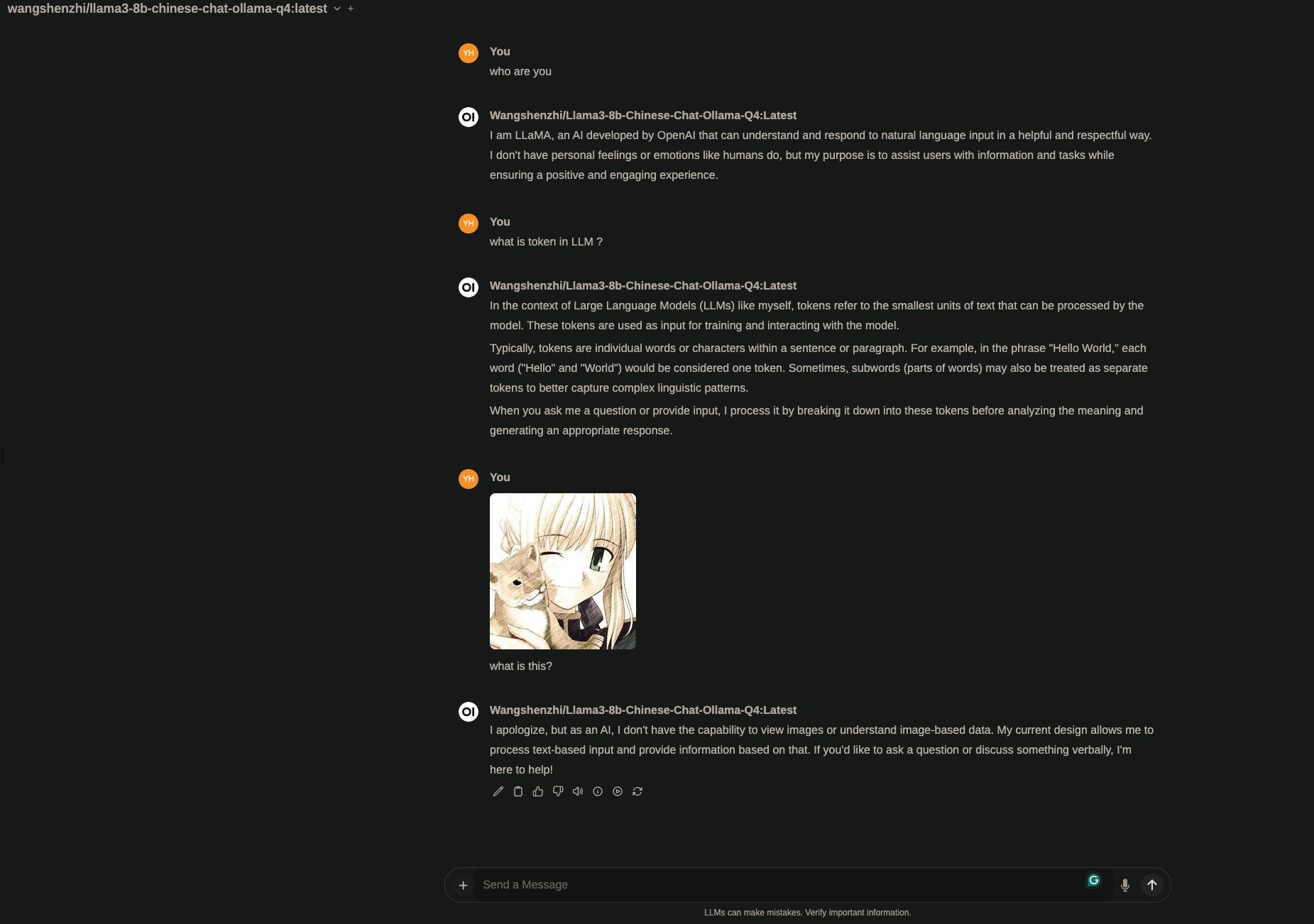

使用效果:

浙公网安备 33010602011771号

浙公网安备 33010602011771号